Kubernetes: El modo ipvs de kube-proxy se cuelga después de unas horas, necesita reinicio manual

Utilice esta plantilla cuando informe un error y proporcione la mayor cantidad de información posible. Si no lo hace, es posible que su error no se solucione de manera oportuna. ¡Gracias!

Qué sucedió : actualizado de v1.11.0 a v1.12.2, ahora kube-proxy se bloquea, generalmente en menos de un día

Lo que esperabas que sucediera : debería seguir funcionando

Cómo reproducirlo (de la forma más mínima y precisa posible) : solo tenga un proxy kube normal ejecutándose en modo ipvs. Generalmente se atasca en menos de un día.

¿Algo más que necesitemos saber? :

Envié SIGABRT al proceso kube-proxy para obtener un seguimiento de la pila, y lo único interesante es que cuando ocurre el error, la goroutine 1 está leyendo desde netlink, mientras que cuando envío SIGABRT y el proceso no está atascado, no está leyendo desde netlink.

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: goroutine 1 [syscall]:

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.Syscall6(0x2d, 0x3, 0xc42081c000, 0x1000, 0x0, 0xc42083deb0, 0xc42083dea4, 0x40fb86, 0x7f2ab9788aa8, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/asm_linux_amd64.s:44 +0x5

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.recvfrom(0x3, 0xc42081c000, 0x1000, 0x1000, 0x0, 0xc42083deb0, 0xc42083dea4, 0x101ffffffffffff, 0x0, 0x1000)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/zsyscall_linux_amd64.go:1665 +0xa6

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.Recvfrom(0x3, 0xc42081c000, 0x1000, 0x1000, 0x0, 0x1000, 0x0, 0x0, 0x16ad4c0, 0x1f4d508)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/syscall_unix.go:252 +0xaf

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/vishvananda/netlink/nl.(*NetlinkSocket).Receive(0xc4204d3440, 0x0, 0x0, 0x0, 0x16ad4c0, 0x1f4d508)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/vishvananda/netlink/nl/nl_linux.go:613 +0x9b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.execute(0xc4204d3440, 0xc42083e150, 0x0, 0x1, 0x2, 0xc420423740, 0x1, 0x2)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:219 +0xd3

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).doCmdwithResponse(0xc420573990, 0xc420990750, 0x0, 0xc42003d501, 0xa, 0x10, 0xc420990701, 0xc42083e230, 0x118dd6b)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:140 +0x20b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).doCmd(0xc420573990, 0xc420990750, 0x0, 0x1, 0x60000020fc6e0, 0xc420990750)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:149 +0x48

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).NewService(0xc420573990, 0xc420990750, 0x0, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/ipvs.go:117 +0x43

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/ipvs.(*runner).AddVirtualServer(0xc42052a340, 0xc420b0e550, 0x1e, 0xc42083e3b8)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/ipvs/ipvs_linux.go:61 +0x60

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).syncService(0xc4201b3e00, 0xc420d53620, 0x21, 0xc420b0e550, 0xc420357901, 0x5, 0xc420d53620)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:1454 +0x635

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).syncProxyRules(0xc4201b3e00)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:803 +0x1081

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).(k8s.io/kubernetes/pkg/proxy/ipvs.syncProxyRules)-fm()

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:395 +0x2a

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/async.(*BoundedFrequencyRunner).tryRun(0xc42042e3f0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/async/bounded_frequency_runner.go:217 +0xb6

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/async.(*BoundedFrequencyRunner).Loop(0xc42042e3f0, 0xc4200b0120)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/async/bounded_frequency_runner.go:179 +0x211

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).SyncLoop(0xc4201b3e00)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:589 +0x4e

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.(*ProxyServer).Run(0xc4207f2000, 0xc4207f2000, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:568 +0x3dd

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.(*Options).Run(0xc4201082c0, 0xc42063e230, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:238 +0x69

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.NewProxyCommand.func1(0xc4200f2500, 0xc42063e230, 0x0, 0x7)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:360 +0x156

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).execute(0xc4200f2500, 0xc4200c4010, 0x7, 0x7, 0xc4200f2500, 0xc4200c4010)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:760 +0x2c1

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).ExecuteC(0xc4200f2500, 0xc4205dc090, 0x16076a0, 0xc4207a7ee8)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:846 +0x30a

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).Execute(0xc4200f2500, 0x1608b88, 0x20dcf40)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:794 +0x2b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: main.main()

Las últimas líneas que registró fueron:

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392942 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392952 5389 graceful_termination.go:160] Trying to delete rs: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: E1115 07:48:52.392978 5389 graceful_termination.go:89] Try delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432" err: Failed to delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432", can't

find the real server

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392985 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: E1115 07:48:52.392992 5389 graceful_termination.go:183] Try flush graceful termination list err

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393147 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393260 5389 graceful_termination.go:89] Try delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125" err: Failed to delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393272 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393281 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393310 5389 graceful_termination.go:89] Try delete rs "10.128.33.142:6379/TCP/10.125.6.13:6379" err: Failed to delete rs "10.128.33.142:6379/TCP/10.125.6.13:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393317 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393327 5389 graceful_termination.go:160] Trying to delete rs: 10.128.34.237:6379/TCP/10.125.6.11:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393355 5389 graceful_termination.go:89] Try delete rs "10.128.34.237:6379/TCP/10.125.6.11:6379" err: Failed to delete rs "10.128.34.237:6379/TCP/10.125.6.11:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393362 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.34.237:6379/TCP/10.125.6.11:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393371 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.200:5432/TCP/10.125.6.27:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393397 5389 graceful_termination.go:89] Try delete rs "10.128.33.200:5432/TCP/10.125.6.27:6432" err: Failed to delete rs "10.128.33.200:5432/TCP/10.125.6.27:6432", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393404 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.200:5432/TCP/10.125.6.27:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393412 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.228:6379/TCP/10.125.2.63:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393440 5389 graceful_termination.go:89] Try delete rs "10.128.33.228:6379/TCP/10.125.2.63:6379" err: Failed to delete rs "10.128.33.228:6379/TCP/10.125.2.63:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393447 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.228:6379/TCP/10.125.2.63:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393455 5389 graceful_termination.go:160] Trying to delete rs: 10.128.34.247:5672/TCP/10.125.2.6:5672

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393482 5389 graceful_termination.go:89] Try delete rs "10.128.34.247:5672/TCP/10.125.2.6:5672" err: Failed to delete rs "10.128.34.247:5672/TCP/10.125.2.6:5672", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393489 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.34.247:5672/TCP/10.125.2.6:5672

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393497 5389 graceful_termination.go:160] Trying to delete rs: 10.128.35.47:4007/TCP/10.125.2.15:4007

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393523 5389 graceful_termination.go:89] Try delete rs "10.128.35.47:4007/TCP/10.125.2.15:4007" err: Failed to delete rs "10.128.35.47:4007/TCP/10.125.2.15:4007", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393530 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.35.47:4007/TCP/10.125.2.15:4007

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393538 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393563 5389 graceful_termination.go:89] Try delete rs "10.128.33.241:4059/TCP/10.125.2.26:4059" err: Failed to delete rs "10.128.33.241:4059/TCP/10.125.2.26:4059", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393571 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393578 5389 graceful_termination.go:160] Trying to delete rs: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393605 5389 graceful_termination.go:89] Try delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432" err: Failed to delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393613 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393621 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.252:6379/TCP/10.125.6.26:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393648 5389 graceful_termination.go:89] Try delete rs "10.128.33.252:6379/TCP/10.125.6.26:6379" err: Failed to delete rs "10.128.33.252:6379/TCP/10.125.6.26:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393656 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.252:6379/TCP/10.125.6.26:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393664 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393690 5389 graceful_termination.go:89] Try delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379" err: Failed to delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393697 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393704 5389 graceful_termination.go:183] Try flush graceful termination list err

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: I1115 07:50:52.393838 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: E1115 07:50:52.393940 5389 graceful_termination.go:89] Try delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125" err: device or resource busy

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: I1115 07:50:52.393957 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420734 5389 proxier.go:1496] Failed to list IPVS destinations, error: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420763 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.33.156:8125/TCP, err: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420889 5389 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420903 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.35.150:6379/TCP, err: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420961 5389 proxier.go:812] Failed to sync service: 10.128.34.54:80/TCP, err: file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.421886 5389 proxier.go:1544] Failed to add destination: 10.125.27.66:80, error: file exists

Si reinicio kube-proxy (manualmente, ugh), todo se recupera y funciona bien. Pero eventualmente se atascará nuevamente.

Medio ambiente :

- Versión de Kubernetes (use

kubectl version): v1.12.2 - Proveedor de nube o configuración de hardware: bare metal, Linux de 64 bits

- SO (por ejemplo, de / etc / os-release): Ubuntu 16.04.5 LTS

- Kernel (por ejemplo,

uname -a): 4.15.0-39-generic (pero consígalo también en el kernel 4.4 original) - Instalar herramientas: binario de https://storage.googleapis.com/kubernetes-release/release/v1.12.2/kubernetes-server-linux-amd64.tar.gz

- Otros:

/ tipo error

Todos 142 comentarios

/ sig red

el mismo error. actualizar desde 1.11.1. Todo se vuelve bueno, excepto que kube-proxy se vuelve inestable, en algún momento el pod no puede acceder al svc aunque sus puntos finales están bien ... Y lo mismo que la resolución de nombres. así que creo que puede existir un error importante aquí.

/ área ipvs

@gjcarneiro ¿resuelves este problema?

Bueno, cambié el clúster nuevamente al modo predeterminado (iptables), parece ser bastante estable desde entonces ...

@ kubernetes / sig-network-bugs

@berlinsaint : Reiterando las menciones para activar una notificación:

@ kubernetes / sig-network-bugs

En respuesta a esto :

@ kubernetes / sig-network-bugs

Las instrucciones para interactuar conmigo usando comentarios de relaciones públicas están disponibles aquí . Si tiene preguntas o sugerencias relacionadas con mi comportamiento, presente un problema en el repositorio de kubernetes / test-infra .

mismo problema, tanto 1.12.2 como 1.13.0-beta1. @ m1093782566 @ León-Wei

@gjcarneiro, ¿quiere decir que en el kernel 4.15 tiene el mismo problema?

@annProg

mismo problema, tanto 1.12.2 como 1.13.0-beta1. @ m1093782566 @ Lion-Wei

Cuánto cuesta tu buzón, conócelo. .juvenil

@annProg

mismo problema, tanto 1.12.2 como 1.13.0-beta1. @ m1093782566 @ Lion-Wei

Cuánto cuesta tu buzón, conócelo. .juvenil

Haga clic en mi avatar para ver

También veo esto repetidamente en mi sistema de registro centralizado:

| Time | sys_name | log_lvl | tag | log_msg

| November 27th 2018, 17:56:23.501 | k8lab2bs | 6 | kube.kube-system.kube-proxy | lw: remote out of the list: 10.12.12.1:443/TCP/10.12.100.133:6443

| November 27th 2018, 17:56:23.500 | k8lab2bs | 6 | kube.kube-system.kube-proxy | Deleting rs: 10.12.12.1:443/TCP/10.12.100.133:6443

| November 27th 2018, 17:56:23.497 | k8lab2bs | 6 | kube.kube-system.kube-proxy | Trying to delete rs: 10.12.12.1:443/TCP/10.12.100.133:6443

Estoy ejecutando v1.12.3 (instalación nueva, no una actualización).

Hola a todos. Gracias por el informe, haré una investigación y trataré de averiguar qué sucedió, cualquier progreso que reportaré aquí.

Además de lo que sucedió, lo cual es bueno saberlo, no me siento seguro acerca de IPVS hasta que haya un código que detecte y restablezca un conector de enlace de red roto. Porque por lo que puedo adivinar de los registros y trazas, es que el conector de enlace de red entra en un estado roto y la tarea que lee / escribe desde / en él se bloqueará para siempre. Creo que kube-proxy necesita tener un código que detecte este problema y, si sucede, cree un nuevo conector de enlace de red desde cero y tal vez reinicie la tarea que lo maneja. Pero no, no soy voluntario, ni siquiera lo sé. Go, lo siento.

Porque por lo que puedo adivinar de los registros y trazas, es que el conector de enlace de red entra en un estado roto y la tarea que lee / escribe desde / en él se bloqueará para siempre.

Actualizamos la versión go netlink hace unos días para admitir la terminación ordenada. La biblioteca netlink se estaba ejecutando bastante estable antes. No estoy seguro de si es la causa.

1.12.3 con el mismo error.

Después de filtrar el registro INFO,

ejecutar kubectl -n kube-system logs kube-proxy-29zh8|egrep ^E; kubectl -n kube-system logs kube-proxy-2pqdn|egrep ^E; kubectl -n kube-system logs kube-proxy-4xw8q|egrep ^E; kubectl -n kube-system logs kube-proxy-6j4bc|egrep ^E; kubectl -n kube-system logs kube-proxy-brbjb|egrep ^E; kubectl -n kube-system logs kube-proxy-r6cg2|egrep ^E; kubectl -n kube-system logs kube-proxy-rpl6t|egrep ^E;

y todo el registro del nodo proxy es

bash

E1129 01:01:10.862180 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 21:09:11.422553 1 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

E1129 21:09:11.422699 1 proxier.go:1116] Failed to sync endpoint for service: 172.17.0.1:31800/TCP, err: Expected only one service obtained=0

E1129 01:01:11.618125 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:11.905626 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:01:41.771596 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:02:11.923872 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:02:42.060658 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:03:12.326762 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:03:42.718417 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:04:12.859933 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:04:42.963527 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:05:13.078486 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:05:43.185141 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:06:13.303090 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:06:43.408582 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:07:13.550358 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:07:43.686235 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:08:13.786326 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:08:43.981764 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:09:14.188053 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:09:44.316316 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:10:14.440466 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:10:44.550092 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:11:14.658190 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:11:44.765396 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:12:14.975724 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:12:45.085632 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:13:15.317679 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:13:45.432469 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:14:15.689681 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:14:45.813565 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:15:33.434931 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:16:03.578017 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:16:33.709744 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:17:03.823325 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:17:33.935191 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:18:04.053183 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:18:34.248994 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:04.375946 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:34.552779 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:36.596182 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:47.433846 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:20:17.534206 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:20:47.682350 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:21:17.825175 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:21:47.942548 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:22:18.055820 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:22:48.149494 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:23:18.564985 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:23:48.678462 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:24:18.836217 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:24:48.991344 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:25:19.091032 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:25:49.187178 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:26:19.301770 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:26:49.425812 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:27:19.606711 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:27:49.721224 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:28:20.109117 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:28:50.211574 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:29:20.405007 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:29:50.507766 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:30:20.605471 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:30:50.702798 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:31:20.807400 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:31:50.903049 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:32:21.005618 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:32:51.106378 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:33:21.224447 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:33:51.354916 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:34:21.467898 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:34:51.583216 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:35:21.691099 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:35:51.797151 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:36:21.921057 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:36:52.083821 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:02.445737 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:07.427811 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:37.546362 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:38:07.651769 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:38:37.797858 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:39:08.064112 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:39:38.181089 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:40:08.282892 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:40:38.390167 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:41:08.508549 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:41:38.617921 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:42:08.728384 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:42:38.844074 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:43:08.973517 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:43:39.092095 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:44:09.202329 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:44:39.363721 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:45:09.476240 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:45:39.764944 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:46:09.894587 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:46:40.013388 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:47:10.127894 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:47:40.236119 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:48:10.397111 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:48:40.600084 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:49:10.877034 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:49:41.023593 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:50:11.149894 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:50:41.262320 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:51:11.410407 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:51:41.547057 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:52:11.609974 1 proxier.go:1544] Failed to add destination: 172.31.200.9:443, error: file exists

E1129 01:52:11.610088 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: invalid argument

E1129 01:52:11.616690 1 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

E1129 01:52:11.616767 1 proxier.go:1116] Failed to sync endpoint for service: 172.18.0.1:31645/TCP, err: Expected only one service obtained=0

E1129 01:01:12.181112 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:22.278474 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:21.459378 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:17.442316 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 20:10:17.955872 1 proxier.go:1455] Failed to add IPVS service "dev-fffrf/mysql-testportal:mysql": file exists

E1129 20:10:17.955863 1 graceful_termination.go:89] Try delete rs "10.100.217.68:15004/TCP/192.100.143.225:15004" err: Failed to delete rs "10.100.217.68:15004/TCP/192.100.143.225:15004", can't find the real server

E1129 20:10:17.955892 1 proxier.go:1119] Failed to sync service: 172.17.0.1:31645/TCP, err: file exists

E1129 20:10:17.956412 1 proxier.go:1485] Failed to get IPVS service, error: invalid argument

E1129 20:10:17.956417 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: Failed to delete rs "10.96.0.1:443/TCP/172.31.10.38:6443", can't find the real server

E1129 20:10:17.956426 1 proxier.go:1116] Failed to sync endpoint for service: 172.31.200.67:31645/TCP, err: invalid argument

E1129 20:10:17.956448 1 graceful_termination.go:89] Try delete rs "10.101.1.98:5672/TCP/192.100.29.180:5672" err: invalid argument

E1129 20:10:17.956547 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 01:01:17.484679 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 02:52:17.498135 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: invalid argument

E1129 02:52:17.498396 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 06:28:17.607394 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: device or resource busy

E1129 06:28:17.607513 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 10:02:17.718458 1 proxier.go:1544] Failed to add destination: 192.100.183.139:3306, error: file exists

E1129 10:02:17.718606 1 proxier.go:1544] Failed to add destination: 192.100.183.152:8080, error: invalid argument

Por cierto. desde arriba de mis registros, parece que kube-proxy todavía tiene muchos problemas con iptables-restore. todos mis nodos son UBUNTU 16.04 que tienen la versión 1.6.0 de iptable.

@ m1093782566 @ León-Wei

Vemos que esto sucede al actualizar desde 1.12.1. por tanto, debe estar en el delta de 1.12.1 y 1.12.2.

El problema está relacionado con la terminación elegante y creo que hemos solucionado el error en v1.13.1.

@ m1093782566 ¿la corrección se transferirá a la línea 1.12? ahora mismo, esto está bloqueando la corrección de seguridad 1.12.3 para nosotros.

Obtuve lo mismo con la actualización de 1.11.2 a 1.11.5.

@ m1093782566 ¿ puede proporcionar más información sobre la solución? Me interesaría revisar el compromiso.

Esto es bastante loco, nos han mordido muy fuerte hoy.

Vemos que esto sucede al actualizar desde 1.12.1. por tanto, debe estar en el delta de 1.12.1 y 1.12.2.

Obtuve lo mismo con la actualización de 1.11.2 a 1.11.5.

¿Fue el bicho elegido por Chery?

Este parece el PR que soluciona el problema: https://github.com/kubernetes/kubernetes/pull/71515

Verdadero @ Quentin-M

Sí, esto probablemente proviene de la corrección en la función delete (no está realmente relacionada con el título del PR).

@ m1093782566 Puedo crear la selección de cereza para 1.12. ¿Queremos exportar el PR completo o solo la corrección en la función de eliminación? (para evitar cambiar el comportamiento con los flujos UDP en 1.12)

¿Fue el bicho elegido por Chery?

@ Quentin-M parece que el error fue introducido por https://github.com/kubernetes/kubernetes/pull/66012, que se seleccionó en las versiones 1.11.5 y 1.12.2:

https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.11.md#changelog -since-v1114

https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.12.md#other -notable-changes-1

Creo que todo el # 71515 debería ser elegido. La terminación elegante en general solo se introdujo y se seleccionó con el número 66012, por lo que el cambio de comportamiento ya se produjo.

k8s.gcr.io/kube-proxy:v1.13.1-beta.0 todavía está obsoleto en nuestros clústeres. El 60% de ellos se atascó en menos de 24 horas. Probar 1.12.1 ahora.

@ Quentin-M: ¿Puede verificar los registros en kube-proxy y confirmar que estos tipos de mensajes se han ido?

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393664 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393690 5389 graceful_termination.go:89] Try delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379" err: Failed to delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393697 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

Ambos están relacionados con la función de eliminación fijada en el PR. Si desaparecieron y aún ve el problema, esta solución no es suficiente

Además, si todo funciona con 1.12.1 , existe una gran probabilidad de que el problema provenga de una terminación ordenada (# 66012)

Creo que tengo una idea: me pregunto qué sucede si intentamos agregar un servidor real que todavía está en finalización elegante. En este caso, deberíamos simplemente aumentar el peso a 1 y eliminarlo de la lista de terminación elegante.

Intentaré probar este escenario tan pronto como pueda (pero será complicado porque estaré en Kubecon la próxima semana)

@ Lion-Wei, ¿qué opinas?

Ok, borre eso, acabo de probar y funciona bien. El código responsable está aquí: https://github.com/kubernetes/kubernetes/blob/456c351e31517543e0686b2cadf21615d30a738f/pkg/proxy/ipvs/proxier.go#L1538 -L1542

En ese caso, el RS se elimina de la lista gracefulDelete y de IPVS RS. Me pregunto si volver a poner el peso en 1 no sería mejor

Intentaré otras cosas basadas en esta parte de los registros, que parece apuntar a intentar sincronizar los puntos finales de un servicio eliminado

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420734 5389 proxier.go:1496] Failed to list IPVS destinations, error: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420763 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.33.156:8125/TCP, err: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420889 5389 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420903 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.35.150:6379/TCP, err: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420961 5389 proxier.go:812] Failed to sync service: 10.128.34.54:80/TCP, err: file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.421886 5389 proxier.go:1544] Failed to add destination: 10.125.27.66:80, error: file exists

De acuerdo, después de una verificación rápida, la confirmación que soluciona el problema de eliminación no está en v1.13.1-beta.0 ni en v1.14.0-alpha.0 que se eliminó el 7 de noviembre

Creo que será en la próxima versión alfa 1.14 que se basará en master

También voy a crear la selección de cereza para 1,13

Tengo un problema con la actualización de 1.12.0 a 1.13.0, parece estar relacionado con este, pero no es el mismo.

No podemos solucionarlo volviendo a iptables. Por favor, ayúdame.

Lo he publicado en stackoverflow

Obtuve lo mismo en 1.11.5. Revertido temporalmente de ipvs a iptables.

Lo mismo en 1.11.5. No se puede revertir a 1.11.4 debido a la vulnerabilidad presente en él. Tuve que cambiar a iptables. ¿La solución para esto se lanzará para 1.11.x?

Puede deshacer kube-proxy de manera muy específica, sin verse afectado por la vulnerabilidad.

@ Quentin-M Sí, ese pensamiento me ha golpeado la mente, pero por otro lado, si lo hiciera, no tendría una terminación elegante, que ha estado ahí todo el tiempo con iptables. No estoy seguro de que a nuestros clientes les guste el cambio.

@ Quentin-M, ¿significa que no habrá solución para 1.11.x para solucionar este error?

@emptywee Creé una selección de cereza para 1.11: https://github.com/kubernetes/kubernetes/pull/71848

Con suerte, se fusionará muy pronto y estará en 1.11.6

Ya se ha fusionado en 1.12 (estará en 1.12.4 ) y 1.13 (estará en 1.13.1 )

La selección de cereza también se fusionó en 1.11

Solo tenemos que esperar a los próximos lanzamientos de parches en las 3 ramas (pero si desea probarlo antes de que pueda crear fácilmente una compilación de kube-proxy personalizada (o, incluso más fácil, una imagen de hiperkube con el parche)

¡Muchas gracias @lbernail ! ¡Sería bueno tener una imagen de Docker disponible públicamente! ¡Me encantaría probarlo!

La solución ya está seleccionada para las versiones 1.11, 1.12 y 1.13.

¿Podría probarlos para que podamos solucionar este problema?

@ m1093782566 Estoy probando esto. Por cierto, ¿cuándo publicará la comunidad el pequeño lanzamiento para esto?

Gracias @berlinsaint , déjame el resultado de la prueba.

¿Cuándo publicará la comunidad el pequeño lanzamiento para esto?

La nueva versión pequeña con la corrección se publicará en menos de 2 semanas.

@emptywee : aquí tienes: lbernail/hyperkube:v1.12.4-beta.1

¡Háganos saber como funciona para usted!

@lbernail, ¿ está bien usarlo con todo lo demás en v1.11.5? ¿O debería pasar primero mi clúster de kubernetes a la versión 1.12.4? De todos modos, ¡muchas gracias!

@emptywee sí, debería funcionar sin ningún problema (he estado ejecutando kube-proxy 1.11 en clústeres 1.10 durante meses)

También puedo hacer una compilación 1.11 más tarde hoy

@lbernail sí, sería bueno tener una imagen de la misma versión de lanzamiento.

@emptywee aquí tienes: lbernail/hyperkube:v1.11.6-beta.1

@ m1093782566 @lbernail Después de una noche de observación, el registro de errores de sincronización de ipvs ya no se ve, mientras

ocurre al menos una vez una noche antes. Pero aún necesito más tiempo para verificarlo, muchas gracias, me molestó mucho tiempo.

Comenzaré a probar mañana el 1.11 y también le daré unos días.

@lbernail Te probé lbernail/hyperkube:v1.11.6-beta.1 (¡Gracias por eso!)

Inmediatamente pensamos que las cosas estaban arregladas, ya que dejamos de ver los mensajes de registro can't find the real server . Sin embargo, después de un día y medio, estamos viendo problemas con entradas ipvs obsoletas en 3/6 nodos de clúster.

Estas son las entradas de ipvs para un servicio en un nodo de clúster roto.

Antes de reiniciar kube-proxy:

-A -t 10.230.65.211:9494 -s rr

-a -t 10.230.65.211:9494 -r 10.230.158.10:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.158.57:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.213.245:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.170:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.180:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.222.151:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.222.158:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.222.160:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.82:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.85:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.117:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.242.229:9494 -m -w 1

Después de reiniciar kube-proxy:

-A -t 10.230.65.211:9494 -s rr

-a -t 10.230.65.211:9494 -r 10.230.158.36:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.213.236:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.129:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.163:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.84:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.124:9494 -m -w 1

@lbernail @bjornryden Esa fue la razón por la que me metí en este hilo cuando cambié a IPVS en 1.11.5. Al día siguiente encontré servicios inaccesibles, así que pensé que kube-proxy se había bloqueado y no actualizaría las entradas de los servicios.

Eso es solo para hacerle saber que tuve un problema similar (IP incorrectas en la tabla ipvs) con v1.11.5 de kube-proxy.

@bjornryden Buenas noticias para los errores de eliminación (esto era lo que estaba abordando el parche)

El hecho de que los backends no se actualicen correctamente es extraño porque la terminación elegante no debería afectar a los nuevos puntos finales (si algunos puntos finales obsoletos todavía estuvieran allí, por ejemplo, me sorprendería menos)

¿Podría compartir los registros de kube-proxy relacionados con el servicio 10.230.65.211:9494 ?

Además, ¿algún comportamiento especial con este servicio / implementación? (por ejemplo, ¿se actualizan los pods con mucha frecuencia o detrás de un HPA?)

Así que ha estado funcionando durante 2 días en mi grupo de laboratorio con la imagen 1.11.6-beta.1 de @lbernail en el modo ipvs.

Hasta ahora todo va bien, no se ha bloqueado y sigue actualizando las entradas de ipvs.

Sin embargo, una observación extraña:

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.130.24:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.129.28:8443 Masq 1 0 0

La primera llamada a ipvsadm muestra el estado inicial antes de eliminar uno de los pods para el servicio. A continuación, pocos muestran que una entrada se ha ido, ya que se eliminó el pod. Sin embargo, no sé si es así como se supone que debe ser, pero creó una segunda entrada con la misma dirección IP que el pod que había dejado. Y luego lo actualizó a la IP correcta del nuevo pod que surgió para reemplazar el eliminado.

Aparte de eso, ha estado bien. Pero el grupo de laboratorios no está tan ocupado como los demás. El comentario de @bjornryden me preocupó un poco al probar la imagen en clústeres más ocupados, donde puede afectar a nuestros clientes.

@emptywee Supongo que el pod eliminado era 10.158.130.24 . No entiendo esto:

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.128.28:8443 Masq 1 0 0

Tener el mismo servidor real dos veces no tiene sentido. ¿Puedes reproducirlo?

El comportamiento normal en la eliminación de pod debe ser:

- si no hay conexiones a este pod, retire el RS

- si hay conexiones, establezca el peso en 0 (las conexiones establecidas continúan, no hay nuevas conexiones)

- cada minuto verifique todos los RS con peso 0 (para esto es la lista de terminación elegante) y elimine los que ya no tienen conexiones

@lbernail correcto. La cápsula eliminada tenía esa dirección IP. Y sí, también me pareció extraño. Intentaré reproducirme cuando tenga la oportunidad. ¿Le gustaría que aumente la verbosidad del registro si puedo reproducir el mismo comportamiento? Si es así, ¿a qué nivel?

@emptywee : sería genial gracias, --v=5 debería darnos mucha información

Lo principal es que ni siquiera creo que un RS pueda aparecer dos veces en un VS en IPVS (nunca vi eso). ¿Qué kernel está ejecutando?

@lbernail lo establecerá en --v = 5 e intentará reproducirlo, probablemente en algún momento del fin de semana.

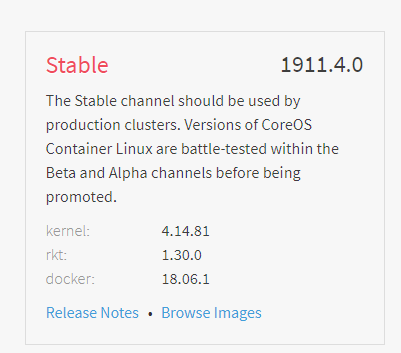

Estoy en CoreOS estable:

4.14 es muy reciente, por lo que me sorprendería si hubiera un problema de IPVS

Voy a intentar estresar un clúster con la versión parcheada para ver si puedo reproducir el problema de @bjornryden

@lbernail Desafortunadamente, no pude reproducir ese comportamiento de duplicación de entrada de ipvs que solo he visto una vez. Intenté varias veces, con diferentes servicios. Sin embargo, no he visto ninguna entrada con peso 0, pero esto podría explicarse por el hecho de que los pods que elimino salen muy rápidamente. Además, kube-proxy ha respondido después de ejecutarse durante más de 5 días. Podría intentarlo de nuevo en el clúster más ocupado de aquí.

@emptywee Esta es una "buena" noticia (incluso si prefiero que podamos reproducirla y entenderla, ¿tal vez fue un error de visualización en ipvsadm?)

El peso solo se establece en 0 si son ActiveConn o InActiveConn. Para verlo, simplemente abra una conexión de larga duración a un servicio antes de eliminar el pod asociado (por ejemplo, usando telnet)

¡5 días de estabilidad son buenas noticias! Háganos saber cómo le va cuando / si prueba en un clúster más ocupado

Tengo algunas pequeñas mejoras en camino:

- https://github.com/kubernetes/kubernetes/pull/71834 : haga que la terminación elegante funcione con los servicios que usan sessionAffinity (ya en el maestro, selecciones de cereza creadas para 1.13, 1.12 y 1.11)

- https://github.com/kubernetes/kubernetes/pull/71895 y https://github.com/kubernetes/kubernetes/pull/72106 : admite la terminación elegante al eliminar un servicio (el primero ya está en master, estoy esperando que el segundo elija ambos en todas las ramas)

Además, 1.11.6 , 1.12.4 y 1.13.1 se han publicado y contienen la corrección en la función de eliminación

Escribí un breve artículo sobre el tema durante el fin de semana /. ¡Me aseguraré de actualizarlo con la versión fija!

@lbernail ¡ Seguro, lo haré! ¿Su imagen de hiperkubo es la misma que la que se publicó como 1.11.6? Instalé su imagen para kube-proxy solo en el clúster más ocupado y cambié a ipvs nuevamente para probar. ¿Quieres que use el oficial?

@emptywee Mi imagen y la 1.11.6 son básicamente las mismas: la construí desde el encabezado de la rama de la versión 1.11 unos días antes del lanzamiento oficial, por lo que la diferencia es de algunas confirmaciones como máximo, ninguna de las cuales involucra IPVS. Así que no creo que valga la pena el esfuerzo de actualizar su clúster nuevamente

Malas noticias :( Acabo de recibir mi kube-proxy que no pudo actualizar los backends de ipvs. Volviendo a iptables y recopilando registros. Tenía kube-proxy ejecutándose con la bandera --v=5 .

@lbernail Entonces, no estoy seguro de cuántos registros se necesitan, pero básicamente encontramos un problema con algunos servicios, que no tenían sus IP de backends ipvs actualizadas. Sin embargo, los registros nos dicen que estaba actualizando los puntos finales correctamente:

$ cat kube-proxy-issue.log | egrep -e 'c-qa4/ycsdtleuk|10.148.191.69|10.148.192.14|10.148.183.70|10.148.184.67'

I1217 19:12:52.849863 1 graceful_termination.go:160] Trying to delete rs: 10.148.6.202:80/TCP/10.148.192.14:8080

I1217 19:12:52.849948 1 graceful_termination.go:173] Deleting rs: 10.148.6.202:80/TCP/10.148.192.14:8080

I1217 19:12:52.850000 1 graceful_termination.go:160] Trying to delete rs: 10.148.6.202:80/TCP/10.148.191.69:8080

I1217 19:12:52.850069 1 graceful_termination.go:173] Deleting rs: 10.148.6.202:80/TCP/10.148.191.69:8080

I1217 19:12:53.425438 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:13:00.501203 1 ipset.go:140] Successfully delete legacy ip set entry: 10.148.191.69,tcp:8080,10.148.191.69 from ip set: KUBE-LOOP-BACK

I1217 19:13:00.543691 1 ipset.go:140] Successfully delete legacy ip set entry: 10.148.192.14,tcp:8080,10.148.192.14 from ip set: KUBE-LOOP-BACK

I1217 19:13:06.916777 1 service.go:309] Adding new service port "c-qa4/ycsdtleuk:http" at 10.148.6.202:80/TCP

I1217 19:13:08.345142 1 proxier.go:1465] Adding new service "c-qa4/ycsdtleuk:http" 10.148.6.202:80/TCP

I1217 19:13:13.939763 1 ipset.go:148] Successfully add entry: 10.148.191.69,tcp:8080,10.148.191.69 to ip set: KUBE-LOOP-BACK

I1217 19:13:14.002663 1 ipset.go:148] Successfully add entry: 10.148.192.14,tcp:8080,10.148.192.14 to ip set: KUBE-LOOP-BACK

I1217 19:27:53.485483 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:27:53.485526 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:42:53.388638 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:42:53.388673 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:57:53.643829 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:57:53.644032 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:12:53.541080 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:12:53.541129 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:27:53.368129 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:27:53.368306 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:42:53.539517 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:42:53.539542 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:57:53.624320 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:57:53.624371 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:12:53.630561 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:12:53.630585 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:20.897397 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:20.897463 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:46.630013 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:46.630084 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:57.995544 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:57.995657 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:27:24.296606 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:27:53.678172 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:28:21.517538 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080]

I1217 21:28:21.595632 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 21:42:53.491595 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 21:57:53.492214 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 22:05:45.760620 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080]

I1217 22:06:24.890429 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080]

I1217 22:07:15.463144 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.68:8080]

I1217 22:07:43.201415 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080]

I1217 22:08:18.268005 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080]

I1217 22:08:58.774066 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:12:53.528515 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:27:53.522197 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:20.396794 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:43.994895 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:54.382253 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.192.70:8080]

I1217 22:30:17.895084 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.184.67:8080 10.148.192.70:8080]

I1217 22:31:45.791871 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.184.67:8080]

I1217 22:31:45.855011 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

I1217 22:42:53.652587 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

I1217 22:57:53.509372 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

Pero cuando lo verifiqué con ipvsadm, todavía mostraba los dos primeros: 10.148.191.69:8080 10.148.192.14:8080

Mientras que kubectl -n c-qa4 describe svc ycsdtleuk estaba diciendo que los puntos finales son 10.148.183.70:8080 10.148.184.67:8080 , y en otros cuadros, las entradas de ipvs para el mismo servicio se estaban actualizando correctamente.

$ kubectl -n c-qa4 describe svc ycsdtleuk

Name: ycsdtleuk

Namespace: c-qa4

Labels: country=uk

env=qa

run=ycsdtleuk

stack=c

track=4

Annotations: run: ycsdtleuk

Selector: load-balancer-ycsdtleuk=true

Type: ClusterIP

IP: 10.148.6.202

Port: http 80/TCP

TargetPort: 8080/TCP

Endpoints: 10.148.183.70:8080,10.148.184.67:8080

Session Affinity: None

Events: <none>

Básicamente, estaba mirando lo siguiente en dos cajas al mismo tiempo:

(incorrect ipvs config)

rnqkbm401 ~ # ipvsadm -L -t 10.148.6.202:80

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP rnqkbm401:http rr

-> 10.148.191.69:http-alt Masq 1 0 0

-> 10.148.192.14:http-alt Masq 1 0 0

(correct ipvs config)

rnqkbw401 ~ # ipvsadm -L -t 10.148.6.202:80

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP rnqkbw401:http rr

-> 10.148.183.70:http-alt Masq 1 0 0

-> 10.148.184.67:http-alt Masq 1 0 0

No hay ningún mensaje de error obvio ni ningún grito que indique signos de un problema en cualquier lugar. Puedo enviarle el archivo de registro completo (18M sin comprimir) directamente, si lo desea.

En pocas palabras: parece que la parte que escucha los cambios de servicios funciona bien, pero la parte que interactúa con el módulo ipvs no lo está. Ni siquiera veo que estuviera intentando eliminar las dos direcciones IP iniciales una vez que las agregó. Algo se atasca en alguna parte.

@emptywee Gracias por el informe detallado. Nada extraño en estos registros.

Lo sorprendente es que syncProxyRules se ejecuta al menos cada 30 segundos (predeterminado) y debería reconciliar los servidores reales IPVS con los puntos finales. Llama a syncEndpoints que dispara AddRealServer y ipvsHandle.NewDestination