Kubernetes: O modo kube-proxy ipvs trava após algumas horas, precisa ser reiniciado manualmente

Use este modelo ao relatar um bug e forneça o máximo de informações possível. Não fazer isso pode resultar em seu bug não ser corrigido em tempo hábil. Obrigado!

O que aconteceu : atualizado de v1.11.0 para v1.12.2, agora o kube-proxy trava, geralmente em menos de um dia

O que você esperava que acontecesse : deve continuar funcionando

Como reproduzi-lo (o mais mínimo e precisamente possível) : basta ter um kube-proxy normal rodando em modo ipvs. Geralmente, ele emperra em menos de um dia.

Mais alguma coisa que precisamos saber? :

Enviei SIGABRT para o processo kube-proxy para obter um rastreamento de pilha, e a única coisa interessante é que quando o bug acontece, a goroutina 1 está lendo do netlink, enquanto que quando eu envio SIGABRT e o processo não está travado, não está lendo do netlink.

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: goroutine 1 [syscall]:

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.Syscall6(0x2d, 0x3, 0xc42081c000, 0x1000, 0x0, 0xc42083deb0, 0xc42083dea4, 0x40fb86, 0x7f2ab9788aa8, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/asm_linux_amd64.s:44 +0x5

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.recvfrom(0x3, 0xc42081c000, 0x1000, 0x1000, 0x0, 0xc42083deb0, 0xc42083dea4, 0x101ffffffffffff, 0x0, 0x1000)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/zsyscall_linux_amd64.go:1665 +0xa6

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.Recvfrom(0x3, 0xc42081c000, 0x1000, 0x1000, 0x0, 0x1000, 0x0, 0x0, 0x16ad4c0, 0x1f4d508)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/syscall_unix.go:252 +0xaf

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/vishvananda/netlink/nl.(*NetlinkSocket).Receive(0xc4204d3440, 0x0, 0x0, 0x0, 0x16ad4c0, 0x1f4d508)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/vishvananda/netlink/nl/nl_linux.go:613 +0x9b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.execute(0xc4204d3440, 0xc42083e150, 0x0, 0x1, 0x2, 0xc420423740, 0x1, 0x2)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:219 +0xd3

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).doCmdwithResponse(0xc420573990, 0xc420990750, 0x0, 0xc42003d501, 0xa, 0x10, 0xc420990701, 0xc42083e230, 0x118dd6b)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:140 +0x20b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).doCmd(0xc420573990, 0xc420990750, 0x0, 0x1, 0x60000020fc6e0, 0xc420990750)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:149 +0x48

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).NewService(0xc420573990, 0xc420990750, 0x0, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/ipvs.go:117 +0x43

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/ipvs.(*runner).AddVirtualServer(0xc42052a340, 0xc420b0e550, 0x1e, 0xc42083e3b8)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/ipvs/ipvs_linux.go:61 +0x60

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).syncService(0xc4201b3e00, 0xc420d53620, 0x21, 0xc420b0e550, 0xc420357901, 0x5, 0xc420d53620)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:1454 +0x635

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).syncProxyRules(0xc4201b3e00)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:803 +0x1081

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).(k8s.io/kubernetes/pkg/proxy/ipvs.syncProxyRules)-fm()

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:395 +0x2a

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/async.(*BoundedFrequencyRunner).tryRun(0xc42042e3f0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/async/bounded_frequency_runner.go:217 +0xb6

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/async.(*BoundedFrequencyRunner).Loop(0xc42042e3f0, 0xc4200b0120)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/async/bounded_frequency_runner.go:179 +0x211

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).SyncLoop(0xc4201b3e00)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:589 +0x4e

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.(*ProxyServer).Run(0xc4207f2000, 0xc4207f2000, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:568 +0x3dd

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.(*Options).Run(0xc4201082c0, 0xc42063e230, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:238 +0x69

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.NewProxyCommand.func1(0xc4200f2500, 0xc42063e230, 0x0, 0x7)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:360 +0x156

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).execute(0xc4200f2500, 0xc4200c4010, 0x7, 0x7, 0xc4200f2500, 0xc4200c4010)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:760 +0x2c1

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).ExecuteC(0xc4200f2500, 0xc4205dc090, 0x16076a0, 0xc4207a7ee8)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:846 +0x30a

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).Execute(0xc4200f2500, 0x1608b88, 0x20dcf40)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:794 +0x2b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: main.main()

As últimas linhas que registrou foram:

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392942 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392952 5389 graceful_termination.go:160] Trying to delete rs: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: E1115 07:48:52.392978 5389 graceful_termination.go:89] Try delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432" err: Failed to delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432", can't

find the real server

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392985 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: E1115 07:48:52.392992 5389 graceful_termination.go:183] Try flush graceful termination list err

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393147 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393260 5389 graceful_termination.go:89] Try delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125" err: Failed to delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393272 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393281 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393310 5389 graceful_termination.go:89] Try delete rs "10.128.33.142:6379/TCP/10.125.6.13:6379" err: Failed to delete rs "10.128.33.142:6379/TCP/10.125.6.13:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393317 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393327 5389 graceful_termination.go:160] Trying to delete rs: 10.128.34.237:6379/TCP/10.125.6.11:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393355 5389 graceful_termination.go:89] Try delete rs "10.128.34.237:6379/TCP/10.125.6.11:6379" err: Failed to delete rs "10.128.34.237:6379/TCP/10.125.6.11:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393362 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.34.237:6379/TCP/10.125.6.11:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393371 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.200:5432/TCP/10.125.6.27:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393397 5389 graceful_termination.go:89] Try delete rs "10.128.33.200:5432/TCP/10.125.6.27:6432" err: Failed to delete rs "10.128.33.200:5432/TCP/10.125.6.27:6432", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393404 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.200:5432/TCP/10.125.6.27:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393412 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.228:6379/TCP/10.125.2.63:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393440 5389 graceful_termination.go:89] Try delete rs "10.128.33.228:6379/TCP/10.125.2.63:6379" err: Failed to delete rs "10.128.33.228:6379/TCP/10.125.2.63:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393447 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.228:6379/TCP/10.125.2.63:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393455 5389 graceful_termination.go:160] Trying to delete rs: 10.128.34.247:5672/TCP/10.125.2.6:5672

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393482 5389 graceful_termination.go:89] Try delete rs "10.128.34.247:5672/TCP/10.125.2.6:5672" err: Failed to delete rs "10.128.34.247:5672/TCP/10.125.2.6:5672", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393489 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.34.247:5672/TCP/10.125.2.6:5672

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393497 5389 graceful_termination.go:160] Trying to delete rs: 10.128.35.47:4007/TCP/10.125.2.15:4007

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393523 5389 graceful_termination.go:89] Try delete rs "10.128.35.47:4007/TCP/10.125.2.15:4007" err: Failed to delete rs "10.128.35.47:4007/TCP/10.125.2.15:4007", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393530 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.35.47:4007/TCP/10.125.2.15:4007

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393538 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393563 5389 graceful_termination.go:89] Try delete rs "10.128.33.241:4059/TCP/10.125.2.26:4059" err: Failed to delete rs "10.128.33.241:4059/TCP/10.125.2.26:4059", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393571 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393578 5389 graceful_termination.go:160] Trying to delete rs: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393605 5389 graceful_termination.go:89] Try delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432" err: Failed to delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393613 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393621 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.252:6379/TCP/10.125.6.26:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393648 5389 graceful_termination.go:89] Try delete rs "10.128.33.252:6379/TCP/10.125.6.26:6379" err: Failed to delete rs "10.128.33.252:6379/TCP/10.125.6.26:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393656 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.252:6379/TCP/10.125.6.26:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393664 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393690 5389 graceful_termination.go:89] Try delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379" err: Failed to delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393697 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393704 5389 graceful_termination.go:183] Try flush graceful termination list err

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: I1115 07:50:52.393838 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: E1115 07:50:52.393940 5389 graceful_termination.go:89] Try delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125" err: device or resource busy

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: I1115 07:50:52.393957 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420734 5389 proxier.go:1496] Failed to list IPVS destinations, error: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420763 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.33.156:8125/TCP, err: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420889 5389 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420903 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.35.150:6379/TCP, err: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420961 5389 proxier.go:812] Failed to sync service: 10.128.34.54:80/TCP, err: file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.421886 5389 proxier.go:1544] Failed to add destination: 10.125.27.66:80, error: file exists

Se eu reiniciar o kube-proxy (manualmente, ugh), tudo se recupera e funciona bem. Mas vai ficar preso novamente, eventualmente.

Meio Ambiente :

- Versão do Kubernetes (use

kubectl version): v1.12.2 - Provedor de nuvem ou configuração de hardware: bare metal, linux de 64 bits

- SO (por exemplo, de / etc / os-release): Ubuntu 16.04.5 LTS

- Kernel (por exemplo,

uname -a): 4.15.0-39-generic (mas obtê-lo no kernel 4.4 original também) - Ferramentas de instalação: binário de https://storage.googleapis.com/kubernetes-release/release/v1.12.2/kubernetes-server-linux-amd64.tar.gz

- Outras:

/ tipo bug

Todos 142 comentários

rede / sig

o mesmo erro. atualização de 1.11.1. Tudo se torna bom, exceto o kube-proxy que se torna instável, às vezes o pod não consegue acessar o svc embora seus endpoints estejam ok .. E o mesmo que a resolução de nomes. então eu acho que pode haver um bug importante aqui.

/ área ipvs

@gjcarneiro você resolve esse problema?

Bem, eu mudei o cluster de volta para o modo padrão (iptables), parece estar bastante estável desde então ...

@ kubernetes / sig-network-bugs

@berlinsaint : Reiterando as menções para acionar uma notificação:

@ kubernetes / sig-network-bugs

Em resposta a isso :

@ kubernetes / sig-network-bugs

Instruções para interagir comigo usando comentários de RP estão disponíveis aqui . Se você tiver dúvidas ou sugestões relacionadas ao meu comportamento, registre um problema no repositório kubernetes / test-infra .

mesmo problema, 1.12.2 e 1.13.0-beta1. @ m1093782566 @ Lion-Wei

@gjcarneiro quer dizer que no kernel 4.15, tem o mesmo problema?

@annProg

mesmo problema, 1.12.2 e 1.13.0-beta1. @ m1093782566 @ Lion-Wei

Quanto custa sua caixa de correio, fique por dentro. .juvenil

@annProg

mesmo problema, 1.12.2 e 1.13.0-beta1. @ m1093782566 @ Lion-Wei

Quanto custa sua caixa de correio, fique por dentro. .juvenil

Clique no meu avatar para ver

Também estou vendo isso repetidamente em meu sistema de registro centralizado:

| Time | sys_name | log_lvl | tag | log_msg

| November 27th 2018, 17:56:23.501 | k8lab2bs | 6 | kube.kube-system.kube-proxy | lw: remote out of the list: 10.12.12.1:443/TCP/10.12.100.133:6443

| November 27th 2018, 17:56:23.500 | k8lab2bs | 6 | kube.kube-system.kube-proxy | Deleting rs: 10.12.12.1:443/TCP/10.12.100.133:6443

| November 27th 2018, 17:56:23.497 | k8lab2bs | 6 | kube.kube-system.kube-proxy | Trying to delete rs: 10.12.12.1:443/TCP/10.12.100.133:6443

Estou executando a v1.12.3 (instalação nova, não uma atualização).

Olá a todos. Obrigado pelo relato, vou fazer uma pesquisa e tentar descobrir o que aconteceu, qualquer progresso relatarei aqui.

Além do que aconteceu, o que é bom saber, não me sinto confiante quanto ao IPVS até que haja um código em vigor que detecte e reconfigure um soquete de netlink quebrado. Porque pelo que posso adivinhar a partir dos logs e rastreios, o soquete netlink entra em um estado quebrado e a tarefa que lê / grava dele vai travar para sempre. Acho que o kube-proxy precisa ter um código que detecte esse problema e, se isso acontecer, crie um novo soquete netlink do zero e talvez reinicie a tarefa que o trata. Mas, não, não sou voluntário, nem sei Go, desculpe.

Porque pelo que posso adivinhar a partir dos logs e rastreios, o soquete netlink entra em um estado quebrado e a tarefa que lê / grava dele vai travar para sempre.

Atualizamos a versão go netlink alguns dias atrás para oferecer suporte ao encerramento normal. A biblioteca netlink estava rodando bastante estável antes. Não tenho certeza se é a causa.

1.12.3 com o mesmo erro.

Depois de filtrar o log de INFO,

execute kubectl -n kube-system logs kube-proxy-29zh8|egrep ^E; kubectl -n kube-system logs kube-proxy-2pqdn|egrep ^E; kubectl -n kube-system logs kube-proxy-4xw8q|egrep ^E; kubectl -n kube-system logs kube-proxy-6j4bc|egrep ^E; kubectl -n kube-system logs kube-proxy-brbjb|egrep ^E; kubectl -n kube-system logs kube-proxy-r6cg2|egrep ^E; kubectl -n kube-system logs kube-proxy-rpl6t|egrep ^E;

e todo o log do nó do proxy é

bash

E1129 01:01:10.862180 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 21:09:11.422553 1 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

E1129 21:09:11.422699 1 proxier.go:1116] Failed to sync endpoint for service: 172.17.0.1:31800/TCP, err: Expected only one service obtained=0

E1129 01:01:11.618125 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:11.905626 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:01:41.771596 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:02:11.923872 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:02:42.060658 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:03:12.326762 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:03:42.718417 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:04:12.859933 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:04:42.963527 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:05:13.078486 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:05:43.185141 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:06:13.303090 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:06:43.408582 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:07:13.550358 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:07:43.686235 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:08:13.786326 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:08:43.981764 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:09:14.188053 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:09:44.316316 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:10:14.440466 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:10:44.550092 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:11:14.658190 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:11:44.765396 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:12:14.975724 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:12:45.085632 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:13:15.317679 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:13:45.432469 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:14:15.689681 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:14:45.813565 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:15:33.434931 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:16:03.578017 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:16:33.709744 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:17:03.823325 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:17:33.935191 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:18:04.053183 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:18:34.248994 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:04.375946 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:34.552779 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:36.596182 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:47.433846 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:20:17.534206 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:20:47.682350 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:21:17.825175 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:21:47.942548 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:22:18.055820 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:22:48.149494 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:23:18.564985 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:23:48.678462 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:24:18.836217 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:24:48.991344 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:25:19.091032 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:25:49.187178 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:26:19.301770 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:26:49.425812 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:27:19.606711 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:27:49.721224 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:28:20.109117 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:28:50.211574 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:29:20.405007 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:29:50.507766 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:30:20.605471 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:30:50.702798 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:31:20.807400 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:31:50.903049 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:32:21.005618 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:32:51.106378 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:33:21.224447 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:33:51.354916 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:34:21.467898 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:34:51.583216 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:35:21.691099 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:35:51.797151 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:36:21.921057 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:36:52.083821 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:02.445737 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:07.427811 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:37.546362 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:38:07.651769 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:38:37.797858 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:39:08.064112 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:39:38.181089 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:40:08.282892 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:40:38.390167 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:41:08.508549 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:41:38.617921 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:42:08.728384 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:42:38.844074 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:43:08.973517 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:43:39.092095 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:44:09.202329 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:44:39.363721 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:45:09.476240 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:45:39.764944 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:46:09.894587 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:46:40.013388 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:47:10.127894 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:47:40.236119 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:48:10.397111 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:48:40.600084 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:49:10.877034 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:49:41.023593 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:50:11.149894 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:50:41.262320 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:51:11.410407 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:51:41.547057 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:52:11.609974 1 proxier.go:1544] Failed to add destination: 172.31.200.9:443, error: file exists

E1129 01:52:11.610088 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: invalid argument

E1129 01:52:11.616690 1 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

E1129 01:52:11.616767 1 proxier.go:1116] Failed to sync endpoint for service: 172.18.0.1:31645/TCP, err: Expected only one service obtained=0

E1129 01:01:12.181112 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:22.278474 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:21.459378 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:17.442316 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 20:10:17.955872 1 proxier.go:1455] Failed to add IPVS service "dev-fffrf/mysql-testportal:mysql": file exists

E1129 20:10:17.955863 1 graceful_termination.go:89] Try delete rs "10.100.217.68:15004/TCP/192.100.143.225:15004" err: Failed to delete rs "10.100.217.68:15004/TCP/192.100.143.225:15004", can't find the real server

E1129 20:10:17.955892 1 proxier.go:1119] Failed to sync service: 172.17.0.1:31645/TCP, err: file exists

E1129 20:10:17.956412 1 proxier.go:1485] Failed to get IPVS service, error: invalid argument

E1129 20:10:17.956417 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: Failed to delete rs "10.96.0.1:443/TCP/172.31.10.38:6443", can't find the real server

E1129 20:10:17.956426 1 proxier.go:1116] Failed to sync endpoint for service: 172.31.200.67:31645/TCP, err: invalid argument

E1129 20:10:17.956448 1 graceful_termination.go:89] Try delete rs "10.101.1.98:5672/TCP/192.100.29.180:5672" err: invalid argument

E1129 20:10:17.956547 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 01:01:17.484679 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 02:52:17.498135 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: invalid argument

E1129 02:52:17.498396 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 06:28:17.607394 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: device or resource busy

E1129 06:28:17.607513 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 10:02:17.718458 1 proxier.go:1544] Failed to add destination: 192.100.183.139:3306, error: file exists

E1129 10:02:17.718606 1 proxier.go:1544] Failed to add destination: 192.100.183.152:8080, error: invalid argument

BTW. visto acima dos meus logs, parece que o kube-proxy ainda tem muitos problemas com o iptables-restore. todos os meus nodos são UBUNTU 16.04 que possuem a versão 1.6.0 do iptable.

@ m1093782566 @ Lion-Wei

Vemos isso acontecendo ao atualizar do 1.12.1. deve, portanto, estar no delta de 1.12.1 e 1.12.2.

O problema está relacionado ao encerramento normal e acho que corrigimos o bug na v1.13.1.

@ m1093782566 a correção será portada para a linha 1.12? no momento, isso está bloqueando a correção de segurança 1.12.3 para nós.

O mesmo aconteceu com a atualização de 1.11.2 para 1.11.5.

@ m1093782566 você pode fornecer mais informações sobre a correção? Eu estaria interessado em examinar o commit.

Isso é muito insano, fomos mordidos com muita força hoje cedo.

Vemos isso acontecendo ao atualizar do 1.12.1. deve, portanto, estar no delta de 1.12.1 e 1.12.2.

O mesmo aconteceu com a atualização de 1.11.2 para 1.11.5.

O bug foi escolhido por chery?

Parece o PR que corrige o problema: https://github.com/kubernetes/kubernetes/pull/71515

True @ Quentin-M

Sim, isso provavelmente vem da correção na função delete (não realmente relacionada ao título do PR).

@ m1093782566 posso criar a escolha

O bug foi escolhido por chery?

@ Quentin-M, parece que o bug foi introduzido por https://github.com/kubernetes/kubernetes/pull/66012 que foi escolhido a dedo para as versões 1.11.5 e 1.12.2:

https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.11.md#changelog -since-v1114

https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.12.md#other -notable-changes-1

Acho que todo o # 71515 deve ser escolhido a dedo. A terminação elegante em geral só foi introduzida e escolhida a dedo com o # 66012, portanto, a mudança de comportamento já aconteceu.

k8s.gcr.io/kube-proxy:v1.13.1-beta.0 ainda está obsoleto em nossos clusters. 60% deles travaram em menos de 24 horas. Tentando 1.12.1 agora.

@ Quentin-M: Você pode verificar os logs no kube-proxy e confirmar se esses tipos de mensagens sumiram:

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393664 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393690 5389 graceful_termination.go:89] Try delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379" err: Failed to delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393697 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

Ambos estão relacionados à função de exclusão fixada no PR. Se eles sumiram e você ainda vê o problema, essa correção não é suficiente

Além disso, se tudo funcionar com 1.12.1 , há uma grande probabilidade de que o problema venha do encerramento normal (# 66012)

Acho que tenho uma ideia: o que acontecerá se tentarmos adicionar um servidor real que ainda esteja em encerramento normal. Nesse caso, devemos apenas aumentar o peso para 1 e removê-lo da lista de término normal.

Tentarei testar esse cenário assim que puder (mas será complicado porque estou na Kubecon na próxima semana)

@ Lion-Wei o que você acha?

Ok, risque isso, acabei de testar e funciona bem. O código responsável por isso está aqui: https://github.com/kubernetes/kubernetes/blob/456c351e31517543e0686b2cadf21615d30a738f/pkg/proxy/ipvs/proxier.go#L1538 -L1542

Nesse caso, o RS é removido da lista gracefulDelete e do IPVS RS. Eu me pergunto se definir o peso de volta para 1 em vez disso não seria melhor

Vou tentar outras coisas com base nesta parte dos logs, que parece apontar para a tentativa de sincronizar endpoints para um serviço excluído

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420734 5389 proxier.go:1496] Failed to list IPVS destinations, error: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420763 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.33.156:8125/TCP, err: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420889 5389 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420903 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.35.150:6379/TCP, err: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420961 5389 proxier.go:812] Failed to sync service: 10.128.34.54:80/TCP, err: file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.421886 5389 proxier.go:1544] Failed to add destination: 10.125.27.66:80, error: file exists

Ok, após uma verificação rápida, o commit que corrige o problema de exclusão não está em v1.13.1-beta.0 nem em v1.14.0-alpha.0 que foi cortado em 7 de novembro

Eu acho que será na próxima versão alfa 1.14 que será baseada no mestre

Vou criar a escolha certa para 1.13 também

Tive um problema com a atualização de 1.12.0 para 1.13.0, parece estar relacionado a este, mas não é o mesmo.

Não podemos corrigir isso revertendo para o iptables. Por favor me ajude.

Eu postei no stackoverflow

Obteve o mesmo em 1.11.5. Temporário revertido de ipvs para iptables.

O mesmo em 1.11.5. Não é possível reverter para 1.11.4 devido à vulnerabilidade presente nele. Tive que mudar para iptables. A correção para isso será lançada para 1.11.x?

Você pode reverter o kube-proxy muito especificamente, sem ser afetado pela vulnerabilidade.

@ Quentin-M Sim, esse pensamento me atingiu, mas por outro lado, se o fizesse, não teria um encerramento normal, que sempre esteve lá com o iptables. Não tenho certeza se nossos clientes gostariam da mudança.

@ Quentin-M significa que não haverá correção para 1.11.x para resolver esse bug?

@emptywee Eu criei uma escolha https://github.com/kubernetes/kubernetes/pull/71848

Esperançosamente, será mesclado em breve e estará em 1.11.6

Já foi mesclado em 1.12 (estará em 1.12.4 ) e 1.13 (estará em 1.13.1 )

A escolha certa acabou de ser fundida no 1.11 também

Precisamos apenas esperar pelos próximos lançamentos de patch nos 3 branches (mas se você quiser testá-lo antes, posso criar facilmente uma compilação de proxy kube personalizada (ou, ainda mais fácil, uma imagem docker hyperkube com o patch)

Muito obrigado @lbernail ! Seria bom ter uma imagem docker disponível publicamente! Eu adoraria testar!

A correção já foi escolhida a dedo para v1.11, v1.12 e v1.13.

Você poderia testá-los para que possamos resolver este problema.

@ m1093782566 estou testando isso. A propósito, quando a comunidade publicará o pequeno lançamento para isso?

Obrigado @berlinsaint , por favor deixe-me o resultado do teste.

quando a comunidade publicará o pequeno lançamento para isso?

O novo pequeno lançamento com a correção será publicado em menos de 2 semanas.

@emptywee : aqui está: lbernail/hyperkube:v1.12.4-beta.1

Conte-nos como isto funciona para você!

@lbernail, há problema em usá-lo com tudo o mais na v1.11.5? Ou devo aumentar meu cluster do Kubernetes para v1.12.4 primeiro? De qualquer forma, muito obrigado!

@emptywee sim, deve funcionar sem problemas (estou executando kube-proxy 1.11 em clusters 1.10 há meses)

Também posso fazer uma compilação 1.11 mais tarde hoje

@lbernail sim, seria bom ter uma imagem da mesma versão de lançamento.

@emptywee aqui está: lbernail/hyperkube:v1.11.6-beta.1

@ m1093782566 @lbernail Depois de uma observação noturna, o log de erros de sincronização do ipvs não foi mais visto, enquanto

ocorre pelo menos uma vez na noite anterior. Mas ainda preciso de mais tempo para verificar isso, muito obrigado, isso me incomodou muito tempo.

Começarei os testes amanhã em 1.11 e darei alguns dias também.

@lbernail Eu tentei lbernail/hyperkube:v1.11.6-beta.1 (Obrigado por isso!)

Imediatamente pensamos que as coisas estavam consertadas, pois paramos de ver as can't find the real server mensagens de log. No entanto, depois de um dia e meio, estamos vendo problemas com entradas ipvs obsoletas em 3/6 nós do cluster.

Estas são as entradas ipvs para um serviço em um nó de cluster quebrado.

Antes de reiniciar o kube-proxy:

-A -t 10.230.65.211:9494 -s rr

-a -t 10.230.65.211:9494 -r 10.230.158.10:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.158.57:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.213.245:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.170:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.180:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.222.151:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.222.158:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.222.160:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.82:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.85:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.117:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.242.229:9494 -m -w 1

Depois de reiniciar o kube-proxy:

-A -t 10.230.65.211:9494 -s rr

-a -t 10.230.65.211:9494 -r 10.230.158.36:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.213.236:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.129:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.163:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.84:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.124:9494 -m -w 1

@lbernail @bjornryden Esse foi o motivo pelo qual entrei neste tópico quando mudei para IPVS no 1.11.5. No dia seguinte, descobri que os serviços não estavam acessíveis, então pensei que o kube-proxy havia travado e não atualizaria as entradas dos serviços.

Isso é só para avisar que tive um problema semelhante (IPs errados na tabela ipvs) com a v1.11.5 do kube-proxy.

@bjornryden Boas notícias para os erros de exclusão (era isso que o patch estava tratando)

O fato de os back-ends não serem atualizados corretamente é estranho porque o encerramento normal não deve afetar os novos endpoints (se alguns endpoints obsoletos ainda estivessem lá, eu ficaria menos surpreso)

Você poderia compartilhar os logs do kube-proxy relacionados ao serviço 10.230.65.211:9494 ?

Além disso, algum comportamento especial com este serviço / implantação? (por exemplo, os pods são atualizados com muita frequência ou por trás de um HPA?)

Portanto, está em execução há 2 dias no cluster do meu laboratório com a imagem 1.11.6-beta.1 de @lbernail no modo ipvs.

Até agora tudo bem, ele não travou e continua atualizando as entradas do ipvs.

Porém, uma observação estranha:

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.130.24:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.129.28:8443 Masq 1 0 0

A primeira chamada para ipvsadm mostra o estado inicial antes de eu excluir um dos pods do serviço. Poucos mostram que uma entrada foi removida, pois o pod foi excluído. No entanto, não sei se é como deveria ser, mas criou uma segunda entrada com o mesmo endereço IP do pod que saiu. E então ele foi atualizado para o IP correto do novo pod que veio para substituir o excluído.

Fora isso, está tudo bem. Mas o cluster do laboratório não está tão ocupado quanto os outros. O comentário de @bjornryden me deixou um pouco preocupado em experimentar a imagem em clusters mais ocupados, onde pode impactar nossos clientes.

@emptywee Presumo que o pod excluído era 10.158.130.24 . Eu não entendo isso:

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.128.28:8443 Masq 1 0 0

Ter o mesmo servidor real duas vezes não faz sentido. Você pode reproduzi-lo?

O comportamento normal na exclusão do pod deve ser:

- se não houver conexões com este pod, remova o RS

- se houver conexões, defina o peso para 0 (as conexões estabelecidas continuam, sem novas conexões)

- a cada minuto verifique todos os RS com peso 0 (é para isso que serve a lista de terminação normal) e remova aqueles que não têm mais conexões

@lbernail correto. O pod excluído tinha esse endereço IP. E sim, também parecia estranho para mim. Vou tentar reproduzir quando tiver chance. Você gostaria que eu aumentasse a verbosidade do log se eu conseguir reproduzir o mesmo comportamento? Se sim, em que nível?

@emptywee : seria ótimo, obrigado, --v=5 deve nos fornecer muitas informações

O principal é que eu nem acho que um RS pode aparecer duas vezes em um VS no IPVS (nunca vi isso). Qual kernel você está executando?

@lbernail o definirá como --v = 5 e tentará reproduzir, provavelmente em algum momento do fim de semana.

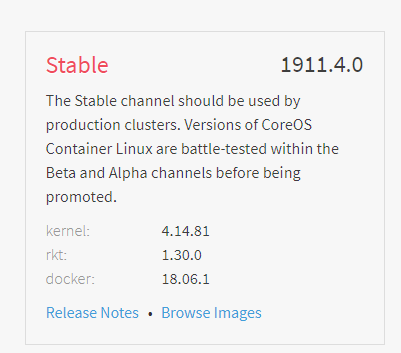

Estou no CoreOS estável:

4.14 é muito recente, então eu ficaria surpreso se houvesse um problema de IPVS

Vou tentar estressar um cluster com a versão corrigida para ver se consigo reproduzir o problema de @bjornryden

@lbernail Infelizmente, não consegui reproduzir aquele comportamento de duplicação de entrada do ipvs que vi apenas uma vez. Tentei várias vezes, com serviços diferentes. No entanto, não vi nenhuma entrada com peso 0, mas isso pode ser explicado pelo fato de que os pods que excluo saem muito rapidamente. Além disso, o kube-proxy tem respondido após ser executado por mais de 5 dias. Eu poderia tentar novamente no modo como o cluster mais ocupado aqui.

@emptywee Esta é uma "boa" notícia (mesmo se eu preferisse que pudéssemos reproduzi-la e entendê-la, talvez fosse uma falha de exibição no ipvsadm?)

O peso só é definido como 0 se forem ActiveConn ou InActiveConn. Para vê-lo, basta abrir uma conexão de longa duração com um serviço antes de excluir o pod associado (por exemplo, usando telnet)

5 dias de estabilidade são boas notícias! Deixe-nos saber como vai quando / se você tentar em um cluster mais ocupado

Tenho algumas pequenas melhorias a caminho:

- https://github.com/kubernetes/kubernetes/pull/71834 : faça com que a terminação normal funcione com serviços usando sessionAffinity (já no mestre, escolhas aleatórias criadas para 1.13, 1.12 e 1.11)

- https://github.com/kubernetes/kubernetes/pull/71895 e https://github.com/kubernetes/kubernetes/pull/72106 : suporte ao encerramento normal ao excluir um serviço (o primeiro já está no mestre, estou esperando o segundo escolher ambos em todos os ramos)

Além disso, 1.11.6 , 1.12.4 e 1.13.1 foram lançados e contêm a correção na função de exclusão

Escrevi um pequeno artigo sobre o assunto no fim de semana /. Vou me certificar de atualizá-lo com a versão corrigida!

@lbernail Claro, basta! A sua imagem do hyperkube é a mesma que foi lançada como 1.11.6? Instalei sua imagem para kube-proxy apenas no cluster mais ocupado e mudei para ipvs novamente para teste. Você gostaria que eu usasse o oficial?

@emptywee Minha imagem e a 1.11.6 são basicamente as mesmas: eu a construí do cabeçalho do branch release-1.11 alguns dias antes do lançamento oficial, então a diferença são alguns commits no máximo, nenhum envolvendo IPVS. Portanto, não acho que vale a pena o esforço de atualizar seu cluster novamente

Más notícias :( acabei de receber o meu kube-proxy e não conseguiu atualizar os back-ends do ipvs. Voltando para iptables e coletando logs. O kube-proxy estava em execução com a bandeira --v=5 .

@lbernail Então, não

$ cat kube-proxy-issue.log | egrep -e 'c-qa4/ycsdtleuk|10.148.191.69|10.148.192.14|10.148.183.70|10.148.184.67'

I1217 19:12:52.849863 1 graceful_termination.go:160] Trying to delete rs: 10.148.6.202:80/TCP/10.148.192.14:8080

I1217 19:12:52.849948 1 graceful_termination.go:173] Deleting rs: 10.148.6.202:80/TCP/10.148.192.14:8080

I1217 19:12:52.850000 1 graceful_termination.go:160] Trying to delete rs: 10.148.6.202:80/TCP/10.148.191.69:8080

I1217 19:12:52.850069 1 graceful_termination.go:173] Deleting rs: 10.148.6.202:80/TCP/10.148.191.69:8080

I1217 19:12:53.425438 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:13:00.501203 1 ipset.go:140] Successfully delete legacy ip set entry: 10.148.191.69,tcp:8080,10.148.191.69 from ip set: KUBE-LOOP-BACK

I1217 19:13:00.543691 1 ipset.go:140] Successfully delete legacy ip set entry: 10.148.192.14,tcp:8080,10.148.192.14 from ip set: KUBE-LOOP-BACK

I1217 19:13:06.916777 1 service.go:309] Adding new service port "c-qa4/ycsdtleuk:http" at 10.148.6.202:80/TCP

I1217 19:13:08.345142 1 proxier.go:1465] Adding new service "c-qa4/ycsdtleuk:http" 10.148.6.202:80/TCP

I1217 19:13:13.939763 1 ipset.go:148] Successfully add entry: 10.148.191.69,tcp:8080,10.148.191.69 to ip set: KUBE-LOOP-BACK

I1217 19:13:14.002663 1 ipset.go:148] Successfully add entry: 10.148.192.14,tcp:8080,10.148.192.14 to ip set: KUBE-LOOP-BACK

I1217 19:27:53.485483 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:27:53.485526 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:42:53.388638 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:42:53.388673 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:57:53.643829 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:57:53.644032 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:12:53.541080 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:12:53.541129 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:27:53.368129 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:27:53.368306 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:42:53.539517 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:42:53.539542 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:57:53.624320 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:57:53.624371 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:12:53.630561 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:12:53.630585 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:20.897397 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:20.897463 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:46.630013 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:46.630084 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:57.995544 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:57.995657 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:27:24.296606 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:27:53.678172 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:28:21.517538 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080]

I1217 21:28:21.595632 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 21:42:53.491595 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 21:57:53.492214 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 22:05:45.760620 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080]

I1217 22:06:24.890429 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080]

I1217 22:07:15.463144 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.68:8080]

I1217 22:07:43.201415 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080]

I1217 22:08:18.268005 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080]

I1217 22:08:58.774066 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:12:53.528515 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:27:53.522197 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:20.396794 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:43.994895 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:54.382253 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.192.70:8080]

I1217 22:30:17.895084 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.184.67:8080 10.148.192.70:8080]

I1217 22:31:45.791871 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.184.67:8080]

I1217 22:31:45.855011 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

I1217 22:42:53.652587 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

I1217 22:57:53.509372 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

Mas quando verifiquei com ipvsadm, ainda estava mostrando os dois primeiros: 10.148.191.69:8080 10.148.192.14:8080

Enquanto kubectl -n c-qa4 describe svc ycsdtleuk estava dizendo que os endpoints são 10.148.183.70:8080 10.148.184.67:8080 , e em outras caixas as entradas de ipvs para o mesmo serviço estavam sendo atualizadas corretamente.

$ kubectl -n c-qa4 describe svc ycsdtleuk

Name: ycsdtleuk

Namespace: c-qa4

Labels: country=uk

env=qa

run=ycsdtleuk

stack=c

track=4

Annotations: run: ycsdtleuk

Selector: load-balancer-ycsdtleuk=true

Type: ClusterIP

IP: 10.148.6.202

Port: http 80/TCP

TargetPort: 8080/TCP

Endpoints: 10.148.183.70:8080,10.148.184.67:8080

Session Affinity: None

Events: <none>

Basicamente, estava olhando para o seguinte em duas caixas ao mesmo tempo:

(incorrect ipvs config)

rnqkbm401 ~ # ipvsadm -L -t 10.148.6.202:80

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP rnqkbm401:http rr

-> 10.148.191.69:http-alt Masq 1 0 0

-> 10.148.192.14:http-alt Masq 1 0 0

(correct ipvs config)

rnqkbw401 ~ # ipvsadm -L -t 10.148.6.202:80

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP rnqkbw401:http rr

-> 10.148.183.70:http-alt Masq 1 0 0

-> 10.148.184.67:http-alt Masq 1 0 0

Não há mensagem de erro óbvia ou qualquer coisa gritando que indique qualquer sinal de um problema em qualquer lugar. Posso enviar o arquivo de log completo (18M descompactado) diretamente para você, se desejar.

Resumindo: parece que enquanto a parte que escuta as mudanças de serviços está funcionando bem, mas a parte que está interagindo com o módulo ipvs não está. Não estou nem vendo que ele estava tentando excluir os dois endereços IP iniciais depois de adicioná-los. Algo está travando em algum lugar.

@emptywee Obrigado pelo relatório detalhado. Nada de estranho nesses logs.

O que é surpreendente é que syncProxyRules é executado pelo menos a cada 30s (padrão) e deve reconciliar servidores IPVS reais com endpoints. Ele chama syncEndpoints que aciona AddRealServer e ipvsHandle.NewDestination

Tudo isso acontece antes da exclusão de endpoints antigos, portanto, não deve ser afetado pelo encerramento normal

Você poderia me enviar os logs completos para que eu possa ver exatamente o que acontece entre 21:26 e 21:29 ?

Duas perguntas adicionais:

- um único Kube-proxy foi afetado, certo?

- Um único serviço foi afetado (o outro continuou a atualizar normalmente?)

Da próxima vez, tente enviar SIGABRT ao processo, para que ele imprima os estados das tarefas.

Quando eu tinha o problema, ele estava sempre fazendo algo dentro de libnetwork/ipvs/netlink.go , o que me leva a suspeitar que a chamada de sistema do netlink travou por algum motivo.

Desculpe pela minha ausência, mas fim de semana e depois tive que me concentrar em reverter para o iptables para nossa configuração.

Analisando os registros solicitados para o serviço, @lbernail , temos muitos destes:

I1214 11:48:44.889081 1 graceful_termination.go:160] Trying to delete rs: 172.17.0.1:31663/TCP/10.230.213.204:9300