Kubernetes: kube-proxy ipvsモードが数時間後にハングし、手動で再起動する必要があります

バグを報告する際はこのテンプレートを使用し、できるだけ多くの情報を提供してください。 そうしないと、バグがタイムリーに対処されない可能性があります。 ありがとう!

何が起こったのか:v1.11.0からv1.12.2にアップグレードされ、kube-proxyがハングします。通常は1日以内です。

あなたが起こると期待したこと:それは機能し続けるはずです

それを再現する方法(可能な限り最小限かつ正確に) :通常のkubeプロキシをipvsモードで実行するだけです。 通常、1日以内にスタックします。

他に知っておくべきことはありますか? :

スタックトレースを取得するためにSIGABRTをkube-proxyプロセスに送信しましたが、興味深いのは、バグが発生したときにgoroutine 1がnetlinkから読み取っているのに対し、SIGABRTを送信してプロセスがスタックしていない場合は読み取っていないことだけです。 netlinkから。

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: goroutine 1 [syscall]:

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.Syscall6(0x2d, 0x3, 0xc42081c000, 0x1000, 0x0, 0xc42083deb0, 0xc42083dea4, 0x40fb86, 0x7f2ab9788aa8, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/asm_linux_amd64.s:44 +0x5

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.recvfrom(0x3, 0xc42081c000, 0x1000, 0x1000, 0x0, 0xc42083deb0, 0xc42083dea4, 0x101ffffffffffff, 0x0, 0x1000)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/zsyscall_linux_amd64.go:1665 +0xa6

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: syscall.Recvfrom(0x3, 0xc42081c000, 0x1000, 0x1000, 0x0, 0x1000, 0x0, 0x0, 0x16ad4c0, 0x1f4d508)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /usr/local/go/src/syscall/syscall_unix.go:252 +0xaf

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/vishvananda/netlink/nl.(*NetlinkSocket).Receive(0xc4204d3440, 0x0, 0x0, 0x0, 0x16ad4c0, 0x1f4d508)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/vishvananda/netlink/nl/nl_linux.go:613 +0x9b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.execute(0xc4204d3440, 0xc42083e150, 0x0, 0x1, 0x2, 0xc420423740, 0x1, 0x2)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:219 +0xd3

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).doCmdwithResponse(0xc420573990, 0xc420990750, 0x0, 0xc42003d501, 0xa, 0x10, 0xc420990701, 0xc42083e230, 0x118dd6b)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:140 +0x20b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).doCmd(0xc420573990, 0xc420990750, 0x0, 0x1, 0x60000020fc6e0, 0xc420990750)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/netlink.go:149 +0x48

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs.(*Handle).NewService(0xc420573990, 0xc420990750, 0x0, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/docker/libnetwork/ipvs/ipvs.go:117 +0x43

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/ipvs.(*runner).AddVirtualServer(0xc42052a340, 0xc420b0e550, 0x1e, 0xc42083e3b8)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/ipvs/ipvs_linux.go:61 +0x60

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).syncService(0xc4201b3e00, 0xc420d53620, 0x21, 0xc420b0e550, 0xc420357901, 0x5, 0xc420d53620)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:1454 +0x635

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).syncProxyRules(0xc4201b3e00)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:803 +0x1081

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).(k8s.io/kubernetes/pkg/proxy/ipvs.syncProxyRules)-fm()

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:395 +0x2a

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/async.(*BoundedFrequencyRunner).tryRun(0xc42042e3f0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/async/bounded_frequency_runner.go:217 +0xb6

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/util/async.(*BoundedFrequencyRunner).Loop(0xc42042e3f0, 0xc4200b0120)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/util/async/bounded_frequency_runner.go:179 +0x211

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/pkg/proxy/ipvs.(*Proxier).SyncLoop(0xc4201b3e00)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/pkg/proxy/ipvs/proxier.go:589 +0x4e

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.(*ProxyServer).Run(0xc4207f2000, 0xc4207f2000, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:568 +0x3dd

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.(*Options).Run(0xc4201082c0, 0xc42063e230, 0x0)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:238 +0x69

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/cmd/kube-proxy/app.NewProxyCommand.func1(0xc4200f2500, 0xc42063e230, 0x0, 0x7)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/cmd/kube-proxy/app/server.go:360 +0x156

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).execute(0xc4200f2500, 0xc4200c4010, 0x7, 0x7, 0xc4200f2500, 0xc4200c4010)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:760 +0x2c1

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).ExecuteC(0xc4200f2500, 0xc4205dc090, 0x16076a0, 0xc4207a7ee8)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:846 +0x30a

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: k8s.io/kubernetes/vendor/github.com/spf13/cobra.(*Command).Execute(0xc4200f2500, 0x1608b88, 0x20dcf40)

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: /workspace/anago-v1.12.2-beta.0.59+17c77c78982180/src/k8s.io/kubernetes/_output/dockerized/go/src/k8s.io/kubernetes/vendor/github.com/spf13/cobra/command.go:794 +0x2b

Nov 15 11:42:05 hex-48b-pm kube-proxy[5389]: main.main()

ログに記録された最後の行は次のとおりです。

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392942 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392952 5389 graceful_termination.go:160] Trying to delete rs: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: E1115 07:48:52.392978 5389 graceful_termination.go:89] Try delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432" err: Failed to delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432", can't

find the real server

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: I1115 07:48:52.392985 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:48:52 hex-48b-pm kube-proxy[5389]: E1115 07:48:52.392992 5389 graceful_termination.go:183] Try flush graceful termination list err

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393147 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393260 5389 graceful_termination.go:89] Try delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125" err: Failed to delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393272 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393281 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393310 5389 graceful_termination.go:89] Try delete rs "10.128.33.142:6379/TCP/10.125.6.13:6379" err: Failed to delete rs "10.128.33.142:6379/TCP/10.125.6.13:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393317 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393327 5389 graceful_termination.go:160] Trying to delete rs: 10.128.34.237:6379/TCP/10.125.6.11:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393355 5389 graceful_termination.go:89] Try delete rs "10.128.34.237:6379/TCP/10.125.6.11:6379" err: Failed to delete rs "10.128.34.237:6379/TCP/10.125.6.11:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393362 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.34.237:6379/TCP/10.125.6.11:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393371 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.200:5432/TCP/10.125.6.27:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393397 5389 graceful_termination.go:89] Try delete rs "10.128.33.200:5432/TCP/10.125.6.27:6432" err: Failed to delete rs "10.128.33.200:5432/TCP/10.125.6.27:6432", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393404 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.200:5432/TCP/10.125.6.27:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393412 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.228:6379/TCP/10.125.2.63:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393440 5389 graceful_termination.go:89] Try delete rs "10.128.33.228:6379/TCP/10.125.2.63:6379" err: Failed to delete rs "10.128.33.228:6379/TCP/10.125.2.63:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393447 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.228:6379/TCP/10.125.2.63:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393455 5389 graceful_termination.go:160] Trying to delete rs: 10.128.34.247:5672/TCP/10.125.2.6:5672

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393482 5389 graceful_termination.go:89] Try delete rs "10.128.34.247:5672/TCP/10.125.2.6:5672" err: Failed to delete rs "10.128.34.247:5672/TCP/10.125.2.6:5672", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393489 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.34.247:5672/TCP/10.125.2.6:5672

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393497 5389 graceful_termination.go:160] Trying to delete rs: 10.128.35.47:4007/TCP/10.125.2.15:4007

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393523 5389 graceful_termination.go:89] Try delete rs "10.128.35.47:4007/TCP/10.125.2.15:4007" err: Failed to delete rs "10.128.35.47:4007/TCP/10.125.2.15:4007", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393530 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.35.47:4007/TCP/10.125.2.15:4007

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393538 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393563 5389 graceful_termination.go:89] Try delete rs "10.128.33.241:4059/TCP/10.125.2.26:4059" err: Failed to delete rs "10.128.33.241:4059/TCP/10.125.2.26:4059", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393571 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.241:4059/TCP/10.125.2.26:4059

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393578 5389 graceful_termination.go:160] Trying to delete rs: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393605 5389 graceful_termination.go:89] Try delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432" err: Failed to delete rs "10.128.32.132:5432/TCP/10.125.2.13:6432", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393613 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.32.132:5432/TCP/10.125.2.13:6432

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393621 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.252:6379/TCP/10.125.6.26:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393648 5389 graceful_termination.go:89] Try delete rs "10.128.33.252:6379/TCP/10.125.6.26:6379" err: Failed to delete rs "10.128.33.252:6379/TCP/10.125.6.26:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393656 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.252:6379/TCP/10.125.6.26:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393664 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393690 5389 graceful_termination.go:89] Try delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379" err: Failed to delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393697 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393704 5389 graceful_termination.go:183] Try flush graceful termination list err

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: I1115 07:50:52.393838 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.156:8125/TCP/10.125.2.21:8125

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: E1115 07:50:52.393940 5389 graceful_termination.go:89] Try delete rs "10.128.33.156:8125/TCP/10.125.2.21:8125" err: device or resource busy

Nov 15 07:50:52 hex-48b-pm kube-proxy[5389]: I1115 07:50:52.393957 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.142:6379/TCP/10.125.6.13:6379

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420734 5389 proxier.go:1496] Failed to list IPVS destinations, error: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420763 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.33.156:8125/TCP, err: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420889 5389 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420903 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.35.150:6379/TCP, err: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420961 5389 proxier.go:812] Failed to sync service: 10.128.34.54:80/TCP, err: file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.421886 5389 proxier.go:1544] Failed to add destination: 10.125.27.66:80, error: file exists

kube-proxyを再起動すると(手動で、ugh)、すべて回復して正常に動作します。 しかし、最終的には再び行き詰まります。

環境:

- Kubernetesバージョン(

kubectl version):v1.12.2 - クラウドプロバイダーまたはハードウェア構成:ベアメタル、64ビットLinux

- OS(例:/ etc / os-releaseから):Ubuntu 16.04.5 LTS

- カーネル(例:

uname -a):4.15.0-39-汎用(ただし、元の4.4カーネルでも取得) - ツールのインストール: https ://storage.googleapis.com/kubernetes-release/release/v1.12.2/kubernetes-server-linux-amd64.tar.gzからのバイナリ

- その他:

/種類のバグ

全てのコメント142件

/ sigネットワーク

同じエラー。 1.11.1からアップグレードします。 kube-proxyが安定しなくなることを除いて、すべてが良好になります。エンドポイントは問題ありませんが、ポッドがsvcにアクセスできない場合があります。名前解決と同じです。 ですから、ここに重要なバグがあるのではないかと思います。

/ area ipvs

@gjcarneiroこの問題を解決しますか?

さて、私はクラスターをデフォルト(iptables)モードに戻しましたが、それ以来かなり安定しているようです...

@ kubernetes / sig-ネットワーク-バグ

@berlinsaint :通知をトリガーするために言及を繰り返します:

@ kubernetes / sig-network-bugs

対応して、この:

@ kubernetes / sig-network-bugs

PRコメントを使用して私とやり取りするための手順は、こちらから入手できkubernetes / test-infraリポジトリに対して問題を

同じ問題、1.12.2と1.13.0-beta1の両方。 @ m1093782566 @ Lion-Wei

@gjcarneiroカーネル4.15でも同じ問題があるということですか?

@annProg

同じ問題、1.12.2と1.13.0の両方-beta1。 @ m1093782566 @ Lion-Wei

あなたのメールボックスはいくらですか、それを知ってください。 。少年

@annProg

同じ問題、1.12.2と1.13.0の両方-beta1。 @ m1093782566 @ Lion-Wei

あなたのメールボックスはいくらですか、それを知ってください。 。少年

アバターをクリックして確認してください

これは、集中ログシステムでも繰り返し見られます。

| Time | sys_name | log_lvl | tag | log_msg

| November 27th 2018, 17:56:23.501 | k8lab2bs | 6 | kube.kube-system.kube-proxy | lw: remote out of the list: 10.12.12.1:443/TCP/10.12.100.133:6443

| November 27th 2018, 17:56:23.500 | k8lab2bs | 6 | kube.kube-system.kube-proxy | Deleting rs: 10.12.12.1:443/TCP/10.12.100.133:6443

| November 27th 2018, 17:56:23.497 | k8lab2bs | 6 | kube.kube-system.kube-proxy | Trying to delete rs: 10.12.12.1:443/TCP/10.12.100.133:6443

v1.12.3を実行しています(アップグレードではなく、新規インストール)。

こんにちは、みんな。 報告してくれてありがとう、私は調査をして、何が起こったのか、ここで報告する進歩を理解しようとします。

何が起こったのかを知るのは良いことですが、壊れたネットリンクソケットを検出してリセットするコードが配置されるまで、IPVSについて自信がありません。 ログとトレースから推測できるのは、netlinkソケットが壊れた状態になり、それとの間で読み取り/書き込みを行うタスクが永久にハングするためです。 kube-proxyにはこの問題を検出するコードが必要だと思います。それが発生した場合は、新しいネットリンクソケットを最初から作成し、それを処理するタスクを再起動します。 でも、いや、私はボランティアではありません。Goも知りません。ごめんなさい。

ログとトレースから推測できるのは、netlinkソケットが壊れた状態になり、それとの間で読み取り/書き込みを行うタスクが永久にハングするためです。

正常な終了をサポートするために、数日前にgonetlinkバージョンをアップグレードしました。 ネットリンクライブラリは、以前はかなり安定して実行されていました。 それが原因かどうかはわかりません。

同じエラーで1.12.3。

INFOログをフィルタリングした後、

kubectl -n kube-system logs kube-proxy-29zh8|egrep ^E; kubectl -n kube-system logs kube-proxy-2pqdn|egrep ^E; kubectl -n kube-system logs kube-proxy-4xw8q|egrep ^E; kubectl -n kube-system logs kube-proxy-6j4bc|egrep ^E; kubectl -n kube-system logs kube-proxy-brbjb|egrep ^E; kubectl -n kube-system logs kube-proxy-r6cg2|egrep ^E; kubectl -n kube-system logs kube-proxy-rpl6t|egrep ^E;実行します

そして、すべてのプロキシノードログは

bash

E1129 01:01:10.862180 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 21:09:11.422553 1 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

E1129 21:09:11.422699 1 proxier.go:1116] Failed to sync endpoint for service: 172.17.0.1:31800/TCP, err: Expected only one service obtained=0

E1129 01:01:11.618125 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:11.905626 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:01:41.771596 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:02:11.923872 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:02:42.060658 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:03:12.326762 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:03:42.718417 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:04:12.859933 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:04:42.963527 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:05:13.078486 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:05:43.185141 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:06:13.303090 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:06:43.408582 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:07:13.550358 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:07:43.686235 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:08:13.786326 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:08:43.981764 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:09:14.188053 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:09:44.316316 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:10:14.440466 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:10:44.550092 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:11:14.658190 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:11:44.765396 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:12:14.975724 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:12:45.085632 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:13:15.317679 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:13:45.432469 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:14:15.689681 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:14:45.813565 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:15:33.434931 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:16:03.578017 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:16:33.709744 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:17:03.823325 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:17:33.935191 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:18:04.053183 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:18:34.248994 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:04.375946 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:34.552779 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:36.596182 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:19:47.433846 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:20:17.534206 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:20:47.682350 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:21:17.825175 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:21:47.942548 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:22:18.055820 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:22:48.149494 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:23:18.564985 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:23:48.678462 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:24:18.836217 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:24:48.991344 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:25:19.091032 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:25:49.187178 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:26:19.301770 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:26:49.425812 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:27:19.606711 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:27:49.721224 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:28:20.109117 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:28:50.211574 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:29:20.405007 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:29:50.507766 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:30:20.605471 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:30:50.702798 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:31:20.807400 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:31:50.903049 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:32:21.005618 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:32:51.106378 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:33:21.224447 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:33:51.354916 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:34:21.467898 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:34:51.583216 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:35:21.691099 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:35:51.797151 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:36:21.921057 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:36:52.083821 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:02.445737 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:07.427811 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:37:37.546362 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:38:07.651769 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:38:37.797858 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:39:08.064112 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:39:38.181089 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:40:08.282892 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:40:38.390167 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:41:08.508549 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:41:38.617921 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:42:08.728384 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:42:38.844074 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:43:08.973517 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:43:39.092095 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:44:09.202329 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:44:39.363721 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:45:09.476240 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:45:39.764944 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:46:09.894587 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:46:40.013388 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:47:10.127894 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:47:40.236119 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:48:10.397111 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:48:40.600084 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:49:10.877034 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:49:41.023593 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:50:11.149894 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:50:41.262320 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:51:11.410407 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:51:41.547057 1 proxier.go:1622] Failed to unbind service addr fe80::1c5d:70ff:fef2:e97b from dummy interface kube-ipvs0: error unbind address: fe80::1c5d:70ff:fef2:e97b from interface: kube-ipvs0, err: cannot assign requested address

E1129 01:52:11.609974 1 proxier.go:1544] Failed to add destination: 172.31.200.9:443, error: file exists

E1129 01:52:11.610088 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: invalid argument

E1129 01:52:11.616690 1 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

E1129 01:52:11.616767 1 proxier.go:1116] Failed to sync endpoint for service: 172.18.0.1:31645/TCP, err: Expected only one service obtained=0

E1129 01:01:12.181112 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:22.278474 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:21.459378 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 01:01:17.442316 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 20:10:17.955872 1 proxier.go:1455] Failed to add IPVS service "dev-fffrf/mysql-testportal:mysql": file exists

E1129 20:10:17.955863 1 graceful_termination.go:89] Try delete rs "10.100.217.68:15004/TCP/192.100.143.225:15004" err: Failed to delete rs "10.100.217.68:15004/TCP/192.100.143.225:15004", can't find the real server

E1129 20:10:17.955892 1 proxier.go:1119] Failed to sync service: 172.17.0.1:31645/TCP, err: file exists

E1129 20:10:17.956412 1 proxier.go:1485] Failed to get IPVS service, error: invalid argument

E1129 20:10:17.956417 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: Failed to delete rs "10.96.0.1:443/TCP/172.31.10.38:6443", can't find the real server

E1129 20:10:17.956426 1 proxier.go:1116] Failed to sync endpoint for service: 172.31.200.67:31645/TCP, err: invalid argument

E1129 20:10:17.956448 1 graceful_termination.go:89] Try delete rs "10.101.1.98:5672/TCP/192.100.29.180:5672" err: invalid argument

E1129 20:10:17.956547 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 01:01:17.484679 1 proxier.go:430] Failed to execute iptables-restore for nat: exit status 1 (iptables-restore: line 7 failed

E1129 02:52:17.498135 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: invalid argument

E1129 02:52:17.498396 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 06:28:17.607394 1 graceful_termination.go:89] Try delete rs "10.96.0.1:443/TCP/172.31.10.38:6443" err: device or resource busy

E1129 06:28:17.607513 1 graceful_termination.go:183] Try flush graceful termination list err

E1129 10:02:17.718458 1 proxier.go:1544] Failed to add destination: 192.100.183.139:3306, error: file exists

E1129 10:02:17.718606 1 proxier.go:1544] Failed to add destination: 192.100.183.152:8080, error: invalid argument

ところで。 私のログの上から、kube-proxyはまだiptables-restoreで多くの問題を抱えているようです。 私のノードはすべて、iptableのバージョン1.6.0を持つUBUNTU16.04です。

@ m1093782566 @ Lion-Wei

これは、1.12.1からアップグレードするときに発生します。 したがって、1.12.1と1.12.2のデルタ内にある必要があります。

この問題は正常終了に関連しており、v1.13.1でバグを修正したと思います。

@ m1093782566修正は1.12行にバックポートされますか? 現在、これは1.12.3のセキュリティ修正をブロックしています。

1.11.2から1.11.5へのアップグレードでも同じようになりました。

@ m1093782566修正に関する詳細情報を提供できますか? コミットを確認したいと思います。

これはかなり正気ではありません、私たちは今日早くに本当に激しく噛まれました。

これは、1.12.1からアップグレードするときに発生します。 したがって、1.12.1と1.12.2のデルタ内にある必要があります。

1.11.2から1.11.5へのアップグレードでも同じようになりました。

バグは陽気に選ばれましたか?

これは、問題を修正するPRのように見えます: //github.com/kubernetes/kubernetes/pull/71515

真の@ Quentin-M

はい、これはおそらくdelete関数の修正によるものです(PRのタイトルとは実際には関係ありません)。

@ m10937825661.12のチェリーピックを作成できます。 完全なPRをバックポートしますか、それとも削除機能の修正のみをバックポートしますか? (1.12のUDPフローでの動作の変更を回避するため)

バグは陽気に選ばれましたか?

@ Quentin-Mバグはhttps://github.com/kubernetes/kubernetes/pull/66012によって導入されたようですが、1.11.5および1.12.2リリースに厳選されました。

https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.11.md#changelog -since-v1114

https://github.com/kubernetes/kubernetes/blob/master/CHANGELOG-1.12.md#other -notable-changes-1

#71515はすべて厳選する必要があると思います。 全体的にグレースフルターミネーションが導入され、#66012で厳選されただけなので、動作の変更はすでに行われています。

k8s.gcr.io/kube-proxy:v1.13.1-beta.0まだクラスター上で古くなっています。 それらの60%は24時間以内に立ち往生しました。 今1.12.1を試してみてください。

@ Quentin-M:kube-proxyのログをチェックして、これらのタイプのメッセージがなくなったことを確認できますか?

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393664 5389 graceful_termination.go:160] Trying to delete rs: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: E1115 07:49:52.393690 5389 graceful_termination.go:89] Try delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379" err: Failed to delete rs "10.128.33.237:6379/TCP/10.125.6.34:6379", can't find the real server

Nov 15 07:49:52 hex-48b-pm kube-proxy[5389]: I1115 07:49:52.393697 5389 graceful_termination.go:93] lw: remote out of the list: 10.128.33.237:6379/TCP/10.125.6.34:6379

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

どちらもPRで修正された削除機能に関連しています。 これらがなくなっても問題が解決しない場合は、この修正だけでは不十分です。

また、すべてが1.12.1で機能する場合、問題は正常な終了に起因する可能性が高いです(#66012)

私は考えを持っていると思います:まだ正常に終了している実サーバーを追加しようとするとどうなるのだろうか。 この場合、重みを1に増やして、グレースフルターミネーションリストから削除する必要があります。

できるだけ早くこのシナリオをテストしようと思います(ただし、来週はKubeconにいるので注意が必要です)

@ Lion-Weiどう思いますか?

それをスクラッチします、私はちょうどテストしました、そしてそれはうまく働きます。 それを担当するコードはここにあります: https :

その場合、RSはgracefulDeleteリストとIPVSRSから削除されます。 代わりに重みを1に戻す方が良いのではないかと思います

ログのこの部分に基づいて他のことを試してみます。これは、削除されたサービスのエンドポイントを同期しようとしていることを示しているようです。

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420734 5389 proxier.go:1496] Failed to list IPVS destinations, error: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420763 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.33.156:8125/TCP, err: invalid argument

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420889 5389 proxier.go:1485] Failed to get IPVS service, error: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420903 5389 proxier.go:809] Failed to sync endpoint for service: 10.128.35.150:6379/TCP, err: Expected only one service obtained=0

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420950 5389 proxier.go:1455] Failed to add IPVS service "monitoring/extradata-inserter:": file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.420961 5389 proxier.go:812] Failed to sync service: 10.128.34.54:80/TCP, err: file exists

Nov 15 07:51:22 hex-48b-pm kube-proxy[5389]: E1115 07:51:22.421886 5389 proxier.go:1544] Failed to add destination: 10.125.27.66:80, error: file exists

簡単なチェックの後、削除の問題を修正するコミットはv1.13.1-beta.0も、11月7日にカットされたv1.14.0-alpha.0もありません。

マスターをベースにした次の1.14アルファリリースになると思います

1.13のチェリーピックも作成します

1.12.0から1.13.0へのアップグレードで問題が発生しました。これに関連しているようですが、同じではありません。

iptablesに戻して修正することはできません。 私を助けてください。

stackoverflowに投稿しました

1.11.5でも同じようになりました。 一時的にipvsからiptablesに戻りました。

1.11.5でも同じです。 脆弱性が存在するため、1.11.4にロールバックできません。 iptablesに切り替える必要がありました。 これに対する修正は1.11.xでリリースされる予定ですか?

脆弱性の影響を受けることなく、kube-proxyを非常に具体的にロールバックできます。

@ Quentin-Mええ、その考えは私の頭に浮かびましたが、他の考えでは、私がそれをした場合、iptablesと一緒にずっとそこにあった優雅な終了はありませんでした。 お客様が変更を望んでいるかどうかわからない。

@ Quentin-Mは、このバグに対処するための1.11.xの修正がないことを意味しますか?

@emptywee 1.11のチェリーピックを作成しました: https :

うまくいけば、それはすぐにマージされ、 1.11.6

1.12( 1.12.4 )と1.13( 1.13.1 )ですでにマージされています

チェリーピックも1.11で統合されました

3つのブランチで次のパッチリリースを待つ必要があります(ただし、テストする前に、カスタムkube-proxyビルド(または、さらに簡単に、パッチを使用したhyperkube dockerイメージ)を簡単に作成できます)

どうもありがとう@lbernail ! 公開されているDockerイメージがあれば便利です。 私はそれをテストしたいです!

修正はすでにv1.11、v1.12、v1.13に厳選されています。

この問題を解決できるように、テストしていただけませんか。

@ m1093782566私はこれをテストしています。 ところで、コミュニティはいつこのための小さなリリースを公開しますか?

@berlinsaintに感謝します、テスト結果を教えてください。

コミュニティはいつこのための小さなリリースを公開しますか?

修正された新しい小さなリリースは、2週間以内に公開されます。

@emptywee :ここに行きます: lbernail/hyperkube:v1.12.4-beta.1

それがあなたのためにどのように機能するかを私たちに知らせてください!

@lbernail v1.11.5で他のすべてのものと一緒に使用しても大丈夫ですか? または、最初にkubernetesクラスターをv1.12.4にバンプする必要がありますか? とにかく、どうもありがとう!

@emptyweeはい、問題なく動作するはずです(1.10クラスターで

今日の後半に1.11ビルドを実行することもできます

@lbernailええ、同じリリースバージョンの画像があればいいのにと

@emptyweeここに行きます: lbernail/hyperkube:v1.11.6-beta.1

@ m1093782566 @lbernailある夜の

少なくとも一晩前に一度発生します。 しかし、それを確認するためにまだもっと時間が必要です、どうもありがとう、それは私を長い間イライラさせました。

明日1.11からテストを開始し、数日もテストを開始します。

@lbernail私はあなたにlbernail/hyperkube:v1.11.6-beta.1を試しました(ありがとう!)

can't find the real serverログメッセージが表示されなくなったため、すぐに問題が解決したと思いました。 ただし、1日半後、3/6クラスターノードの古いipvsエントリで問題が発生しています。

これは、壊れたクラスターノード上のサービスのipvsエントリです。

kube-proxyを再起動する前に:

-A -t 10.230.65.211:9494 -s rr

-a -t 10.230.65.211:9494 -r 10.230.158.10:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.158.57:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.213.245:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.170:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.180:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.222.151:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.222.158:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.222.160:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.82:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.85:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.117:9494 -m -w 0

-a -t 10.230.65.211:9494 -r 10.230.242.229:9494 -m -w 1

kube-proxyを再起動した後:

-A -t 10.230.65.211:9494 -s rr

-a -t 10.230.65.211:9494 -r 10.230.158.36:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.213.236:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.129:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.216.163:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.84:9494 -m -w 1

-a -t 10.230.65.211:9494 -r 10.230.226.124:9494 -m -w 1

@lbernail @bjornrydenこれが、1.11.5でIPVSに切り替えたときにこのスレッドに入った理由です。 翌日、サービスにアクセスできないことがわかったので、kube-proxyがハングし、サービスのエントリを更新しないと思いました。

これは、kube-proxyのv1.11.5で同様の問題(ipvsテーブルのIPが間違っている)があったことをお知らせするためのものです。

@bjornryden削除エラーの朗報(これはパッチが対処していたものでした)

正常な終了が新しいエンドポイントに影響を与えるべきではないため、バックエンドが適切に更新されないという事実は奇妙です(たとえば、いくつかの古いエンドポイントがまだそこにある場合、私はそれほど驚かないでしょう)

サービス10.230.65.211:9494関連するkube-proxyのログを共有できますか?

また、このサービス/デプロイメントに関する特別な動作はありますか? (たとえば、ポッドは非常に頻繁に更新されますか、それともHPAの背後にありますか?)

したがって、ipvsモードの@lbernailによる使用して、ラボクラスターで2日間実行されています。

これまでのところ、ハングしておらず、ipvsエントリを更新し続けています。

しかし、1つの奇妙な観察:

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.130.24:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.128.28:8443 Masq 1 0 0

lvdkbm501 ~ # ipvsadm -L -n -t 10.158.9.61:443

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.129.28:8443 Masq 1 0 0

ipvsadmを最初に呼び出すと、サービスのポッドの1つを削除する前の初期状態が表示されます。 ポッドが削除されたため、1つのエントリがなくなったことを示す次の例はほとんどありません。 しかし、それがどうあるべきかはわかりませんが、残ったポッドと同じIPアドレスで2番目のエントリを作成しました。 そして、削除されたポッドを置き換えるために登場した新しいポッドの正しいIPに更新されました。

それ以外は大丈夫です。 ただし、ラボクラスターは他のクラスターほどビジーではありません。 @bjornrydenからのコメントにより、お客様に影響を与える可能性のある忙しいクラスターで画像を試してみるのが少し心配になりました。

@emptywee削除されたポッドは10.158.130.24だったと思います。 私はこれを理解していません:

TCP 10.158.9.61:443 rr

-> 10.158.128.28:8443 Masq 1 0 0

-> 10.158.128.28:8443 Masq 1 0 0

同じ実サーバーを2回持つことは意味がありません。 再現できますか?

ポッドの削除時の通常の動作は次のとおりです。

- このポッドに接続されていない場合は、RSを取り外します

- 接続がある場合は、重みを0に設定します(確立された接続は続行され、新しい接続はありません)

- 毎分、重みが0のすべてのRSをチェックし(これがグレースフルターミネーションリストの目的です)、接続がなくなったRSを削除します。

@lbernail正解です。 削除されたポッドにはそのIPアドレスがありました。 そして、はい、それも私には奇妙に見えました。 機会があれば再現してみます。 同じ動作を再現できる場合は、ログの詳細度を上げますか? はいの場合、どのレベルまでですか?

@emptywee :--v=5は私たちにたくさんの情報を与えるはずです

重要なことは、RSがIPVSのVSに2回表示されることすらできないと思います(私はそれを見たことがありません)。 どのカーネルを実行していますか?

@lbernailはそれを--v = 5に設定し、おそらく週末のある時間に再現しようとします。

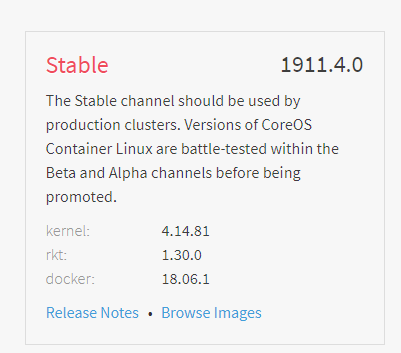

私はCoreOS安定版を使用しています:

4.14はごく最近のことなので、IPVSの問題があったとしたら驚きます

パッチを適用したバージョンでクラスターにストレスをかけて、 @ bjornrydenから問題を再現できるかどうかを確認し

@lbernail残念ながら、一度しか見たことがないipvsエントリの複製動作を再現できませんでした。 さまざまなサービスで複数回試行しました。 ただし、重みが0のエントリは見たことがありませんが、これは、削除したポッドがすぐに終了するという事実によって説明される可能性があります。 また、kube-proxyは、5日以上実行した後に応答しました。 ここでもっと忙しいクラスターの方法でもう一度試してみるかもしれません。

@emptyweeこれは「良い」ニュースです(再現して理解できたとしても、ipvsadmの表示の不具合だったのではないでしょうか?)

重みは、ActiveConnまたはInActiveConnの場合にのみ0に設定されます。 表示するには、関連するポッドを削除する前に、サービスへの長期接続を開くだけです(たとえば、telnetを使用)

5日間の安定は朗報です! 忙しいクラスターを試してみるとどうなるか教えてください

途中でいくつかの小さな改善があります:

- https://github.com/kubernetes/kubernetes/pull/71834:sessionAffinityを使用してサービスで正常な終了を機能させる(すでにマスターで、1.13、1.12、1.11用に作成されたチェリーピック)

- https://github.com/kubernetes/kubernetes/pull/71895およびhttps://github.com/kubernetes/kubernetes/pull/72106 :サービスを削除する際の正常な終了をサポートします(最初はすでにマスターにあります、私は2番目のものがすべてのブランチで両方をチェリーピックするのを待っています)

また、 1.11.6 、 1.12.4 、 1.13.1がリリースされ、削除機能の修正が含まれています

私は週末にこの問題について短い記事を書きました/。 必ず修正版でアップデートしていきます!

@lbernailもちろんです。 ハイパークベのイメージは1.11.6としてリリースされたものと同じですか? kube-proxyのイメージをよりビジーなクラスターにのみインストールし、テストのために再びipvsに切り替えました。 公式のものを使って欲しいですか?

@emptywee私のイメージと1.11.6は基本的に同じです。公式リリースの数日前にリリース-1.11ブランチのヘッドからビルドしたので、違いはせいぜい数回のコミットであり、IPVSは関係ありません。 したがって、クラスターを再度更新する価値はないと思います。

悪いニュース:(kube-proxyがipvsバックエンドの更新に失敗しました。iptablesに戻ってログを収集しています。kube-proxyが--v=5フラグで実行されていました。

@lbernailしたがって、必要なログの量はわかりませんが、基本的に、ipvsバックエンドIPが更新されていないいくつかのサービスで問題が発生しました。 ただし、ログには、エンドポイントが適切に更新されていたことが示されています。

$ cat kube-proxy-issue.log | egrep -e 'c-qa4/ycsdtleuk|10.148.191.69|10.148.192.14|10.148.183.70|10.148.184.67'

I1217 19:12:52.849863 1 graceful_termination.go:160] Trying to delete rs: 10.148.6.202:80/TCP/10.148.192.14:8080

I1217 19:12:52.849948 1 graceful_termination.go:173] Deleting rs: 10.148.6.202:80/TCP/10.148.192.14:8080

I1217 19:12:52.850000 1 graceful_termination.go:160] Trying to delete rs: 10.148.6.202:80/TCP/10.148.191.69:8080

I1217 19:12:52.850069 1 graceful_termination.go:173] Deleting rs: 10.148.6.202:80/TCP/10.148.191.69:8080

I1217 19:12:53.425438 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:13:00.501203 1 ipset.go:140] Successfully delete legacy ip set entry: 10.148.191.69,tcp:8080,10.148.191.69 from ip set: KUBE-LOOP-BACK

I1217 19:13:00.543691 1 ipset.go:140] Successfully delete legacy ip set entry: 10.148.192.14,tcp:8080,10.148.192.14 from ip set: KUBE-LOOP-BACK

I1217 19:13:06.916777 1 service.go:309] Adding new service port "c-qa4/ycsdtleuk:http" at 10.148.6.202:80/TCP

I1217 19:13:08.345142 1 proxier.go:1465] Adding new service "c-qa4/ycsdtleuk:http" 10.148.6.202:80/TCP

I1217 19:13:13.939763 1 ipset.go:148] Successfully add entry: 10.148.191.69,tcp:8080,10.148.191.69 to ip set: KUBE-LOOP-BACK

I1217 19:13:14.002663 1 ipset.go:148] Successfully add entry: 10.148.192.14,tcp:8080,10.148.192.14 to ip set: KUBE-LOOP-BACK

I1217 19:27:53.485483 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:27:53.485526 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:42:53.388638 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:42:53.388673 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:57:53.643829 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 19:57:53.644032 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:12:53.541080 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:12:53.541129 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:27:53.368129 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:27:53.368306 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:42:53.539517 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:42:53.539542 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:57:53.624320 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 20:57:53.624371 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:12:53.630561 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:12:53.630585 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:20.897397 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:20.897463 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:46.630013 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:46.630084 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:57.995544 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.191.69:8080 10.148.192.14:8080]

I1217 21:26:57.995657 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:27:24.296606 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:27:53.678172 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080 10.148.192.14:8080]

I1217 21:28:21.517538 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080]

I1217 21:28:21.595632 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 21:42:53.491595 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 21:57:53.492214 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080]

I1217 22:05:45.760620 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080]

I1217 22:06:24.890429 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080]

I1217 22:07:15.463144 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.68:8080]

I1217 22:07:43.201415 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080]

I1217 22:08:18.268005 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080]

I1217 22:08:58.774066 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:12:53.528515 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:27:53.522197 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:20.396794 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:43.994895 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.192.70:8080]

I1217 22:29:54.382253 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.192.70:8080]

I1217 22:30:17.895084 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.184.67:8080 10.148.192.70:8080]

I1217 22:31:45.791871 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.134.231:8080 10.148.183.70:8080 10.148.184.67:8080]

I1217 22:31:45.855011 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

I1217 22:42:53.652587 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

I1217 22:57:53.509372 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.70:8080 10.148.184.67:8080]

しかし、ipvsadmで確認したところ、最初の2つが表示されていました:10.148.191.69:8080 10.148.192.14:8080

kubectl -n c-qa4 describe svc ycsdtleukは、エンドポイントが10.148.183.70:8080 10.148.184.67:8080であると言っていましたが、他のボックスでは、同じサービスのipvsエントリが適切に更新されていました。

$ kubectl -n c-qa4 describe svc ycsdtleuk

Name: ycsdtleuk

Namespace: c-qa4

Labels: country=uk

env=qa

run=ycsdtleuk

stack=c

track=4

Annotations: run: ycsdtleuk

Selector: load-balancer-ycsdtleuk=true

Type: ClusterIP

IP: 10.148.6.202

Port: http 80/TCP

TargetPort: 8080/TCP

Endpoints: 10.148.183.70:8080,10.148.184.67:8080

Session Affinity: None

Events: <none>

私は基本的に2つのボックスで同時に次のものを見ていました:

(incorrect ipvs config)

rnqkbm401 ~ # ipvsadm -L -t 10.148.6.202:80

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP rnqkbm401:http rr

-> 10.148.191.69:http-alt Masq 1 0 0

-> 10.148.192.14:http-alt Masq 1 0 0

(correct ipvs config)

rnqkbw401 ~ # ipvsadm -L -t 10.148.6.202:80

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP rnqkbw401:http rr

-> 10.148.183.70:http-alt Masq 1 0 0

-> 10.148.184.67:http-alt Masq 1 0 0

問題の兆候を示す明らかなエラーメッセージや叫び声はどこにもありません。 必要に応じて、完全なログファイル(18M非圧縮)を直接送信できます。

簡単に言うと、サービスの変更をリッスンする部分は正常に機能しているように感じますが、ipvsモジュールと対話している部分は機能していません。 最初の2つのIPアドレスを追加した後、それらを削除しようとしていたことすらわかりません。 どこかで何かが動けなくなっています。

@emptywee詳細なレポートありがとうございます。 これらのログには何も奇妙なことはありません。

驚くべきことに、 syncProxyRulesは少なくとも30秒ごとに実行され(デフォルト)、IPVS実サーバーとエンドポイントを調整する必要があります。 syncEndpointsを呼び出し、 AddRealServerとipvsHandle.NewDestinationをトリガーします

これはすべて、古いエンドポイントが削除される前に行われるため、正常な終了の影響を受けないようにする必要があります

21:26と21:29間で何が起こっているかを正確に確認できるように、完全なログを送っていただけませんか。

2つの追加の質問:

- 単一のkubeプロキシが影響を受けましたね。

- 単一のサービスが影響を受けましたか(他のサービスは正常に更新され続けましたか?)

次回は、SIGABRTをプロセスに送信して、タスクの状態を出力してみてください。

問題が発生したときは、常にlibnetwork/ipvs/netlink.go内で何かを実行していたため、何らかの理由でnetlinkシステムコールがスタックしているのではないかと思われました。

不在で申し訳ありませんが、週末になってから、セットアップのためにiptablesに戻すことに集中する必要がありました。

サービス@lbernailに要求されたログを

I1214 11:48:44.889081 1 graceful_termination.go:160] Trying to delete rs: 172.17.0.1:31663/TCP/10.230.213.204:9300

I1214 11:48:44.889099 1 graceful_termination.go:173] Deleting rs: 172.17.0.1:31663/TCP/10.230.213.204:9300

I1214 11:48:44.889113 1 graceful_termination.go:160] Trying to delete rs: 172.17.0.1:31663/TCP/10.230.226.83:9300

I1214 11:48:44.889130 1 graceful_termination.go:173] Deleting rs: 172.17.0.1:31663/TCP/10.230.226.83:9300

...

これらも見ました:

I1214 12:15:44.920364 1 graceful_termination.go:160] Trying to delete rs: 10.230.65.211:9494/TCP/10.230.226.124:9494

I1214 12:15:44.920489 1 graceful_termination.go:173] Deleting rs: 10.230.65.211:9494/TCP/10.230.226.124:9494

I1214 12:15:44.920512 1 graceful_termination.go:93] lw: remote out of the list: 10.230.65.211:9494/TCP/10.230.226.124:9494

他の人が報告したように、これは一部のノードでのみ発生しました。 問題を発見するまでに、この特定のサービスで3つのクラスターノードが壊れていました。

@lbernailもちろんです。 これがリクエストされたログの一部です。スタートアップの部分も含めました: https :

ファイル全体が必要な場合はお知らせください。 はいの場合、送信先またはアップロード先。

あなたの質問に答えるには:

クラスターには60以上のノードがあり、他のいくつかのノードを確認しました。ipvsエントリは正しいものでした。 ただし、すべてのエントリについてはわかりません。 しかし、すべてのトラフィックをサービスにルーティングするマスターノードでは、少なくとも2つのサービスが適切に更新されていませんでした。 それ以上の可能性もありますが、お客様から苦情が寄せられると、すぐに2つのサービスにアクセスできないとのことでした。 ログを収集し、影響を最小限に抑えるためにkube-proxyを再起動しました。 トラブルシューティングの一環として、そのマスターノードとワーカーノードの1つでipvsエントリの状態を比較し、それが異なることに気付きました。 他のノードのエントリが正しく更新されていない可能性がありますが、トラフィックがそれらを経由しないため、影響はありませんでした。

いいえ、少なくとも2つのサービスが影響を受けました。 おそらくもっと多いかもしれませんが、私はそれをチェックしませんでした。

ログからの2つの興味深いこと:

I1217 21:26:57.995657 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.191.69:8080 10.148.192.14:8080]はIPVSによって処理されることはありませんが、2つの古いRSを保持しているため、エラーは発生しません(RSを追加してもログは生成されません)。I1217 21:28:21.517538 1 endpoints.go:234] Setting endpoints for "c-qa4/ycsdtleuk:http" to [10.148.183.68:8080 10.148.187.41:8080 10.148.191.69:8080]は、10.148.192.14:8080の削除呼び出しをトリガーしません(ログがそこにあるはずです)

@emptyweeは、正常に終了する前にIPVSが機能していましたか、それともiptablesを使用していましたか?

@ m1093782566 / @ Lion-Weiは、ここで何が起こっているのか考えていますか?

@lbernail 1.11にアップグレードしてipvsに切り替えるまで待って(この機能のGAリリースが行われたのはこのときだと思います)、1.11.5に直接アップグレードし、ipvsの使用を開始するのはこれが初めてでした。

@emptywee :問題を特定するために、情報レベルのログをさらに追加します。 より詳細なバージョンを数時間実行しても大丈夫ですか? (あなたが望まないかどうかは完全に理解していますが、私はまだ私の側で再現することができませんでした)

5月からIPVSを使用しており、1.12.1と1.11.1では問題はありませんでした。

1.12.3にアップグレードした後、これがいくつかのノードで発生することもわかりましたが、すべてのノードではありません。 影響を受けたノードは、アップグレードの数時間後にIPVSの更新を停止しましたが、私が識別できる調整された方法ではありませんでした。

注意すべき点の1つは、kube-proxyもその時点で完全にロギングを停止したため、完全にスタックしたように見えることです。

@matthiasrのログファイルには、netlinkソケットからの読み取りがスタックしていることが再び示されています。 私と同じ。

ネットリンクソケットとの相互作用が多すぎる原因となる論理エラーがあると主張することができます。 ただし、netlinkとの通信が安定していない場合、ipvsは最終的にスタックします。 論理エラーが修正された場合、この状態に達するまでにかなり時間がかかる可能性がありますが、十分な時間が与えられた場合に発生しないという意味ではありません。

そのため、ネットリンクの相互作用に何らかのタイムアウトを設定することをお勧めします。 操作がタイムアウトした場合は、回復メカニズムとして、ネットリンクソケットを閉じ、新しいソケットを自動的に開きます。

@matthiasr OK、それは

どこかにデッドロックがあるようです

@lbernailは、クラスター全体をipvsに切り替えるのは少し面倒ですが、これがこの問題の解決に役立つ場合は、私はダウンしています。 使用する画像名を教えてください。これを支援するために全力を尽くします。

1.11.6でIPVSに戻り、問題を再現できるかどうかを確認しました。 ロギングを5に設定し、クラスター内で次の日にいくつかのアクティビティを実行します。 明日は仕事をしませんが、オンラインでポップして、ログを増やした画像に変更する必要があるかどうかを確認します。

@matthiasr : 1.12.3間違いなく問題があります(このスレッドの残りの部分を参照してください)。 その一部は1.12.4解決されます。 ログのエラーが大幅に少なくなります。 これらはすべて消えるはずです: Failed to add destination: 10.zz.yy.xx, error: file exists

kube-proxyがハングしているように見え、実サーバーが更新されなくなるという問題がまだあります。

私はそれをもう少し調べました:

- @emptyweeから、問題が発生した後、proxier.go、ipset.go、またはgraceful_termination.goのいずれからもログが表示されないようです。これは、どこかでスタックしていることを示しているようです。 @emptywee 21:30以降にこれらのファイルのログがあるかどうかを確認できますか?

- goルーチンダンプでは、netlinkソケットで受信する2つのsyscallがあります。 そのため、そこで問題が発生する可能性があります。 さらに、正常な終了をサポートするために、libnetwork / ipvsがアップグレードされたため、動作が変更された可能性があります。 ただし、libnetworkコードはnetlinkソケットにsend / rcvタイムアウトを設定しているようです(スタックしている場合は、経過した分数が表示されます): https :

興味深いことに、libnetworkの新しいバージョンのみにnetlinkタイムアウトがあります。

libnetworkは、すべてのリリースブランチ(1.11、1.12、および1.13)でアップグレードされ、正常に終了できるようになりました。 ba46b928444931e6865d8618dc03622cac79aa6fからa9cd636e37898226332c439363e2ed0ea185ae92

古いバージョンでは、コードは次のとおりでした: https :

これら2つのコミット間のlibnetworkのIPVSコードの唯一の違いは次のとおりです。

- タイムアウトの導入

ActiveConnectionsとInactiveConnectionsをDestination追加(これは正常な終了に必要でした)

これは関係があるのではないかと思います。

この問題についてもう少し考えてみると、同じネットリンクソケットを使用する2つのゴルーチンがあるという事実から来ていると思います(gracefulTerminationManagerは独自のゴルーチンで実行され、utilipvs.Interfaceをプロキシーと共有するため)。

pkg/util/ipvs/ipvs_linux.goすべての呼び出しにミューテックスを追加して、単一のゴルーチンが常にnetlinkソケットを使用していることを確認できます。

@ m1093782566どう思いますか?

@lbernailいいえ、21:30以降はこれらのファイルからのエントリはありません。

さまざまなファイルの最後のエントリは次のとおりです。

graceful_termination.goからの最後のエントリ

$ cat kube-proxy-issue.log | grep 'graceful_termination.go' | tail

I1217 21:18:20.757262 1 graceful_termination.go:66] Adding rs 10.148.11.105:8080/TCP/10.148.174.35:8081 to graceful delete rsList

I1217 21:18:52.267340 1 graceful_termination.go:160] Trying to delete rs: 10.148.0.145:80/TCP/10.148.188.28:8080

I1217 21:18:52.267456 1 graceful_termination.go:173] Deleting rs: 10.148.0.145:80/TCP/10.148.188.28:8080

I1217 21:18:52.267638 1 graceful_termination.go:160] Trying to delete rs: 10.148.0.145:80/TCP/10.148.145.194:8080

I1217 21:18:52.267755 1 graceful_termination.go:173] Deleting rs: 10.148.0.145:80/TCP/10.148.145.194:8080

I1217 21:18:52.405770 1 graceful_termination.go:160] Trying to delete rs: 10.148.0.145:80/TCP/10.148.188.28:8081

I1217 21:18:52.405906 1 graceful_termination.go:173] Deleting rs: 10.148.0.145:80/TCP/10.148.188.28:8081

I1217 21:18:52.406052 1 graceful_termination.go:160] Trying to delete rs: 10.148.0.145:80/TCP/10.148.145.194:8081

I1217 21:18:52.406156 1 graceful_termination.go:173] Deleting rs: 10.148.0.145:80/TCP/10.148.145.194:8081

I1217 21:18:53.240664 1 graceful_termination.go:160] Trying to delete rs: 10.148.11.105:8080/TCP/10.148.174.35:8081

proxier.goからの最後のエントリ:

$ cat kube-proxy-issue.log | grep 'proxier.go' | tail

I1217 21:18:52.570282 1 proxier.go:1023] Port "nodePort for kube-system/kube-dns:dns-tcp" (:30054/tcp) was open before and is still needed

I1217 21:18:52.663609 1 proxier.go:1023] Port "nodePort for ingress-nginx/ingress-nginx:http" (:31513/tcp) was open before and is still needed

I1217 21:18:53.241144 1 proxier.go:1465] Adding new service "c-qa4/yardchange-ws:http" 10.148.1.136:80/TCP

E1217 21:18:53.241277 1 proxier.go:1467] Failed to add IPVS service "c-qa4/yardchange-ws:http": file exists

E1217 21:18:53.241350 1 proxier.go:821] Failed to sync service: 10.148.1.136:80/TCP, err: file exists

I1217 21:18:53.241624 1 proxier.go:1465] Adding new service "c-qa4/receiving-ws-v2-uk:http-admin" 10.148.13.141:8080/TCP

E1217 21:18:53.241723 1 proxier.go:1467] Failed to add IPVS service "c-qa4/receiving-ws-v2-uk:http-admin": file exists

E1217 21:18:53.241761 1 proxier.go:821] Failed to sync service: 10.148.13.141:8080/TCP, err: file exists

E1217 21:18:53.242506 1 proxier.go:1496] Failed to get IPVS service, error: Expected only one service obtained=0

E1217 21:18:53.242558 1 proxier.go:818] Failed to sync endpoint for service: 10.148.11.84:8080/TCP, err: Expected only one service obtained=0

ipset.goからの最後のエントリ:

$ cat kube-proxy-issue.log | grep 'ipset.go' | tail

I1217 21:17:14.768694 1 ipset.go:148] Successfully add entry: 10.148.134.229,tcp:8080,10.148.134.229 to ip set: KUBE-LOOP-BACK

I1217 21:17:14.774040 1 ipset.go:148] Successfully add entry: 10.148.134.229,tcp:8081,10.148.134.229 to ip set: KUBE-LOOP-BACK

I1217 21:17:26.643709 1 ipset.go:148] Successfully add entry: 10.148.172.59,tcp:8080,10.148.172.59 to ip set: KUBE-LOOP-BACK

I1217 21:17:26.648504 1 ipset.go:148] Successfully add entry: 10.148.172.59,tcp:8081,10.148.172.59 to ip set: KUBE-LOOP-BACK

I1217 21:17:31.049667 1 ipset.go:148] Successfully add entry: 10.148.136.14,tcp:8080,10.148.136.14 to ip set: KUBE-LOOP-BACK

I1217 21:17:31.053901 1 ipset.go:148] Successfully add entry: 10.148.136.14,tcp:8081,10.148.136.14 to ip set: KUBE-LOOP-BACK

I1217 21:18:18.920550 1 ipset.go:140] Successfully delete legacy ip set entry: 10.148.181.11,tcp:8080,10.148.181.11 from ip set: KUBE-LOOP-BACK

I1217 21:18:18.924752 1 ipset.go:140] Successfully delete legacy ip set entry: 10.148.181.11,tcp:8081,10.148.181.11 from ip set: KUBE-LOOP-BACK