Tensorflow: Actualice a CuDNN 7 y CUDA 9

Información del sistema

- ¿He escrito código personalizado (en lugar de usar un script de ejemplo de stock provisto en TensorFlow) : No

- Plataforma y distribución del sistema operativo (por ejemplo, Linux Ubuntu 16.04) : Windows Server 2012

- TensorFlow instalado desde (fuente o binario) : binario

- Versión de TensorFlow (use el comando a continuación) : 1.3.0-rc1

- Versión de Python : 3.5.2

- Versión de Bazel (si se compila desde la fuente) : N / A

- Versión CUDA / cuDNN : CUDA V8.0.44, CuDNN 6.0

- Modelo de GPU y memoria : Nvidia GeForce GTX 1080 Ti, 11 GB

- Comando exacto para reproducir : N / A

Describe el problema

Actualice TensorFlow para que sea compatible con CUDA 9 y CuDNN 7. Nvidia afirma que esto proporcionará un aumento de rendimiento del doble en las GPU Pascal.

Todos 170 comentarios

@tfboyd , ¿tienes algún comentario sobre esto?

cuDNN 7 todavía está en modo de vista previa y se está trabajando en ello. Acabamos de pasar a cuDNN 6.0 con 1.3, que debería ser definitivo en un par de semanas. Puede descargar cuDNN 1.3.0rc2 si está interesado en eso. Todavía no he compilado con cuDNN 7 o CUDA 9. He oído que CUDA 9 no es fácil de instalar en todas las plataformas y solo están disponibles algunos paquetes de instalación seleccionados. Cuando las bibliotecas estén definitivas comenzaremos la evaluación final. NVIDIA también acaba de comenzar a enviar parches a las principales plataformas ML para admitir aspectos de estas nuevas bibliotecas y sospecho que habrá trabajo adicional.

Editar: Quise decir que CUDA 9 no es fácil de instalar en todas las plataformas y en su lugar dije cuDNN. También cambié la seguridad de que habrá trabajo y sospecho que habrá trabajo adicional. El resto de mi declaración tonta lo dejé, por ejemplo, no me di cuenta de que cuDNN 7 salió a la luz ayer.

Sin decir cómo debería leer el sitio web. Pero el 2x más rápido en pascal parece ser parte del lanzamiento de CUDA 8. Supongo que depende de cómo leas el sitio. NVIDIA no nos ha mencionado que CUDA 9 acelerará Pascal en 2x (en todo) y aunque todo es posible, no esperaría que eso suceda.

https://developer.nvidia.com/cuda-toolkit/whatsnew

El sitio es un poco confuso, pero creo que la sección que está citando está anidada bajo CUDA 8. Solo menciono esto para que no tenga expectativas poco realistas para su lanzamiento. Para Volta debería haber grandes ganancias a partir de lo que entiendo y creo que (ahora no estoy seguro) la gente solo está obteniendo muestras de ingeniería de Volta para comenzar un trabajo de alto nivel y prepararse para el lanzamiento completo.

@tfboyd cuDNN 7 ya no está en modo de vista previa a partir de ayer. Ha sido lanzado oficialmente tanto para CUDA 8.0 como para CUDA 9.0 RC.

Ahh me perdí eso. Gracias @sclarkson y perdón por la información incorrecta.

Ciertamente lo intentaré porque finalmente gcc 6 es compatible con CUDA 9 y Ubuntu 17.04 viene con él.

Si tienes suerte, avísale al hilo. Personalmente estoy empezando a

prueba completa cuDNN 6 (Internamente se ha probado mucho pero no he sido

usándolo personalmente). A menudo tardo en actualizar a las últimas novedades. Mi

Supongo que es posible que no vea ningún cambio real con cuDNN 7 hasta que todo se ponga

parcheado para utilizar las últimas API. Quiero enfatizar de nuevo que me equivoco todo

del tiempo. Lo que he visto como un forastero es que las nuevas versiones de cuDNN agregan

nuevos métodos / API. Algunos son interesantes y otros no lo son de inmediato.

útil. Luego, esas API se exponen a través de la API de TensorFlow o simplemente se usan

detrás de escena para hacer que los métodos existentes sean más rápidos. Mi muy alto nivel

la comprensión es cuDNN 7 + CUDA 9 mejorará el soporte FP16 con un enfoque en

Volta. Creo que uno de los principales enfoques es cómo obtener modelos (muchos no solo

algunos) para converger con FP16 sin tener que adivinar interminablemente el

config / hiperparámetros a utilizar. Quiero enfatizar que así es como yo

Entendí la conversación y puedo estar equivocado o medio correcto.

ESTRÉS: Si hay métodos que cree que deben agregarse (o apalancamiento para

rendimiento) a TensorFlow de cuDNN siempre estamos interesados en una lista.

Internamente, esto sucedió con cuDNN 6 y nos enfocamos en implementar el

Los equipos de características dijeron que querían que les ayudara en sus proyectos.

El sábado 5 de agosto de 2017 a las 8:46 a.m., Courtial Florian [email protected]

escribió:

Sin duda lo intentaré porque finalmente gcc 6 es compatible con CUDA 9 y

Ubuntu 17.04 viene con él.-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320450756 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZessKqj_nPY1br9SD9L9SX-8Kf5Dbtks5sVI5TgaJpZM4OuRL7

.

Hablando de métodos que se agregarán, la convolución grupal de cudnn7 sería una característica importante para la comunidad de visión.

Genial, lo agregaré a la lista que estoy comenzando. Puedo olvidar pero me siento libre

para recordarme que publique algún tipo de lista en la que pueda proporcionar alguna orientación

en lo que probablemente se esté trabajando. No puede ser una promesa pero queremos

retroalimentación para que podamos priorizar lo que la gente quiere y necesita. Gracias Yuxin.

El sábado 5 de agosto de 2017 a las 12:26 p.m., Yuxin Wu [email protected] escribió:

Hablando de métodos que se agregarán, la convolución de grupo de cudnn7 sería una

característica importante para la comunidad de la visión.-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

.

Intenté compilar con cuDNN 7 con CUDA 8 y fallé, lo que me parece

de lo esperado. Hay un parche entrante de NVIDIA que debería ayudar a la línea

cosas claras. Solo un aviso si alguien lo está intentando.

El sábado 5 de agosto de 2017 a las 1:47 p.m., Toby Boyd [email protected] escribió:

Genial, lo agregaré a la lista que estoy comenzando. Puedo olvidar pero me siento libre

para recordarme que publique algún tipo de lista en la que pueda proporcionar alguna orientación

en lo que probablemente se esté trabajando. No puede ser una promesa pero queremos

retroalimentación para que podamos priorizar lo que la gente quiere y necesita. Gracias Yuxin.El sábado 5 de agosto de 2017 a las 12:26 p. M., Yuxin Wu [email protected]

escribió:Hablando de métodos que se agregarán, la convolución de grupo de cudnn7 sería una

característica importante para la comunidad de la visión.-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

.

Estoy tratando de obtener cuDNN 7 con CUDA 8/9 ejecutándose. CUDA 8 no es compatible con GTX 1080 Ti, al menos el instalador lo dice ^^

Me está costando mucho hacer que funcione. Quiero señalar este gran artículo que resume lo que ya he probado: https://nitishmutha.github.io/tensorflow/2017/01/22/TensorFlow-with-gpu-for-windows.html

Los ejemplos de CUDA funcionan a través de Visual-Studio en ambas combinaciones de configuración.

Aquí la salida del deviceQuery.exe que se compiló usando Visual-Studio:

PS C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release> deviceQuery.exe

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release\deviceQuery.exe Starting...

CUDA Device Query (Runtime API) version (CUDART static linking)

Detected 1 CUDA Capable device(s)

Device 0: "GeForce GTX 1080 Ti"

CUDA Driver Version / Runtime Version 9.0 / 9.0

CUDA Capability Major/Minor version number: 6.1

Total amount of global memory: 11264 MBytes (11811160064 bytes)

(28) Multiprocessors, (128) CUDA Cores/MP: 3584 CUDA Cores

GPU Max Clock rate: 1683 MHz (1.68 GHz)

Memory Clock rate: 5505 Mhz

Memory Bus Width: 352-bit

L2 Cache Size: 2883584 bytes

Maximum Texture Dimension Size (x,y,z) 1D=(131072), 2D=(131072, 65536), 3D=(16384, 16384, 16384)

Maximum Layered 1D Texture Size, (num) layers 1D=(32768), 2048 layers

Maximum Layered 2D Texture Size, (num) layers 2D=(32768, 32768), 2048 layers

Total amount of constant memory: 65536 bytes

Total amount of shared memory per block: 49152 bytes

Total number of registers available per block: 65536

Warp size: 32

Maximum number of threads per multiprocessor: 2048

Maximum number of threads per block: 1024

Max dimension size of a thread block (x,y,z): (1024, 1024, 64)

Max dimension size of a grid size (x,y,z): (2147483647, 65535, 65535)

Maximum memory pitch: 2147483647 bytes

Texture alignment: 512 bytes

Concurrent copy and kernel execution: Yes with 2 copy engine(s)

Run time limit on kernels: Yes

Integrated GPU sharing Host Memory: No

Support host page-locked memory mapping: Yes

Alignment requirement for Surfaces: Yes

Device has ECC support: Disabled

CUDA Device Driver Mode (TCC or WDDM): WDDM (Windows Display Driver Model)

Device supports Unified Addressing (UVA): Yes

Supports Cooperative Kernel Launch: No

Supports MultiDevice Co-op Kernel Launch: No

Device PCI Domain ID / Bus ID / location ID: 0 / 1 / 0

Compute Mode:

< Default (multiple host threads can use ::cudaSetDevice() with device simultaneously) >

deviceQuery, CUDA Driver = CUDART, CUDA Driver Version = 9.0, CUDA Runtime Version = 9.0, NumDevs = 1, Device0 = GeForce GTX 1080 Ti

Result = PASS

@tfboyd , ¿tienes algún enlace que confirme la actualización de cuDNN de Nvidea?

@ 4F2E4A2E 1080 Ti definitivamente es compatible con CUDA 8.0. Eso es lo que he estado usando con TensorFlow durante los últimos meses.

Hola a todos, tengo gtx 1080 ti con cuda 8.0. Estoy intentando instalar tensorflow-gpu, ¿elijo cuDNN 5.1, 6.0 o 7.0?

Sugiero que te quedes con 5.1 por el momento. Estoy ejecutando un rendimiento más profundo

pruebas en 6 y obteniendo resultados mixtos que necesitan más pruebas para averiguarlo.

El 6 de agosto de 2017 a las 9:30 p.m., "colmantse" [email protected] escribió:

Hola a todos, tengo gtx 1080 ti con cuda 8.0. Estoy intentando instalar

tensorflow-gpu, ¿elijo cuDNN 5.1, 6.0 o 7.0?-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320566071 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZeshvEFsdeWz-1uyzl_L6HE15E0BzSks5sVpLlgaJpZM4OuRL7

.

gracias, probé con cudnn 6.0 pero no funciona, supongo que debido a mi instalación ficticia de tf-gpu. cudnn 5.1 me funciona con python 3.6

@tpankaj ¡ Gracias! Lo tengo funcionando con CUDA 8 y cuDNN 5.1

Aquí está el conjunto completo de características en cuDNN 7:

Funciones y mejoras clave

Esta versión de cuDNN incluye las siguientes características y mejoras clave.

Núcleos de tensor

La versión 7.0.1 de cuDNN es la primera en admitir las operaciones de Tensor Core en su

implementación. Los núcleos tensores proporcionan una multiplicación de matrices altamente optimizada

bloques de construcción que no tienen un comportamiento numérico equivalente en el tradicional

instrucciones, por lo tanto, su comportamiento numérico es ligeramente diferente.

cudnnSetConvolutionMathType, cudnnSetRNNMatrixMathType y

cudnnMathType_t

El cudnnSetConvolutionMathType y cudnnSetRNNMatrixMathType

Las funciones le permiten elegir si usar o no las operaciones de Tensor Core en

las capas de convolución y RNN respectivamente configurando el modo matemático en

CUDNN_TENSOR_OP_MATH o CUDNN_DEFAULT_MATH.

Las operaciones de Tensor Core realizan una acumulación de punto flotante paralelo de múltiples

productos de punto flotante.

Establecer el modo matemático en CUDNN_TENSOR_OP_MATH indica que la biblioteca utilizará

Operaciones de Tensor Core.

El valor predeterminado es CUDNN_DEFAULT_MATH. Este valor predeterminado indica que el Tensor Core

La biblioteca evitará operaciones. El modo predeterminado es una operación serializada

mientras que Tensor Core es una operación paralelizada, por lo tanto, los dos pueden resultar

en resultados numéricos ligeramente diferentes debido a la diferente secuencia de operaciones.

La biblioteca vuelve al modo matemático predeterminado cuando las operaciones de Tensor Core son

no admitido o no permitido.

cudnnSetConvolutionGroupCount

Una nueva interfaz que permite a las aplicaciones realizar grupos de convolución en el

capas de convolución en una sola llamada a la API.

cudnnCTCLoss

cudnnCTCLoss proporciona una implementación de GPU del Connectionist Temporal

Función de pérdida de clasificación (CTC) para RNN. La función de pérdida de CTC se utiliza para

reconocimiento de fonemas en el reconocimiento de voz y escritura a mano.

CUDNN_BATCHNORM_SPATIAL_PERSISTENT

La función CUDNN_BATCHNORM_SPATIAL_PERSISTENT es un nuevo lote

modo de normalización para cudnnBatchNormalizationForwardTraining

y cudnnBatchNormalizationBackward. Este modo es similar a

CUDNN_BATCHNORM_SPATIAL, sin embargo, puede ser más rápido para algunas tareas.

cudnnQueryRuntimeError

La función cudnnQueryRuntimeError reporta códigos de error escritos por GPU

kernels al ejecutar cudnnBatchNormalizationForwardTraining

y cudnnBatchNormalizationAtrás con el

Modo CUDNN_BATCHNORM_SPATIAL_PERSISTENT.

cudnnGetConvolutionForwardAlgorithm_v7

Esta nueva API devuelve todos los algoritmos ordenados por rendimiento esperado

(usando heurística interna). Estos algoritmos se generan de manera similar a

cudnnFindConvolutionForwardAlgorithm.

cudnnGetConvolutionBackwardDataAlgorithm_v7

Esta nueva API devuelve todos los algoritmos ordenados por rendimiento esperado

(usando heurística interna). Estos algoritmos se generan de manera similar a

cudnnFindConvolutionBackwardAlgorithm.

cudnnGetConvolutionBackwardFilterAlgorithm_v7

Esta nueva API devuelve todos los algoritmos ordenados por rendimiento esperado

(usando heurística interna). Estos algoritmos se generan de manera similar a

cudnnFindConvolutionBackwardFilterAlgorithm.

CUDNN_REDUCE_TENSOR_MUL_NO_ZEROS

La función MUL_NO_ZEROS es una reducción de multiplicación que ignora los ceros en el

datos.

CUDNN_OP_TENSOR_NOT

La función OP_TENSOR_NOT es una operación unaria que toma el negativo de

(alfa * A).

cudnnGetDropoutDescriptor

La función cudnnGetDropoutDescriptor permite que las aplicaciones abandonen

valores.

Muy bien, estoy pensando en iniciar un nuevo número que sea más un "blog" de CUDA 9 RC + cuDNN 7.0. Tengo una compilación TF "en mi mano" que está parcheada pero es CUDA 9RC y cuDNN 7.0 y quiero ver si alguien está interesado en probarlo. También necesito asegurarme de que no haya alguna razón extraña por la que no pueda compartirlo. Hay cambios que deben realizarse en algunas bibliotecas ascendentes que usa TensorFlow, pero comenzará a ver los PR provenientes de NVIDIA en un futuro cercano. El equipo y yo pudimos probar CUDA 8 + cuDNN 6 en Volta y luego CUDA 9RC + cuDNN 7 en Volta (V100) con código FP32. Solo hago compilaciones de Linux y Python 2.7, pero si todos / alguno de ustedes están interesados, me gustaría intentar involucrar a la comunidad más de lo que lo hicimos con cuDNN 6.0. Puede que no sea muy divertido, pero quiero ofrecer y tratar de hacer que esto se sienta más como si estuviéramos juntos en esto en lugar de recibir información. También quiero crear listas de las funciones en las que estamos trabajando pero que no prometemos para cuDNN 7 (y 6.0). @ cancan101 gracias por la lista completa.

@tfboyd : Agradecería las descripciones sobre cómo hacer CUDA 9.0RC + cuDNN 7.0. Yo mismo estoy usando un sistema extraño (ubuntu 17.10 beta con TF1.3, CUDA 8.0 y cuDNN 6.0 gcc-4.8), y actualizar a cuda 9 y cudnn 7 en realidad sería bueno para el compilador.

Veré qué puedo hacer para obtener lo que necesita para construirse usted mismo y un

binario. El líder del equipo de desempeño indicó que puedo intentar que esto suceda

para que podamos ser más transparentes y espero divertirnos más como comunidad.

Conseguir el parche y cómo construirlo no es muy difícil, pero es un poco

más difícil. También será muy informal ya que no tengo tiempo para gestionar un

rama y el parche podría pudrirse (no aplicar limpiamente) muy rápidamente. los

Se usó el parche para asegurarse de que todos los involucrados estuvieran de acuerdo con los cambios en

general y espero que comiencen a llegar RP individuales.

El viernes 11 de agosto de 2017 a las 5:22 a.m., Erlend Aune [email protected]

escribió:

@tfboyd https://github.com/tfboyd : agradecería las descripciones

al hacer CUDA 9.0RC + cuDNN 7.0. Yo mismo estoy usando un sistema extraño (ubuntu

17.10 beta con TF1.3, CUDA 8.0 y cuDNN 6.0 gcc-4.8) y actualización a

cuda 9 y cudnn 7 serían realmente agradables en el compilador.-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321798364 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesj4WRkFKNX-Nt2oKtvp0oyQVBtM5ks5sXEdqgaJpZM4OuRL7

.

@tfboyd : Estoy interesado, ¿cómo lo compartirás? ¿Una rama?

@tfboyd Definitivamente también estaría muy interesado. ¡Gracias!

Tratando de resolverlo esta semana. La logística es a menudo más difícil que yo

pensar.

El 12 de agosto de 2017 a las 10:18 a. M., "Tanmay Bakshi" [email protected] escribió:

@tfboyd https://github.com/tfboyd Definitivamente estaría muy interesado porque

bien. ¡Gracias!-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321994065 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesjO42Rl1WCyW0KR22KgbydKh1O4Zks5sXd6AgaJpZM4OuRL7

.

Instrucciones y un binario para jugar si te gusta Python 2.7. Voy a cerrar esto porque actualizaré el problema que creo para rastrear el esfuerzo. @ tanmayb123 @Froskekongen

Intenté instalar tensorflow-gpu-1.3.0 precompilado para Python 3.6 en Windows x64 y proporcioné la versión 7.0 de la biblioteca cuDNN con Cuda 8.0 y al menos para mí, todo parece funcionar. No veo ninguna excepción o problema.

¿Es esto de esperarse? ¿CuDNN 7.0 es compatible con versiones anteriores de cuDNN 6.0? ¿Puede esto dar lugar a problemas?

@apacha Estoy un poco sorprendido de que haya funcionado. He visto el error antes en mis pruebas donde el binario de TensorFlow no puede encontrar cuDNN porque lo busca por nombre y los archivos * .so incluyen 6.0 / 7.0 en los nombres. De forma remota, es posible que tenga cuDNN 6 todavía en su camino. No me gusta hacer conjeturas sobre su configuración, pero si estuviera haciendo una apuesta, diría que todavía está usando cuDNN 6.

En lo que respecta a la compatibilidad con versiones anteriores, menos TensorFlow se compila para buscar una versión específica. Yo no sé.

Finalmente, no es gran cosa. Los PR de cuDNN 7 están casi aprobados / fusionados y el binario precompilado probablemente se moverá a cuDNN 7 a partir de la 1.5.

ACTUALIZACIÓN sobre el progreso de CUDA 9RC y cuDNN 7

- Las relaciones públicas de NVIDIA están casi aprobadas

- EIGEN cambio ha sido aprobado y combinado

- Las pruebas FP16 han comenzado en serio en V100 (Volta)

@tfboyd solo para completar: estaba usando cuDNN 5 anteriormente y como tuve que actualizar para tensorflow 1.3, estaba esperando a la versión 7 de cuDNN para darle una oportunidad. He eliminado explícitamente cudnn64_5.dll y no hay cudnn64_6.dll en mi ruta de instalación de CUDA. Quizás sea la magia de Windows. :-PAG

Aunque observe una cosa: todavía estoy usando CUDA 8.0, no 9.0.

@apacha Podría ser la magia de Windows. No quería sonar crítico porque no tenía ni idea. Creo que la magia de Windows es posible ya que las llamadas cuDNN no deberían haber cambiado y, por lo tanto, parece probable que sean compatibles con versiones anteriores. Para las compilaciones de Linux, TensorFlow está buscando archivos específicos (o así es como se ve cuando obtengo errores) y no está contento si no encuentra cudnnblahblah.6.so. Gracias por la actualización y los detalles.

¿Hay alguna rama / etiqueta que podamos verificar y probar?

Comenzó una nueva instalación, Ubuntu 17 ... luego nuevo gcc impongo CUDA 9, veo que CuDNN con quien encaja es 7 ... ya ves hacia donde me dirijo.

Seguro que puedo hackear mi configuración en muchos lugares (y empezar de cero de nuevo con Ubuntu 16) solo que estoy tan cerca, se dice que la solución está cerca ... ¿por qué dar un gran salto en el pasado si puedo hacer ¡un pequeño salto en el futuro!

Los RP están casi aprobados. Están en revisión. Sospecho un par mas

semanas como máximo, pero estas revisiones pueden llevar tiempo. Creo que estos son todos

ellos. Podría haber un rezagado o un cambio para obtener el cambio EIGEN para

CUDA 9. No los he preparado personalmente. Se acercan cada día más.

https://github.com/tensorflow/tensorflow/pull/12504

https://github.com/tensorflow/tensorflow/pull/12503

https://github.com/tensorflow/tensorflow/pull/12502

El martes 12 de septiembre de 2017 a las 7:49 p.m., Remi Morin [email protected]

escribió:

¿Hay alguna rama / etiqueta que podamos verificar y probar?

Comenzó una nueva instalación, Ubuntu 17 ... luego el nuevo gcc impondrá CUDA 9,

Veo que CuDNN con quien encaja tiene 7 ... ya ves hacia dónde me dirijo.

Seguro que puedo piratear mi configuración en muchos lugares (y empezar desde cero

de nuevo con Ubuntu 16) solo que estoy tan cerca, se dice que la solución está cerca ...

¡Dar un gran salto en el pasado si puedo dar un pequeño salto en el futuro!-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-329041739 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesrpX6TSN6fVESEsql3QNtjgo-LM9ks5sh0KqgaJpZM4OuRL7

.

@tfboyd ¿

cuda 9.0 ha sido lanzado, no puedo encontrar el archivo de instalación de cuda 8.0 ...

por favor actualice tensorflow ...

cuda 9.0 ha sido lanzado, no puedo encontrar el archivo de instalación de cuda 8.0 ...

@thomasjo gracias!

Entonces, siguiendo a @tfboyd aprobando los PR que mencionó, ¿tensorflow 1.3 ahora será compatible con CUDA 9 y cuDNN 7? ¿Alguien en algún lugar ha instalado esto con éxito?

@voxmenthe Acabo de intentar instalar tf1.3 con CUDA 9.0 y cuDNN7. Recibí el error relacionado con este problema # 12489

EDITAR: Básicamente, no sé cómo. Pero al pasar a la rama maestra (que al principio no se estaba instalando para mí) sin más cambios, pude instalarla. Aunque, ahora, cuando intento importar tensorflow, dice que le falta el módulo de plataforma.

¿Alguna indicación de qué tan cerca están de entrar los RP asociados? Instalé cuDNN 7 y luego me di cuenta de que estaba causando problemas; puedo cambiar a v6, pero pensé que podría esperar si está cerca de resolverse ...

Los RP parecen estar aprobados. No he ejecutado la compilación yo mismo en unos días. Tenga en cuenta que 1.3 no tendría estos cambios, ya que fue hace un tiempo. 1.4 tendría los cambios. Espero que esta semana pueda descargar las últimas versiones y hacer una nueva compilación. Sospecho que alguien lo hará bien antes de que yo tenga tiempo.

¿Alguna posibilidad de que alguno de ustedes, gente inteligente, esté haciendo un tutorial para tf 1.3 o 1.4 con CUDA v9.0, cudnn 7.0 para Win 10 x64? Intenté instalar (Anaconda) pero sigo recibiendo el error '_pywrap_tensorflow_internal' y ya he comprobado que msvcp140.dll se ha agregado a mi ruta.

@ devilsnare007 : Creo que las mejores posibilidades son siguiendo https://github.com/philferriere/dlwin. Simplemente reemplace las versiones enumeradas con las versiones actuales. Tenga en cuenta que TF 1.4 ni siquiera se ha lanzado. Pero TF 1.3 debería funcionar bien con las instrucciones proporcionadas. Una vez que todo se haya actualizado y se haya lanzado TF 1.4, actualizaremos ese tutorial.

¿Se admitirá cuDNN 7.0 cuando se lance TF 1.4?

@soloice

Al principio (hace un par de días) pude compilar CUDA 9 (versión de lanzamiento) con cuDNN 7.0 sin cambios especiales y ejecuté algunas pruebas tf_cnn_benchmarks.py en una GTX 1080. Todo se ve bien. TF 1.4, que debería ser RC esta semana, tendrá los binarios CUDA 8 y cuDNN 6, pero también se compilará bien con CUDA 9 y cuDNN 7. El objetivo es que TF 1.5 tenga CUDA 9 y cuDNN 7 en el binario. Esto les da a las personas tiempo para actualizar sus bibliotecas de sistemas y más tiempo para realizar pruebas. Si está ejecutando Voltas, no dude en iniciar otro hilo y lo actualizaré y progresará en FP16 en tiempo real.

@tfboyd ¡Es genial escuchar que TF 1.4 se compila con cuDNN 7! Si en algún momento tiene ganas de crear una guía de instalación, sería un gran servicio público para la comunidad de DL.

No hay problema, eso debería ser bastante fácil y estoy feliz de intentar llenar ese

brecha.

El lunes 9 de octubre de 2017 a las 9:42 a.m., Jeff [email protected] escribió:

@tfboyd https://github.com/tfboyd Es genial escuchar que TF 1.4 se compila

con cuDNN 7! Si en algún momento te apetece crear una guía de instalación,

sería un gran servicio público para la comunidad de DL.-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335212652 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesp7d2aT8gsGOWb6YjHH_CnpKXUIPks5sqkztgaJpZM4OuRL7

.

¿Existe la posibilidad de tener un whl que funcione con CUDA 9 y cuDNN 7.0?

¡Gracias!

Publicaré la mía (que probablemente no sea 1.4, pero una coincidencia cercana

e incluyo el hash en el nombre) cuando lo construyo para probarlo, pero

be ubuntu 16.04 (olvido qué versión de gcc), linux, python 2.7 solo para su información.

Y realmente no se supone que deba compartir esas compilaciones porque puede ser

confuso para la gente y voy a enfatizar por todo lo que sabes que incluí algunos

puerta trasera loca. Aunque agregar un código secreto parece demasiado trabajo

a mi.

Creo que las compilaciones de gpu nocturnas están casi en vivo en pip (estoy bastante seguro de que

siempre ha sucedido, solo tenía que encontrarlos) lo que significa que después de 1.4 el

Las compilaciones nocturnas pasarán a CUDA 9 + cuDNN 7 muy rápidamente.

El lunes 9 de octubre de 2017 a las 11:41 a.m., alexirae [email protected] escribió:

¿Existe la posibilidad de tener un whl que funcione con CUDA 9 y cuDNN 7.0?

¡Gracias!

-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335249979 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZeskJ5LXJwFcRpm-sKZ9QORoltrHOEks5sqmj1gaJpZM4OuRL7

.

@tfboyd Gracias por tu respuesta. Finalmente logré construir el último TF a partir de fuentes con soporte CUDA 8 + cuDNN 7 en Ubuntu 16.04 y todo funciona bien en GTX 1080 Ti.

@tfboyd ¿14.rc TF es compatible con CuDNN 7 y CUDA 9?

Se incluye si lo construye desde el código fuente. Quiero cambiar el predeterminado

binarios que me obliga a ejecutar algunas pruebas de regresión en K80s en AWS para

asegúrese de que todo se vea bien y de que se creen las compilaciones. Nosotros

inmediatamente tuvo un problema ya que el controlador de NVIDIA necesitaba un rendimiento reducido

en Kokoro ejecutándose en Google Cloud en un 30%. Nada es todo recto

hacia adelante, pero CUDA 9 y cuDNN 7 están en la fuente 1.4 y tienen como se esperaba en

pruebas muy limitadas en Pascal para mí.

El jueves 12 de octubre de 2017 a las 2:40 a.m., Konstantin [email protected]

escribió:

@tfboyd https://github.com/tfboyd ¿14.rc TF es compatible con CuDNN 7 y

CUDA 9?-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336075883 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesq03dvnXWd0GLXODBTNCWExlZGPnks5srd6pgaJpZM4OuRL7

.

¿Existe la posibilidad de tener un whl que funcione con CUDA 9, cuDNN 7.0 y python 3.5?

Después de que se finalice TF 1.4, las compilaciones nocturnas se trasladarán a CUDA 9 +

cuDNN 7 asumiendo que no hay problemas. Las construcciones que hice y comparto por diversión son

siempre python 2.7 porque ese es el valor predeterminado en mis sistemas de prueba.

El lunes 16 de octubre de 2017 a las 6:59 a.m., Diego Stalder [email protected]

escribió:

¿Existe la posibilidad de tener un whl que funcione con CUDA 9, cuDNN 7.0 y

Python 3.5?-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336894073 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesqgclWqET4OufQHV3FAD4XxgnZiKks5ss2E6gaJpZM4OuRL7

.

¿Alguna fecha de lanzamiento prevista?

Todos los que muerden un poco, simplemente construyan #master desde la fuente. No es demasiado difícil (solo requiere mucho tiempo), obtienes las últimas optimizaciones CUDA / cuDNN _y_ adicionales en una instalación pip / whl (por ejemplo, mira las optimizaciones de CPU en este tutorial ). Además, la próxima vez que actualice CUDA / cuDNN, podrá volver a compilar sin tener que esperar.

construyendo a partir de las fuentes, TF1.4 está trabajando con cuda 9.0, cuDNN v7.0.3 y python3.5

¿Puedo construir desde la fuente en la plataforma win10?

Me gustaría que TF funcionara en cuda 9.0, cuDNN v7, python3. 6 y win10

Construido a partir de las fuentes, TF1.4 también funciona con cuda 9.0, cuDNN v7.0.3 y python2.7.

@affromero ¿

Hice una prueba de tf_cnn_benchmarks en la construcción de AWS desde la rama TF 1.4RC0 con CUDA 9 / cuDNN 7 y los resultados fueron iguales o ligeramente más rápidos que CUDA 8 + cuDNN 6.

Editar: elimine la mención de que no estaba abordando el comentario de elipeters. :-)

@elipeters

Cuando decimos construir nos referimos a construir desde el código fuente, no instalar un archivo de rueda. Una rueda ya está compilada y los binarios 1.4 son compatibles con CUDA 8 + cuDNN 6. Para obtener CUDA 9, necesitará compilar desde el código fuente. Nunca he hecho la construcción de ventanas. Una vez que se envíe 1.4, el equipo cambiará las compilaciones nocturnas a CUDA 9.

Existe la segunda versión candidata (rc1) para 1.4 como rueda precompilada (https://pypi.python.org/pypi/tensorflow). ¿Alguien ha probado eso con CUDA 9 todavía?

Probado, pero no con el trabajo cuda 9.0.

Lo intentaré otra vez.

1.4 es CUDA 8 + cuDNN 6, esto no funcionará con CUDA 9, tendrá que compilar desde la fuente

Una vez que se publique 1.4, trabajaremos para cambiar las compilaciones nocturnas a CUDA 9 y luego 1.5 probablemente sea CUDA 9.

Sé que CUDA 9 funciona bien al compilar 1.4 desde la fuente (ubuntu 16.04 / python 2) porque estaba haciendo evaluaciones comparativas en AWS el fin de semana pasado.

Tengo una receta reciente sobre cómo construir desde la fuente aquí (publique un enlace a su rueda CUDA 9.0 allí también una vez que la construya)

Eres el mejor Yaroslav.

El miércoles 25 de octubre de 2017 a las 8:11 a. M., Yaroslav Bulatov [email protected]

escribió:

Tengo una receta reciente sobre cómo construir desde la fuente aquí.

https://github.com/yaroslavvb/tensorflow-community-wheels (publique

un enlace a su rueda CUDA 9.0 allí también una vez que lo construya)-

Recibes esto porque te mencionaron.

Responda a este correo electrónico directamente, véalo en GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-339361959 ,

o silenciar el hilo

https://github.com/notifications/unsubscribe-auth/AWZesmRwb0UmLWxzANWCq5RrT6teYtr5ks5sv0-IgaJpZM4OuRL7

.

hola, trato de construir tensorflow gpu por win10 env, entonces también conocí este problema, ¿alguien puede ayudarme? Gracias primero.

mi entorno:

win10 + gtx 1080ti + cuda 9.0 + cuDNN 7 + visual studio profession 2015 + cmake 3.6.3 + python 3.5.4

cuando cambio a tensorflow r1.4 , y construyo por cmake en el entorno win10 , emite un error que :

`CUSTOMBUILD: Error interno: la afirmación falló en:" C: /dvs/p4/build/sw/rel/gpu_drv/r384/r384_00/drivers/compiler/edg/EDG_4.12/src/lookup.c ", línea 2652 [ C: \ TF \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

1 error catastrófico detectado en la compilación de "C: /Users/ADMINI~1/AppData/Local/Temp/tmpxft_00000c94_00000000-8_adjust_contrast_op_gpu.cu.cpp4.ii".

Compilación abortada.

ajustar_contraste_op_gpu.cu.cc

CUSTOMBUILD: error nvcc: 'cudafe ++' murió con el estado 0xC0000409 [C: \ TF \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

Error de CMake en tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release. cmake: 267 (mensaje):

Error al generar el archivo

C: /TF/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir / __ / __ / core / kernels / Release / tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj`

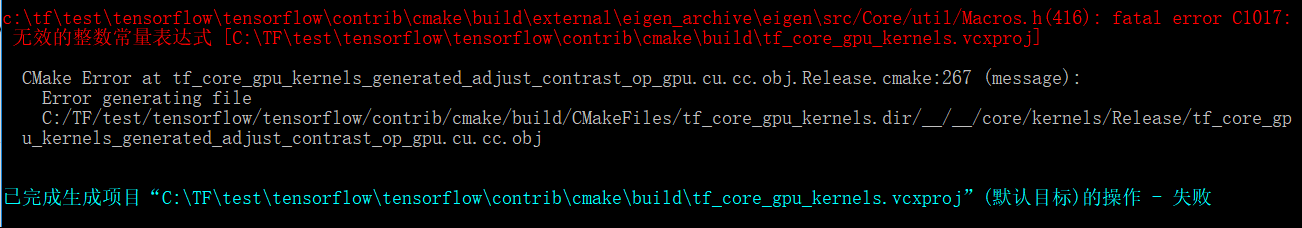

El problema anterior parece un problema de cuda compolie, pero cuando cambio la versión de tensorflow a r1.3, aparece otro problema:

`c: \ tftest \ tensorflow \ tensorflow \ contrib \ cmake \ build \ external \ eigen_archive \ eigen \ src / Core / util / Macros.h (416): error fatal C1017:

无效 的 整数 常量 表达式 [C: \ TFtest \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

Error de CMake en tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release. cmake: 267 (mensaje):

Error al generar el archivo

C: /TF/test/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir / __ / __ / core / kernels / Release / tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj`

parece que el archivo adjust_contrast_op_gpu.cu.cc tiene algún problema, pero no puedo encontrar ningún error en él.

los problemas anteriores me preocupan unos días, deseo que alguien me ayude a realizar este intento y tenga éxito, y espero que la actualización de Google tensorflow soporte cuda 9.0 y cudnn 7 en el entorno win10.

¿Alguien ha lanzado un whl para TensorFlow con CUDA 9 y cuDNN 7.0?

@vellamike Sé que tu pregunta es general, pero el equipo de TF tendrá CUDA 9 en los binarios con 1.5 que debería aterrizar en el cuarto trimestre. Por ahora, debes construir desde la fuente.

Estoy intentando construir 1.4 con CUDA 9 y cuDNN 7 en mac 10.13 high sierra. Sigo recibiendo este error

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: output 'tensorflow/core/kernels/_objs/depthwise_conv_op_gpu/tensorflow/core/kernels/depthwise_conv_op_gpu.cu.pic.o' was not created.

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: not all outputs were created or valid.

Target //tensorflow/tools/pip_package:build_pip_package failed to build

¿Alguna solución para esto?

@smitshilu posiblemente relacionado https://github.com/tensorflow/tensorflow/issues/2143

¿Por qué 1.4 todavía no tiene CUDA 9 en binarios? Esta versión se lanzó hace mucho tiempo y para usar con V100 se requiere compilar desde la fuente, lo que no es tan fácil y rápido para una serie de problemas informados.

@ViktorM ¿Qué problemas tuviste al compilar desde la fuente? Fue un poco complicado, pero no tan difícil.

El 26 de septiembre de 2017 fue el GA para CUDA 9. Si lanzamos los binarios CUDA 9 + cuDNN 7 en el cuarto trimestre, creo que será lo más rápido que hayamos actualizado cuDNN. No estuve aquí de 8.5 a 9, así que no tengo ni idea. Me gustaría que fuéramos un poco más rápido, pero esto también significa que cualquier persona con una configuración de CUDA 8 tiene que actualizar no solo a CUDA 9, sino que también necesita actualizar el controlador de su dispositivo a 384.x, que puedo decir que no es algo de producción. tomar a la ligera.

Idealmente tendríamos construcciones infinitas (o solo unas pocas más, pero la matriz explota rápidamente), pero ese es otro problema que llevaría mucho tiempo explicar y dudo que a mucha gente le importe.

@yaroslavvb Siendo muy honestos, estamos trabajando en algunos problemas del FP16. Hay una ruta en tf_cnn_benchmarks para FP16 y el foco está en ResNet50 primero y también estamos trabajando en el escalado automático para FP16. Puede intentarlo si está interesado, pero estamos trabajando activamente en algunos problemas. La gente está en eso y solo está tomando tiempo. Finalmente tenemos DGX-1 en casa, por lo que también podemos jugar con los mismos contenedores e intentar realizar un seguimiento del rendimiento en esa plataforma exacta en el futuro.

Ok, voy a instalar Ubuntu 17.10 y solo quería probar las últimas novedades para divertirme.

Antes de hacerlo, solo quería saber si alguien probó la construcción de pilas a continuación desde la fuente y tuvo suerte.

-> Ubuntu 17.10, CUDA 9.0, cuDNN 7.0, TF maestro

-> Ubuntu 17.10, CUDA 8.0, cnDNN 6.1, TF 1.4

Me encuentro con el mismo problema que @ xsr-ai, específicamente usando Python 3.6.3, VS 2017, CUDA 9, cuDNN 7.

@ aluo-x ¿Quieres decir que probaste Windows 10? Asumiendo porque dijiste VS 2017.

Si, eso es correcto. Aquí está el error específico:

CustomBuild:

Building NVCC (Device) object CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

CMake Error at tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release.cmake:222 (message):

Error generating

C:/optimae/tensorflow-1.4.0/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

C:\Program Files (x86)\Microsoft Visual Studio\2017\BuildTools\Common7\IDE\VC\VCTargets\Microsoft.CppCommon.targets(171,5): error MSB6006: "cmd.exe" exited with code 1. [C:\optimae\tensorflow-1.4.0\

tensorflow\contrib\cmake\build\tf_core_gpu_kernels.vcxproj]

@ aluo-x ¿Utilizó la última marca C? es decir, ¿la versión candidata o la versión estable?

Usando cmake 3.9.5, swig 3.0.12, CUDA 9.0.176, cuDNN 7.0.3. VS 2017 19.11.25547.

@ aluo-x Incluso yo no tuve mucha suerte con c-make. ¿Pero puedes intentar construir con Bazel?

@smitshilu Si no me equivoco, está recibiendo un error con respecto a la alineación, ¿verdad? Similar al descrito aquí para pytorch: https://github.com/pytorch/pytorch/issues/2692

Intenté aplicar la misma solución, que es eliminar todo ___ align __ (sizeof (T)) _ de los archivos problemáticos:

_tensorflow / core / kernels / concat_lib_gpu_impl.cu.cc_

_tensorflow / core / kernels / depthwise_conv_op_gpu.cu.cc_

_tensorflow / core / kernels / split_lib_gpu.cu.cc_

No estoy seguro de si esto causa algún problema, pero parece que funciona bien hasta ahora. Y por lo que tengo entendido, el tiempo de ejecución siempre usará una alineación fija de 16 para la memoria compartida.

Para las personas interesadas, hemos subido ruedas CUDA 9. ¡No es necesario que lo construyas tú mismo! https://github.com/mind/wheels/releases/tag/tf1.4-gpu-cuda9

Ubuntu 17.10, CUDA 9, CuDNN 7, Python 3.6, bazel 0.7.0 + TF desde la fuente (maestro).

Siga las instrucciones como en esta respuesta para poner en funcionamiento CUDA:

https://askubuntu.com/questions/967332/how-can-i-install-cuda-9-on-ubuntu-17-10

Tenga en cuenta que es posible que desee utilizar estos comandos en su lugar para la versión de 64 bits:

sudo ln -s /usr/bin/gcc-6 /usr/local/cuda-9.0/bin/gcc

sudo ln -s /usr/bin/g++-6 /usr/local/cuda-9.0/bin/g++

sudo ./cuda_9.0.176_384.81_linux-run --override

Para instalar Tensorflow necesitará

- Antes de compilar TF: configure correctamente las variables de ruta (las rutas de la página de NVIDIA no funcionaron para mí):

export PATH=/usr/local/cuda-9.0/bin:${PATH}

export LD_LIBRARY_PATH=${LD_LIBRARY_PATH}:/usr/local/cuda-9.0/lib64

- Antes de compilar: Configure bazel para usar la misma versión de gcc que durante la instalación de CUDA:

sudo update-alternatives --remove-all g++

sudo update-alternatives --remove-all gcc

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-6 10

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-6 10

- Mientras sigue las instrucciones de TF una vez que llegue a la nota de paso de compilación de bazel, necesitará una marca adicional para compilar con la versión de gcc superior a 4. *:

bazel build --config=opt --config=cuda --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0" //tensorflow/tools/pip_package:build_pip_package

@alexbrad Me encontré con el mismo problema de construcción para Mac GPU con CUDA 9, cuDNN 7. Esta solución también funcionó para mí y no he tenido ningún problema al usar TF hasta ahora.

Cambios de fuente y rueda: https://github.com/nathanielatom/tensorflow/releases/tag/v1.4.0-mac

Ubuntu 16.04, TensorFlow 1.4 con CUDA 9.0 y cuDNN 7.0.3 ya instalados y probados:

Instalar Tensorflow 1.4 desde la fuente

cd ~/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

- Configurar para la versión CUDA: 9.0

- Configurar para la versión cuDNN: 7.0.3

- Obtenga su capacidad informática en https://developer.nvidia.com/cuda-gpus

- Configuré esto en 6.1 porque tengo una GeForce GTX 1070

- Configure otras opciones según corresponda

./configure

Instalación de Bazel

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

Construyendo TensorFlow

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

El nombre del archivo de rueda de tensorflow anterior puede ser diferente

Solo ls /tmp/tensorflow_pkg para verificar

Pasos de instalación para Mac 10.13, CUDA 9 y tensorflow 1.4 https://gist.github.com/smitshilu/53cf9ff0fd6cdb64cca69a7e2827ed0f

¿Alguien puede decirme cómo puedo crear el paquete tensorflow whl a partir de fuentes para Windows en Linux (Ubuntu 16.04) con bazel? Era posible para la versión 1.2 si estaba en lo cierto. Gracias.

@ValeryPiashchynski puede seguir estos pasos https://www.tensorflow.org/install/install_sources

@smitshilu Gracias por tu respuesta. Puedo construir un paquete de rueda en Ubuntu siguiendo estos pasos y todo funciona bien en Ubuntu. Pero no puedo instalar ese paquete whl en el sistema operativo Windows (hay un error: no es compatible con la rueda). Entonces, mi pregunta es ¿cómo puedo crear un paquete en Ubuntu que luego puedo instalar en Windows?

~ @ValeryPiashchynski No creo que eso sea posible. ~

(sacándolo como los comentarios a continuación sugieren lo contrario)

La construcción cruzada en Ubuntu para Windows debería ser posible algún día a través de clang. Probablemente requiera muchas correcciones, ya que los binarios de Windows se compilan actualmente con MSVC. Básicamente hice la misma pregunta cuando hablé en persona con

La compilación cruzada es posible con bazel pero no estoy seguro de cómo hacerlo en tensorflow. Para referencia

https://github.com/bazelbuild/bazel/wiki/Building-with-a-custom-toolchain

https://github.com/bazelbuild/bazel/issues/1353

¿Alguien sabe si las compilaciones nocturnas de tensorflow 1.5 publicadas aquí (compilaciones win10) tienen soporte CUDA9 + CuDNN7?

https://pypi.python.org/pypi/tf-nightly-gpu/1.5.0.dev20171115

En una nota al margen, es totalmente irresponsable cerrar este ticket así como el # 14126 solo porque dices "Se lanzará con TF 1.5". MXNET 0.12 ya tiene CUDA9 FP16 en producción. Tensorflow y CNTK deben darse prisa. No solo es beneficioso para Volta.

Todavía no, estamos trabajando para actualizar nuestra infraestructura de compilación para CUDA 9.

Nuestro objetivo es tener paquetes de pip con CUDA 9 antes del final de esta semana.

tengo dos computadoras, y ayer instalé 1080ti e instalé todo (cuda8 y cudnn6) nuevo controlador gráfico, visual studio 2015

comparo el tiempo de epoch 1080ti vs 980ti

y veo que 1080ti se ejecuta cada época en 22 minutos, ¡pero 980ti se ejecuta en 13 minutos! (lote = 60 para 1080 vs lote = 20 para 980ti)

¿Por qué 1080ti funciona más lento que 980ti? ¿y cómo puedo comprobar lo que está mal?

¿Cuál es el tiempo de ejecución si usa 20 lotes para 1080Ti?

@gunan , ¿me pregunto si hay una nueva ETA para esto?

@smitshilu

en 1080ti con 20 lotes = 26 min

y con 60batch = 19min

en 980gtx con lote 20 = 14 min !!!!

uso Windows, instalo la última versión del controlador con cuda 8 y cudnn 6

¿Cómo puedo averiguar por qué funciona más lento que el 980?

@nasergh ¿Tienes GTX 1080ti y 980ti en SLI?

@vickylance

No

dos computadoras diferentes!

Ambos son disco duro cori7 y 1TB y cargo una imagen de datos desde un disco duro sata de 1TB

pero en 980 tengo Windows en el disco duro SSD

Intento una versión diferente del controlador, lo último que verifico es 388.13 descargado del sitio web de asus con CUDA 8 y cudnn 6

no sé cuál de estas es la razón

1- ventanas! tal vez funcione mejor en linux

2- velocidad del disco duro

3- 1080TI falso

4- CUDA y cudnn no compatibles con 1080ti

5- CPU (la CPU en la computadora 1080TI es más poderosa que la 980)

que sugieres ?

@nasergh

1) ¿La RAM es la misma? si es así. No estoy seguro de si afectará tanto, pero compruebe si los MHz de la RAM también son los mismos en ambos sistemas.

2) Verifique el% de utilización de la GPU cuando se ejecuta en 980ti y 1080ti. Utilice esta herramienta si desea verificar la utilización de la GPU. https://docs.microsoft.com/en-us/sysinternals/downloads/process-explorer Hay mejores por ahí, pero esto es lo que me vino a la cabeza.

3) Si desea obtener el mejor rendimiento, le sugiero que instale Ubuntu16.04 como arranque dual en su sistema 1080ti y use CUDA 9.0 y cuDNN 7.0

4) Además, Windows consume muchos recursos del sistema en sí mismo, por lo que ejecutarlo en un SSD definitivamente le da una ventaja, pero no de esa magnitud como se ve en su escenario de prueba.

Quizás sea la arquitectura de la placa seleccionada.

TF está configurado por defecto para 3.0, 3.5 y 5.2; mientras que 1080TI es 6.1 (Pascal) mientras que 980 es 5.2 (Maxwell) según https://en.wikipedia.org/wiki/CUDA#GPUs_supported.

¿Quizás la degradación a 3.0 o 5.2 no es eficiente en el 1080TI, mientras que es nativa para el 980?

Intente computar con ambas capacidades 5.2 y 6.1 (consulte CMakeLists.txt l.232 y l.246)

De: nasergh [mailto: [email protected]]

Envoyé: mercredi 22 de noviembre de 2017 17:17

À: tensorflow / tensorflow

Cc: sylvain-bougnoux; Manual

Objet: Re: [tensorflow / tensorflow] Actualización a CuDNN 7 y CUDA 9 (# 12052)

@vickylance

No

dos computadoras diferentes!

Ambos son disco duro cori7 y 1TB y cargo una imagen de datos desde un disco duro sata de 1TB

pero en 980 tengo Windows en el disco duro SSD

Intento una versión diferente del controlador, lo último que verifico es 388.13 descargado del sitio web de asus con CUDA 8 y cudnn 6

no sé cuál de estas es la razón

1- ventanas! tal vez funcione mejor en linux

2- velocidad del disco duro

3- 1080TI falso

4- CUDA y cudnn no compatibles con 1080ti

que sugieres ?

-

Estás recibiendo esto porque estás suscrito a este hilo.

Responda a este correo electrónico directamente, véalo en GitHub o silencie el hilo.

entorno: cuda9.0 + cudnn7.0 + tf1.4 , y encuentro un error cuando ejecuto el ejemplo "ptb", TypeError: __init __ () obtuvo un argumento de palabra clave inesperado 'input_size', 'input_size' es el parámetro del CudnnLSTM

Después de ver este hilo durante meses, lo probaré en Gentoo Linux.

tengo asus strix 1080TI

1- en ubunto puedo usar el controlador en el sitio web de nvidia o debo descargarlo de asus (porque no veo el controlador para linux en el sitio web de asus)

2- la última versión está bien o debo instalar 378.13 porque veo en la mayoría de los comentarios que dicen usar 378.13?

Gracias

Para aquellos en Windows, acabo de cargar TF 1.4.0 construido contra CUDA 8.0.61.2, cuDNN 7.0.4, Python 3.6.3, con soporte AVX en mi repositorio . Con suerte, esto es suficiente hasta que CUDA 9 se resuelva en Windows.

estoy tratando de instalar CUDA9 y cudnn 7 en ubuntu 16.04 y python 3.6

pero estoy fallando :(

Intento todo, busco en todas partes pero sigo dando el mismo error "importError: libcublas.so.8.0 no se puede abrir el archivo de objeto compartido: no existe tal archivo o directorio

creo que el tensor quiere ejecutar CUDA8

¿Cómo puedo decirle que use cuda9? !!!! si la respuesta se ejecuta desde la fuente, ¿cómo exactamente? No vi un sitio web muy claro sobre la compilación desde la fuente

Gracias

Deberías instalar tf desde source @ nasergh

@ withme6696

¿Cómo puedo instalarlo desde la fuente?

sé que puedo descargar uno de esto

https://github.com/mind/wheels/releases

pero no sé descargar cuál y cómo instalarlo.

@nasergh echa un vistazo a nuestro README para saber cómo instalarlo. Si no le importa instalar MKL, puede hacerlo

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-37/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Si no desea instalar MKL, puede hacerlo

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-nomkl/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Usaré este problema como problema de seguimiento para el soporte de CUDA 9.

Actualmente, existen dos bloqueadores:

1 - https://github.com/tensorflow/tensorflow/pull/14770

2 - En Windows, parece que tenemos un error con NVCC. La construcción de TF con CUDA9 parece estar fallando con un bloqueo del compilador. NVIDIA está ayudando a investigar esto y, una vez que tengamos una actualización, procederemos.

@danqing

Gracias

1- MKL ¿cuánto mejora la velocidad?

2- en la versión sin MKL ¿necesito instalar MKL?

para 1, vea esto : tenga en cuenta que los cálculos realizados en GPU no tendrán la velocidad, obviamente.

para 2, no lo haces. asegúrese de instalar la versión correcta.

por cierto, este es un hilo con muchos suscriptores. Si tiene problemas futuros con nuestras ruedas, abra un problema en nuestro repositorio en lugar de comentar a continuación, para que no enviemos spam a mucha gente.

@Tweakmind : no puedo pasar esta parte:

Construyendo TensorFlow

bazel build --config = opt --config = cuda // tensorflow / tools / pip_ package: build_pip_package --cxxopt = "- D_GLIBCXX_USE_CXX11_ABI = 0

bazel-bin / tensorflow / tools / pip_package / build_pip_package / tmp / tensorflow_pkg

instalación de pip /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

¿La primera línea parece estar incompleta (faltan comillas dobles)? ¿Son estas tres líneas o dos líneas?

@goodmangu el código correcto, creo, es:

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

Faltan comillas dobles en el comando.

Estoy superando esta parte usando el script aquí , pero me bloquean algunos errores del compilador cuda en https://github.com/tensorflow/tensorflow/issues/15108

Gracias chicos. Aprecio esto. Lo hice funcionar el mismo día usando el binario de Linux de compilación nocturna en su lugar. Ver: https://github.com/tensorflow/tensorflow

Ahora ejecutando 3 GTX 1080 Tis con Keras. ¡Frio!

Pasé los últimos dos días tratando de construir Tensorflow desde la fuente (r1.4) para mi MacBook Pro con una eGPU. El controlador funciona, con Cuda 8.0, cuDNN 6.0, Mac OSX Sierra 10.12. Muy cerca del final, pero bloqueado por algunos errores de compilación después de 20 minutos. ¿Alguien ha tenido suerte hasta ahora? ¿Algún paquete construido con éxito que pueda compartir? Gracias por adelantado.

@goodmangu ¿Podría especificar qué "binario de Linux de compilación nocturna" utiliza?

Claro, este: tf_nightly_gpu-1.head-cp27-none-linux_x86_64.whl

¿Aún no es compatible con Windows 10 para Cuda 9.0 + cuDNN 7.0? Solo verificando.

Tensorflow GPU 1.4.0

@goodmangu Probé con 1.4 pero OSX 10.13 y CUDA 9 cuDNN 7. Puedes encontrar los pasos aquí

@ eeilon79 hay un error nvcc en Windows que nos impide construir binarios. Estamos recibiendo ayuda de nvidia para solucionar esos problemas.

¿Hay alguna actualización para CUDA 9 en la versión nocturna de Tensorflow (1.5-dev) en el paquete tf-nightly-gpu pip? Necesito usar este 1.5 para el CuDNNLSTM en Keras

OK, el PR acaba de fusionarse.

En aproximadamente 10-12 horas, nuestros nuevos camisones deberían construirse con cuda9, a excepción de las ventanas.

En Windows, todavía estamos bloqueados por un error de NVCC.

Terminé el paquete general CUDA 9 y CUDANN 7 para el sistema Gentoo y probé la prueba ficticia y parece que funciona con la importación ficticia tensorflow como tf en python, pero necesito hacer pruebas adicionales:

Estoy usando commit: c9568f1ee51a265db4c5f017baf722b9ea5ecfbb

En Windows, todavía estamos bloqueados por un error de NVCC.

¿Le importaría publicar el enlace aquí a ese problema? ¡Gracias por adelantado!

@smitshilu Tu artículo me ayudó.

Y escribí un artículo con algunos elementos agregados.

https://github.com/masasys/MacTF1.4GPU

@arbynacosta

Corro

bazel build --config = opt --config = cuda // tensorflow / tools / pip_ package: build_pip_package --cxxopt = "- D_GLIBCXX_USE_CXX11_ABI = 0"

pero me sale este error

Error: el comando de compilación solo se admite desde un espacio de trabajo.

También pruebo el tensor todas las noches pero me da error

atributoerror: el módulo 'tensorflow' no tiene atributo ....

salida de dir (tf)

['__doc__', '__loarder__', '__name__', __package__ '' __path__ __spec__]

Lo siento @goodmangu , estaba fuera. ¿Lo hiciste funcionar? Extrañé las comillas dobles de cierre como señaló

@nasergh , ¿está ejecutando ese comando desde el interior del directorio tensorflow clonado? Asegúrese de que WORKSPACE exista en el directorio.

Por ejemplo:

~/Downloads/tensorflow$ ls

ACKNOWLEDGMENTS bazel-bin bazel-testlogs configure LICENSE tensorflow WORKSPACE

ADOPTERS.md bazel-genfiles BUILD configure.py models.BUILD third_party

arm_compiler.BUILD bazel-out CODE_OF_CONDUCT.md CONTRIBUTING.md README.md tools

AUTHORS bazel-tensorflow CODEOWNERS ISSUE_TEMPLATE.md RELEASE.md util

@Tweakmind

yo ejecuto el comando

sudo su

y luego ir a la carpeta tensorflow (había un archivo de espacio de trabajo allí)

pero me sale este error

root<strong i="10">@pc</strong>:/home/pc2/tensorflow# bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

..........

WARNING: Config values are not defined in any .rc file: opt

ERROR: /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD:4:1: Traceback (most recent call last):

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD", line 4

error_gpu_disabled()

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/error_gpu_disabled.bzl", line 3, in error_gpu_disabled

fail("ERROR: Building with --config=c...")

ERROR: Building with --config=cuda but TensorFlow is not configured to build with GPU support. Please re-run ./configure and enter 'Y' at the prompt to build with GPU support.

ERROR: no such target '@local_config_cuda//crosstool:toolchain': target 'toolchain' not declared in package 'crosstool' defined by /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD

INFO: Elapsed time: 6.830s

FAILED: Build did NOT complete successfully (2 packages loaded)

currently loading: @bazel_tools//tools/jdk

@nasergh Asegúrese de seguir todas las instrucciones aquí:

https://www.tensorflow.org/install/install_sources

Si está compilando con soporte de GPU, asegúrese de que está configurando apropiadamente.

Instale Tensorflow 1.4 desde la fuente.

- Al momento de escribir este artículo, esta es la única forma en que funcionará con CUDA 9.0 y cuDNN 7.0

- Instrucciones: https://www.tensorflow.org/install/install_sources

- Algunas de las instrucciones pueden no tener sentido, así es como lo hice:

cd $HOME/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

./configure

La salida de muestra y las opciones diferirán de las de las instrucciones.

- Asegúrese de configurar para la versión CUDA: 9.0

- Asegúrese de configurar para la versión cuDNN: 7.0.4

- Asegúrese de conocer su capacidad informática en https://developer.nvidia.com/cuda-gpus

- Configuré esto en 6.1 porque tengo una GeForce GTX 1070

Instalación de Bazel

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

Construyendo TensorFlow

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

@Tweakmind : gracias por

@Tweakmind

hago lo siguiente y también configuro el archivo pero dice

pc2<strong i="7">@pc</strong>:~/Downloads/tensorflow$ bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: Skipping '//tensorflow/tools/pip_package:build_pip_package': error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

WARNING: Target pattern parsing failed.

ERROR: error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

INFO: Elapsed time: 0.082s

FAILED: Build did NOT complete successfully (0 packages loaded)

currently loading: tensorflow/tools/pip_package

creo que instalo cuda y cudnn correctamente

''

buscar / usr | grep libcudnn

/ usr / share / doc / libcudnn7

/ usr / share / doc / libcudnn7 / copyright

/usr/share/doc/libcudnn7/NVIDIA_SLA_cuDNN_Support.txt

/usr/share/doc/libcudnn7/changelog.Debian.gz

/ usr / share / lintian / overrides / libcudnn7

/usr/lib/x86_64-linux-gnu/libcudnn.so.7.0.4

/usr/lib/x86_64-linux-gnu/libcudnn.so.7

''

@goodmangu , trabajaré en la compilación de MacOS durante el fin de semana.

@nasergh , ¿instalaste cuDNN?

Aquí está mi guía para cuDNN, incluida la fuente y los documentos para probar la instalación:

Descargar archivos cuDNN 7.0.4

Debe iniciar sesión en su cuenta de desarrollador de Nvidia en su navegador

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/cudnn-9.0-linux-x64-v7

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64

Compruebe cada hash

cd $HOME/Downloads

md5sum cudnn-9.0-linux-x64-v7.tgz && \

md5sum libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

La salida debe ser:

fc8a03ac9380d582e949444c7a18fb8d cudnn-9.0-linux-x64-v7.tgz

e986f9a85fd199ab8934b8e4835496e2 libcudnn7_7.0.4.31-1 + cuda9.0_amd64.deb

4bd528115e3dc578ce8fca0d32ab82b8 libcudnn7-dev_7.0.4.31-1 + cuda9.0_amd64.deb

04ad839c937362a551eb2170afb88320 libcudnn7-doc_7.0.4.31-1 + cuda9.0_amd64.deb

Instale cuDNN 7.0.4 y bibliotecas

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

Verificando cuDNN

Ubuntu 17.10 incluye la versión 7+ de los compiladores GNU

CUDA no es compatible con versiones superiores a 6

El error devuelto es:

error - ¡versión GNU no compatible! ¡Las versiones de gcc posteriores a la 6 no son compatibles!

Solución: instale la versión 6 y cree enlaces simbólicos en el directorio bin de CUDA:

sudo apt-get install gcc-6 g++-6

sudo ln -sf /usr/bin/gcc-6 /usr/local/cuda/bin/gcc

sudo ln -sf /usr/bin/g++-6 /usr/local/cuda/bin/g++

Ahora compile mnistCUDNN para probar cuDNN

cp -r /usr/src/cudnn_samples_v7/ $HOME

cd $HOME/cudnn_samples_v7/mnistCUDNN

make clean && make

./mnistCUDNN

Si cuDNN está instalado correctamente, verá:

¡Prueba aprobada!

Estimado @Tweakmind

su camino funciona gracias por su ayuda (¡¡¡Estuve intentando instalar tensor por más de 3 semanas !!!)

el problema es que lo instalo en python3.6 y ahora tengo un problema con el paquete PIL

Traceback (most recent call last):

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 551, in get

inputs = self.queue.get(block=True).get()

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 644, in get

raise self._value

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 119, in worker

result = (True, func(*args, **kwds))

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 391, in get_index

return _SHARED_SEQUENCES[uid][i]

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 761, in __getitem__

return self._get_batches_of_transformed_samples(index_array)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 1106, in _get_batches_of_transformed_samples

interpolation=self.interpolation)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 345, in load_img

raise ImportError('Could not import PIL.Image. '

ImportError: Could not import PIL.Image. The use of `array_to_img` requires PIL.

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File "<stdin>", line 7, in <module>

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/models.py", line 1227, in fit_generator

initial_epoch=initial_epoch)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/engine/training.py", line 2115, in fit_generator

generator_output = next(output_generator)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 557, in get

six.raise_from(StopIteration(e), e)

File "<string>", line 3, in raise_from

StopIteration: Could not import PIL.Image. The use of `array_to_img` requires PIL.

Intento instalar la almohada pero no ayuda

también intento instalar PIL pero

UnsatisfiableError: The following specifications were found to be in conflict:

- pil -> python 2.6*

- python 3.6*

@nasergh ¿Qué obtienes con:

pip install pillow

El mío se parece a:

~$ pip install pillow

Requirement already satisfied: pillow in ./anaconda3/lib/python3.6/site-packages

@nasergh , tengo que estrellarme, pero me registraré cuando me levante.

@goodmangu , no podré hacer la compilación de Mac durante el fin de semana porque no tengo acceso a mi Mac Pro 2012. Con suerte, eres bueno con Ubuntu por ahora. Sé que me funciona bien. Debería tenerlo de vuelta el próximo fin de semana.

@Tweakmind - ¡Gracias! , ¿ha visto algún aumento de rendimiento con CUDA 9 y cuDNN 7?

También creo que algunos pasos mencionados por @Tweakmind a continuación son redundantes, o necesitas:

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

o

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

@gunan

CUDA 9.1.85 se lanzó hace unos momentos con CuDNN 7.0.5, con correcciones de errores del compilador nvcc. Me pregunto si permite a los usuarios de win10 compilar Tensorflow 1.4.1. Ya era hora.

De nuestras correspondencias con NVIDIA, no creo que 9.1 haya solucionado este problema.

Sin embargo, tenemos soluciones alternativas. Primero, necesitamos que este PR se fusione en eigen:

https://bitbucket.org/eigen/eigen/pull-requests/351/win-nvcc/diff

Luego actualizaremos nuestra dependencia eigen, que debería arreglar todas nuestras compilaciones para CUDA9

El pr se rechaza pero parece que se fusionará manualmente. ¿Tenemos que esperar una versión propia o las fuentes la están construyendo?

Genial, entonces estará en Nightly pip?

@Tweakmind

Intento reconstruir el tensor usando Python 2.7

pero en la compilación de bazel obtengo este error

También instalo numpy pero sin cambios.

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: /home/gh2/Downloads/tensorflow/util/python/BUILD:5:1: no such package '@local_config_python//': Traceback (most recent call last):

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 310

_create_local_python_repository(repository_ctx)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 274, in _create_local_python_repository

_get_numpy_include(repository_ctx, python_bin)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 257, in _get_numpy_include

_execute(repository_ctx, [python_bin, "-c",..."], <2 more arguments>)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 76, in _execute

_python_configure_fail("\n".join([error_msg.strip() if ... ""]))

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 37, in _python_configure_fail

fail(("%sPython Configuration Error:%...)))

Python Configuration Error: Problem getting numpy include path.

Traceback (most recent call last):

File "<string>", line 1, in <module>

**ImportError: No module named numpy**

Is numpy installed?

and referenced by '//util/python:python_headers'

ERROR: Analysis of target '//tensorflow/tools/pip_package:build_pip_package' failed; build aborted: Loading failed

INFO: Elapsed time: 10.826s

FAILED: Build did NOT complete successfully (26 packages loaded)

currently loading: tensorflow/core ... (3 packages)

Fetching http://mirror.bazel.build/.../~ooura/fft.tgz; 20,338b 5s

Fetching http://mirror.bazel.build/zlib.net/zlib-1.2.8.tar.gz; 19,924b 5s

Fetching http://mirror.bazel.build/.../giflib-5.1.4.tar.gz; 18,883b 5s

Parece que OSX está excluido en la versión 7.0.5 de cuDNN. ¿Alguien sabe algo detallado?

Todavía no puedo hacer que tensorflow-gpu funcione en Windows 10 (con CUDA 9.0.176 y cudnn 7.0).

Desinstalé tensorflow y tensorflow-gpu y los reinstalé (con --no-cache-dir para asegurar la descarga de la versión más reciente con la solución alternativa eigen). Cuando instalo ambos, no se reconoce mi GPU:

InvalidArgumentError (ver arriba para rastreo): No se puede asignar un dispositivo para la operación 'random_uniform_1 / sub': La operación se asignó explícitamente a / device: GPU : 0 pero los dispositivos disponibles son [/ job: localhost / replica : 0 / task: 0 / device : CPU: 0 ]. Asegúrese de que la especificación del dispositivo se refiera a un dispositivo válido.

Cuando instalo solo tensorflow-gpu, se queja de que falta un dll:

ImportError: no se pudo encontrar 'cudart64_80.dll'. TensorFlow requiere que esta DLL se instale en un directorio que se nombra en su variable de entorno% PATH%. Descargue e instale CUDA 8.0 desde esta URL: https://developer.nvidia.com/cuda-toolkit

Lo cual es extraño porque mi versión de CUDA es 9.0, no 8.0, y se reconoce (se pasó la prueba de deviceQuery).

Mi versión de Python es 3.6.3. Estoy intentando ejecutar este código en Spyder (3.2.4) para probar tensorflow-gpu.

¿Qué me perdí?

Estoy tratando de compilar desde la fuente por bazel en win 7, obtengo un error

Sin caja de herramientas para cpu 'x64_windows'

¿Alguien puede construir whl?

@ hadaev8 , necesito mucha más información para ayudar. Puedo trabajar en un whl pero tendrá grandes dependencias y no Win7, una vez que resuelva MacOS, resolveré Win10. En cualquier caso, publique sus datos.

@ eeilon79 , necesito volver a crear esto en Win10. Actualmente estoy enfocado en MacOS ahora que Ubuntu está resuelto. Volveré a Win 10.

@nasergh , ¿existe algún requisito para Python 2.7?

Con CUDA 8.0 y cuDNN 6.0, así es como instalé TensorFlow desde la fuente para la compatibilidad con Cuda GPU y AVX2 en Win10:

Requerimientos:

* Windows 10 64-Bit

* Visual Studio 15 C++ Tools

* NVIDIA CUDA® Toolkit 8.0

* NVIDIA cuDNN 6.0 for CUDA 8.0

* Cmake

* Swig

Instale Visual Studio Community Edition Update 3 con Windows Kit 10.0.10240.0

Siga las instrucciones en: https://github.com/philferriere/dlwin (Gracias Phil)

Cree una unidad virtual N: para mayor claridad

Sugiero crear un directorio fuera de C: o la unidad que elijas y crear N: según estas instrucciones (2 GB como mínimo):

https://technet.microsoft.com/en-us/library/gg318052 (v = ws.10) .aspx

Instalar Cuda 8.0 de 64 bits

https://developer.nvidia.com/cuda-downloads (Desplácese hacia abajo hasta Legacy)

Instale cuDNN 6.0 para Cuda 8.0

https://developer.nvidia.com/rdp/cudnn-download

Coloque la carpeta cuda de zip en N: \ y cambie el nombre de cuDNN-6

Instalar CMake

https://cmake.org/files/v3.10/cmake-3.10.0-rc5-win64-x64.msi

Instalar Swig (swigwin-3.0.12)

https://sourceforge.net/projects/swig/files/swigwin/swigwin-3.0.12/swigwin-3.0.12.zip

cntk-py36

`` `conda crear --nombre cntk-py36 python = 3.6 numpy scipy h5py jupyter

activar cntk-py36

instalación de pip https://cntk.ai/PythonWheel/GPU/cntk-2.2-cp36-cp36m-win_amd64.whl

python -c "importar cntk; imprimir (cntk .__ versión__)"

conda instalar pygpu

pip instalar keras

#### Remove old tensorflow in Tools if it exists

```cd C:\Users\%USERNAME%\Tools\

move tensorflow tensorflow.not

git clone --recursive https://github.com/tensorflow/tensorflow.git

cd C:\Users\%USERNAME%\Tools\tensorflow\tensorflow\contrib\cmake

Edit CMakeLists.txt

Comenta estos:

# if (tensorflow_OPTIMIZE_FOR_NATIVE_ARCH)

# include(CheckCXXCompilerFlag)

# CHECK_CXX_COMPILER_FLAG("-march=native" COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

# if (COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

# set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -march=native")

# endif()

# endif()

Agregue estos:

if (tensorflow_OPTIMIZE_FOR_NATIVE_ARCH)

include(CheckCXXCompilerFlag)

CHECK_CXX_COMPILER_FLAG("-march=native" COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

if (COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -march=native")

else()

CHECK_CXX_COMPILER_FLAG("/arch:AVX2" COMPILER_OPT_ARCH_AVX_SUPPORTED)

if(COMPILER_OPT_ARCH_AVX_SUPPORTED)

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} /arch:AVX2")

endif()

endif()

endif()

compilación de mkdir y compilación de cd

"C:\Program Files (x86)\Microsoft Visual Studio 14.0\VC\bin\amd64\vcvars64.bat"

cmake .. -A x64 -DCMAKE_BUILD_TYPE=Release ^

-DSWIG_EXECUTABLE=N:/swigwin-3.0.12/swig.exe ^

-DPYTHON_EXECUTABLE=N:/Anaconda3/python.exe ^

-DPYTHON_LIBRARIES=N:/Anaconda3/libs/python36.lib ^

-Dtensorflow_ENABLE_GPU=ON ^

-DCUDNN_HOME="n:\cuDNN-6" ^

-Dtensorflow_WIN_CPU_SIMD_OPTIONS=/arch:AVX2

- Edificio para: Visual Studio 14 2015