Tensorflow: قم بالترقية إلى CuDNN 7 و CUDA 9

معلومات النظام

- هل قمت بكتابة رمز مخصص (على عكس استخدام برنامج نصي لمثال الأسهم متوفر في TensorFlow) : لا

- نظام التشغيل الأساسي والتوزيع (على سبيل المثال ، Linux Ubuntu 16.04) : Windows Server 2012

- تم تثبيت TensorFlow من (مصدر أو ثنائي) : ثنائي

- إصدار TensorFlow (استخدم الأمر أدناه) : 1.3.0-rc1

- إصدار Python : 3.5.2

- إصدار Bazel (إذا كان التجميع من المصدر) : N / A

- إصدار CUDA / cuDNN : CUDA V8.0.44 ، CuDNN 6.0

- طراز وحدة معالجة الرسومات والذاكرة : Nvidia GeForce GTX 1080 Ti ، 11 جيجابايت

- الأمر المحدد لإعادة الإنتاج : N / A

صف المشكلة

يرجى ترقية TensorFlow لدعم CUDA 9 و CuDNN 7. تدعي Nvidia أن هذا سيوفر أداءً مضاعفًا على وحدات معالجة الرسومات Pascal.

ال 170 كومينتر

tfboyd هل لديك أي تعليق على هذا؟

لا يزال cuDNN 7 في وضع المعاينة ويتم العمل عليه. لقد انتقلنا للتو إلى cuDNN 6.0 مع 1.3 ، والتي من المفترض أن تصبح نهائية في غضون أسبوعين. يمكنك تنزيل cuDNN 1.3.0rc2 إذا كنت مهتمًا بذلك. لم أقوم بتجميع cuDNN 7 أو CUDA 9 حتى الآن. لقد سمعت أنه ليس من السهل تثبيت CUDA 9 على جميع الأنظمة الأساسية ولا تتوفر سوى حزم تثبيت مختارة. عندما تنتهي المكتبات ، سنبدأ التقييم النهائي. بدأت NVIDIA للتو في إرسال تصحيحات إلى منصات ML الرئيسية لدعم جوانب هذه المكتبات الجديدة وأظن أنه سيكون هناك عمل إضافي.

تحرير: قصدت أن أقول إن CUDA 9 ليس من السهل تثبيته على جميع المنصات وبدلاً من ذلك قلت cuDNN. لقد غيرت أيضًا بالتأكيد أنه سيكون هناك عمل لأظن أنه سيكون هناك عمل إضافي. بقية بياني السخيف الذي تركته ، على سبيل المثال لم أكن أدرك أن cuDNN 7 تم بثه مباشرة أمس.

لا أقول كيف يجب أن تقرأ الموقع. لكن يبدو أن أسرع 2x على باسكال جزء من إصدار CUDA 8. أفترض أن ذلك يعتمد على كيفية قراءتك للموقع. لم تذكر NVIDIA لنا أن CUDA 9 ستعمل على تسريع Pascal بمقدار 2x (في كل شيء) وبينما كل شيء ممكن ، لا أتوقع حدوث ذلك.

https://developer.nvidia.com/cuda-toolkit/whatsnew

الموقع محير بعض الشيء لكني أعتقد أن القسم الذي تقتبسه متداخل في CUDA 8. أذكر هذا فقط حتى لا يكون لديك توقعات غير واقعية لإصدارها. بالنسبة لفولتا ، يجب أن يكون هناك بعض المكاسب الكبيرة مما أفهمه وأعتقد (لست متأكدًا الآن) أن الناس يحصلون فقط على عينات هندسية من فولتا لبدء عمل رفيع المستوى للاستعداد للإصدار الكامل.

tfboyd cuDNN 7 لم يعد في وضع المعاينة اعتبارًا من أمس. تم إصداره رسميًا لكل من CUDA 8.0 و CUDA 9.0 RC.

آه فاتني ذلك. شكرا sclarkson وآسف للمعلومات الخاطئة.

سأجربه بالتأكيد لأنه أخيرًا يتم دعم مجلس التعاون الخليجي 6 بواسطة CUDA 9 ويأتي معه Ubuntu 17.04.

إذا كان لديك الحظ ، دع الخيط يعرف. أنا شخصيا بدأت للتو

اختبار cuDNN 6 بالكامل (تم اختباره داخليًا كثيرًا ولكني لم أقم بذلك

باستخدامه شخصيًا). غالبًا ما أكون بطيئًا في الترقية إلى أحدث الأشياء. لي

تخمين أنك قد لا ترى أي تغيير حقيقي مع cuDNN 7 حتى يحصل كل شيء

مصححة لاستخدام أحدث واجهات برمجة التطبيقات. أريد أن أؤكد مرة أخرى أنني مخطئ جميعًا

من الوقت. ما رأيته كغريب هو إضافة إصدارات cuDNN الجديدة

طرق جديدة / واجهات برمجة التطبيقات. بعضها ممتع والبعض الآخر ليس على الفور

مفيد. ثم يتم الكشف عن واجهات برمجة التطبيقات هذه عبر واجهة برمجة تطبيقات TensorFlow أو استخدامها للتو

وراء الكواليس لتسريع الأساليب الحالية. مستواي العالي جدا

الفهم هو أن cuDNN 7 + CUDA 9 سيعزز دعم FP16 مع التركيز على

فولتا. أعتقد أن أحد النقاط الرئيسية التي تركز عليها هو كيفية الحصول على النماذج (العديد منها ليس فقط

عدد قليل) للالتقاء مع FP16 دون الحاجة إلى التخمين الصحيح إلى ما لا نهاية

config / hyperparameters للاستخدام. أريد أن أؤكد أن هذا هو ما أنا عليه

فهمت المحادثة وقد أكون غير صحيح أو نصفه صحيح.

الإجهاد: إذا كانت هناك طرق تعتقد أنها بحاجة إلى إضافتها (أو الاستفادة منها

الأداء) إلى TensorFlow من cuDNN ، نحن مهتمون دائمًا بقائمة.

داخليًا ، حدث هذا مع cuDNN 6 وركزنا على تنفيذ

قالت فرق الميزات إنهم يريدون أن يساعد ذلك في مشاريعهم.

يوم السبت ، 5 أغسطس ، 2017 الساعة 8:46 صباحًا ، Courtial Florian [email protected]

كتب:

سأجربه بالتأكيد لأن مجلس التعاون الخليجي 6 مدعوم من CUDA 9 و

يأتي Ubuntu 17.04 معه.-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320450756 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZessKqj_nPY1br9SD9L9SX-8Kf5Dbtks5sVI5TgaJpZM4OuRL7

.

عند الحديث عن الأساليب التي سيتم إضافتها ، فإن الالتفاف الجماعي من cudnn7 سيكون سمة مهمة لمجتمع الرؤية.

رائع سأضيفه إلى القائمة التي أبدأ بها. قد أنسى لكني أشعر بالحرية

لتذكيرني بنشر نوع من القائمة حيث يمكنني تقديم بعض الإرشادات

على ما يحتمل أن يتم العمل عليه. لا يمكن أن يكون وعدًا ولكننا نريد

التعليقات حتى نتمكن من تحديد أولويات ما يريده الناس ويحتاجونه. شكرا لك يوكسين.

في يوم السبت ، 5 أغسطس ، 2017 الساعة 12:26 مساءً ، كتب Yuxin Wu [email protected] :

عند الحديث عن الأساليب التي سيتم إضافتها ، سيكون التفاف المجموعة من cudnn7 عبارة عن ملف

ميزة مهمة لمجتمع الرؤية.-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

.

لقد حاولت للتو التحويل البرمجي باستخدام cuDNN 7 باستخدام CUDA 8 وفشلت في ذلك النوع

من المتوقع. هناك تصحيح وارد من NVIDIA يجب أن يساعد في الخط

الامور. مجرد تنبيه إذا كان أي شخص يحاول.

في يوم السبت ، 5 آب (أغسطس) 2017 الساعة 1:47 مساءً ، كتب توبي بويد [email protected] :

رائع سأضيفه إلى القائمة التي أبدأ بها. قد أنسى لكني أشعر بالحرية

لتذكيرني بنشر نوع من القائمة حيث يمكنني تقديم بعض الإرشادات

على ما يحتمل أن يتم العمل عليه. لا يمكن أن يكون وعدًا ولكننا نريد

التعليقات حتى نتمكن من تحديد أولويات ما يريده الناس ويحتاجونه. شكرا لك يوكسين.يوم السبت ، 5 أغسطس ، 2017 الساعة 12:26 مساءً ، Yuxin Wu [email protected]

كتب:عند الحديث عن الأساليب التي سيتم إضافتها ، سيكون التفاف المجموعة من cudnn7 عبارة عن ملف

ميزة مهمة لمجتمع الرؤية.-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

.

أحاول الحصول على cuDNN 7 مع تشغيل CUDA 8/9. لا يتم دعم CUDA 8 بواسطة GTX 1080 Ti - على الأقل يقول المثبت ذلك ^ ^

أواجه مشكلة كبيرة في تشغيلها معًا. أريد أن أشير إلى هذا المقال الرائع الذي يلخص ما جربته بالفعل: https://nitishmutha.github.io/tensorflow/2017/01/22/TensorFlow-with-gpu-for-windows.html

تعمل أمثلة CUDA عبر Visual Studio في كلا مجموعتي الإعداد.

هنا ناتج deviceQuery.exe الذي تم تجميعه باستخدام Visual Studio:

PS C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release> deviceQuery.exe

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release\deviceQuery.exe Starting...

CUDA Device Query (Runtime API) version (CUDART static linking)

Detected 1 CUDA Capable device(s)

Device 0: "GeForce GTX 1080 Ti"

CUDA Driver Version / Runtime Version 9.0 / 9.0

CUDA Capability Major/Minor version number: 6.1

Total amount of global memory: 11264 MBytes (11811160064 bytes)

(28) Multiprocessors, (128) CUDA Cores/MP: 3584 CUDA Cores

GPU Max Clock rate: 1683 MHz (1.68 GHz)

Memory Clock rate: 5505 Mhz

Memory Bus Width: 352-bit

L2 Cache Size: 2883584 bytes

Maximum Texture Dimension Size (x,y,z) 1D=(131072), 2D=(131072, 65536), 3D=(16384, 16384, 16384)

Maximum Layered 1D Texture Size, (num) layers 1D=(32768), 2048 layers

Maximum Layered 2D Texture Size, (num) layers 2D=(32768, 32768), 2048 layers

Total amount of constant memory: 65536 bytes

Total amount of shared memory per block: 49152 bytes

Total number of registers available per block: 65536

Warp size: 32

Maximum number of threads per multiprocessor: 2048

Maximum number of threads per block: 1024

Max dimension size of a thread block (x,y,z): (1024, 1024, 64)

Max dimension size of a grid size (x,y,z): (2147483647, 65535, 65535)

Maximum memory pitch: 2147483647 bytes

Texture alignment: 512 bytes

Concurrent copy and kernel execution: Yes with 2 copy engine(s)

Run time limit on kernels: Yes

Integrated GPU sharing Host Memory: No

Support host page-locked memory mapping: Yes

Alignment requirement for Surfaces: Yes

Device has ECC support: Disabled

CUDA Device Driver Mode (TCC or WDDM): WDDM (Windows Display Driver Model)

Device supports Unified Addressing (UVA): Yes

Supports Cooperative Kernel Launch: No

Supports MultiDevice Co-op Kernel Launch: No

Device PCI Domain ID / Bus ID / location ID: 0 / 1 / 0

Compute Mode:

< Default (multiple host threads can use ::cudaSetDevice() with device simultaneously) >

deviceQuery, CUDA Driver = CUDART, CUDA Driver Version = 9.0, CUDA Runtime Version = 9.0, NumDevs = 1, Device0 = GeForce GTX 1080 Ti

Result = PASS

tfboyd هل لديك أي رابط يؤكد تحديث cuDNN من Nvidea؟

يدعم @ 4F2E4A2E 1080 Ti بالتأكيد CUDA 8.0. هذا ما كنت أستخدمه مع TensorFlow خلال الأشهر العديدة الماضية.

مرحبًا بالجميع ، لدي gtx 1080 ti مع cuda 8.0. أحاول تثبيت tensorflow-gpu ، هل أستخدم cuDNN 5.1 أو 6.0 أو 7.0؟

أقترح التمسك بـ 5.1 في الوقت الحالي. أنا أجري بعض الأداء الأعمق

الاختبارات على 6 والحصول على نتائج مختلطة تحتاج إلى مزيد من الاختبارات لمعرفة ذلك.

في 6 أغسطس 2017 الساعة 9:30 مساءً ، كتب "colmantse" [email protected] :

مرحبًا بالجميع ، لدي gtx 1080 ti مع cuda 8.0. أحاول التثبيت

tensorflow-gpu ، هل أستخدم cuDNN 5.1 أو 6.0 أو 7.0؟-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320566071 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZeshvEFsdeWz-1uyzl_L6HE15E0BzSks5sVpLlgaJpZM4OuRL7

.

شكرًا ، لقد جربت مع cudnn 6.0 ولكن لا يعمل ، أعتقد أنه بسبب تركيب tf-gpu الوهمي. cudnn 5.1 يعمل معي مع Python 3.6

tpankaj شكرا لك! لقد قمت بتشغيله مع CUDA 8 و cuDNN 5.1

فيما يلي مجموعة الميزات الكاملة في cuDNN 7:

الميزات والتحسينات الرئيسية

يتضمن إصدار cuDNN هذا الميزات والتحسينات الرئيسية التالية.

موتر النوى

الإصدار 7.0.1 من cuDNN هو أول إصدار يدعم عمليات Tensor Core في

تطبيق. توفر نوى الموتر مضاعفة مصفوفة محسّنة للغاية

كتل البناء التي ليس لها سلوك عددي مكافئ في التقليدية

التعليمات ، لذلك ، فإن سلوكها العددي مختلف قليلاً.

cudnnSetConvolutionMathType و cudnnSetRNNMatrixMathType و

cudnnMathType_t

cudnnSetConvolutionMathType و cudnnSetRNNMatrixMathType

تمكّنك الوظائف من اختيار ما إذا كنت تريد استخدام عمليات Tensor Core أم لا في

طبقات الالتفاف و RNN على التوالي عن طريق ضبط الوضع الرياضي على أي منهما

CUDNN_TENSOR_OP_MATH أو CUDNN_DEFAULT_MATH.

تؤدي عمليات Tensor Core تراكمًا متوازيًا للنقطة العائمة متعددة

منتجات النقطة العائمة.

يشير ضبط وضع الرياضيات على CUDNN_TENSOR_OP_MATH إلى أن المكتبة ستستخدم

عمليات Tensor Core.

الافتراضي هو CUDNN_DEFAULT_MATH. يشير هذا الافتراضي إلى أن Tensor Core

سيتم تجنب العمليات من قبل المكتبة. الوضع الافتراضي هو عملية متسلسلة

بينما ، Tensor Core هي عملية متوازية ، وبالتالي ، قد ينتج عنهما

في نتائج عددية مختلفة قليلاً بسبب اختلاف تسلسل العمليات.

تعود المكتبة إلى الوضع الرياضي الافتراضي عندما تكون عمليات Tensor Core

غير مدعوم أو غير مسموح به.

cudnnSetConvolutionGroupCount

واجهة جديدة تسمح للتطبيقات بتنفيذ مجموعات التفاف في ملف

طبقات الالتفاف في استدعاء API واحد.

cudnnCTCLoss

يوفر cudnnCTCLoss تطبيق GPU لـ Connectionist Temporal

دالة خسارة التصنيف (CTC) لـ RNNs. يتم استخدام وظيفة فقدان CTC من أجل

التعرف على الصوت في التعرف على الكلام والكتابة اليدوية.

CUDNN_BATCHNORM_SPATIAL_PERSISTENT

دالة CUDNN_BATCHNORM_SPATIAL_PERSISTENT هي دفعة جديدة

وضع التطبيع لـ cudnnBatchNormalizationForwardTraining

و cudnnBatchNormalizationBackward. هذا الوضع مشابه لـ

CUDNN_BATCHNORM_SPATIAL ، ومع ذلك ، يمكن أن يكون أسرع لبعض المهام.

cudnnQueryRuntimeError

تُبلغ الدالة cudnnQueryRuntimeError عن رموز الخطأ التي كتبها GPU

النواة عند تنفيذ cudnnBatchNormalizationForwardTraining

و cudnnBatchNormalizationBackward مع امتداد

الوضع CUDNN_BATCHNORM_SPATIAL_PERSISTENT.

cudnnGetConvolutionForwardAlgorithm_v7

تعرض واجهة برمجة التطبيقات الجديدة هذه جميع الخوارزميات مرتبة حسب الأداء المتوقع

(باستخدام الاستدلال الداخلي). يتم إخراج هذه الخوارزميات بشكل مشابه لـ

cudnnFindConvolutionForwardAlgorithm.

cudnnGetConvolutionBackwardDataAlgorithm_v7

تعرض واجهة برمجة التطبيقات الجديدة هذه جميع الخوارزميات مرتبة حسب الأداء المتوقع

(باستخدام الاستدلال الداخلي). يتم إخراج هذه الخوارزميات بشكل مشابه لـ

cudnnFindConvolutionBackwardAlgorithm.

cudnnGetConvolutionBackwardFilterAlgorithm_v7

تعرض واجهة برمجة التطبيقات الجديدة هذه جميع الخوارزميات مرتبة حسب الأداء المتوقع

(باستخدام الاستدلال الداخلي). يتم إخراج هذه الخوارزميات بشكل مشابه لـ

cudnnFindConvolutionBackwardFilterAlgorithm.

CUDNN_REDUCE_TENSOR_MUL_NO_ZEROS

الدالة MUL_NO_ZEROS هي تقليل الضرب الذي يتجاهل الأصفار في ملف

البيانات.

CUDNN_OP_TENSOR_NOT

الدالة OP_TENSOR_NOT هي عملية أحادية تأخذ سالب

(ألفا * أ).

cudnnGetDropoutDescriptor

تسمح وظيفة cudnnGetDropoutDescriptor للتطبيقات بالتسرب

القيم.

حسنًا ، أفكر في بدء إصدار جديد يشبه "مدونة" CUDA 9 RC + cuDNN 7.0. لدي بنية TF "في يدي" تم تصحيحها معًا ولكنها CUDA 9RC و cuDNN 7.0 وأريد معرفة ما إذا كان أي شخص مهتمًا بتجربته. أحتاج أيضًا إلى التأكد من عدم وجود سبب غريب يمنعني من مشاركته. هناك تغييرات يجب إجراؤها على بعض المكتبات الأولية التي يستخدمها TensorFlow ولكنك ستبدأ في رؤية العلاقات العامة القادمة من NVIDIA في المستقبل القريب. تمكنت أنا والفريق من اختبار CUDA 8 + cuDNN 6 على Volta ثم CUDA 9RC + cuDNN 7 على Volta (V100) برمز FP32. أنا أقوم فقط ببناء Linux و Python 2.7 ولكن إذا كان كل / أي منكم مهتمًا ، أود أن أحاول إشراك المجتمع أكثر مما فعلنا مع cuDNN 6.0. قد لا يكون الأمر ممتعًا للغاية ولكني أريد أن أعرضه وكذلك أحاول أن أجعل هذا يشعر وكأننا في هذا معًا مقابل أنا أتقاضى المعلومات. ما زلت أرغب أيضًا في إنشاء قوائم بالميزات التي نعمل عليها ولكن لا نعد بها لـ cuDNN 7 (و 6.0). @ cancan101 شكرا لك على القائمة الكاملة.

tfboyd : سأكون ممتنًا للأوصاف المتعلقة بعمل CUDA 9.0RC + cuDNN 7.0. أنا أستخدم نظامًا غريبًا بنفسي (ubuntu 17.10 beta مع TF1.3 و CUDA 8.0 و cuDNN 6.0 gcc-4.8) ، وستكون الترقية إلى cuda 9 و cudnn 7 أمرًا رائعًا.

سأرى ما يمكنني فعله للحصول على ما تحتاجه لبناء نفسك و

الثنائية. أشار قائد فريق الأداء إلى أنه يمكنني محاولة تحقيق ذلك

حتى نكون أكثر شفافية وآمل أن نحظى بمزيد من المرح كمجتمع.

الحصول على التصحيح وكيفية بنائه ليس صعبًا للغاية ولكنه قليل

أصعب. سيكون أيضًا غير رسمي للغاية حيث ليس لدي الوقت لإدارة ملف

الفرع والرقعة يمكن أن تتعفن قليلاً (لا تنطبق بشكل نظيف) بسرعة كبيرة. ال

تم استخدام التصحيح للتأكد من أن جميع المشاركين موافقون على التغييرات في

عامة وأتوقع أن يبدأ ظهور العلاقات العامة الفردية.

يوم الجمعة ، 11 أغسطس ، 2017 الساعة 5:22 صباحًا ، Erlend Aune [email protected]

كتب:

tfboyd https://github.com/tfboyd : سأكون ممتنًا للأوصاف

على عمل CUDA 9.0RC + cuDNN 7.0. أنا بنفسي أستخدم نظامًا غريبًا (ubuntu

17.10 بيتا مع TF1.3 و CUDA 8.0 و cuDNN 6.0 gcc-4.8) ، والترقية إلى

cuda 9 و cudnn 7 سيكونان في الواقع لطيفين compilerwise.-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321798364 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesj4WRkFKNX-Nt2oKtvp0oyQVBtM5ks5sXEdqgaJpZM4OuRL7

.

tfboyd : أنا مهتم ، كيف

tfboyd سأكون بالتأكيد مهتمًا جدًا أيضًا. شكرا!

أحاول معرفة ذلك هذا الأسبوع. غالبًا ما تكون الخدمات اللوجستية أصعب مني

فكر في.

في 12 آب (أغسطس) 2017 الساعة 10:18 صباحًا ، كتب "Tanmay Bakshi" [email protected] :

tfboyd https://github.com/tfboy ، سأكون بالتأكيد مهتمًا جدًا

حسنا. شكرا!-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321994065 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesjO42Rl1WCyW0KR22KgbydKh1O4Zks5sXd6AgaJpZM4OuRL7

.

تعليمات وثنائي للعب به إذا كنت تحب Python 2.7. سأغلق هذا لأنني سأحدّث المشكلة التي أنشأتها لتتبع الجهد المبذول. تضمين التغريدة

لقد حاولت للتو تثبيت tensorflow-gpu-1.3.0 المُجمَّع مسبقًا لـ Python 3.6 على Windows x64 وقدمت مكتبة cuDNN الإصدار 7.0 مع Cuda 8.0 وعلى الأقل بالنسبة لي ، يبدو أن كل شيء يعمل. لا أرى أي استثناء أو مشاكل.

هل هذا متوقع؟ هل cuDNN 7.0 متوافق مع الإصدارات السابقة لـ cuDNN 6.0؟ قد يؤدي هذا إلى أي مشاكل؟

apacha أنا مندهش قليلاً من

فيما يتعلق بالتوافق العكسي ناقص TensorFlow التي يتم تجميعها للبحث عن إصدار معين. لا اعرف.

أخيرًا ، إنها ليست مشكلة كبيرة. تم اعتماد / دمج cuDNN 7 PRs تقريبًا ومن المرجح أن ينتقل الثنائي المترجم مسبقًا إلى cuDNN 7 اعتبارًا من 1.5.

تحديث على التقدم إلى CUDA 9RC و cuDNN 7

- تمت الموافقة تقريبًا على PRs من NVIDIA

- تمت الموافقة على تغيير EIGEN ودمجه

- بدأ اختبار FP16 بجدية على V100 (فولتا)

tfboyd فقط من أجل الاكتمال: كنت أستخدم cuDNN 5 سابقًا وبما أنني اضطررت إلى التحديث من أجل tensorflow 1.3 ، فقد كنت أتنقل فقط إلى الإصدار 7 من cuDNN لإعطائه لقطة. لقد حذفت صراحةً cudnn64_5.dll ولا يوجد cudnn64_6.dll في مسار تثبيت CUDA الخاص بي. ربما يكون سحر Windows. :-P

على الرغم من ملاحظة شيء واحد: ما زلت أستخدم CUDA 8.0 ، وليس 9.0.

apacha قد يكون سحر النوافذ. لم أرغب في إصدار الأحكام لأنه لم يكن لدي أي فكرة. أعتقد أن سحر windows ممكن لأن مكالمات cuDNN لا ينبغي أن تتغير وبالتالي يبدو أن التوافق مع الإصدارات السابقة محتمل. بالنسبة إلى إصدارات Linux ، يبحث TensorFlow عن ملفات محددة (أو هذا ما يبدو عليه عندما أحصل على أخطاء) وهو غير سعيد للغاية إذا لم يجد cudnnblahblah.6.so. شكرا على التحديث والتفاصيل.

هل هناك فرع / علامة كل ما يمكننا التحقق منه وتجربته؟

بدأت عملية تثبيت جديدة تمامًا ، Ubuntu 17 ... ثم فرض مجلس التعاون الخليجي الجديد CUDA 9 ، أرى أن CuDNN الذي يتناسب مع هو 7 ... ترى إلى أين أتجه.

يمكنني بالتأكيد اختراق الإعداد الخاص بي في العديد من الأماكن (والبدء من نقطة الصفر مرة أخرى باستخدام Ubuntu 16) فقط أنا قريب جدًا ، ويقال إن الإصلاح قريب ... لماذا أقوم بقفزة كبيرة في الماضي إذا كان بإمكاني القيام بذلك قفزة صغيرة في المستقبل!

تمت الموافقة على PRs تقريبًا. هم في المراجعة. أظن زوجين أكثر

أسابيع على الأكثر ، ولكن قد تستغرق هذه المراجعات وقتًا. أعتقد أن هذه كلها

معهم. يمكن أن يكون هناك متطرف أو تغيير للحصول على تغيير EIGEN

كودا 9. لم أعدهم شخصيًا. يقتربون كل يوم.

https://github.com/tensorflow/tensorflow/pull/12504

https://github.com/tensorflow/tensorflow/pull/12503

https://github.com/tensorflow/tensorflow/pull/12502

يوم الثلاثاء ، 12 سبتمبر 2017 الساعة 7:49 مساءً ، Remi Morin [email protected]

كتب:

هل هناك فرع / علامة كل ما يمكننا التحقق منه وتجربته؟

بدأت عملية تثبيت جديدة تمامًا ، Ubuntu 17 ... ثم فرض مجلس التعاون الخليجي الجديد CUDA 9 ،

أرى أن CuDNN الذي يتناسب مع هو 7 ... ترى إلى أين أتجه.

يمكنني بالتأكيد اختراق الإعداد الخاص بي في العديد من الأماكن (وبدء تشغيله من نقطة الصفر

مرة أخرى مع Ubuntu 16) أنا قريب جدًا ، يُقال أن الإصلاح قريب ... لماذا

قم بقفزة كبيرة في الماضي إذا كان بإمكاني القيام بقفزة صغيرة في المستقبل!-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-329041739 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesrpX6TSN6fVESEsql3QNtjgo-LM9ks5sh0KqgaJpZM4OuRL7

.

tfboyd هل ما زالت هذه مشكلة؟ أدركت أنه تم إصدار cuda 9.0 اليوم فقط.

تم إصدار cuda 9.0 ، لا يمكنني العثور على ملف تثبيت cuda 8.0 ...

الرجاء ترقية Tensorflow ...

تم إصدار cuda 9.0 ، لا يمكنني العثور على ملف تثبيت cuda 8.0 ...

tomasjo شكرا!

إذن ، باتباع tfboyd للموافقة على العلاقات العامة التي ذكرها ، هل سيكون tensorflow 1.3 متوافقًا الآن مع CUDA 9 و cuDNN 7؟ هل قام أي شخص في أي مكان بتثبيت هذا بنجاح؟

voxmenthe لقد حاولت للتو تثبيت tf1.3 مع CUDA 9.0 و cuDNN7. تلقيت الخطأ المتعلق بهذه المشكلة رقم 12489

تحرير: في الأساس ، لا أعرف كيف. لكن بالانتقال إلى الفرع الرئيسي (الذي لم يكن مثبتًا لي في البداية) دون أي تغيير آخر ، تمكنت من تثبيته. على الرغم من أنني الآن عندما أحاول استيراد tensorflow ، فإنه يقول إنه يفتقد وحدة النظام الأساسي.

هل هناك أي مؤشر على مدى قرب العلاقات العامة المرتبطة بها؟ لقد قمت بتثبيت cuDNN 7 ثم أدركت أنه يتسبب في حدوث مشكلات - يمكنني الرجوع إلى الإصدار 6 ولكنني قد أنتظر إذا كان قريبًا من الحل ...

يبدو أن PRs تمت الموافقة عليها. لم أدير البناء بنفسي في غضون أيام قليلة. ضع في اعتبارك أن 1.3 لن يكون لديه هذه التغييرات لأن ذلك كان منذ فترة. 1.4 سيكون لها التغييرات. آمل أن أتمكن هذا الأسبوع من تنزيل أحدث الإصدارات والقيام ببنية جديدة. أظن أن شخصًا ما سيفعل ذلك جيدًا قبل أن يتاح لي الوقت.

هل من المحتمل أن يقوم أي شخص أذكياء منكم بعمل برنامج تعليمي لـ tf 1.3 أو 1.4 باستخدام CUDA v9.0 ، cudnn 7.0 لـ Win 10 x64؟ لقد حاولت تثبيت (Anaconda) ولكن استمر في الحصول على الخطأ '_pywrap_tensorflow_internal' ولقد تحققت بالفعل من إضافة msvcp140.dll إلى المسار الخاص بي ..

@ devilsnare007 : أعتقد أن أفضل الفرص هي باتباع https://github.com/philferriere/dlwin. ببساطة استبدل الإصدارات المدرجة بالإصدارات الحالية. لاحظ أن TF 1.4 لم يتم إصدارها حتى. لكن يجب أن يعمل فريق العمل 1.3 بشكل جيد مع التعليمات المقدمة. بمجرد ترقية كل شيء وإصدار TF 1.4 ، سنقوم بتحديث هذا البرنامج التعليمي.

هل سيتم دعم cuDNN 7.0 عند إصدار TF 1.4؟

تضمين التغريدة

في البداية (منذ يومين) تمكنت من تجميع CUDA 9 (إصدار الإصدار) باستخدام cuDNN 7.0 بدون تغييرات خاصة وقمت بإجراء بعض اختبارات tf_cnn_benchmarks.py على GTX 1080. كل شيء يبدو جيدًا. TF 1.4 الذي يجب أن يكون RC هذا الأسبوع سيحتوي على ثنائيات CUDA 8 و cuDNN 6 ولكنه سيجمع أيضًا بشكل جيد مع CUDA 9 و cuDNN 7. والهدف هو أن يكون TF 1.5 لديك CUDA 9 و cuDNN 7 في الثنائي. يمنح هذا الأشخاص الوقت لترقية مكتبات الأنظمة الخاصة بهم والمزيد من الوقت للاختبار. إذا كنت تقوم بتشغيل Voltas فلا تتردد في بدء موضوع آخر وسوف أقوم بتحديثه وسوف يتقدم في FP16 في الوقت الحقيقي.

tfboyd من الرائع أن نسمع أن TF 1.4 يجمع مع cuDNN 7! إذا شعرت في وقت ما أنك مستعد لإنشاء دليل تثبيت ، فسيكون ذلك خدمة عامة رائعة لمجتمع DL.

لا توجد مشكلة ، يجب أن يكون ذلك سهلاً بدرجة كافية ويسعدني أن أحاول ملء ذلك

الفارق.

في يوم الإثنين 9 أكتوبر 2017 الساعة 9:42 صباحًا ، كتب Jeff [email protected] :

tfboyd https://github.com/tfboyd عظيم أن نسمع أن TF 1.4 يجمع

مع cuDNN 7! إذا كنت تشعر في مرحلة ما بإنشاء دليل تثبيت ، فقم بذلك

ستكون خدمة عامة رائعة لمجتمع DL.-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335212652 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesp7d2aT8gsGOWb6YjHH_CnpKXUIPks5sqkztgaJpZM4OuRL7

.

هل هناك احتمال أن يكون لديك whl يعمل مع CUDA 9 و cuDNN 7.0؟

شكرا!

سأقوم بنشر خاصتي (التي لن تكون على الأرجح 1.4 ولكن بعضها قريب من التطابق

وأقوم بتضمين التجزئة في الاسم) عندما أقوم بإنشائها للاختبار ولكنها ستفعل

كن أوبونتو 16.04 (نسيت ما هو إصدار مجلس التعاون الخليجي) ، لينكس ، بايثون 2.7 فقط لمعلوماتك.

وأنا لا أفترض حقًا أن أشارك تلك البنيات لأنها يمكن أن تكون كذلك

مربكًا للناس وسأؤكد على كل ما تعرفه أنني قمت بتضمين البعض

باب خلفي مجنون. على الرغم من أن إضافة بعض الرموز السرية تبدو وكأنها تتطلب الكثير من العمل

إلي.

أعتقد أن إنشاءات gpu الليلية تكاد تكون حية (أنا متأكد من أنها

حدث دائمًا كان عليك فقط العثور عليها) مما يعني أنه بعد 1.4

ستنتقل الإصدارات الليلية إلى CUDA 9 + cuDNN 7 بسرعة كبيرة.

في يوم الإثنين 9 أكتوبر 2017 الساعة 11:41 صباحًا ، كتب alexirae [email protected] :

هل هناك احتمال أن يكون لديك whl يعمل مع CUDA 9 و cuDNN 7.0؟

شكرا!

-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335249979 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZeskJ5LXJwFcRpm-sKZ9QORoltrHOEks5sqmj1gaJpZM4OuRL7

.

tfboyd شكرا

tfboyd هل يدعم 14.rc TF دعم CuDNN 7 و CUDA 9؟

يتم تضمينه إذا كنت تبني من المصدر. اريد تغيير الافتراضي

الثنائيات التي تتطلب مني إجراء بعض اختبارات الانحدار على K80s على AWS إلى

تأكد من أن كل شيء يبدو جيدًا وكذلك إنشاء البنيات. نحن

واجهت مشكلة على الفور لأن برنامج تشغيل NVIDIA يحتاج إلى أداء منخفض

على Kokoro يعمل في Google Cloud بنسبة 30٪. ليس هناك ما هو مستقيم

إلى الأمام ، ولكن CUDA 9 و cuDNN 7 موجودان في 1.4 المصدر ولديهما كما هو متوقع في

اختبارات محدودة للغاية على باسكال بالنسبة لي.

يوم الخميس ، 12 أكتوبر 2017 ، الساعة 2:40 صباحًا ، Konstantin [email protected]

كتب:

tfboyd https://github.com/tfboyd هل يدعم 14.rc TF دعم CuDNN 7 و

كودا 9؟-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336075883 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesq03dvnXWd0GLXODBTNCWExlZGPnks5srd6pgaJpZM4OuRL7

.

هل هناك احتمال أن يكون لديك whl يعمل مع CUDA 9 و cuDNN 7.0 و python 3.5؟

بعد الانتهاء من TF 1.4 ، ستنتقل الإنشاءات الليلية إلى CUDA 9 +

cuDNN 7 على افتراض عدم وجود مشاكل. البنيات التي صنعتها وأشاركها من أجل المتعة هي

دائمًا python 2.7 لأن هذا هو الإعداد الافتراضي في أنظمة الاختبار الخاصة بي.

يوم الاثنين ، 16 أكتوبر ، 2017 الساعة 6:59 صباحًا ، Diego Stalder [email protected]

كتب:

هل هناك احتمال أن يكون لديك whl يعمل مع CUDA 9 و cuDNN 7.0 و

بيثون 3.5؟-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336894073 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesqgclWqET4OufQHV3FAD4XxgnZiKks5ss2E6gaJpZM4OuRL7

.

أي تاريخ إطلاق متوقع؟

كل أولئك الذين يقضمون بصوت عالي قليلًا ، ما عليك سوى إنشاء # Master من المصدر. ليس الأمر صعبًا جدًا (مجرد مضيعة للوقت) ، فأنت تحصل على أحدث CUDA / cuDNN ، _ و_ تحسينات إضافية عبر تثبيت نقطة / whl (على سبيل المثال ، راجع تحسينات وحدة المعالجة المركزية في هذا tut ). بالإضافة إلى ذلك ، في المرة القادمة التي يتم فيها ترقية CUDA / cuDNN ، يمكنك إعادة البناء مرة أخرى دون الحاجة إلى الانتظار.

بناء من المصادر ، يعمل TF1.4 مع cuda 9.0 و cuDNN v7.0.3 و python3.5

هل يمكنني البناء من المصدر على منصة win10؟

أود أن يعمل TF على cuda 9.0 و cuDNN v7 و python3. 6 ، و win10

بناء من المصادر ، يعمل TF1.4 مع cuda 9.0 و cuDNN v7.0.3 و python2.7 أيضًا.

affromero هل كانت لديك أية مشكلات مع jsoncpp بالصدفة؟

لقد أجريت اختبارًا لـ tf_cnn_benchmarks على AWS بناء من فرع TF 1.4RC0 مع CUDA 9 / cuDNN 7 وكانت النتائج متساوية أو أسرع قليلاً من CUDA 8 + cuDNN 6.

تحرير: إزالة الإشارة إلى أنني لم أكن أعالج تعليق المدققين. :-)

elipeters

عندما نقول البناء فإننا نعني البناء من المصدر وليس تثبيت ملف العجلة. تم تجميع العجلة بالفعل ودعم 1.4 ثنائيات CUDA 8 + cuDNN 6. للحصول على CUDA 9 ، ستحتاج إلى البناء من المصدر. لم أفعل أبدا بناء النوافذ. بمجرد 1.4 سفينة ، سيقوم الفريق بتحويل الإنشاءات الليلية إلى CUDA 9.

هناك الإصدار الثاني المرشح (rc1) لـ 1.4 خارج كعجلة مترجمة مسبقًا (https://pypi.python.org/pypi/tensorflow). هل اختبر أي شخص ذلك باستخدام CUDA 9 حتى الآن؟

حاولت ، ولكن ليس مع cuda 9.0.

ساحاول مرة اخرى.

1.4 هو CUDA 8 + cuDNN 6 ولن يعمل هذا مع CUDA 9 ، وسيتعين عليك التحويل من المصدر

بمجرد إصدار 1.4 ، سنعمل على تحويل الإصدارات الليلية إلى CUDA 9 ومن ثم سيكون 1.5 على الأرجح CUDA 9.

أعلم أن CUDA 9 يعمل بشكل جيد عند إنشاء 1.4 من المصدر (ubuntu 16.04 / python 2) لأنني كنت أقوم بإجراء اختبارات على AWS في نهاية الأسبوع الماضي.

لدي وصفة حديثة للبناء من المصدر هنا (يرجى نشر رابط إلى عجلة CUDA 9.0 هناك أيضًا بمجرد إنشائها)

أنت أفضل ياروسلاف.

يوم الأربعاء 25 أكتوبر 2017 الساعة 8:11 صباحًا ، ياروسلاف بولاتوف إخطارات @github.com

كتب:

لدي وصفة حديثة للبناء من المصدر هنا

https://github.com/yaroslavvb/tensorflow-community-wheels (يرجى النشر

رابط إلى عجلة CUDA 9.0 الخاصة بك هناك أيضًا بمجرد إنشائها)-

أنت تتلقى هذا لأنه تم ذكرك.

قم بالرد على هذا البريد الإلكتروني مباشرة ، وقم بعرضه على GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-339361959 ،

أو كتم الخيط

https://github.com/notifications/unsubscribe-auth/AWZesmRwb0UmLWxzANWCq5RrT6teYtr5ks5sv0-IgaJpZM4OuRL7

.

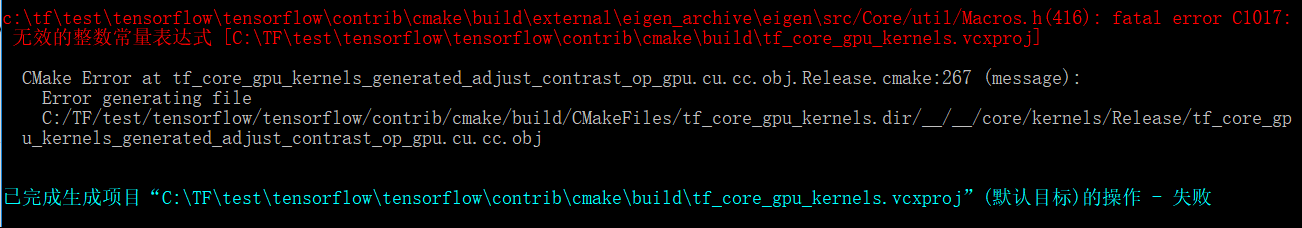

مرحبًا , أحاول إنشاء tensorflow gpu بواسطة win10 env , ثم قابلت أيضًا مثل هذه المشكلة , هل يمكن لأي شخص مساعدتي , شكرًا أولاً.

بيئتي :

win10 + gtx 1080ti + cuda 9.0 + cuDNN 7 + مهنة الاستوديو المرئي 2015 + CMake 3.6.3 + Python 3.5.4

عندما أقوم بالتبديل إلى tensorflow r1.4 , والبناء بواسطة cmake في بيئة win10 ,

"CUSTOMBUILD: خطأ داخلي: فشل التأكيد في:" C: /dvs/p4/build/sw/rel/gpu_drv/r384/r384_00/drivers/compiler/edg/EDG_4.12/src/lookup.c "، السطر 2652 [ C: \ TF \ tensorflow \ tensorflow \ مساهمة \ cmake \ بناء \ tf_core_gpu_kernels.vcxproj]

تم اكتشاف خطأ فادح في تجميع "C: / المستخدمون / ADMINI~1/AppData/Local/Temp/tmpxft_00000c94_00000000-8_adjust_contrast_op_gpu.cu.cpp4.ii".

تجميع إحباط.

Adjust_contrast_op_gpu.cu.cc

CUSTOMBUILD: خطأ nvcc: "cudafe ++" مات بالحالة 0xC0000409 [C: \ TF \ tensorflow \ tensorflow \ Contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

CMake خطأ في tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release. cmake: 267 (رسالة):

خطأ في إنشاء الملف

C: /TF/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir / __ / __ / core / kernels / Release / tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj`

تبدو المشكلة أعلاه وكأنها مشكلة cuda compolie نفسها , ولكن عندما أقوم بتبديل إصدار tensorflow إلى r1.3 ,

`c: \ tftest \ tensorflow \ tensorflow \ Contrib \ cmake \ build \ external \ eigen_archive \ eigen \ src / Core / util / Macros.h (416): خطأ فادح C1017:

无效 的 整数 常量 表达式 [C: \ TFtest \ tensorflow \ tensorflow \ Contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

CMake خطأ في tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release. cmake: 267 (رسالة):

خطأ في إنشاء الملف

C: /TF/test/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir / __ / __ / core / kernels / Release / tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

يبدو أن الملف adjustment_contrast_op_gpu.cu.cc لديه بعض المشاكل , لكن لا يمكنني العثور على أي خطأ منه.

مثل هذه المشكلات المذكورة أعلاه تزعجني بضعة أيام أتمنى أن يساعدني شخص ما في هذه المحاولة والنجاح , ونتوقع بشدة ترقية Google لدعم tensorflow cuda 9.0 و cudnn 7 في بيئة win10.

هل قام أي شخص بإصدار whl لـ TensorFlow باستخدام CUDA 9 و cuDNN 7.0؟

vellamike أعلم أن سؤالك عام ، لكن فريق TF سيكون لديه CUDA 9 في الثنائيات مع 1.5 يجب أن يهبط في Q4. في الوقت الحالي ، عليك أن تبني من المصدر.

أحاول بناء 1.4 باستخدام CUDA 9 و cuDNN 7 في mac 10.13 high sierra. وأظل الحصول على هذا الخطأ

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: output 'tensorflow/core/kernels/_objs/depthwise_conv_op_gpu/tensorflow/core/kernels/depthwise_conv_op_gpu.cu.pic.o' was not created.

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: not all outputs were created or valid.

Target //tensorflow/tools/pip_package:build_pip_package failed to build

أي حل لهذا؟

ربما يرتبط smitshilu https://github.com/tensorflow/tensorflow/issues/2143

لماذا لا يزال 1.4 لا يحتوي على CUDA 9 في الثنائيات؟ تم إصدار هذا الإصدار منذ فترة طويلة وللاستخدام مع V100 ، يلزم بناء من المصدر وهو ليس سلسًا وسريعًا لمتابعة عدد من المشكلات التي تم الإبلاغ عنها.

ViktorM ما هي المشكلات التي

كان 26-SEP-2017 هو GA لـ CUDA 9. إذا أطلقنا ثنائيات CUDA 9 + cuDNN 7 في الربع الرابع ، أعتقد أن هذا سيكون أسرع ما قمنا بترقية cuDNN. لم أكن هنا لمدة 8.5 إلى 9 لذلك ليس لدي أي فكرة. أود منا أن نذهب أسرع قليلاً ، لكن هذا يعني أيضًا أن أي شخص لديه إعداد CUDA 8 عليه الترقية ليس فقط إلى CUDA 9 ولكنهم يحتاجون أيضًا إلى ترقية برنامج تشغيل أجهزتهم إلى 384.x ، والذي يمكنني القول أنه ليس شيئًا إنتاجيًا للناس خذ على محمل الجد.

من الناحية المثالية ، سيكون لدينا عدد لا نهائي (أو عدد قليل فقط ولكن المصفوفة تنفجر بسرعة) ، ولكن هذه مشكلة أخرى قد تستغرق وقتًا طويلاً لشرحها وأشك في أن الكثير من الناس يهتمون بها.

yaroslavvb بصراحة شديدة ، فإننا نعمل على حل بعض مشكلات FP16. يوجد مسار في tf_cnn_benchmarks لـ FP16 ويتم التركيز على ResNet50 أولاً ونحن نعمل على التحجيم التلقائي لـ FP16 أيضًا. يمكنك تجربتها إذا كنت مهتمًا ولكننا نعمل بنشاط من خلال بعض المشاكل. الناس عليه وهو يأخذ الوقت فقط. لدينا أخيرًا DGX-1s في المنزل حتى نتمكن أيضًا من اللعب بنفس الحاويات ومحاولة تتبع الأداء على تلك المنصة المحددة للمضي قدمًا.

حسنًا ، سأقوم بتثبيت Ubuntu 17.10 وأردت فقط تجربة أحدث الأشياء من أجل المتعة.

قبل أن أفعل ، أردت فقط أن أعرف هل جرب أي شخص بناء الأكوام أدناه من المصدر وحصل على أي حظ؟

-> Ubuntu 17.10 ، CUDA 9.0 ، cuDNN 7.0 ، TF Master

-> Ubuntu 17.10 ، CUDA 8.0 ، cnDNN 6.1 ، TF 1.4

أواجه نفس المشكلة مثل @ xsr-ai ، على وجه التحديد باستخدام Python 3.6.3 ، VS 2017 ، CUDA 9 ، cuDNN 7.

@ aluo-x هل تقصد أنك جربت Windows 10؟ بافتراض أنك قلت VS 2017.

نعم هذا صحيح. هذا هو الخطأ المحدد:

CustomBuild:

Building NVCC (Device) object CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

CMake Error at tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release.cmake:222 (message):

Error generating

C:/optimae/tensorflow-1.4.0/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

C:\Program Files (x86)\Microsoft Visual Studio\2017\BuildTools\Common7\IDE\VC\VCTargets\Microsoft.CppCommon.targets(171,5): error MSB6006: "cmd.exe" exited with code 1. [C:\optimae\tensorflow-1.4.0\

tensorflow\contrib\cmake\build\tf_core_gpu_kernels.vcxproj]

@ aluo-x هل استخدمت أحدث إصدار من c-make؟ أي الإفراج عن المرشح أو الإفراج المستقر؟

باستخدام cmake 3.9.5 و swig 3.0.12 و CUDA 9.0.176 و cuDNN 7.0.3. VS 2017 19.11.25547.

@ aluo-x حتى لم يكن لدي الكثير من الحظ مع c-make. لكن هل يمكنك تجربة البناء باستخدام Bazel؟

smitshilu إذا لم أكن مخطئًا ، https://github.com/pytorch/pytorch/issues/2692

حاولت تطبيق نفس الحل ، وهو إزالة جميع ___ محاذاة __ (sizeof (T)) _ من الملفات الإشكالية:

_tensorflow / core / kernels / concat_lib_gpu_impl.cu.cc_

_tensorflow / core / kernels / deepwise_conv_op_gpu.cu.cc_

_tensorflow / core / kernels / split_lib_gpu.cu.cc_

لست متأكدًا مما إذا كان هذا يسبب أي مشاكل ، ولكن يبدو أنه يعمل بشكل جيد حتى الآن. ومما أفهمه ، سيستخدم وقت التشغيل دائمًا محاذاة ثابتة لـ 16 للذاكرة المشتركة.

للأشخاص المهتمين ، تم تحميل عجلات CUDA 9. لا حاجة لبناء نفسك! https://github.com/mind/wheels/releases/tag/tf1.4-gpu-cuda9

Ubuntu 17.10 و CUDA 9 و CuDNN 7 و Python 3.6 و bazel 0.7.0 + TF من المصدر (رئيسي).

اتبع التعليمات الواردة في هذه الإجابة لتشغيل CUDA وتشغيله:

https://askubuntu.com/questions/967332/how-can-i-install-cuda-9-on-ubuntu-17-10

ملاحظة ، قد ترغب في استخدام هذه الأوامر بدلاً من ذلك لإصدار 64 بت:

sudo ln -s /usr/bin/gcc-6 /usr/local/cuda-9.0/bin/gcc

sudo ln -s /usr/bin/g++-6 /usr/local/cuda-9.0/bin/g++

sudo ./cuda_9.0.176_384.81_linux-run --override

لتثبيت Tensorflow ستحتاج

- قبل تجميع TF: تكوين متغيرات المسار بشكل صحيح (المسارات من صفحة NVIDIA لم تعمل معي):

export PATH=/usr/local/cuda-9.0/bin:${PATH}

export LD_LIBRARY_PATH=${LD_LIBRARY_PATH}:/usr/local/cuda-9.0/lib64

- قبل التحويل البرمجي: قم بتكوين bazel لاستخدام إصدار دول مجلس التعاون الخليجي نفسه أثناء تثبيت CUDA:

sudo update-alternatives --remove-all g++

sudo update-alternatives --remove-all gcc

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-6 10

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-6 10

- أثناء اتباع تعليمات TF بمجرد وصولك إلى ملاحظة خطوة bazel build ، ستحتاج إلى علامة إضافية لتجميعها مع إصدار مجلس التعاون الخليجي الأعلى من 4. *:

bazel build --config=opt --config=cuda --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0" //tensorflow/tools/pip_package:build_pip_package

alexbrad لقد واجهت نفس مشكلة إنشاء وحدة معالجة الرسومات لنظام التشغيل Mac مع CUDA 9 ، cuDNN 7. لقد نجح هذا الحل أيضًا بالنسبة لي ولم أواجه أي مشكلات باستخدام TF حتى الآن.

تغييرات المصدر والعجلة: https://github.com/nathanielatom/tensorflow/releases/tag/v1.4.0-mac

تم تثبيت واختبار Ubuntu 16.04 و TensorFlow 1.4 مع CUDA 9.0 و cuDNN 7.0.3:

قم بتثبيت Tensorflow 1.4 من المصدر

cd ~/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

- التكوين لإصدار CUDA: 9.0

- التكوين لإصدار cuDNN: 7.0.3

- احصل على إمكانية الحوسبة الخاصة بك من https://developer.nvidia.com/cuda-gpus

- لقد قمت بتعيين هذا على 6.1 لأن لدي GeForce GTX 1070

- تكوين الخيارات الأخرى حسب الاقتضاء

./configure

تركيب بازل

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

بناء TensorFlow

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

قد يكون اسم ملف عجلة tensorflow أعلاه مختلفًا

فقط ls /tmp/tensorflow_pkg للتحقق

خطوات التثبيت لنظام التشغيل Mac 10.13 و CUDA 9 و Tensorflow 1.4 https://gist.github.com/smitshilu/53cf9ff0fd6cdb64cca69a7e2827ed0f

هل يمكن لأحد أن يخبرني ، كيف يمكنني إنشاء حزمة tensorflow whl من مصادر Windows في Linux (Ubuntu 16.04) مع bazel؟ كان من الممكن بالنسبة للإصدار 1.2 إذا كنت على حق. شكرا.

ValeryPiashchynski يمكنك اتباع هذه الخطوات https://www.tensorflow.org/install/install_sources

smitshilu شكرا لك على إجابتك. يمكنني بناء حزمة عجلة في Ubuntu باتباع هذه الخطوات وكلها تعمل بشكل جيد في Ubuntu. لكن لا يمكنني تثبيت حزمة whl في نظام التشغيل Windows (هناك خطأ: ليست عجلة دعم). لذا فإن سؤالي هو كيف يمكنني إنشاء حزمة في Ubuntu والتي يمكنني تثبيتها بعد ذلك في Windows؟

تضمين التغريدة

(إخراجها كما التعليقات أدناه تشير إلى خلاف ذلك)

يجب أن يكون البناء المتقاطع على Ubuntu for Windows ممكنًا يومًا ما من خلال clang. من المحتمل أن يتطلب الكثير من الإصلاحات ، نظرًا لأن ثنائيات Windows مبنية حاليًا باستخدام MSVC. سألت نفس السؤال بشكل أساسي عندما تحدثت شخصيًا إلى gunan يوم الاثنين الماضي. هل ينبغي تحويل هذا إلى إصدار خاص به ، لأنه ليس له علاقة مباشرة بـ CUDA؟

التحويل المتقاطع ممكن مع bazel ولكن لست متأكدًا من كيفية القيام بذلك على Tensorflow. كمرجع

https://github.com/bazelbuild/bazel/wiki/Building-with-a-custom-toolchain

https://github.com/bazelbuild/bazel/issues/1353

هل يعرف أي شخص ما إذا كان إصدار tensorflow 1.5 الليلي المنشور هنا (يبني win10) لديه دعم CUDA9 + CuDNN7؟

https://pypi.python.org/pypi/tf-nightly-gpu/1.5.0.dev20171115

في ملاحظة جانبية ، من غير المسؤول تمامًا إغلاق هذه التذكرة وكذلك # 14126 لمجرد أنك تقول "سيتم إصدارها مع TF 1.5". MXNET 0.12 لديها بالفعل CUDA9 FP16 في الإنتاج. يحتاج Tensorflow و CNTK إلى التعجيل. انها ليست مفيدة فقط لفولتا.

ليس بعد ، نحن نعمل على ترقية البنية التحتية للبناء لـ CUDA 9.

نحن نهدف إلى الحصول على حزم Pip مع CUDA 9 قبل نهاية هذا الأسبوع.

لدي جهازي كمبيوتر ، وبالأمس قمت بتثبيت 1080ti وتثبيت كل شيء (cuda8 و cudnn6) برنامج تشغيل رسومات جديد ، استوديو مرئي 2015

أقارن زمن حقبة 1080ti مقابل 980ti

وأرى 1080ti تشغيل كل فترة في 22 دقيقة ولكن 980ti يتم تشغيلها في 13 دقيقة !!! (الدفعة = 60 مقابل 1080 مقابل الدفعة = 20 مقابل 980 تي)

لماذا 1080ti العمل أبطأ من 980ti !!!! وكيف اتفقد ما هو الخطأ ؟!

ما هو وقت التشغيل إذا كنت تستخدم 20 دفعة لـ 1080Ti؟

gunan ، أتساءل فقط عما إذا كان هناك ETA جديد لهذا؟

تضمين التغريدة

في 1080 تي ب 20 دفعة = 26 دقيقة

ومع 60 دفعة = 19 دقيقة

في 980 جرام × دفعة 20 = 14 دقيقة !!!!

أنا أستخدم windows ، قم بتثبيت الإصدار الأخير من برنامج التشغيل باستخدام cuda 8 و cudnn 6

كيف يمكنني معرفة سبب تشغيله بشكل أبطأ من 980؟

nasergh هل لديك GTX 1080ti و 980ti في SLI؟

تضمين التغريدة

لا

جهازي كمبيوتر مختلفين!

كلاهما عبارة عن قرص صلب cori7 و 1 تيرابايت وأقوم بتحميل صورة بيانات من 1 تيرابايت ساتا HDD

ولكن في عام 980 لدي نوافذ على القرص الصلب SSD

لقد جربت إصدارًا مختلفًا من برنامج التشغيل ، آخر شيء أتحقق منه 388.13 تم تنزيله من موقع Asus على الويب باستخدام CUDA 8 و cudnn 6

لا أعرف أي واحد من هذا هو السبب

1- النوافذ! ربما يعمل بشكل أفضل على نظام التشغيل Linux

2- سرعة HDD

3- 1080TI وهمية

4- CUDA و cudnn غير متوافقين مع 1080ti

5- وحدة المعالجة المركزية (CPU على كمبيوتر 1080TI أقوى من 980)

ماذا تقترح ؟

تضمين التغريدة

1) هل ذاكرة الوصول العشوائي هي نفسها؟ لو ذلك. لست متأكدًا مما إذا كان سيؤثر كثيرًا ولكن تحقق مما إذا كانت MHz من ذاكرة الوصول العشوائي هي نفسها أيضًا في كلا النظامين.

2) تحقق من استخدام GPU٪ عند التشغيل على 980ti و 1080ti. استخدم هذه الأداة إذا كنت تريد التحقق من استخدام GPU. https://docs.microsoft.com/en-us/sysinternals/downloads/process-explorer هناك أفضل منها ، لكن هذا ما جاء فوق رأسي.

3) إذا كنت ترغب في الحصول على أفضل أداء ، أقترح تثبيت Ubuntu16.04 كتمهيد مزدوج على نظام 1080ti الخاص بك واستخدام CUDA 9.0 و cuDNN 7.0

4) تستهلك النوافذ أيضًا الكثير من موارد النظام في حد ذاتها ، لذا فإن تشغيلها على SSD يمنحها بالتأكيد ميزة ، ولكن ليس بهذا الحجم كما هو موضح في سيناريو الاختبار الخاص بك.

ربما هي بنية اللوحة المختارة.

تم تكوين TF بشكل افتراضي لـ 3.0 و 3.5 و 5.2 ؛ بينما 1080TI هو 6.1 (باسكال) بينما 980 هو 5.2 (ماكسويل) وفقًا لـ https://en.wikipedia.org/wiki/CUDA#GPUs_supported.

ربما لا يكون الرجوع إلى الإصدار 3.0 أو 5.2 غير فعال على 1080TI ، بينما هو أصلي لـ 980؟

جرب الحوسبة بكلتا الإمكانيات 5.2 و 6.1 (راجع CMakeLists.txt l.232 و l.246)

De: nasergh [mailto: [email protected]]

Envoyé: mercredi 22 نوفمبر 2017 17:17

À: Tensorflow / Tensorflow

نسخة إلى: سيلفان بوغنو ؛ كتيب

الهدف: Re: [tensorflow / tensorflow] الترقية إلى CuDNN 7 و CUDA 9 (# 12052)

تضمين التغريدة

لا

جهازي كمبيوتر مختلفين!

كلاهما عبارة عن قرص صلب cori7 و 1 تيرابايت وأقوم بتحميل صورة بيانات من 1 تيرابايت ساتا HDD

ولكن في عام 980 لدي نوافذ على القرص الصلب SSD

لقد جربت إصدارًا مختلفًا من برنامج التشغيل ، آخر شيء أتحقق منه 388.13 تم تنزيله من موقع Asus على الويب باستخدام CUDA 8 و cudnn 6

لا أعرف أي واحد من هذا هو السبب

1- النوافذ! ربما يعمل بشكل أفضل على نظام التشغيل Linux

2- سرعة HDD

3- 1080TI وهمية

4- CUDA و cudnn غير متوافقين مع 1080ti

ماذا تقترح ؟

-

أنت تتلقى هذا لأنك مشترك في هذا الموضوع.

قم بالرد على هذه الرسالة الإلكترونية مباشرةً ، أو اعرضها على GitHub ، أو قم بكتم صوت الموضوع.

البيئة: cuda9.0 + cudnn7.0 + tf1.4 , وأنا أواجه خطأ عندما أقوم بتشغيل مثال "ptb" ، TypeError: __init __ () حصلت على وسيطة كلمة رئيسية غير متوقعة 'input_size' ، 'input_size' هي معلمة CudnnLSTM

بعد مشاهدة هذا الموضوع لأشهر سأجربه على Gentoo linux

لدي آسوس ستراكس 1080 تي آي

1- في ubunto يمكنني استخدام برنامج التشغيل في موقع ويب nvidia أو يجب علي التنزيل من asus (لأنني لا أرى برنامج التشغيل لنظام التشغيل Linux في موقع ASUS)

2- الإصدار الأخير على ما يرام أو يجب أن أتصل بـ 378.13 لأنني أرى في معظم التعليقات يقولون استخدام 378.13؟

شكرا

بالنسبة لأولئك الذين يستخدمون Windows ، قمت للتو بتحميل TF 1.4.0 المبني على CUDA 8.0.61.2 و cuDNN 7.0.4 و Python 3.6.3 مع دعم AVX على الريبو الخاص بي . نأمل أن يكون هذا كافيًا حتى يتم فرز CUDA 9 على Windows.

أحاول تثبيت CUDA9 و cudnn 7 على ubuntu 16.04 و python 3.6

لكني فاشل :(

أحاول كل شيء ، ابحث في كل مكان ولكن ما زلت أعطي نفس الخطأ "importError: libcublas.so.8.0 لا يمكن فتح ملف كائن مشترك: لا يوجد مثل هذا الملف أو الدليل

أعتقد أن موتر تريد تشغيل CUDA8

كيف يمكنني ان اقول له لاستخدام cuda9؟ !!!! إذا تم تشغيل الجواب من المصدر كيف بالضبط؟ لم أر موقعًا واضحًا جدًا حول الإنشاء من المصدر

شكرا

يجب عليك تثبيت tf من source @ nasergh

MustafaHosny اللهم امين

كيف يمكنني تثبيته من المصدر؟

أعلم أنه يمكنني تنزيل واحد من هذا

https://github.com/mind/wheels/releases

لكني لا أعرف تحميل أي واحد وكيفية تثبيته!؟

nasergh تحقق من ملف README الخاص بنا لمعرفة كيفية التثبيت. إذا كنت لا تمانع في تثبيت MKL ، فيمكنك القيام بذلك

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-37/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

إذا كنت لا تريد تثبيت MKL ، فيمكنك القيام بذلك

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-nomkl/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

سأستخدم هذه المشكلة باعتبارها مشكلة التتبع لدعم CUDA 9.

حاليًا ، هناك نوعان من الحاصرات:

1 - https://github.com/tensorflow/tensorflow/pull/14770

2 - على الويندوز ، يبدو أن لدينا خطأ في NVCC. يبدو أن بناء TF باستخدام CUDA9 يفشل مع تعطل المترجم. تساعد NVIDIA في التحقيق في هذا الأمر ، وبمجرد حصولنا على تحديث ، سنمضي قدمًا.

تضمين التغريدة

شكرا

1- MKL ما مدى تحسين السرعة؟

2- في الإصدار بدون MKL أحتاج إلى تثبيت MKL ؟!

بالنسبة إلى 1 ، راجع هذا - لاحظ أن العمليات الحسابية التي تتم على وحدة معالجة الرسومات لن تتسارع بشكل واضح.

لمدة 2 ، أنت لا تفعل ذلك. تأكد من تثبيت الإصدار الصحيح.

راجع للشغل ، هذا موضوع به العديد من المشتركين. إذا كانت لديك مشكلات مستقبلية مع عجلاتنا ، فالرجاء فتح مشكلة في الريبو الخاص بنا بدلاً من التعليق أدناه ، حتى لا نرسل بريدًا عشوائيًا إلى عدد كبير من الأشخاص.

Tweakmind : لا يمكنني تمرير هذا الجزء:

بناء TensorFlow

بناء bazel --config = opt --config = cuda // tensorflow / tools / pip_ package: build_pip_package --cxxopt = "- D_GLIBCXX_USE_CXX11_ABI = 0

bazel-bin / tensorflow / tools / pip_package / build_pip_package / tmp / tensorflow_pkg

تثبيت النقطة /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

يبدو أن السطر الأول غير مكتمل (لا توجد علامات اقتباس مزدوجة)؟ هل هذه الخطوط الثلاثة أم سطرين؟

goodmangu الرمز الصحيح ، على ما أعتقد ، هو:

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

علامات الاقتباس المزدوجة مفقودة من الأمر.

لقد تجاوزت هذا الجزء باستخدام البرنامج النصي هنا ، ولكن تم حظر بعض أخطاء برنامج التحويل البرمجي cuda في https://github.com/tensorflow/tensorflow/issues/15108

شكرا يا شباب. أقدر هذا. لقد نجحت في العمل في نفس اليوم باستخدام نظام Linux ثنائي الإنشاء ليلاً بدلاً من ذلك. انظر: https://github.com/tensorflow/tensorflow

تعمل الآن 3 GTX 1080 Tis مع Keras. رائع!

أمضيت اليومين الماضيين في محاولة إنشاء Tensorflow من المصدر (r1.4) لجهاز MacBook Pro الخاص بي باستخدام eGPU. سائق يعمل مع Cuda 8.0 و cuDNN 6.0 و Mac OSX Sierra 10.12. قريب جدًا من النهاية ، ولكن تم حظره بواسطة بعض أخطاء الإنشاء بعد 20 دقيقة. أي شخص لديه الحظ حتى الآن؟ أي حزمة مبنية بنجاح يمكنك مشاركتها؟ شكرا لك مقدما.

goodmangu هل يمكنك من فضلك تحديد أي "إصدار لينكس الثنائي الليلي" الذي تستخدمه؟

بالتأكيد ، هذا واحد: tf_nightly_gpu-1.head-cp27-none-linux_x86_64.whl

لا يزال لا يدعم Windows 10 لـ Cuda 9.0 + cuDNN 7.0؟ مجرد التحقق.

Tensorflow GPU 1.4.0

goodmangu لقد جربت هنا

@ eeilon79 يوجد خطأ في nvcc على النوافذ يمنعنا من بناء ثنائيات. نحصل على مساعدة من nvidia لإصلاح هذه المشكلات.

هل هناك أي تحديث لـ CUDA 9 في Tensorflow Nightly Version (1.5-dev) ضمن حزمة النقطة tf-nightly-gpu ؟ تحتاج إلى استخدام 1.5 لـ CuDNNLSTM في Keras

حسنًا ، تم دمج العلاقات العامة.

في غضون 10-12 ساعة تقريبًا ، يجب أن يتم بناء الكؤوس الليلية الجديدة لدينا باستخدام cuda9 ، باستثناء النوافذ.

على windows ، ما زلنا محظورًا بواسطة خطأ NVCC.

انتهيت من حزمة CUDA 9 و CUDANN 7 العامة لنظام Gentoo وجربت اختبارًا وهميًا ويبدو أنني أعمل عن طريق tensorflow الاستيراد الوهمي مثل tf في python ، لكنني بحاجة إلى إجراء اختبارات إضافية:

أنا أستخدم الالتزام: c9568f1ee51a265db4c5f017baf722b9ea5ecfbb

على windows ، ما زلنا محظورًا بواسطة خطأ NVCC.

هل تمانع في نشر الرابط هنا لهذه المشكلة؟ شكرا لك مقدما!

smitshilu ساعدتني مقالتك.

وكتبت مقالًا مع إضافة بعض العناصر.

https://github.com/masasys/MacTF1.4GPU

تضمين التغريدة

انا اجري

بناء bazel --config = opt --config = cuda // tensorflow / tools / pip_ package: build_pip_package --cxxopt = "- D_GLIBCXX_USE_CXX11_ABI = 0"

لكني حصلت على هذا الخطأ

خطأ: يتم دعم أمر الإنشاء فقط من داخل مساحة العمل.

أنا أيضا أحاول تينسور ليلا لكنه يعطي خطأ

خطأ السمة: الوحدة النمطية "tensorflow" ليس لها سمة ....

إخراج دير (تف)

['__doc__'، '__loarder__'، '__name__'، __package__ '' __path__ __spec__]

آسف @ goodmangu ، كنت بعيدًا. هل وجدتها تعمل؟ لقد فاتني اقتباسات الإغلاق المزدوجة كما أشار

nasergh ، هل تقوم بتشغيل هذا الأمر من داخل دليل tensorflow المستنسخ. تأكد من وجود مساحة العمل في الدليل.

على سبيل المثال:

~/Downloads/tensorflow$ ls

ACKNOWLEDGMENTS bazel-bin bazel-testlogs configure LICENSE tensorflow WORKSPACE

ADOPTERS.md bazel-genfiles BUILD configure.py models.BUILD third_party

arm_compiler.BUILD bazel-out CODE_OF_CONDUCT.md CONTRIBUTING.md README.md tools

AUTHORS bazel-tensorflow CODEOWNERS ISSUE_TEMPLATE.md RELEASE.md util

تضمين التغريدة

أنا أدير الأمر

sudo su

ثم انتقل إلى مجلد tensorflow (كان هناك ملف مساحة عمل هناك)

لكني حصلت على هذه الأخطاء

root<strong i="10">@pc</strong>:/home/pc2/tensorflow# bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

..........

WARNING: Config values are not defined in any .rc file: opt

ERROR: /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD:4:1: Traceback (most recent call last):

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD", line 4

error_gpu_disabled()

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/error_gpu_disabled.bzl", line 3, in error_gpu_disabled

fail("ERROR: Building with --config=c...")

ERROR: Building with --config=cuda but TensorFlow is not configured to build with GPU support. Please re-run ./configure and enter 'Y' at the prompt to build with GPU support.

ERROR: no such target '@local_config_cuda//crosstool:toolchain': target 'toolchain' not declared in package 'crosstool' defined by /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD

INFO: Elapsed time: 6.830s

FAILED: Build did NOT complete successfully (2 packages loaded)

currently loading: @bazel_tools//tools/jdk

nasergh يرجى التأكد من اتباع جميع التعليمات هنا:

https://www.tensorflow.org/install/install_sources

إذا كنت تقوم بالبناء بدعم GPU ، فتأكد من أنك تقوم بالتكوين بشكل مناسب.

قم بتثبيت Tensorflow 1.4 من المصدر.

- حتى كتابة هذه السطور ، هذه هي الطريقة الوحيدة التي ستعمل بها مع CUDA 9.0 و cuDNN 7.0

- التعليمات: https://www.tensorflow.org/install/install_sources

- قد لا تكون بعض التعليمات منطقية ، وإليك كيف فعلت ذلك:

cd $HOME/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

./configure

ستختلف مخرجات العينة والخيارات عن تلك الموجودة في التعليمات

- تأكد من تكوين الإصدار CUDA: 9.0

- تأكد من تكوين إصدار cuDNN: 7.0.4

- تأكد من معرفة قدرتك على الحوسبة من https://developer.nvidia.com/cuda-gpus

- لقد قمت بتعيين هذا على 6.1 لأن لدي GeForce GTX 1070

تركيب بازل

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

بناء TensorFlow

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

@ Tweakmind : شكرًا على عودتك إلي في هذا الشأن. نعم ، لقد عملت مع Ubuntu ، وما زلت غير محظوظ مع Mac OSX (10.12.6) مع eGPU (1080 Ti). بالنسبة لجميع المصادر التي اتبعتها ، فشل البناء بعد حوالي 10-15 دقيقة. سيكون رائعًا إذا كان لدينا نجاح قابل للتكرار. شكرا لك مقدما.

تضمين التغريدة

أنا أتابع وأقوم أيضًا بتهيئة الملف لكنه يقول

pc2<strong i="7">@pc</strong>:~/Downloads/tensorflow$ bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: Skipping '//tensorflow/tools/pip_package:build_pip_package': error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

WARNING: Target pattern parsing failed.

ERROR: error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

INFO: Elapsed time: 0.082s

FAILED: Build did NOT complete successfully (0 packages loaded)

currently loading: tensorflow/tools/pip_package

أعتقد أنني تثبيت cuda و cudnn بشكل صحيح

""

البحث / usr | grep libcudnn

/ usr / share / doc / libcudnn7

/ usr / share / doc / libcudnn7 / copyright

/usr/share/doc/libcudnn7/NVIDIA_SLA_cuDNN_Support.txt

/usr/share/doc/libcudnn7/changelog.Debian.gz

/ usr / share / lintian / overrides / libcudnn7

/usr/lib/x86_64-linux-gnu/libcudnn.so.7.0.4

/usr/lib/x86_64-linux-gnu/libcudnn.so.7

""

goodmangu ، سأعمل على بناء MacOS خلال عطلة نهاية الأسبوع.

nasergh ، هل قمت بتثبيت cuDNN؟

إليك دليلي لـ cuDNN بما في ذلك المصدر والمستندات لاختبار التثبيت:

قم بتنزيل ملفات cuDNN 7.0.4

يجب عليك تسجيل الدخول إلى حساب مطور Nvidia الخاص بك في متصفحك

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/cudnn-9.0-linux-x64-v7

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64

تحقق من كل تجزئة

cd $HOME/Downloads

md5sum cudnn-9.0-linux-x64-v7.tgz && \

md5sum libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

يجب أن يكون الإخراج:

fc8a03ac9380d582e949444c7a18fb8d cudnn-9.0-linux-x64-v7.tgz

e986f9a85fd199ab8934b8e4835496e2 libcudnn7_7.0.4.31-1 + cuda9.0_amd64.deb

4bd528115e3dc578ce8fca0d32ab82b8 libcudnn7-dev_7.0.4.31-1 + cuda9.0_amd64.deb

04ad839c937362a551eb2170afb88320 libcudnn7-doc_7.0.4.31-1 + cuda9.0_amd64.deb

قم بتثبيت cuDNN 7.0.4 والمكتبات

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

التحقق من cuDNN

يتضمن Ubuntu 17.10 الإصدار 7+ لمجمعي GNU

CUDA غير متوافق مع إصدار أعلى من الإصدار 6

الخطأ الذي تم إرجاعه هو:

خطأ - إصدار جنو غير مدعوم! إصدارات دول مجلس التعاون الخليجي الأحدث من 6 غير مدعومة!

إصلاح - تثبيت الإصدار 6 وإنشاء روابط رمزية في دليل حاوية CUDA:

sudo apt-get install gcc-6 g++-6

sudo ln -sf /usr/bin/gcc-6 /usr/local/cuda/bin/gcc

sudo ln -sf /usr/bin/g++-6 /usr/local/cuda/bin/g++

الآن قم ببناء mnistCUDNN لاختبار cuDNN

cp -r /usr/src/cudnn_samples_v7/ $HOME

cd $HOME/cudnn_samples_v7/mnistCUDNN

make clean && make

./mnistCUDNN

إذا تم تثبيت cuDNN بشكل صحيح ، فسترى:

نجح الاختبار!

عزيزي Tweakmind

طريقتك تعمل بفضل مساعدتك (كنت أحاول تثبيت موتر لأكثر من 3 أسابيع !!!)

المشكلة هي أنني قمت بتثبيته على python3.6 والآن لدي مشكلة مع حزمة PIL

Traceback (most recent call last):

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 551, in get

inputs = self.queue.get(block=True).get()

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 644, in get

raise self._value

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 119, in worker

result = (True, func(*args, **kwds))

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 391, in get_index

return _SHARED_SEQUENCES[uid][i]

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 761, in __getitem__

return self._get_batches_of_transformed_samples(index_array)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 1106, in _get_batches_of_transformed_samples

interpolation=self.interpolation)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 345, in load_img

raise ImportError('Could not import PIL.Image. '

ImportError: Could not import PIL.Image. The use of `array_to_img` requires PIL.

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File "<stdin>", line 7, in <module>

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/models.py", line 1227, in fit_generator

initial_epoch=initial_epoch)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/engine/training.py", line 2115, in fit_generator

generator_output = next(output_generator)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 557, in get

six.raise_from(StopIteration(e), e)

File "<string>", line 3, in raise_from

StopIteration: Could not import PIL.Image. The use of `array_to_img` requires PIL.

أحاول تثبيت وسادة لكنها لا تساعد

أحاول أيضًا تثبيت PIL ولكن

UnsatisfiableError: The following specifications were found to be in conflict:

- pil -> python 2.6*

- python 3.6*

nasergh ماذا تحصل مع:

pip install pillow

منجم يشبه:

~$ pip install pillow

Requirement already satisfied: pillow in ./anaconda3/lib/python3.6/site-packages

nasergh ، أحتاج إلى التحطم لكنني سأقوم بتسجيل الوصول عندما أستيقظ.

goodmangu ، لن أتمكن من إنشاء Mac خلال عطلة نهاية الأسبوع حيث لا يمكنني الوصول إلى جهاز Mac Pro لعام 2012. نأمل أن تكون جيدًا مع Ubuntu في الوقت الحالي. أعلم أنه يعمل بشكل جيد بالنسبة لي. يجب أن أعود في نهاية الأسبوع المقبل.

تضمين التغريدة ، هل رأيت أي تحسن في الأداء مع CUDA 9 و cuDNN 7؟

أعتقد أيضًا أن بعض الخطوات التي ذكرها @ Tweakmind أدناه زائدة عن الحاجة ، فأنت بحاجة إما إلى:

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

أو

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

تضمين التغريدة

تم إصدار CUDA 9.1.85 للتو منذ لحظات مع CuDNN 7.0.5 ، مع إصلاحات أخطاء برنامج التحويل البرمجي nvcc. أتساءل عما إذا كان يتيح لمستخدمي win10 تجميع Tensorflow 1.4.1؟ إنها مسألة وقت.

من مراسلاتنا مع NVIDIA ، لا أعتقد أن 9.1 أصلح هذه المشكلة.

ومع ذلك ، لدينا حلول بديلة. أولاً ، نحتاج إلى دمج هذا العلاقات العامة في eigen:

https://bitbucket.org/eigen/eigen/pull-requests/351/win-nvcc/diff

ثم سنقوم بتحديث تبعية eigen الخاصة بنا ، والتي يجب أن تصلح جميع تصميماتنا لـ CUDA9

تم رفض العلاقات العامة ولكن يتم دمج اللحامات يدويًا. هل يتعين علينا انتظار إصدار eigen أم يتم بناؤه بواسطة المصادر؟

رائع ، إذًا سيكون على النقطة الليلية؟

تضمين التغريدة

أحاول إعادة بناء موتر باستخدام بيثون 2.7

لكن في bazel build أحصل على هذا الخطأ

أقوم أيضًا بتثبيت numpy ولكن بدون تغيير.

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: /home/gh2/Downloads/tensorflow/util/python/BUILD:5:1: no such package '@local_config_python//': Traceback (most recent call last):

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 310

_create_local_python_repository(repository_ctx)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 274, in _create_local_python_repository

_get_numpy_include(repository_ctx, python_bin)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 257, in _get_numpy_include

_execute(repository_ctx, [python_bin, "-c",..."], <2 more arguments>)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 76, in _execute

_python_configure_fail("\n".join([error_msg.strip() if ... ""]))

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 37, in _python_configure_fail

fail(("%sPython Configuration Error:%...)))

Python Configuration Error: Problem getting numpy include path.

Traceback (most recent call last):

File "<string>", line 1, in <module>

**ImportError: No module named numpy**

Is numpy installed?

and referenced by '//util/python:python_headers'

ERROR: Analysis of target '//tensorflow/tools/pip_package:build_pip_package' failed; build aborted: Loading failed

INFO: Elapsed time: 10.826s

FAILED: Build did NOT complete successfully (26 packages loaded)

currently loading: tensorflow/core ... (3 packages)

Fetching http://mirror.bazel.build/.../~ooura/fft.tgz; 20,338b 5s

Fetching http://mirror.bazel.build/zlib.net/zlib-1.2.8.tar.gz; 19,924b 5s

Fetching http://mirror.bazel.build/.../giflib-5.1.4.tar.gz; 18,883b 5s

يبدو أن OSX مستبعد في الإصدار 7.0.5 من cuDNN. هل يعرف احد شيئا مفصلا؟

ما زلت لا أستطيع الحصول على tensorflow-gpu للعمل في نظام التشغيل Windows 10 (مع CUDA 9.0.176 و cudnn 7.0).

لقد قمت بإلغاء تثبيت كل من tensorflow و tensorflow-gpu وأعدت تثبيتهما (باستخدام - no-cache-dir لضمان تنزيل أحدث إصدار باستخدام حل eigen). عندما أقوم بتثبيت كليهما ، لا يتم التعرف على وحدة معالجة الرسومات الخاصة بي:

InvalidArgumentError (انظر أعلاه للتتبع): لا يمكن تعيين جهاز للعملية 'random_uniform_1 / sub': تم تعيين العملية صراحةً إلى / device: GPU : 0 ولكن الأجهزة المتاحة هي [/ job: localhost / replica : 0 / task: 0 / device : وحدة المعالجة المركزية: 0 ]. تأكد من أن مواصفات الجهاز تشير إلى جهاز صالح.

عندما أقوم بتثبيت tensorflow-gpu ، فإنه يشتكي من فقدان dll:

خطأ في الاستيراد: تعذر العثور على "cudart64_80.dll". يتطلب TensorFlow تثبيت DLL هذا في دليل مسمى في متغير البيئة٪ PATH٪. قم بتنزيل CUDA 8.0 وتثبيته من عنوان URL هذا: https://developer.nvidia.com/cuda-toolkit

وهو أمر غريب لأن إصدار CUDA الخاص بي هو 9.0 وليس 8.0 ويتم التعرف عليه (تم اجتياز اختبار deviceQuery).

إصدار Python الخاص بي هو 3.6.3. أحاول تشغيل هذا الرمز في Spyder (3.2.4) لاختبار tensorflow-gpu.

ماذا افتقد؟

أحاول البناء من المصدر بواسطة bazel على win 7 ، احصل على الخطأ

لا يوجد toolcahin لوحدة المعالجة المركزية "x64_windows"

يمكن لأي شخص بناء whl؟

@ hadaev8 ، أحتاج إلى الكثير من المعلومات للمساعدة. يمكنني العمل على whl ولكن سيكون له تبعيات ثقيلة وليس Win7 ، بمجرد حل نظام MacOS ، سأحل Win10. على أي حال ، انشر التفاصيل الخاصة بك.

@ eeilon79 ، أحتاج إلى إعادة إنشاء هذا ضمن Win10. أركز حاليًا على MacOS بعد أن تم حل Ubuntu. سأعود إلى Win 10.

nasergh ، هل هناك متطلبات لبيثون 2.7؟

مع CUDA 8.0 و cuDNN 6.0 ، هكذا قمت بتثبيت TensorFlow من المصدر لدعم Cuda GPU و AVX2 في Win10:

متطلبات:

* Windows 10 64-Bit

* Visual Studio 15 C++ Tools

* NVIDIA CUDA® Toolkit 8.0

* NVIDIA cuDNN 6.0 for CUDA 8.0

* Cmake

* Swig

قم بتثبيت Visual Studio Community Edition Update 3 w / Windows Kit 10.0.10240.0

اتبع التعليمات على: https://github.com/philferriere/dlwin (شكرًا لك Phil)

قم بإنشاء محرك افتراضي N: من أجل الوضوح

أقترح إنشاء دليل خارج C: أو محرك الأقراص الذي تختاره وإنشاء N: بناءً على هذه الإرشادات (2 جيجابايت كحد أدنى):

https://technet.microsoft.com/en-us/library/gg318052 (v = ws.10) .aspx

قم بتثبيت Cuda 8.0 64 بت

https://developer.nvidia.com/cuda-downloads (قم بالتمرير لأسفل إلى Legacy)

قم بتثبيت cuDNN 6.0 لـ Cuda 8.0

https://developer.nvidia.com/rdp/cudnn-download

ضع مجلد cuda من zip على N: \ وأعد تسمية cuDNN-6

قم بتثبيت CMake

https://cmake.org/files/v3.10/cmake-3.10.0-rc5-win64-x64.msi

تثبيت Swig (swigwin-3.0.12)

https://sourceforge.net/projects/swig/files/swigwin/swigwin-3.0.12/swigwin-3.0.12.zip

cntk-py36

"" كوندا إنشاء - الاسم cntk-py36 python = 3.6 numpy scipy h5py jupyter

تفعيل cntk-py36

تثبيت Pip https://cntk.ai/PythonWheel/GPU/cntk-2.2-cp36-cp36m-win_amd64.whl

python -c "import cntk ؛ print (cntk .__ version__)"

كوندا تثبيت pygpu

نقطة تثبيت keras

#### Remove old tensorflow in Tools if it exists

```cd C:\Users\%USERNAME%\Tools\

move tensorflow tensorflow.not

git clone --recursive https://github.com/tensorflow/tensorflow.git

cd C:\Users\%USERNAME%\Tools\tensorflow\tensorflow\contrib\cmake

Edit CMakeLists.txt

قم بالتعليق على هذه:

# if (tensorflow_OPTIMIZE_FOR_NATIVE_ARCH)

# include(CheckCXXCompilerFlag)

# CHECK_CXX_COMPILER_FLAG("-march=native" COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

# if (COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

# set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -march=native")

# endif()

# endif()

أضف ما يلي:

if (tensorflow_OPTIMIZE_FOR_NATIVE_ARCH)

include(CheckCXXCompilerFlag)

CHECK_CXX_COMPILER_FLAG("-march=native" COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

if (COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -march=native")

else()

CHECK_CXX_COMPILER_FLAG("/arch:AVX2" COMPILER_OPT_ARCH_AVX_SUPPORTED)

if(COMPILER_OPT_ARCH_AVX_SUPPORTED)

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} /arch:AVX2")

endif()

endif()

endif()

mkdir بناء & بناء القرص المضغوط

"C:\Program Files (x86)\Microsoft Visual Studio 14.0\VC\bin\amd64\vcvars64.bat"

cmake .. -A x64 -DCMAKE_BUILD_TYPE=Release ^

-DSWIG_EXECUTABLE=N:/swigwin-3.0.12/swig.exe ^

-DPYTHON_EXECUTABLE=N:/Anaconda3/python.exe ^

-DPYTHON_LIBRARIES=N:/Anaconda3/libs/python36.lib ^

-Dtensorflow_ENABLE_GPU=ON ^

-DCUDNN_HOME="n:\cuDNN-6" ^

-Dtensorflow_WIN_CPU_SIMD_OPTIONS=/arch:AVX2

- بناء لـ: Visual Studio 14 2015

- تحديد إصدار Windows SDK 10.0.14393.0 لاستهداف Windows 10.0.16299.

- تعريف المترجم C هو MSVC 19.0.24225.1

- تعريف برنامج التحويل البرمجي CXX هو MSVC 19.0.24225.1

- تحقق من عمل مترجم C: C: / Program Files (x86) / Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe

- تحقق من وجود مترجم C: C: / Program Files (x86) / Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe - يعمل

- الكشف عن معلومات المترجم C ABI

- الكشف عن معلومات المترجم C ABI - تم

- تحقق من عمل مترجم CXX: C: / Program Files (x86) / Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe

- تحقق من عمل مترجم CXX: C: / Program Files (x86) / Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe - يعمل

- كشف معلومات المترجم CXX ABI

- الكشف عن معلومات ABI مترجم CXX - تم

- الكشف عن ميزات تجميع CXX

- الكشف عن ميزات تجميع CXX - تم

- إجراء اختبار COMPILER_OPT_ARCH_NATIVE_SUPPORTED

- إجراء اختبار COMPILER_OPT_ARCH_NATIVE_SUPPORTED - فشل

- إجراء اختبار COMPILER_OPT_ARCH_AVX_SUPPORTED

- تنفيذ الاختبار COMPILER_OPT_ARCH_AVX_SUPPORTED - نجاح

- إجراء اختبار COMPILER_OPT_WIN_CPU_SIMD_SUPPORTED

- تنفيذ الاختبار COMPILER_OPT_WIN_CPU_SIMD_SUPPORTED - النجاح

- تم العثور على CUDA: C: / Program Files / NVIDIA GPU Computing Toolkit / CUDA / v8.0 (تم العثور على إصدار مناسب "8.0" ، الحد الأدنى المطلوب هو "8.0")

- تم العثور على PythonInterp: C: /Users/٪USERNAME٪/Anaconda3/python.exe (تم العثور على الإصدار "3.6.3")

- تم العثور على PythonLibs: C: /Users/٪USERNAME٪/Anaconda3/libs/python36.lib (الإصدار الموجود "3.6.3")

- تم العثور على SWIG: C: /Users/٪USERNAME٪/Tools/swigwin-3.0.12/swig.exe (تم العثور على الإصدار "3.0.12")

- تم التهيئة

- تم التوليد

- تمت كتابة ملفات الإنشاء إلى: C: / Users /٪ USERNAME٪ / Tools / Tensorflow / Tensorflow / Contrib / cmake / build

MSBuild /p:Configuration=Release tf_python_build_pip_package.vcxproj

تضمين التغريدة

python 3.6 و tensorflow last from master و cuda 9.0 و cudnn 7.0.5 لـ cuda 9.0 و basel و swig الذي تم تحميله اليوم.

@ Tweakmind هل تبني مع سيد أم؟

تضمين التغريدة

يمكنك البناء على النوافذ مع cuda 9 cudnn 7 ومشاركة .whl؟

تضمين التغريدة

ألا تحاول البناء على فوز 10 مع cuda 9 cudnn 7؟

شكرا لخبرتك!

@ hadaev8 @ alc5978

يوفر تثبيت pip -U tf-nightly-gpu الآن إصدارًا من win10 بتاريخ 20171221 ، والذي يعتمد على TF 1.5 beta مع CUDA 9.0 و CuDNN 7.0.5. ركضتها الليلة الماضية ، لا بأس. الآن يجب أن ننتقل إلى CUDA 9.1 للحصول على سرعة إطلاق نواة CUDA 12x. دعم نوافذ Tensorflow بطيء جدًا وفقر الدم. يجب تقديم البنيات الرسمية المستقرة في أسرع وقت ممكن. أنا بالفعل مع Tensorflow 1.5 المستقر ليتم إطلاقه مع CUDA 9.1 ، بحلول نهاية يناير من فضلك؟

انتقل إلى http://www.python36.com/install-tensorflow141-gpu/ لتثبيت Tensorflow خطوة بخطوة باستخدام cuda 9.1 و cudnn7.05 على ubuntu. وانتقل إلى http://www.python36.com/install-tensorflow-gpu-windows للتثبيت خطوة بخطوة لتطبيق Tensorflow مع cuda 9.1 و cudnn 7.0.5 على Windows.

إنه 2018 ، نهاية شهر يناير تقريبًا ، ولم يتم بعد تثبيت TF مع CUDA9.1 و CuDNN7 على نظام التشغيل Windows 10؟

1.5 هو RC مع CUDA 9 + cuDNN 7 ويجب أن يذهب GA في الأيام القليلة القادمة. (كان CUDA 9.1 كان GA في ديسمبر ويتطلب ترقية أخرى لبرنامج تشغيل الجهاز مما يسبب اضطرابًا للعديد من المستخدمين. تتمثل الخطة الحالية في الحفاظ على الإصدار الافتراضي على CUDA 9.0.x ومواصلة الترقية إلى إصدارات cuDNN الأحدث).

فتحت مشكلة لمناقشة CUDA 9.1.

يعد تحسين سرعة تشغيل kernel 12x أكثر دقة من الرقم 12x. الطرف الأعلى من 12x هو لـ ops مع الكثير من الوسائط وتعطيل المستخدمين مرتفعًا بسبب ترقية برنامج تشغيل الجهاز. آمل أن يكون لدي "قناة" تختبر 9.1 في المستقبل القريب ومعرفة كيفية التعامل مع هذا النموذج.

آمل أن يكون أخيرًا CUDA 9.1 وليس 9.0.

آمل أن يكون أخيرًا CUDA 9.1 وليس 9.0 أيضًا.

أنا متأكد من أنه سيكون أخيرًا CUDA 9.1 ، وليس 9.0 أيضًا ، أليس كذلك؟ :)

ViktorM @ Magicfeng007 @ alc5978

يوجد مؤشر الترابط 9.1

إذا كان أي شخص لا يزال يواجه مشاكل مثل Keras مع TensorFlow backend لا يستخدم GPU .... فقط اتبع التعليمات في هذه الصفحة. يتم تحديثه ويعمل بشكل صحيح بنسبة 100٪.

https://research.wmz.ninja/articles/2017/01/configuring-gpu-accelerated-keras-in-windows-10.html

تحية للجميع

أقوم اليوم بتثبيت tensorflow-gpu 1.6.0rc1 على win10 مع مكتبة CUDA 9.0 و cuDNN 7.0.5 مع http://www.python36.com/install-tensorflow-using-official-pip-pacakage/

كل شيء يبدو على ما يرام

لقد قمت بإنشاء برنامج نصي واحد لمتطلبات NVIDIA GPU (CUDA-9.0 و cuDNN-7.0) لأحدث TensorFlow (v1.5 +) ، ها هو الرابط .

التعليق الأكثر فائدة

عند الحديث عن الأساليب التي سيتم إضافتها ، فإن الالتفاف الجماعي من cudnn7 سيكون سمة مهمة لمجتمع الرؤية.