Tensorflow: Upgrade auf CuDNN 7 und CUDA 9

System Information

- Habe ich benutzerdefinierten Code geschrieben (im Gegensatz zu einem in TensorFlow bereitgestellten Standard-Beispielskript) : Nein

- Betriebssystemplattform und -verteilung (z. B. Linux Ubuntu 16.04) : Windows Server 2012

- TensorFlow installiert von (Quelle oder Binär) : Binär

- TensorFlow-Version (verwenden Sie den Befehl unten) : 1.3.0-rc1

- Python-Version : 3.5.2

- Bazel-Version (wenn aus der Quelle kompiliert) : N/A

- CUDA/cuDNN-Version : CUDA V8.0.44, CuDNN 6.0

- GPU-Modell und Speicher : Nvidia GeForce GTX 1080 Ti, 11 GB

- Genauer Befehl zum Reproduzieren : N/A

Beschreibe das Problem

Bitte aktualisieren Sie TensorFlow, um CUDA 9 und CuDNN 7 zu unterstützen. Nvidia behauptet, dass dies eine 2-fache Leistungssteigerung auf Pascal-GPUs bietet.

Alle 170 Kommentare

@tfboyd hast du dazu irgendwelche kommentare?

cuDNN 7 befindet sich noch im Vorschaumodus und wird bearbeitet. Wir sind gerade mit 1.3 auf cuDNN 6.0 umgestiegen, das in ein paar Wochen endgültig sein sollte. Sie können cuDNN 1.3.0rc2 herunterladen, wenn Sie daran interessiert sind. Ich habe noch nicht mit cuDNN 7 oder CUDA 9 kompiliert. Ich habe gehört, dass CUDA 9 nicht auf allen Plattformen einfach zu installieren ist und nur ausgewählte Installationspakete verfügbar sind. Wenn die Bibliotheken endgültig sind, beginnen wir mit der abschließenden Auswertung. NVIDIA hat auch gerade damit begonnen, Patches an die großen ML-Plattformen zu senden, um Aspekte dieser neuen Bibliotheken zu unterstützen, und ich vermute, dass es zusätzliche Arbeit geben wird.

Bearbeiten: Ich wollte sagen, dass CUDA 9 nicht einfach auf allen Plattformen zu installieren ist und sagte stattdessen cuDNN. Ich habe auch geändert, dass es Arbeit geben wird, von der ich vermute, dass es zusätzliche Arbeit geben wird. Den Rest meiner albernen Aussage habe ich hinterlassen, zB wusste ich nicht, dass cuDNN 7 gestern live gegangen ist.

Nicht sagen, wie Sie die Website lesen sollten. Aber das 2x schnellere auf Pascal scheint Teil der CUDA 8-Version zu sein. Ich nehme an, es hängt davon ab, wie Sie die Site lesen. NVIDIA hat uns gegenüber nicht erwähnt, dass CUDA 9 Pascal um das Zweifache beschleunigen wird (für alles) und obwohl alles möglich ist, würde ich nicht erwarten, dass dies geschieht.

https://developer.nvidia.com/cuda-toolkit/whatsnew

Die Site ist ein wenig verwirrend, aber ich denke, der von Ihnen zitierte Abschnitt ist unter CUDA 8 verschachtelt. Ich erwähne dies nur, damit Sie keine unrealistischen Erwartungen an ihre Veröffentlichung haben. Für Volta sollte es einige große Vorteile geben von dem, was ich verstehe, und ich denke (ich weiß es jetzt nicht genau), die Leute bekommen nur technische Muster von Volta, um mit der Arbeit auf hohem Niveau zu beginnen, um sich auf die vollständige Veröffentlichung vorzubereiten.

@tfboyd cuDNN 7 befindet sich seit gestern nicht mehr im Vorschaumodus. Es wurde offiziell sowohl für CUDA 8.0 als auch für CUDA 9.0 RC veröffentlicht.

Ahh das habe ich verpasst. Danke @sclarkson und sorry für die falschen Infos.

Ich werde es auf jeden Fall ausprobieren, denn endlich wird gcc 6 von CUDA 9 unterstützt und Ubuntu 17.04 kommt damit.

Wenn du Glück hast, lass es den Thread wissen. Ich persönlich fange gerade erst an

cuDNN 6 vollständig testen (Intern wurde es viel getestet, aber ich nicht

persönlich verwenden). Ich bin oft langsam, um auf die neuesten Dinge zu aktualisieren. Mein

Ich vermute, dass Sie mit cuDNN 7 möglicherweise keine wirkliche Änderung sehen, bis alles erreicht ist

gepatcht, um die neuesten APIs zu verwenden. Ich möchte noch einmal betonen, dass ich falsch liege

der ganzen Zeit. Was ich als Außenstehender gesehen habe, sind die neuen cuDNN-Versionen hinzufügen

neue Methoden/APIs. Manche sind interessant und manche nicht sofort

sinnvoll. Dann werden diese APIs über die TensorFlow-API verfügbar gemacht oder einfach nur verwendet

hinter den Kulissen, um bestehende Methoden schneller zu machen. Mein sehr hohes Niveau

Verständnis ist cuDNN 7 + CUDA 9 wird die RP16-Unterstützung mit einem Schwerpunkt auf . verbessern

Volta. Ich denke, einer der Schwerpunkte liegt darin, Modelle zu bekommen (viele nicht nur

ein paar), um mit FP16 zu konvergieren, ohne endlos das Richtige erraten zu müssen

config/hyperparameters zu verwenden. Ich möchte betonen, dass ich so

das Gespräch verstanden habe und ich möglicherweise falsch oder halb richtig liege.

STRESS: Wenn es Methoden gibt, die Ihrer Meinung nach hinzugefügt werden müssen (oder

performance) zu TensorFlow von cuDNN sind wir immer an einer Liste interessiert.

Intern geschah dies mit cuDNN 6 und wir konzentrierten uns auf die Implementierung der

Features-Teams sagten, sie wollten, dass dies ihren Projekten helfen würde.

Am Sa, 5. August 2017 um 8:46 Uhr, Courtial Florian [email protected]

schrieb:

Ich werde es auf jeden Fall ausprobieren, denn endlich wird gcc 6 von CUDA 9 unterstützt und

Ubuntu 17.04 kommt mit.—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320450756 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZessKqj_nPY1br9SD9L9SX-8Kf5Dbtks5sVI5TgaJpZM4OuRL7

.

Apropos hinzuzufügende Methoden, die Gruppenfaltung von cudnn7 wäre ein wichtiges Feature für die Vision-Community.

Cool, ich werde es der Liste hinzufügen, die ich starte. Ich kann es vergessen, aber ich fühle mich frei

um mich daran zu erinnern, eine Art Liste zu veröffentlichen, in der ich eine Anleitung geben kann

woran wahrscheinlich gearbeitet wird. Es kann kein Versprechen sein, aber wir wollen

Feedback, damit wir priorisieren können, was die Leute wollen und brauchen. Danke Yuxin.

Am Samstag, den 5. August 2017 um 12:26 Uhr schrieb Yuxin Wu [email protected] :

Apropos hinzuzufügende Methoden, Gruppenfaltung von cudnn7 wäre a

wichtige Funktion für die Vision-Community.—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

.

Ich habe gerade versucht, mit cuDNN 7 mit CUDA 8 zu kompilieren, und es ist fehlgeschlagen, was mir gefällt

von erwartet. Es gibt einen Patch von NVIDIA, der helfen sollte

Dinge auf. Nur ein Hinweis, wenn es jemand versucht.

Am Samstag, den 5. August 2017 um 13:47 Uhr schrieb Toby Boyd [email protected] :

Cool, ich werde es der Liste hinzufügen, die ich starte. Ich kann es vergessen, aber ich fühle mich frei

um mich daran zu erinnern, eine Art Liste zu veröffentlichen, in der ich eine Anleitung geben kann

woran wahrscheinlich gearbeitet wird. Es kann kein Versprechen sein, aber wir wollen

Feedback, damit wir priorisieren können, was die Leute wollen und brauchen. Danke Yuxin.Am Sa, 5. August 2017 um 12:26 Uhr, Yuxin Wu [email protected]

schrieb:Apropos hinzuzufügende Methoden, Gruppenfaltung von cudnn7 wäre a

wichtige Funktion für die Vision-Community.—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

.

Ich versuche, cuDNN 7 mit CUDA 8/9 zum Laufen zu bringen. CUDA 8 wird von der GTX 1080 Ti nicht unterstützt - sagt zumindest der Installer ^^

Ich habe große Probleme, es zum Laufen zu bringen. Ich möchte auf diesen großartigen Artikel hinweisen, der zusammenfasst, was ich bereits versucht habe: https://nitishmutha.github.io/tensorflow/2017/01/22/TensorFlow-with-gpu-for-windows.html

Die CUDA-Beispiele funktionieren über Visual-Studio in beiden Setup-Kombinationen.

Hier die Ausgabe der deviceQuery.exe, die mit Visual-Studio kompiliert wurde:

PS C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release> deviceQuery.exe

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release\deviceQuery.exe Starting...

CUDA Device Query (Runtime API) version (CUDART static linking)

Detected 1 CUDA Capable device(s)

Device 0: "GeForce GTX 1080 Ti"

CUDA Driver Version / Runtime Version 9.0 / 9.0

CUDA Capability Major/Minor version number: 6.1

Total amount of global memory: 11264 MBytes (11811160064 bytes)

(28) Multiprocessors, (128) CUDA Cores/MP: 3584 CUDA Cores

GPU Max Clock rate: 1683 MHz (1.68 GHz)

Memory Clock rate: 5505 Mhz

Memory Bus Width: 352-bit

L2 Cache Size: 2883584 bytes

Maximum Texture Dimension Size (x,y,z) 1D=(131072), 2D=(131072, 65536), 3D=(16384, 16384, 16384)

Maximum Layered 1D Texture Size, (num) layers 1D=(32768), 2048 layers

Maximum Layered 2D Texture Size, (num) layers 2D=(32768, 32768), 2048 layers

Total amount of constant memory: 65536 bytes

Total amount of shared memory per block: 49152 bytes

Total number of registers available per block: 65536

Warp size: 32

Maximum number of threads per multiprocessor: 2048

Maximum number of threads per block: 1024

Max dimension size of a thread block (x,y,z): (1024, 1024, 64)

Max dimension size of a grid size (x,y,z): (2147483647, 65535, 65535)

Maximum memory pitch: 2147483647 bytes

Texture alignment: 512 bytes

Concurrent copy and kernel execution: Yes with 2 copy engine(s)

Run time limit on kernels: Yes

Integrated GPU sharing Host Memory: No

Support host page-locked memory mapping: Yes

Alignment requirement for Surfaces: Yes

Device has ECC support: Disabled

CUDA Device Driver Mode (TCC or WDDM): WDDM (Windows Display Driver Model)

Device supports Unified Addressing (UVA): Yes

Supports Cooperative Kernel Launch: No

Supports MultiDevice Co-op Kernel Launch: No

Device PCI Domain ID / Bus ID / location ID: 0 / 1 / 0

Compute Mode:

< Default (multiple host threads can use ::cudaSetDevice() with device simultaneously) >

deviceQuery, CUDA Driver = CUDART, CUDA Driver Version = 9.0, CUDA Runtime Version = 9.0, NumDevs = 1, Device0 = GeForce GTX 1080 Ti

Result = PASS

@tfboyd haben Sie einen Link, der das cuDNN-Update von Nvidea bestätigt?

@4F2E4A2E 1080 Ti unterstützt definitiv CUDA 8.0. Das habe ich in den letzten Monaten mit TensorFlow verwendet.

Hallo zusammen, also ich habe gtx 1080 ti mit cuda 8.0. Ich versuche, tensorflow-gpu zu installieren, gehe ich für cuDNN 5.1, 6.0 oder 7.0?

Ich schlage vor, im Moment bei 5.1 zu bleiben. Ich laufe eine tiefere Perf

Tests auf 6 und gemischte Ergebnisse, die weitere Tests erfordern, um herauszufinden.

Am 6. August 2017 um 21:30 Uhr schrieb "colmantse" [email protected] :

Hallo zusammen, also ich habe gtx 1080 ti mit cuda 8.0. Ich versuche zu installieren

tensorflow-gpu, gehe ich für cuDNN 5.1, 6.0 oder 7.0?—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320566071 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZeshvEFsdeWz-1uyzl_L6HE15E0BzSks5sVpLlgaJpZM4OuRL7

.

danke, ich habe es mit cudnn 6.0 versucht, aber es funktioniert nicht, ich denke, wegen meiner Dummy-TF-GPU-Installation. cudnn 5.1 funktioniert bei mir mit Python 3.6

@tpankaj Danke! Bei mir läuft es mit CUDA 8 und cuDNN 5.1

Hier sind die vollständigen Funktionen von cuDNN 7:

Hauptfunktionen und Verbesserungen

Diese cuDNN-Version enthält die folgenden Hauptfunktionen und Verbesserungen.

Tensorkerne

Version 7.0.1 von cuDNN ist die erste, die die Tensor-Core-Operationen in ihrer

Implementierung. Tensor-Kerne bieten eine hochoptimierte Matrixmultiplikation

Bausteine, die kein äquivalentes numerisches Verhalten im traditionellen

Anweisungen, daher ist sein numerisches Verhalten etwas anders.

cudnnSetConvolutionMathType, cudnnSetRNNMatrixMathType und

cudnnMathType_t

Der cudnnSetConvolutionMathType und der cudnnSetRNNMatrixMathType

Funktionen ermöglichen es Ihnen zu wählen, ob Sie Tensor Core-Operationen in

die Faltungs- bzw. RNN-Schichten, indem Sie den mathematischen Modus auf entweder setzen

CUDNN_TENSOR_OP_MATH oder CUDNN_DEFAULT_MATH.

Tensor-Core-Operationen führen eine parallele Gleitkomma-Akkumulation von mehreren . durch

Gleitkomma-Produkte.

Das Einstellen des mathematischen Modus auf CUDNN_TENSOR_OP_MATH zeigt an, dass die Bibliothek verwendet

Tensor-Core-Operationen.

Der Standardwert ist CUDNN_DEFAULT_MATH. Diese Vorgabe zeigt an, dass der Tensor Core

Der Betrieb wird von der Bibliothek vermieden. Der Standardmodus ist ein serialisierter Vorgang

während der Tensor-Kern eine parallelisierte Operation ist, können die beiden daher resultieren

in leicht unterschiedlichen numerischen Ergebnissen aufgrund der unterschiedlichen Reihenfolge der Operationen.

Die Bibliothek fällt auf den mathematischen Standardmodus zurück, wenn Tensor Core-Operationen

nicht unterstützt oder nicht erlaubt.

cudnnSetConvolutionGroupCount

Eine neue Schnittstelle, die es Anwendungen ermöglicht, Faltungsgruppen im

Faltungsschichten in einem einzigen API-Aufruf.

cudnnCTCLoss

cudnnCTCLoss bietet eine GPU-Implementierung des Connectionist Temporal

Klassifikations-(CTC)-Verlustfunktion für RNNs. Die CTC-Verlustfunktion wird verwendet für

Phonemerkennung bei der Sprach- und Handschrifterkennung.

CUDNN_BATCHNORM_SPATIAL_PERSISTENT

Die Funktion CUDNN_BATCHNORM_SPATIAL_PERSISTENT ist ein neuer Batch

Normalisierungsmodus für cudnnBatchNormalizationForwardTraining

und cudnnBatchNormalizationBackward. Dieser Modus ist ähnlich wie

CUDNN_BATCHNORM_SPATIAL kann jedoch für einige Aufgaben schneller sein.

cudnnQueryRuntimeError

Die Funktion cudnnQueryRuntimeError meldet Fehlercodes, die von der GPU geschrieben wurden

Kernel beim Ausführen von cudnnBatchNormalizationForwardTraining

und cudnnBatchNormalizationBackward mit dem

CUDNN_BATCHNORM_SPATIAL_PERSISTENT-Modus.

cudnnGetConvolutionForwardAlgorithm_v7

Diese neue API gibt alle Algorithmen sortiert nach erwarteter Leistung zurück

(unter Verwendung interner Heuristiken). Diese Algorithmen werden ähnlich ausgegeben wie

cudnnFindConvolutionForwardAlgorithm.

cudnnGetConvolutionBackwardDataAlgorithm_v7

Diese neue API gibt alle Algorithmen sortiert nach erwarteter Leistung zurück

(unter Verwendung interner Heuristiken). Diese Algorithmen werden ähnlich ausgegeben wie

cudnnFindConvolutionBackwardAlgorithm.

cudnnGetConvolutionBackwardFilterAlgorithm_v7

Diese neue API gibt alle Algorithmen sortiert nach erwarteter Leistung zurück

(unter Verwendung interner Heuristiken). Diese Algorithmen werden ähnlich ausgegeben wie

cudnnFindConvolutionBackwardFilterAlgorithm.

CUDNN_REDUCE_TENSOR_MUL_NO_ZEROS

Die Funktion MUL_NO_ZEROS ist eine Multiplikationsreduktion, die Nullen im ignoriert

Daten.

CUDNN_OP_TENSOR_NOT

Die Funktion OP_TENSOR_NOT ist eine unäre Operation, die das Negative von annimmt

(Alpha*A).

cudnnGetDropoutDescriptor

Die Funktion cudnnGetDropoutDescriptor ermöglicht es Anwendungen, Dropouts zu erhalten

Werte.

Okay, ich denke darüber nach, eine neue Ausgabe zu starten, die eher ein "Blog" von CUDA 9 RC + cuDNN 7.0 ist. Ich habe einen TF-Build "in meiner Hand", der zusammengepatcht ist, aber CUDA 9RC und cuDNN 7.0 ist, und ich möchte sehen, ob jemand daran interessiert ist, es auszuprobieren. Ich muss auch sicherstellen, dass es keinen seltsamen Grund gibt, warum ich es nicht teilen kann. An einigen Upstream-Bibliotheken, die TensorFlow verwendet, müssen Änderungen vorgenommen werden, aber Sie werden in naher Zukunft PRs von NVIDIA sehen. Ich und das Team konnten CUDA 8 + cuDNN 6 auf Volta und dann CUDA 9RC + cuDNN 7 auf Volta (V100) mit FP32-Code testen. Ich mache nur Linux-Builds und Python 2.7, aber wenn alle/jeder von euch interessiert sind, würde ich gerne versuchen, die Community mehr einzubeziehen, als wir es mit cuDNN 6.0 getan haben. Es macht vielleicht nicht so viel Spaß, aber ich möchte es anbieten und versuchen, das Gefühl zu vermitteln, dass wir zusammen in dieser Sache sind, anstatt Informationen zu erhalten. Ich möchte auch noch Listen erstellen, an denen wir arbeiten, aber für cuDNN 7 (und 6.0) nicht vielversprechend sind. @cancan101 danke für die vollständige Liste.

@tfboyd : Ich wäre dankbar für Beschreibungen zu CUDA 9.0RC + cuDNN 7.0. Ich benutze selbst ein seltsames System (ubuntu 17.10 beta mit TF1.3, CUDA 8.0 und cuDNN 6.0 gcc-4.8), und ein Upgrade auf cuda 9 und cudnn 7 wäre Compilertechnisch eigentlich nett.

Ich werde sehen, was ich tun kann, um das zu bekommen, was Sie brauchen, um sich selbst zu bauen und a

binär. Der Leiter des Performance-Teams hat angegeben, dass ich versuchen kann, dies zu erreichen

damit wir transparenter sein können und ich hoffe, dass wir als Gemeinschaft mehr Spaß haben.

Den Patch zu bekommen und wie man ihn baut, ist nicht super schwer, aber ein wenig

Schwerer. Es wird auch sehr informell sein, da ich keine Zeit habe, um ein

Ast und der Flicken könnte sehr schnell verrotten (nicht sauber auftragen). Die

Patch wurde verwendet, um sicherzustellen, dass alle Beteiligten mit den Änderungen in einverstanden waren

allgemein und ich gehe davon aus, dass einzelne PRs eintreffen werden.

Am Freitag, 11. August 2017 um 5:22 Uhr, Erlend Aune [email protected]

schrieb:

@tfboyd https://github.com/tfboyd : Für Beschreibungen wäre ich dankbar

über CUDA 9.0RC+cuDNN 7.0. Ich benutze selbst ein seltsames System (ubuntu

17.10 Beta mit TF1.3, CUDA 8.0 und cuDNN 6.0 gcc-4.8) und Upgrade auf

cuda 9 und cudnn 7 wären Compilerweise eigentlich nett.—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321798364 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesj4WRkFKNX-Nt2oKtvp0oyQVBtM5ks5sXEdqgaJpZM4OuRL7

.

@tfboyd : Ich bin interessiert, wie werden Sie es teilen? Ein Zweig?

@tfboyd Das würde mich auf jeden Fall auch sehr interessieren. Vielen Dank!

Versuche es diese Woche herauszufinden. Logistik ist oft schwerer als ich

denken.

Am 12. August 2017 um 10:18 Uhr schrieb "Tanmay Bakshi" [email protected] :

@tfboyd https://github.com/tfboyd würde mich auf jeden Fall sehr interessieren da

Gut. Vielen Dank!—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321994065 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesjO42Rl1WCyW0KR22KgbydKh1O4Zks5sXd6AgaJpZM4OuRL7

.

Anweisungen und eine Binärdatei zum Spielen, wenn Sie Python 2.7 mögen. Ich werde dies schließen, da ich das von mir erstellte Problem aktualisieren werde, um den Aufwand zu verfolgen. @tanmayb123 @Froskekongen

Ich habe gerade versucht, die vorkompilierte tensorflow-gpu-1.3.0 für Python 3.6 unter Windows x64 zu installieren und die cuDNN-Bibliothek Version 7.0 mit Cuda 8.0 bereitgestellt und zumindest für mich scheint alles zu funktionieren. Ich sehe keine Ausnahme oder Probleme.

Ist das zu erwarten? Ist cuDNN 7.0 abwärtskompatibel zu cuDNN 6.0? Kann dies zu Problemen führen?

@apacha Ich bin ein wenig überrascht, dass es funktioniert hat. Ich habe den Fehler schon einmal bei meinen Tests gesehen, bei denen die TensorFlow-Binärdatei cuDNN nicht finden kann, weil sie nach Namen sucht und die *.so-Dateien 6.0/7.0 in den Namen enthalten. Aus der Ferne ist möglich, dass Sie cuDNN 6 noch im Weg haben. Ich mag es nicht, Vermutungen über Ihr Setup anzustellen, aber wenn ich eine Wette abschließe, würde ich sagen, dass es immer noch cuDNN 6 verwendet.

In Bezug auf Abwärtskompatibilität minus TensorFlow, das kompiliert wird, um nach einer bestimmten Version zu suchen. Ich weiß nicht.

Schließlich ist es keine große Sache. cuDNN 7 PRs sind fast genehmigt/zusammengeführt und die vorkompilierte Binärdatei wird wahrscheinlich ab 1.5 zu cuDNN 7 wechseln.

UPDATE zum Fortschritt zu CUDA 9RC und cuDNN 7

- PRs von NVIDIA sind fast genehmigt

- EIGEN-Änderung wurde genehmigt und zusammengeführt

- FP16-Tests haben ernsthaft mit V100 (Volta) begonnen

@tfboyd nur der Vollständigkeit halber: Ich habe zuvor cuDNN 5 verwendet und da ich auf Tensorflow 1.3 aktualisieren musste, bin ich nur auf cuDNN Version 7 gesprungen, um es auszuprobieren. Ich habe cudnn64_5.dll explizit gelöscht und es gibt kein cudnn64_6.dll in meinem CUDA-Installationspfad. Vielleicht ist es Windows-Magie. :-P

Beachten Sie jedoch eine Sache: Ich verwende immer noch CUDA 8.0, nicht 9.0.

@apacha Es könnte Windows-Magie sein. Ich wollte nicht verurteilend klingen, da ich keine Ahnung hatte. Ich denke, Windows Magic ist möglich, da sich die cuDNN-Aufrufe nicht ändern sollten und daher abwärtskompatibel erscheint. Für die Linux-Builds sucht TensorFlow nach bestimmten Dateien (oder so sieht es aus, wenn ich Fehler bekomme) und ist sehr unglücklich, wenn es cudnnblahblah.6.so nicht findet. Danke für das Update und die Besonderheiten.

Gibt es einen Zweig / Tag, was wir auschecken und ausprobieren können?

Ich habe eine brandneue Installation gestartet, Ubuntu 17 ... dann neue gcc auferlegen CUDA 9, ich sehe, dass CuDNN, zu dem es passt, 7 ist ... Sie sehen, wohin ich gehe.

Ich kann mein Setup sicher an vielen Stellen hacken (und mit Ubuntu 16 wieder von vorne beginnen), nur ich bin so nah dran, der Fix soll nah sein... warum einen großen Sprung in die Vergangenheit machen, wenn ich es schaffen kann ein kleiner Sprung in die Zukunft!

Die PRs sind fast genehmigt. Sie befinden sich in der Überprüfung. Ich vermute noch ein paar

Wochen höchstens, aber diese Überprüfungen können Zeit in Anspruch nehmen. Ich denke das sind alle

Sie. Es könnte einen Nachzügler oder eine Änderung geben, um das EIGEN-Wechselgeld zu erhalten

CUDA 9. Ich habe sie nicht persönlich vorbereitet. Sie kommen sich jeden Tag näher.

https://github.com/tensorflow/tensorflow/pull/12504

https://github.com/tensorflow/tensorflow/pull/12503

https://github.com/tensorflow/tensorflow/pull/12502

Am Dienstag, 12. September 2017 um 19:49 Uhr, Remi Morin [email protected]

schrieb:

Gibt es einen Zweig / Tag, was wir auschecken und ausprobieren können?

Habe eine brandneue Installation gestartet, Ubuntu 17 ... dann neue gcc impose CUDA 9,

Ich sehe, dass CuDNN, zu dem passt, 7 ist ... Sie sehen, wohin ich gehe.

Ich kann mein Setup sicher an vielen Stellen hacken (und es von Grund auf neu starten .)

wieder mit Ubuntu 16) nur ich bin so nah dran, der Fix soll nah dran sein... warum

mache einen großen Sprung in die Vergangenheit, wenn ich einen kleinen Sprung in die Zukunft machen kann!—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-329041739 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesrpX6TSN6fVESEsql3QNtjgo-LM9ks5sh0KqgaJpZM4OuRL7

.

@tfboyd Ist das immer noch ein Problem? Ich habe festgestellt, dass cuda 9.0 erst heute veröffentlicht wurde.

cuda 9.0 wurde veröffentlicht, ich kann die cuda 8.0-Installationsdatei nicht finden....

pls upgrade tensorflow...

cuda 9.0 wurde veröffentlicht, ich kann die cuda 8.0-Installationsdatei nicht finden....

@thomasjo danke!

Wird tensorflow 1.3 nun, nachdem @tfboyd die von ihm erwähnten PRs genehmigt hat, mit CUDA 9 und cuDNN 7 kompatibel sein? Hat das jemand irgendwo tatsächlich erfolgreich installiert?

@voxmenthe Ich habe gerade versucht, tf1.3 mit CUDA 9.0 und cuDNN7 zu installieren. Ich habe den Fehler in dieser Ausgabe #12489 erhalten

EDIT: Im Grunde weiß ich nicht wie. Aber ohne weitere Änderungen in den Master-Zweig (der am Anfang nicht für mich installiert war) zu wechseln, konnte ich ihn installieren. Wenn ich jetzt versuche, Tensorflow zu importieren, heißt es jedoch, dass das Plattformmodul fehlt.

Gibt es einen Hinweis darauf, wie nahe die zugehörigen PRs sind? Ich habe cuDNN 7 installiert und dann festgestellt, dass es Probleme verursacht - ich kann auf v6 downgraden, dachte mir aber, ich könnte warten, wenn es kurz vor der Lösung steht ...

Die PRs scheinen genehmigt zu sein. Ich habe den Build seit ein paar Tagen nicht mehr selbst ausgeführt. Denken Sie daran, dass 1.3 diese Änderungen nicht haben würde, da dies schon eine Weile her ist. 1.4 hätte die Änderungen. Hoffentlich kann ich diese Woche die neuesten Versionen herunterladen und einen neuen Build erstellen. Ich vermute, jemand wird es gut machen, bevor ich Zeit habe.

Besteht die Möglichkeit, dass einer von euch schlauen Leuten ein Tutorial für TF 1.3 oder 1.4 mit CUDA v9.0, cudnn 7.0 für Win 10 x64 erstellt? Ich habe versucht, (Anaconda) zu installieren, erhalte jedoch weiterhin den Fehler '_pywrap_tensorflow_internal' und habe bereits überprüft, ob msvcp140.dll zu meinem Pfad hinzugefügt wurde.

@devilsnare007 : Ich denke, die besten Chancen sind, wenn Sie https://github.com/philferriere/dlwin folgen

Wird cuDNN 7.0 unterstützt, wenn TF 1.4 veröffentlicht wird?

@solice

Am Anfang (Stand vor ein paar Tagen) konnte ich CUDA 9 (Release-Version) mit cuDNN 7.0 ohne besondere Änderungen kompilieren und ein paar tf_cnn_benchmarks.py Tests auf einer GTX 1080 durchführen. Alles sieht gut aus. TF 1.4, das diese Woche RC haben sollte, wird CUDA 8- und cuDNN 6-Binärdateien enthalten, aber auch mit CUDA 9 und cuDNN 7 problemlos kompiliert werden. Das Ziel ist, dass TF 1.5 CUDA 9 und cuDNN 7 in der Binärdatei hat. Dies gibt den Benutzern Zeit, ihre Systembibliotheken zu aktualisieren, und mehr Zeit zum Testen. Wenn Sie Voltas verwenden, können Sie gerne einen anderen Thread starten und ich werde ihn aktualisieren, damit er in Echtzeit auf FP16 voranschreitet.

@tfboyd Toll zu hören, dass TF 1.4 mit cuDNN 7 kompiliert wird! Wenn Sie irgendwann Lust haben, eine Installationsanleitung zu erstellen, wäre dies ein großartiger öffentlicher Service für die DL-Community.

Kein Problem, das sollte einfach sein und ich versuche das gerne auszufüllen

Lücke.

Am Montag, 9. Oktober 2017 um 9:42 Uhr schrieb Jeff [email protected] :

@tfboyd https://github.com/tfboyd Toll zu hören, dass TF 1.4 kompiliert

mit cuDNN 7! Wenn Sie irgendwann Lust haben, eine Installationsanleitung zu erstellen, dann

wäre ein toller öffentlicher Dienst für die DL-Gemeinde.—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335212652 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesp7d2aT8gsGOWb6YjHH_CnpKXUIPks5sqkztgaJpZM4OuRL7

.

Gibt es eine Möglichkeit, eine Whl zu haben, die mit CUDA 9 und cuDNN 7.0 funktioniert?

Vielen Dank!

Ich werde meine veröffentlichen (die wahrscheinlich nicht 1.4 sein wird, aber einige, die fast übereinstimmen

und ich füge den Hash in den Namen ein), wenn ich ihn zum Testen baue, aber er wird

sein ubuntu 16.04 (ich habe vergessen, welche gcc-Version), Linux, Python 2.7 nur zur Information.

Und ich soll diese Builds nicht wirklich teilen, weil es sein kann

verwirrend für die Leute und ich werde betonen für alles, was Sie wissen, ich habe einige eingefügt

verrückte Hintertür. Obwohl sich das Hinzufügen eines Geheimcodes wie zu viel Arbeit anfühlt

mir.

Ich denke, Nightly-Gpu-Builds sind fast live in Pip (ich bin mir ziemlich sicher, dass sie

ist schon immer passiert, man musste sie nur finden) das heißt nach 1.4 die

Nightly Builds werden sehr schnell auf CUDA 9 + cuDNN 7 verschoben.

Am Montag, den 9. Oktober 2017 um 11:41 Uhr schrieb alexirae [email protected] :

Gibt es eine Möglichkeit, eine Whl zu haben, die mit CUDA 9 und cuDNN 7.0 funktioniert?

Vielen Dank!

—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335249979 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZeskJ5LXJwFcRpm-sKZ9QORoltrHOEks5sqmj1gaJpZM4OuRL7

.

@tfboyd Danke für deine Antwort. Endlich habe ich es geschafft, das neueste TF aus Quellen mit CUDA 8 + cuDNN 7-Unterstützung auf Ubuntu 16.04 zu erstellen und alles funktioniert gut auf GTX 1080 Ti.

@tfboyd Unterstützt 14.rc TF CuDNN 7 und CUDA 9?

Es ist enthalten, wenn Sie aus dem Quellcode erstellen. Ich möchte die Standardeinstellung ändern

Binärdateien, für die ich einige Regressionstests auf K80s auf AWS ausführen muss, um

Stellen Sie sicher, dass alles gut aussieht, und lassen Sie Builds erstellen. Wir

hatte sofort ein Problem, da der NVIDIA-Treiber eine verringerte Leistung benötigte

auf Kokoro, das in Google Cloud ausgeführt wird, um 30 %. Nichts ist gerade

vorwärts, aber CUDA 9 und cuDNN 7 sind in 1.4 Quelle und haben wie erwartet in

sehr begrenzte Tests auf Pascal für mich.

Am Do, 12. Oktober 2017 um 2:40 Uhr, Konstantin [email protected]

schrieb:

@tfboyd https://github.com/tfboyd Unterstützt 14.rc TF CuDNN 7 und

CUDA9?—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336075883 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesq03dvnXWd0GLXODBTNCWExlZGPnks5srd6pgaJpZM4OuRL7

.

Gibt es eine Möglichkeit, eine Whl zu haben, die mit CUDA 9, cuDNN 7.0 und Python 3.5 funktioniert?

Nachdem TF 1.4 fertiggestellt ist, werden die nächtlichen Builds in den CUDA 9 + verschoben

cuDNN 7 vorausgesetzt, es liegen keine Probleme vor. Builds, die ich zum Spaß gemacht und geteilt habe, sind

immer Python 2.7, weil dies die Standardeinstellung auf meinen Testsystemen ist.

Am Montag, 16. Oktober 2017 um 6:59 Uhr, Diego Stalder [email protected]

schrieb:

Gibt es eine Möglichkeit, ein Whl zu haben, das mit CUDA 9, cuDNN 7.0 und funktioniert?

Python 3.5?—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336894073 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesqgclWqET4OufQHV3FAD4XxgnZiKks5ss2E6gaJpZM4OuRL7

.

Irgendein voraussichtliches Erscheinungsdatum?

Alle, die an dem Stück kauen, bauen einfach #master aus dem Quellcode. Es ist nicht zu schwer (nur zeitaufwendig), Sie erhalten die neuesten CUDA/cuDNN, _und_ zusätzliche Optimierungen über eine pip/whl-Installation (siehe zB die CPU-Optimierungen in diesem Tutorial ). Außerdem können Sie beim nächsten CUDA/cuDNN-Upgrade erneut bauen, ohne warten zu müssen.

Aufbauend auf den Quellen arbeitet TF1.4 mit cuda 9.0, cuDNN v7.0.3 und python3.5

Kann ich auf der Win10-Plattform aus dem Quellcode erstellen?

Ich möchte, dass TF auf cuda 9.0, cuDNN v7, python3 arbeitet. 6 und win10

Aufbauend auf den Quellen funktioniert TF1.4 auch mit cuda 9.0, cuDNN v7.0.3 und python2.7.

@affromero Hatten Sie zufällig Probleme mit jsoncpp?

Ich habe einen Test von tf_cnn_benchmarks auf AWS-Building vom TF 1.4RC0-Zweig mit CUDA 9 / cuDNN 7 durchgeführt und die Ergebnisse waren gleich oder etwas schneller als CUDA 8 + cuDNN 6.

Bearbeiten: Erwähnung entfernen Ich habe den Kommentar von Elipeters nicht angesprochen. :-)

@elipeters

Wenn wir von „Building“ sprechen, meinen wir „Building from Source“ und nicht die Installation einer Wheel-Datei. Ein Rad ist bereits kompiliert und 1.4-Binärdateien unterstützen CUDA 8 + cuDNN 6. Um CUDA 9 zu erhalten, müssen Sie aus dem Quellcode erstellen. Windows habe ich noch nie gebaut. Sobald 1.4 ausgeliefert wird, wird das Team die nächtlichen Builds auf CUDA 9 umstellen.

Es gibt den 2. Release Candidate (rc1) für 1.4 als vorkompiliertes Rad ( https://pypi.python.org/pypi/tensorflow ). Hat das schon mal jemand mit CUDA 9 getestet?

Versucht, aber nicht mit funktionierendem cuda 9.0.

Ich werde es nochmal versuchen.

1.4 ist CUDA 8 + cuDNN 6 Dies funktioniert nicht mit CUDA 9 Sie müssen aus dem Quellcode kompilieren

Sobald 1.4 veröffentlicht ist, werden wir daran arbeiten, die nächtlichen Builds auf CUDA 9 umzustellen und dann wird 1.5 höchstwahrscheinlich CUDA 9 sein.

Ich weiß, dass CUDA 9 beim Erstellen von 1.4 aus dem Quellcode (ubuntu 16.04/python 2) gut funktioniert, weil ich letztes Wochenende Benchmarks auf AWS durchgeführt habe.

Ich habe ein aktuelles Rezept auf dem Aufbau von Quelle hier (bitte einen Link zu Ihrem CUDA 9.0 Rad auch dort posten , sobald Sie es bauen)

Du bist der beste Jaroslaw.

Am Mittwoch, 25. Oktober 2017 um 8:11 Uhr, Yaroslav Bulatov [email protected]

schrieb:

Ich habe hier ein aktuelles Rezept zum Bauen aus der Quelle

https://github.com/yaroslavvb/tensorflow-community-wheels (bitte posten

einen Link zu Ihrem CUDA 9.0-Laufrad dort auch, sobald Sie es gebaut haben)—

Sie erhalten dies, weil Sie erwähnt wurden.

Antworten Sie direkt auf diese E-Mail und zeigen Sie sie auf GitHub an

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-339361959 ,

oder den Thread stumm schalten

https://github.com/notifications/unsubscribe-auth/AWZesmRwb0UmLWxzANWCq5RrT6teYtr5ks5sv0-IgaJpZM4OuRL7

.

hallo, ich versuche, tensorflow gpu von win10 zu bauen, dann habe ich mich auch wie dieses Problem getroffen, kann mir jemand helfen, danke zuerst.

meine Umgebung:

win10 + gtx 1080ti + cuda 9.0 + cuDNN 7 + Visual Studio Profession 2015 + cmake 3.6.3 + Python 3.5.4

Wenn ich zu tensorflow r1.4 wechsle und von cmake in der Win10-Umgebung baue, ist das genau so:

`CUSTOMBUILD : Interner Fehler: Assertion fehlgeschlagen bei: "C:/dvs/p4/build/sw/rel/gpu_drv/r384/r384_00/drivers/compiler/edg/EDG_4.12/src/lookup.c", Zeile 2652 [ C:\TF\tensorflow\tensorflow\contrib\cmake\build\tf_core_gpu_kernels.vcxproj]

1 katastrophaler Fehler bei der Kompilierung von "C:/Users/ADMINI~1/AppData/Local/Temp/tmpxft_00000c94_00000000-8_adjust_contrast_op_gpu.cu.cpp4.ii" erkannt.

Kompilierung abgebrochen.

adjust_contrast_op_gpu.cu.cc

CUSTOMBUILD : nvcc error : 'cudafe++' mit Status 0xC0000409 gestorben [C:\TF\tensorflow\tensorflow\contrib\cmake\build\tf_core_gpu_kernels.vcxproj]

CMake-Fehler bei tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release. cmake:267 (Nachricht):

Fehler beim Generieren der Datei

C:/TF/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj`

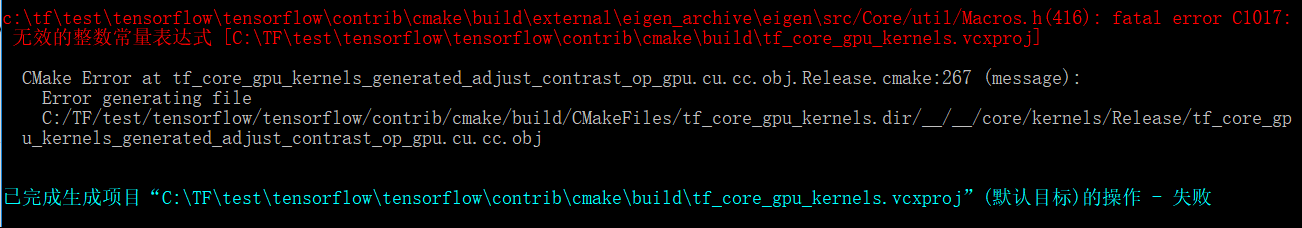

Das obige Problem sieht aus wie ein Problem mit cuda compolie selbst, aber wenn ich die Tensorflow-Version auf r1.3 umstelle, ist ein weiteres Problem aufgetreten:

`c:\tftest\tensorflow\tensorflow\contrib\cmake\build\external\eigen_archive\eigen\src/Core/util/Macros.h(416): fatal error C1017:

无效的整数常量表达式 [C:\TFtest\tensorflow\tensorflow\contrib\cmake\build\tf_core_gpu_kernels.vcxproj]

CMake-Fehler bei tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release. cmake:267 (Nachricht):

Fehler beim Generieren der Datei

C:/TF/test/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj`

Es sieht so aus, als hätte die Datei adjust_contrast_op_gpu.cu.cc ein Problem, aber ich kann keinen Fehler finden.

solche oben genannten Probleme beunruhigen mich einige Tage. Ich möchte, dass mir jemand hilft, diesen Versuch und Erfolg zu machen.

Hat jemand eine Whl für TensorFlow mit CUDA 9 und cuDNN 7.0 veröffentlicht?

@vellamike Ich weiß, dass Ihre Frage allgemein ist, aber das TF-Team wird CUDA 9 in den Binärdateien mit 1,5 haben, die im vierten Quartal landen sollten. Im Moment müssen Sie aus der Quelle erstellen.

Ich versuche, 1.4 mit CUDA 9 und cuDNN 7 in Mac 10.13 High Sierra zu erstellen. Ich bekomme immer diesen Fehler

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: output 'tensorflow/core/kernels/_objs/depthwise_conv_op_gpu/tensorflow/core/kernels/depthwise_conv_op_gpu.cu.pic.o' was not created.

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: not all outputs were created or valid.

Target //tensorflow/tools/pip_package:build_pip_package failed to build

Irgendeine Lösung dafür?

@smitshilu möglicherweise verwandt https://github.com/tensorflow/tensorflow/issues/2143

Warum hat 1.4 CUDA 9 immer noch nicht in Binärdateien? Diese Version wurde vor langer Zeit veröffentlicht und für die Verwendung mit V100 ist das Erstellen aus dem Quellcode erforderlich, was aufgrund einer Reihe von gemeldeten Problemen nicht so reibungslos und schnell funktioniert.

@ViktorM Welche Probleme hatten Sie beim Kompilieren aus dem Quellcode? Es war ein bisschen knifflig, aber nicht so schwer.

26-SEP-2017 war die GA für CUDA 9. Wenn wir CUDA 9 + cuDNN 7-Binärdateien im vierten Quartal veröffentlichen, denke ich, dass dies die schnellste Aktualisierung von cuDNN sein wird. Ich war zwischen 8,5 und 9 nicht hier, also habe ich keine Ahnung. Ich möchte, dass wir etwas schneller gehen, aber das bedeutet auch, dass jeder mit einem CUDA 8-Setup nicht nur auf CUDA 9 aktualisieren muss, sondern auch seinen Gerätetreiber auf 384.x aktualisieren muss, was ich sagen kann, ist nichts für Produktionsleute leicht nehmen.

Idealerweise hätten wir unendliche (oder nur ein paar mehr, aber die Matrix explodiert schnell) Builds, aber das ist ein weiteres Problem, dessen Erklärung lange dauern würde, und ich bezweifle, dass sich viele Leute darum kümmern.

Übrigens, ich habe mit CUDA 9 auf float16 matmul/V100 mit Nvidias NGC TensorFlow-Container 85 Tops/Sekunde beobachtet (im Gegensatz zu 8,8 Tops/s auf meiner GTX 1080 zu Hause). Ich freue mich wirklich darauf, diese Verbesserungen in der offiziell unterstützten Version zu haben!

@yaroslavvb Ganz ehrlich, wir arbeiten an einigen RP16-Problemen. Es gibt einen Pfad in den tf_cnn_benchmarks für FP16 und der Fokus liegt zuerst auf ResNet50 und wir arbeiten auch an der automatischen Skalierung für FP16. Sie können es bei Interesse ausprobieren, aber wir arbeiten aktiv an einigen Problemen. Die Leute sind drauf und es braucht nur Zeit. Wir haben endlich DGX-1s im Haus, damit wir auch mit den gleichen Containern spielen und versuchen können, die Leistung auf genau dieser Plattform im Auge zu behalten.

Ok, also werde ich Ubuntu 17.10 installieren und wollte nur die neuesten Sachen zum Spaß ausprobieren.

Bevor ich das tue, wollte ich nur wissen, ob jemand die folgenden Stapel aus der Quelle versucht hat und Glück hatte?

-> Ubuntu 17.10, CUDA 9.0, cuDNN 7.0, TF-Master

-> Ubuntu 17.10, CUDA 8.0, cnDNN 6.1, TF 1.4

Ich habe das gleiche Problem wie @xsr-ai, insbesondere mit Python 3.6.3, VS 2017, CUDA 9, cuDNN 7.

@aluo-x Du meinst, du hast es unter Windows 10 versucht? Angenommen, Sie sagten VS 2017.

Ja, das ist richtig. Hier der konkrete Fehler:

CustomBuild:

Building NVCC (Device) object CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

CMake Error at tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release.cmake:222 (message):

Error generating

C:/optimae/tensorflow-1.4.0/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

C:\Program Files (x86)\Microsoft Visual Studio\2017\BuildTools\Common7\IDE\VC\VCTargets\Microsoft.CppCommon.targets(171,5): error MSB6006: "cmd.exe" exited with code 1. [C:\optimae\tensorflow-1.4.0\

tensorflow\contrib\cmake\build\tf_core_gpu_kernels.vcxproj]

@aluo-x Hast du das neueste c-make verwendet? dh Release Candidate oder die stabile Version?

Verwenden von cmake 3.9.5, swig 3.0.12, CUDA 9.0.176, cuDNN 7.0.3. VS 2017 19.11.25547.

@aluo-x Auch ich hatte nicht viel Glück mit c-make. Aber können Sie versuchen, mit Bazel zu bauen?

@smitshilu Wenn ich mich nicht irre, erhalten Sie einen Fehler bezüglich der Ausrichtung, oder? Ähnlich wie hier für pytorch beschrieben: https://github.com/pytorch/pytorch/issues/2692

Ich habe versucht, die gleiche Lösung anzuwenden, dh alle ___align__(sizeof(T))_ aus den problematischen Dateien zu entfernen:

_tensorflow/core/kernels/concat_lib_gpu_impl.cu.cc_

_tensorflow/core/kernels/depthwise_conv_op_gpu.cu.cc_

_tensorflow/core/kernels/split_lib_gpu.cu.cc_

Ich bin mir nicht sicher, ob dies zu Problemen führt, aber es scheint bisher gut zu funktionieren. Und soweit ich weiß, wird die Laufzeit immer eine feste Ausrichtung von 16 für den gemeinsamen Speicher verwenden.

Für Interessierte haben wir CUDA 9 Räder hochgeladen. Sie müssen nicht selbst bauen! https://github.com/mind/wheels/releases/tag/tf1.4-gpu-cuda9

Ubuntu 17.10, CUDA 9, CuDNN 7, Python 3.6, Bazel 0.7.0 + TF aus dem Quellcode (Master).

Befolgen Sie die Anweisungen in dieser Antwort, um CUDA zum Laufen zu bringen:

https://askubuntu.com/questions/967332/how-can-i-install-cuda-9-on-ubuntu-17-10

Beachten Sie, dass Sie möglicherweise stattdessen diese Befehle für die 64-Bit-Version verwenden möchten:

sudo ln -s /usr/bin/gcc-6 /usr/local/cuda-9.0/bin/gcc

sudo ln -s /usr/bin/g++-6 /usr/local/cuda-9.0/bin/g++

sudo ./cuda_9.0.176_384.81_linux-run --override

Um Tensorflow zu installieren, benötigen Sie

- Vor dem Kompilieren von TF: Pfadvariablen richtig konfigurieren (die Pfade von der NVIDIA-Seite haben bei mir nicht funktioniert):

export PATH=/usr/local/cuda-9.0/bin:${PATH}

export LD_LIBRARY_PATH=${LD_LIBRARY_PATH}:/usr/local/cuda-9.0/lib64

- Vor dem Kompilieren: Konfigurieren Sie bazel so, dass dieselbe gcc-Version wie während der CUDA-Installation verwendet wird:

sudo update-alternatives --remove-all g++

sudo update-alternatives --remove-all gcc

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-6 10

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-6 10

- Wenn Sie den TF-Anweisungen folgen, sobald Sie zum Build-Schritt von Bazel gelangen, benötigen Sie ein zusätzliches Flag, um mit gcc-Version höher als 4.* zu kompilieren:

bazel build --config=opt --config=cuda --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0" //tensorflow/tools/pip_package:build_pip_package

@alexbrad Ich bin mit CUDA 9, cuDNN 7 auf das gleiche Problem beim Erstellen von Mac-GPUs gestoßen. Diese Lösung hat auch bei mir funktioniert und ich habe bisher keine Probleme mit TF gehabt.

Quelländerungen und Rad: https://github.com/nathanielatom/tensorflow/releases/tag/v1.4.0-mac

Ubuntu 16.04, TensorFlow 1.4 mit CUDA 9.0 und cuDNN 7.0.3 bereits installiert und getestet:

Installieren Sie Tensorflow 1.4 von Source

cd ~/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

- Konfigurieren für CUDA-Version: 9.0

- Für cuDNN-Version konfigurieren: 7.0.3

- Holen Sie sich Ihre Rechenleistung von https://developer.nvidia.com/cuda-gpus

- Ich habe dies auf 6.1 gesetzt, da ich eine GeForce GTX 1070 . habe

- Konfigurieren Sie andere Optionen nach Bedarf

./configure

Bazel installieren

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

TensorFlow aufbauen

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Der Name der obigen Tensorflow-Raddatei kann anders sein

Nur ls /tmp/tensorflow_pkg zum Überprüfen

Installationsschritte für Mac 10.13, CUDA 9 und tensorflow 1.4 https://gist.github.com/smitshilu/53cf9ff0fd6cdb64cca69a7e2827ed0f

Kann mir jemand sagen, wie ich ein tensorflow-whl-Paket aus Quellen für Windows in Linux (Ubuntu 16.04) mit Bazel erstellen kann? Es war für Version 1.2 möglich, wenn ich recht habe. Vielen Dank.

@ValeryPiashchynski Sie können diesen Schritten folgen https://www.tensorflow.org/install/install_sources

@smitshilu Danke für

~ @ValeryPiashchynski Ich glaube nicht, dass das möglich ist.~

(es herausnehmen, wie die Kommentare unten etwas anderes vorschlagen)

Cross-Building auf Ubuntu für Windows soll eines Tages per Clang möglich sein. Es wird wahrscheinlich viele Korrekturen erfordern, da Windows-Binärdateien derzeit mit MSVC erstellt werden. Ich habe im Grunde die gleiche Frage gestellt, als ich letzten Montag persönlich mit

Cross-Compilierung ist mit Bazel möglich, aber nicht sicher, wie es auf Tensorflow gemacht wird. Als Referenz

https://github.com/bazelbuild/bazel/wiki/Building-with-a-custom-toolchain

https://github.com/bazelbuild/bazel/issues/1353

Weiß jemand, ob die hier geposteten tensorflow 1.5 Nightly-Builds (win10-Builds) CUDA9 + CuDNN7-Unterstützung haben?

https://pypi.python.org/pypi/tf-nightly-gpu/1.5.0.dev20171115

Nebenbei bemerkt, es ist völlig unverantwortlich, dieses Ticket sowie #14126 zu schließen, nur weil Sie sagen "Es wird mit TF 1.5 veröffentlicht". MXNET 0.12 hat bereits CUDA9 FP16 in Produktion. Tensorflow und CNTK müssen sich beeilen. Davon profitiert nicht nur Volta.

Noch nicht, wir arbeiten daran, unsere Build-Infra für CUDA 9 zu aktualisieren.

Wir streben an, noch vor Ende dieser Woche Pip-Pakete mit CUDA 9 zu haben.

Ich habe zwei Computer und gestern installiere ich 1080ti und installiere alles (cuda8 und cudnn6), neuen Grafiktreiber, Visual Studio 2015

Ich vergleiche die Zeit der Epoche 1080ti mit 980ti

und ich sehe, dass 1080ti jede Epoche in 22 Minuten läuft, aber 980ti in 13 Minuten läuft !!! (Batch = 60 für 1080 vs Batch = 20 für 980ti)

warum 1080ti langsamer arbeitet als 980ti !!!! und wie kann ich überprüfen, was falsch ist?!

Was ist die Laufzeit, wenn Sie 20 Batch für 1080Ti verwenden?

@gunan , frage mich nur, ob es dafür eine neue ETA gibt?

@smitshilu

in 1080ti mit 20 Batch =26 min

und mit 60batch = 19min

in 980gtx mit Batch 20 = 14 min !!!!

Ich benutze Windows, installiere die letzte Treiberversion mit cuda 8 und cudnn 6

Wie kann ich herausfinden, warum es langsamer als 980 läuft?

@nasergh Hast du GTX 1080ti und 980ti in SLI?

@vickylance

Nein

zwei verschiedene Computer!

beide sind Cori7 und 1TB Festplatte und ich lade Datenabbilder von 1TB SATA HDD

aber in 980 habe ich Windows auf SSD-Festplatte

Ich versuche verschiedene Treiberversionen als letztes, was ich überprüfe 388.13, das von der Asus-Website mit CUDA 8 und Cudnn 6 heruntergeladen wurde

ich weiß nicht welche davon der grund sind

1- Fenster! vielleicht funktioniert es besser unter linux

2- HDD-Geschwindigkeit

3- gefälschte 1080TI

4- CUDA und cudnn nicht kompatibel mit 1080ti

5- CPU (CPU auf einem 1080TI-Computer ist leistungsstärker als 980)

was schlagen Sie vor ?

@nasergh

1) Ist der Arbeitsspeicher gleich? wenn ja. Ich bin mir nicht sicher, ob es sich so stark auswirkt, aber überprüfen Sie, ob die MHz des RAMs in beiden Systemen auch gleich sind.

2) Überprüfen Sie die GPU-Auslastung in % bei der Ausführung auf 980ti und 1080ti. Verwenden Sie dieses Tool, wenn Sie die GPU-Auslastung überprüfen möchten. https://docs.microsoft.com/en-us/sysinternals/downloads/process-explorer Es gibt bessere da draußen, aber das ist mir eingefallen.

3) Wenn Sie die beste Leistung erzielen möchten, würde ich vorschlagen, Ubuntu16.04 als Dual-Boot auf Ihrem 1080ti-System zu installieren und CUDA 9.0 und cuDNN 7.0 zu verwenden

4) Auch Windows beansprucht selbst eine Menge Systemressourcen, so dass es definitiv einen Vorteil hat, es auf einer SSD zu betreiben, aber nicht in dieser Größenordnung, wie in Ihrem Testszenario zu sehen ist.

Vielleicht liegt es an der gewählten Board-Architektur.

TF ist standardmäßig für 3.0, 3.5 und 5.2 konfiguriert; während 1080TI 6.1 (Pascal) und 980 5.2 (Maxwell) laut https://en.wikipedia.org/wiki/CUDA#GPUs_supported ist.

Vielleicht ist das Downgrade auf 3.0 oder 5.2 beim 1080TI nicht effizient, während es beim 980 nativ ist?

Versuchen Sie, mit beiden Funktionen 5.2 und 6.1 zu rechnen (siehe CMakeLists.txt l.232 und l.246)

De : nasergh [mailto:[email protected]]

Gesandter : mercredi 22. November 2017 17:17

À : Tensorflow/Tensorflow

Cc: sylvain-bougnoux; Handbuch

Objekt: Re: [tensorflow/tensorflow] Upgrade auf CuDNN 7 und CUDA 9 (#12052)

@vickylance

Nein

zwei verschiedene Computer!

beide sind Cori7 und 1TB Festplatte und ich lade Datenabbilder von 1TB SATA HDD

aber in 980 habe ich Windows auf SSD-Festplatte

Ich versuche verschiedene Treiberversionen als letztes, was ich überprüfe 388.13, das von der Asus-Website mit CUDA 8 und Cudnn 6 heruntergeladen wurde

ich weiß nicht welche davon der grund sind

1- Fenster! vielleicht funktioniert es besser unter linux

2- HDD-Geschwindigkeit

3- gefälschte 1080TI

4- CUDA und cudnn nicht kompatibel mit 1080ti

was schlagen Sie vor ?

—

Sie erhalten dies, weil Sie diesen Thread abonniert haben.

Antworten Sie direkt auf diese E-Mail, zeigen Sie sie auf GitHub an oder schalten Sie den Thread stumm.

Umgebung: cuda9.0+cudnn7.0+tf1.4,und ich treffe auf einen Fehler, wenn ich das "ptb"-Beispiel ausführe, TypeError: __init__() hat ein unerwartetes Schlüsselwortargument 'input_size' erhalten, 'input_size' ist der Parameter der CudnnLSTM

Nachdem ich diesen Thread monatelang beobachtet habe, werde ich ihn auf Gentoo Linux ausprobieren

Ich habe Asus Strix 1080TI

1- In Ubunto kann ich den Treiber auf der nvidia-Website verwenden oder ich muss von Asus herunterladen (weil ich keinen Treiber für Linux auf der Asus-Website sehe)

2- letzte Version ist in Ordnung oder ich muss 378.13 installieren, weil ich in den meisten Kommentaren sehe, dass sie 378.13 verwenden?

Danke

Für diejenigen unter Windows habe ich gerade TF 1.4.0, erstellt gegen CUDA 8.0.61.2, cuDNN 7.0.4, Python 3.6.3, mit AVX-Unterstützung in mein Repo hochgeladen. Hoffentlich reicht dies, bis CUDA 9 unter Windows aussortiert wird.

Ich versuche, CUDA9 und Cudnn 7 auf Ubuntu 16.04 und Python 3.6 zu installieren

aber ich bin gescheitert :(

Ich versuche alles, suche überall, gebe aber immer noch den gleichen Fehler "importError: libcublas.so.8.0 kann die Shared Object-Datei nicht öffnen: keine solche Datei oder kein solches Verzeichnis"

Ich denke, Tensor möchte CUDA8 ausführen

Wie kann ich ihm sagen, dass er cuda9 benutzen soll?!!!! Wenn die Antwort von der Quelle ausgeführt wird, wie genau? Ich habe keine sehr klare Website zum Erstellen aus der Quelle gesehen

Danke

Sie sollten tf von source@nasergh installieren

@mitme6696

Wie kann ich es von der Quelle installieren?

Ich weiß, dass ich eines davon herunterladen kann

https://github.com/mind/wheels/releases

aber ich weiß nicht, welches herunterladen und wie es installiert wird!?

@nasergh Lesen Sie unsere README- Datei für die Installation. Wenn es Ihnen nichts ausmacht, MKL zu installieren, können Sie dies tun

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-37/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Wenn Sie MKL nicht installieren möchten, können Sie dies tun

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-nomkl/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Ich werde dieses Problem als Tracking-Problem für den CUDA 9-Support verwenden.

Derzeit gibt es zwei Blocker:

1 - https://github.com/tensorflow/tensorflow/pull/14770

2 - Unter Windows sieht es so aus, als hätten wir einen Fehler mit NVCC. Das Erstellen von TF mit CUDA9 scheint mit einem Compiler-Absturz zu scheitern. NVIDIA hilft, dies zu untersuchen, und sobald wir ein Update haben, werden wir fortfahren.

@danqing

Vielen Dank

1- MKL wie viel verbessern die Geschwindigkeit?

2- in der Version ohne MKL muss ich MKL installieren?!

für 1 sehen Sie dies - beachten Sie, dass Berechnungen, die auf der GPU durchgeführt werden, offensichtlich nicht die Geschwindigkeit haben.

für 2 nicht. Stellen Sie sicher, dass Sie die richtige Version installieren.

Übrigens, das ist ein Thread mit vielen Abonnenten. Wenn Sie zukünftige Probleme mit unseren Rädern haben, öffnen Sie bitte ein Problem in unserem Repo, anstatt unten zu kommentieren, damit wir nicht viele Leute spammen.

@Tweakmind : Ich kann diesen Teil nicht bestehen:

TensorFlow aufbauen

bazel build --config=opt --config=cuda //tensorflow/tools/pip_ package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Die erste Zeile scheint unvollständig zu sein (doppelte Anführungszeichen fehlen)? Sind das drei Zeilen oder zwei Zeilen?

@goodmangu der richtige Code ist meiner Meinung nach:

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

Im Befehl fehlen doppelte Anführungszeichen.

Ich komme an diesem Teil mit dem Skript hier vorbei , werde jedoch durch einige cuda-Compilerfehler in https://github.com/tensorflow/tensorflow/issues/15108 blockiert

Danke Leute. Habe dies geschätzt. Ich habe es am selben Tag zum Laufen gebracht, indem ich stattdessen die nächtliche Build-Linux-Binärdatei verwendet habe. Siehe: https://github.com/tensorflow/tensorflow

Jetzt laufen 3 GTX 1080 Tis mit Keras. Cool!

Ich habe die letzten zwei Tage damit verbracht, Tensorflow aus dem Quellcode (r1.4) für mein MacBook Pro mit einer eGPU zu erstellen. Treiber funktioniert, mit Cuda 8.0, cuDNN 6.0, Mac OSX Sierra 10.12. Kurz vor dem Ende, aber nach 20 Minuten durch einige Build-Fehler blockiert. Hat jemand bisher Glück gehabt? Irgendein erfolgreich erstelltes Paket, das Sie teilen können? Danke im Voraus.

@goodmangu Könnten Sie bitte angeben, welche "die nächtliche Build-Linux-Binärdatei" Sie verwenden?

Klar, dieser hier: tf_nightly_gpu-1.head-cp27-none-linux_x86_64.whl

Immer noch keine Windows 10-Unterstützung für Cuda 9.0 + cuDNN 7.0? Nur verifizieren.

Tensorflow-GPU 1.4.0

@goodmangu Ich habe es mit 1.4 versucht, aber OSX 10.13 und CUDA 9 cuDNN 7. Schritte findest du hier

@eeilon79 es gibt einen nvcc-Fehler unter Windows, der uns daran hindert, Binärdateien zu erstellen. Wir erhalten Hilfe von nvidia, um diese Probleme zu beheben.

Gibt es ein Update für CUDA 9 in der Tensorflow Nightly Version (1.5-dev) unter dem tf-nightly-gpu pip-Paket? Diese 1.5 muss für CuDNNLSTM in Keras verwendet werden

OK, die PR wird gerade zusammengeführt.

In ca. 10-12 Stunden sollten unsere neuen Nightlies mit cuda9 gebaut sein, bis auf Fenster.

Unter Windows werden wir immer noch durch einen NVCC-Fehler blockiert.

Ich habe das allgemeine CUDA 9- und CUDANN 7-Paket für das Gentoo-System fertiggestellt und einen Dummy-Test ausprobiert und sieht aus, als würde ich mit Dummy-Import Tensorflow als tf in Python arbeiten, aber ich muss zusätzliche Tests durchführen:

Ich verwende Commit: c9568f1ee51a265db4c5f017baf722b9ea5ecfbb

Unter Windows werden wir immer noch durch einen NVCC-Fehler blockiert.

Würde es Ihnen etwas ausmachen, den Link zu diesem Thema hier zu posten? Danke im Voraus!

@smitshilu Dein Artikel hat mir geholfen.

Und ich habe einen Artikel mit einigen hinzugefügten Elementen geschrieben.

https://github.com/masasys/MacTF1.4GPU

@arbynacosta

ich renne

bazel build --config=opt --config=cuda //tensorflow/tools/pip_ package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

aber ich bekomme diesen fehler

Fehler: Der Build-Befehl wird nur innerhalb eines Arbeitsbereichs unterstützt.

Ich versuche auch jeden Abend Tensor, aber es gibt einen Fehler

attributeerror : Modul 'tensorflow' hat kein Attribut ....

Ausgabe von dir(tf)

['__doc__', '__loarder__', '__name__', __Paket__' '__Pfad__ __spec__]

Sorry @goodmangu , ich war weg. Hast du es zum Laufen gebracht? Ich habe die abschließenden doppelten Anführungszeichen verpasst, wie @arbynacosta darauf hingewiesen hat. Ich habe dies jetzt unter Ubuntu 17.10 mit CUDA 9.0 und cuDNN 7.0.4 laufen. Ich kann bei Bedarf an einem MacOS-Build arbeiten. Ich habe sowohl auf Win10 als auch auf MacOS gerettet, kann aber dieses Wochenende daran arbeiten, wenn die Leute es brauchen.

@nasergh , führen Sie diesen Befehl aus dem geklonten Tensorflow-Verzeichnis aus. Stellen Sie sicher, dass WORKSPACE im Verzeichnis vorhanden ist.

Zum Beispiel:

~/Downloads/tensorflow$ ls

ACKNOWLEDGMENTS bazel-bin bazel-testlogs configure LICENSE tensorflow WORKSPACE

ADOPTERS.md bazel-genfiles BUILD configure.py models.BUILD third_party

arm_compiler.BUILD bazel-out CODE_OF_CONDUCT.md CONTRIBUTING.md README.md tools

AUTHORS bazel-tensorflow CODEOWNERS ISSUE_TEMPLATE.md RELEASE.md util

@Tweakmind

ich führe den Befehl aus

sudo su

und dann gehe zum Tensorflow-Ordner (da war eine Arbeitsbereichsdatei drin)

aber ich bekomme diese fehler

root<strong i="10">@pc</strong>:/home/pc2/tensorflow# bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

..........

WARNING: Config values are not defined in any .rc file: opt

ERROR: /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD:4:1: Traceback (most recent call last):

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD", line 4

error_gpu_disabled()

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/error_gpu_disabled.bzl", line 3, in error_gpu_disabled

fail("ERROR: Building with --config=c...")

ERROR: Building with --config=cuda but TensorFlow is not configured to build with GPU support. Please re-run ./configure and enter 'Y' at the prompt to build with GPU support.

ERROR: no such target '@local_config_cuda//crosstool:toolchain': target 'toolchain' not declared in package 'crosstool' defined by /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD

INFO: Elapsed time: 6.830s

FAILED: Build did NOT complete successfully (2 packages loaded)

currently loading: @bazel_tools//tools/jdk

@nasergh Bitte stellen Sie sicher, dass Sie alle Anweisungen hier befolgen:

https://www.tensorflow.org/install/install_sources

Wenn Sie mit GPU-Unterstützung bauen, stellen Sie sicher, dass Sie entsprechend konfigurieren.

Installieren Sie Tensorflow 1.4 von Source.

- Zum jetzigen Zeitpunkt funktioniert es nur so mit CUDA 9.0 und cuDNN 7.0

- Anleitung: https://www.tensorflow.org/install/install_sources

- Einige der Anweisungen sind möglicherweise nicht sinnvoll, so habe ich es gemacht:

cd $HOME/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

./configure

Die Beispielausgabe und die Optionen unterscheiden sich von denen in der Anleitung

- Stellen Sie sicher, dass Sie für die CUDA-Version konfigurieren: 9.0

- Stellen Sie sicher, dass Sie für die cuDNN-Version konfigurieren: 7.0.4

- Stellen Sie sicher, dass Sie Ihre Rechenkapazität kennen unter https://developer.nvidia.com/cuda-gpus

- Ich habe dies auf 6.1 gesetzt, da ich eine GeForce GTX 1070 . habe

Bazel installieren

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

TensorFlow aufbauen

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

@Tweakmind : gemeldet haben . Ja, ich habe es für Ubuntu zum Laufen gebracht und habe immer noch kein Glück mit Mac OSX (10.12.6) mit einer eGPU (1080 Ti). Bei allen Quellen, denen ich gefolgt bin, schlug der Build nach etwa 10-15 Minuten fehl. Es wäre toll, wenn wir einen reproduzierbaren Erfolg hätten. Danke im Voraus.

@Tweakmind

Ich folge und konfiguriere auch die Datei, aber sie sagt

pc2<strong i="7">@pc</strong>:~/Downloads/tensorflow$ bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: Skipping '//tensorflow/tools/pip_package:build_pip_package': error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

WARNING: Target pattern parsing failed.

ERROR: error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

INFO: Elapsed time: 0.082s

FAILED: Build did NOT complete successfully (0 packages loaded)

currently loading: tensorflow/tools/pip_package

ich glaube ich installiere cuda und cudnn richtig

```

find /usr | grep libcudnn

/usr/share/doc/libcudnn7

/usr/share/doc/libcudnn7/copyright

/usr/share/doc/libcudnn7/NVIDIA_SLA_cuDNN_Support.txt

/usr/share/doc/libcudnn7/changelog.Debian.gz

/usr/share/lintian/overrides/libcudnn7

/usr/lib/x86_64-linux-gnu/libcudnn.so.7.0.4

/usr/lib/x86_64-linux-gnu/libcudnn.so.7

```

@goodmangu , ich werde am Wochenende am MacOS-Build arbeiten.

@nasergh , Hast du cuDNN installiert?

Hier ist mein Leitfaden für cuDNN einschließlich der Quelle und der Dokumente zum Testen der Installation:

cuDNN 7.0.4-Dateien herunterladen

Sie müssen sich in Ihrem Browser bei Ihrem Nvidia-Entwicklerkonto anmelden

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/cudnn-9.0-linux-x64-v7

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64

Überprüfen Sie jeden Hash

cd $HOME/Downloads

md5sum cudnn-9.0-linux-x64-v7.tgz && \

md5sum libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

Ausgabe sollte sein:

fc8a03ac9380d582e949444c7a18fb8d cudnn-9.0-linux-x64-v7.tgz

e986f9a85fd199ab8934b8e4835496e2 libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

4bd528115e3dc578ce8fca0d32ab82b8 libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

04ad839c937362a551eb2170afb88320 libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

cuDNN 7.0.4 und Bibliotheken installieren

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

cuDNN verifizieren

Ubuntu 17.10 enthält Version 7+ der GNU-Compiler

CUDA ist nicht kompatibel mit höher als Version 6

Der zurückgegebene Fehler lautet:

error -- nicht unterstützte GNU-Version! gcc-Versionen nach 6 werden nicht unterstützt!

Fix - Installieren Sie Version 6 und erstellen Sie symbolische Links im CUDA bin-Verzeichnis:

sudo apt-get install gcc-6 g++-6

sudo ln -sf /usr/bin/gcc-6 /usr/local/cuda/bin/gcc

sudo ln -sf /usr/bin/g++-6 /usr/local/cuda/bin/g++

Erstellen Sie jetzt mnistCUDNN, um cuDNN zu testen

cp -r /usr/src/cudnn_samples_v7/ $HOME

cd $HOME/cudnn_samples_v7/mnistCUDNN

make clean && make

./mnistCUDNN

Wenn cuDNN richtig installiert ist, sehen Sie:

Test bestanden!

Lieber @Tweakmind

dein Weg funktioniert danke für deine Hilfe (ich habe mehr als 3 Wochen versucht, Tensor zu installieren!!!)

Das Problem ist, dass ich es auf Python3.6 installiere und jetzt ein Problem mit dem PIL-Paket habe

Traceback (most recent call last):

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 551, in get

inputs = self.queue.get(block=True).get()

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 644, in get

raise self._value

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 119, in worker

result = (True, func(*args, **kwds))

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 391, in get_index

return _SHARED_SEQUENCES[uid][i]

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 761, in __getitem__

return self._get_batches_of_transformed_samples(index_array)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 1106, in _get_batches_of_transformed_samples

interpolation=self.interpolation)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 345, in load_img

raise ImportError('Could not import PIL.Image. '

ImportError: Could not import PIL.Image. The use of `array_to_img` requires PIL.

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File "<stdin>", line 7, in <module>

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/models.py", line 1227, in fit_generator

initial_epoch=initial_epoch)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/engine/training.py", line 2115, in fit_generator

generator_output = next(output_generator)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 557, in get

six.raise_from(StopIteration(e), e)

File "<string>", line 3, in raise_from

StopIteration: Could not import PIL.Image. The use of `array_to_img` requires PIL.

Ich versuche, Kissen zu installieren, aber es hilft nicht

Ich versuche auch, PIL zu installieren, aber

UnsatisfiableError: The following specifications were found to be in conflict:

- pil -> python 2.6*

- python 3.6*

@nasergh Was bekommen Sie mit:

pip install pillow

Meine sieht aus wie:

~$ pip install pillow

Requirement already satisfied: pillow in ./anaconda3/lib/python3.6/site-packages

@nasergh , ich muss abstürzen, aber ich

@goodmangu , ich kann den Mac-Build über das Wochenende nicht

@Tweakmind - Danke! , haben Sie mit CUDA 9 und cuDNN 7 eine Leistungssteigerung festgestellt?

Außerdem denke ich, dass einige Schritte, die von @Tweakmind unten erwähnt werden, überflüssig sind, Sie benötigen entweder:

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

oder

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

@gunan

CUDA 9.1.85 wurde gerade erst mit CuDNN 7.0.5 veröffentlicht, mit Fehlerbehebungen für den nvcc-Compiler. Ich frage mich, ob es Win10-Benutzern ermöglicht, Tensorflow 1.4.1 zu kompilieren? Es ist an der Zeit.

Aus unserer Korrespondenz mit NVIDIA glaube ich nicht, dass 9.1 dieses Problem behoben hat.

Wir haben jedoch Workarounds. Zuerst müssen wir diesen PR in eigen zusammenführen:

https://bitbucket.org/eigen/eigen/pull-requests/351/win-nvcc/diff

Dann werden wir unsere Eigenabhängigkeit aktualisieren, die alle unsere Builds für CUDA9 beheben sollte

Der pr wird abgelehnt, aber er scheint manuell zusammengeführt zu werden. Müssen wir auf ein eigenes Release warten oder wird es von den Quellen gebaut?

Cool, dann wird es auf Nightly Pip sein?

@Tweakmind

Ich versuche, den Tensor mit Python 2.7 neu aufzubauen

aber in bazel build erhalte ich diesen fehler

Ich installiere auch numpy, aber keine Änderung.

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: /home/gh2/Downloads/tensorflow/util/python/BUILD:5:1: no such package '@local_config_python//': Traceback (most recent call last):

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 310

_create_local_python_repository(repository_ctx)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 274, in _create_local_python_repository

_get_numpy_include(repository_ctx, python_bin)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 257, in _get_numpy_include

_execute(repository_ctx, [python_bin, "-c",..."], <2 more arguments>)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 76, in _execute

_python_configure_fail("\n".join([error_msg.strip() if ... ""]))

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 37, in _python_configure_fail

fail(("%sPython Configuration Error:%...)))

Python Configuration Error: Problem getting numpy include path.

Traceback (most recent call last):

File "<string>", line 1, in <module>

**ImportError: No module named numpy**

Is numpy installed?

and referenced by '//util/python:python_headers'

ERROR: Analysis of target '//tensorflow/tools/pip_package:build_pip_package' failed; build aborted: Loading failed

INFO: Elapsed time: 10.826s

FAILED: Build did NOT complete successfully (26 packages loaded)

currently loading: tensorflow/core ... (3 packages)

Fetching http://mirror.bazel.build/.../~ooura/fft.tgz; 20,338b 5s

Fetching http://mirror.bazel.build/zlib.net/zlib-1.2.8.tar.gz; 19,924b 5s

Fetching http://mirror.bazel.build/.../giflib-5.1.4.tar.gz; 18,883b 5s

Es scheint, dass OSX in Version 7.0.5 von cuDNN ausgeschlossen ist. Kennt jemand eine genaue Sache?

Ich kann tensorflow-gpu immer noch nicht in Windows 10 (mit CUDA 9.0.176 und cudnn 7.0) zum Laufen bringen.

Ich habe sowohl tensorflow als auch tensorflow-gpu deinstalliert und neu installiert (mit dem --no-cache-dir, um sicherzustellen, dass die neueste Version mit dem eigenen Workaround heruntergeladen wird). Wenn ich beide installiere, wird meine GPU nicht erkannt:

InvalidArgumentError (Traceback siehe oben): Kann kein Gerät für Operation 'random_uniform_1/sub' zuweisen: Operation wurde explizit / device:GPU :0 zugewiesen, aber verfügbare Geräte sind [ / job:localhost/replica :0/ task:0/device : CPU:0 ]. Stellen Sie sicher, dass sich die Gerätespezifikation auf ein gültiges Gerät bezieht.

Wenn ich nur tensorflow-gpu installiere, beschwert es sich über eine fehlende DLL:

ImportError: 'cudart64_80.dll' konnte nicht gefunden werden. TensorFlow erfordert, dass diese DLL in einem Verzeichnis installiert wird, das in Ihrer Umgebungsvariablen %PATH% benannt ist. Laden Sie CUDA 8.0 von dieser URL herunter und installieren Sie es: https://developer.nvidia.com/cuda-toolkit

Was seltsam ist, da meine CUDA-Version 9.0 und nicht 8.0 ist und erkannt wird (deviceQuery-Test bestanden).

Meine Python-Version ist 3.6.3. Ich versuche, diesen Code in Spyder (3.2.4) auszuführen, um tensorflow-gpu zu testen.

Was habe ich verpasst?

Ich versuche, von Bazel auf Win 7 aus dem Quellcode zu bauen, bekomme Fehler

Kein Toolcahin für CPU 'x64_windows'

Kann jeder whl bauen?

@hadaev8 , ich brauche viel mehr Informationen, um zu helfen. Ich kann an einer Whl arbeiten, aber es wird starke Abhängigkeiten haben und nicht Win7. Sobald ich MacOS gelöst habe, werde ich Win10 lösen. Poste auf jeden Fall deine Daten.

@eeilon79 , ich muss dies unter Win10 neu erstellen. Ich konzentriere mich derzeit auf MacOS, da Ubuntu gelöst ist. Ich werde auf Win 10 zurückkommen.

@nasergh , gibt es eine Voraussetzung für Python 2.7?

Mit CUDA 8.0 und cuDNN 6.0 habe ich TensorFlow aus dem Quellcode für die Cuda-GPU- und AVX2-Unterstützung in Win10 installiert:

Anforderungen:

* Windows 10 64-Bit

* Visual Studio 15 C++ Tools

* NVIDIA CUDA® Toolkit 8.0

* NVIDIA cuDNN 6.0 for CUDA 8.0

* Cmake

* Swig

Installieren Sie Visual Studio Community Edition Update 3 mit Windows Kit 10.0.10240.0

Folgen Sie den Anweisungen unter: https://github.com/philferriere/dlwin (Danke Phil)

Erstellen Sie ein virtuelles Laufwerk N: aus Gründen der Übersichtlichkeit