システムインフォメーション

- カスタムコードを作成しましたか(TensorFlowで提供されているストックサンプルスクリプトを使用するのではなく) :いいえ

- OSプラットフォームとディストリビューション(例:Linux Ubuntu 16.04) :Windows Server 2012

- (ソースまたはバイナリ)からインストールされたTensorFlow :バイナリ

- TensorFlowバージョン(以下のコマンドを使用) :1.3.0-rc1

- Pythonバージョン:3.5.2

- Bazelバージョン(ソースからコンパイルする場合) :N / A

- CUDA / cuDNNバージョン:CUDA V8.0.44、CuDNN 6.0

- GPUモデルとメモリ:Nvidia GeForce GTX 1080 Ti、11 GB

- 再現する正確なコマンド:N / A

問題を説明する

TensorFlowをアップグレードしてCUDA9とCuDNN7をサポートしてください。Nvidiaは、これによりPascalGPUのパフォーマンスが2倍向上すると主張しています。

全てのコメント170件

@tfboydこれについて何かコメントはありますか?

cuDNN 7はまだプレビューモードであり、作業中です。 1.3のcuDNN6.0に移行しましたが、数週間で最終版になります。 興味があれば、cuDNN1.3.0rc2をダウンロードできます。 まだcuDNN7またはCUDA9でコンパイルしていません。 CUDA 9はすべてのプラットフォームにインストールするのは簡単ではなく、一部のインストールパッケージしか利用できないと聞きました。 ライブラリが最終的になったら、最終評価を開始します。 NVIDIAはまた、これらの新しいライブラリの側面をサポートするために、主要なMLプラットフォームにパッチを送信し始めたばかりであり、追加の作業があると思います。

編集:CUDA 9をすべてのプラットフォームにインストールするのは簡単ではなく、代わりにcuDNNと言いました。 また、追加の作業があると思われる作業があることを確認しました。 私が残した私の愚かな声明の残りの部分、例えば私はcuDNN7が昨日ライブになったことに気づいていませんでした。

あなたがウェブサイトをどのように読むべきかを言っていない。 しかし、pascalで2倍高速になるのは、CUDA8リリースの一部のようです。 サイトの読み方次第だと思います。 NVIDIAは、CUDA 9がPascalを(すべてにおいて)2倍高速化することについては言及していません。何でも可能ですが、そうなるとは思いません。

https://developer.nvidia.com/cuda-toolkit/whatsnew

このサイトは少し紛らわしいですが、引用しているセクションはCUDA 8の下にネストされていると思います。これについてのみ言及しているので、リリースに非現実的な期待はありません。 Voltaの場合、私が理解していることからいくつかの大きな利益があるはずです。人々はVoltaのエンジニアリングサンプルを入手して、完全なリリースの準備をするための高レベルの作業を開始していると思います。

@tfboyd cuDNN 7は、昨日よりプレビューモードではなくなりました。 CUDA8.0とCUDA9.0RCの両方で正式にリリースされました。

ああ、私はそれを逃した。 @sclarksonに感謝し、間違った情報をお詫びします。

最終的にgcc6はCUDA9でサポートされ、Ubuntu 17.04が付属しているので、ぜひ試してみます。

運が良ければスレッドに知らせてください。 私は個人的に始めたばかりです

cuDNN 6を完全にテストします(内部的には多くのテストが行われていますが、私はまだテストされていません

個人的に使用する)。 私はしばしば最新のものにアップグレードするのが遅いです。 私の

推測では、すべてが取得されるまで、cuDNN7で実際の変更が見られない可能性があります

最新のAPIを使用するようにパッチが適用されました。 私はすべて間違っていることをもう一度強調したい

当時の。 私が部外者として見たのは、新しいcuDNNバージョンが追加することです

新しいメソッド/ API。 面白いものもあれば、すぐにはないものもあります

使える。 次に、それらのAPIはTensorFlow APIを介して公開されるか、単に使用されます

既存のメソッドを高速化するための舞台裏。 私の非常に高いレベル

理解はcuDNN7 + CUDA 9は、に焦点を当ててFP16サポートを強化します

ボルタ。 主な焦点の1つは、モデルを取得する方法だと思います(多くは

いくつか)FP16と収束するために、無限に正しいことを推測する必要はありません

使用するconfig / hyperparameters。 これが私のやり方であることを強調したい

会話を理解しました、そして私は間違っているか半分正しいかもしれません。

ストレス:追加する必要があると思う方法がある場合(または

パフォーマンス)cuDNNからTensorFlowに、私たちは常にリストに関心があります。

内部的には、これはcuDNN 6で発生し、実装に重点を置きました。

機能チームは、プロジェクトに役立つことを望んでいると述べました。

午前8時46分AMに土、2017年8月5日には、Courtialフロリアン[email protected]

書きました:

最終的にgcc6がCUDA9でサポートされ、

Ubuntu17.04に付属しています。—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320450756 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZessKqj_nPY1br9SD9L9SX-8Kf5Dbtks5sVI5TgaJpZM4OuRL7

。

追加する方法について言えば、cudnn7からのグループ畳み込みはビジョンコミュニティにとって重要な機能です。

かっこいい私が始めているリストにそれを追加します。 忘れるかもしれませんがお気軽に

私がいくつかのガイダンスを提供できるある種のリストを公開することを私に思い出させるために

何に取り組んでいる可能性が高いかについて。 それは約束ではありませんが、私たちは望んでいます

フィードバックにより、人々が何を望んでいて何を必要としているかに優先順位を付けることができます。 Yuxinありがとうございます。

12時26分PMに土、2017年8月5日には、渝信呉[email protected]は書きました:

追加するメソッドと言えば、cudnn7からのグループ畳み込みは

ビジョンコミュニティにとって重要な機能。—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

。

CUDA8を使用してcuDNN7でコンパイルしようとしましたが、失敗しました。

期待の。 NVIDIAから届くパッチがあります。

物事を。 誰かが試みているなら、ただ注意してください。

2017年8月5日土曜日午後1時47分、Toby [email protected]は次のように書いています。

かっこいい私が始めているリストにそれを追加します。 忘れるかもしれませんがお気軽に

私がいくつかのガイダンスを提供できるある種のリストを公開することを私に思い出させるために

何に取り組んでいる可能性が高いかについて。 それは約束ではありませんが、私たちは望んでいます

フィードバックにより、人々が何を望んでいて何を必要としているかに優先順位を付けることができます。 Yuxinありがとうございます。12時26分PMに土、2017年8月5日には、渝信呉[email protected]

書きました:追加するメソッドと言えば、cudnn7からのグループ畳み込みは

ビジョンコミュニティにとって重要な機能。—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

。

CUDA8 / 9を実行してcuDNN7を取得しようとしています。 CUDA8はGTX1080Tiではサポートされていません-少なくともインストーラーはそう言っています^^

私はそれを一緒に実行するのに大きな問題を抱えています。 私がすでに試したことを要約したこの素晴らしい記事を指摘したいと思います: //nitishmutha.github.io/tensorflow/2017/01/22/TensorFlow-with-gpu-for-windows.html

CUDAの例は、両方のセットアップの組み合わせでVisual-Studioを介して機能しています。

Visual-Studioを使用してコンパイルされたdeviceQuery.exeの出力は次のとおりです。

PS C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release> deviceQuery.exe

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release\deviceQuery.exe Starting...

CUDA Device Query (Runtime API) version (CUDART static linking)

Detected 1 CUDA Capable device(s)

Device 0: "GeForce GTX 1080 Ti"

CUDA Driver Version / Runtime Version 9.0 / 9.0

CUDA Capability Major/Minor version number: 6.1

Total amount of global memory: 11264 MBytes (11811160064 bytes)

(28) Multiprocessors, (128) CUDA Cores/MP: 3584 CUDA Cores

GPU Max Clock rate: 1683 MHz (1.68 GHz)

Memory Clock rate: 5505 Mhz

Memory Bus Width: 352-bit

L2 Cache Size: 2883584 bytes

Maximum Texture Dimension Size (x,y,z) 1D=(131072), 2D=(131072, 65536), 3D=(16384, 16384, 16384)

Maximum Layered 1D Texture Size, (num) layers 1D=(32768), 2048 layers

Maximum Layered 2D Texture Size, (num) layers 2D=(32768, 32768), 2048 layers

Total amount of constant memory: 65536 bytes

Total amount of shared memory per block: 49152 bytes

Total number of registers available per block: 65536

Warp size: 32

Maximum number of threads per multiprocessor: 2048

Maximum number of threads per block: 1024

Max dimension size of a thread block (x,y,z): (1024, 1024, 64)

Max dimension size of a grid size (x,y,z): (2147483647, 65535, 65535)

Maximum memory pitch: 2147483647 bytes

Texture alignment: 512 bytes

Concurrent copy and kernel execution: Yes with 2 copy engine(s)

Run time limit on kernels: Yes

Integrated GPU sharing Host Memory: No

Support host page-locked memory mapping: Yes

Alignment requirement for Surfaces: Yes

Device has ECC support: Disabled

CUDA Device Driver Mode (TCC or WDDM): WDDM (Windows Display Driver Model)

Device supports Unified Addressing (UVA): Yes

Supports Cooperative Kernel Launch: No

Supports MultiDevice Co-op Kernel Launch: No

Device PCI Domain ID / Bus ID / location ID: 0 / 1 / 0

Compute Mode:

< Default (multiple host threads can use ::cudaSetDevice() with device simultaneously) >

deviceQuery, CUDA Driver = CUDART, CUDA Driver Version = 9.0, CUDA Runtime Version = 9.0, NumDevs = 1, Device0 = GeForce GTX 1080 Ti

Result = PASS

@tfboyd NvideaからのcuDNNアップデートを確認するリンクはありますか?

@ 4F2E4A2E 1080Tiは間違いなく

みなさん、こんにちは。cuda8.0でgtx 1080tiを使用しています。 tensorflow-gpuをインストールしようとしていますが、cuDNN 5.1、6.0、または7.0を使用しますか?

今のところ5.1を使い続けることをお勧めします。 私はいくつかのより深いパフォーマンスを実行しています

6でテストし、理解するためにさらにテストが必要な混合結果を取得します。

2017年8月6日午後9時30分、「colmantse」 [email protected]は次のように書いています。

みなさん、こんにちは。cuda8.0でgtx 1080tiを使用しています。 インストールしようとしています

tensorflow-gpu、cuDNN 5.1、6.0、または7.0を使用しますか?—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320566071 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZeshvEFsdeWz-1uyzl_L6HE15E0BzSks5sVpLlgaJpZM4OuRL7

。

おかげで、私はcudnn 6.0で試しましたが、動作しません。ダミーのtf-gpuインストールが原因だと思います。 cudnn5.1はpython3.6で動作します

@tpankajありがとうございます! CUDA8とcuDNN5.1で実行しています

cuDNN7の機能の完全なセットは次のとおりです。

主な機能と機能強化

このcuDNNリリースには、次の主要な機能と拡張機能が含まれています。

テンソルコア

cuDNNのバージョン7.0.1は、その中でTensorCore操作をサポートする最初のバージョンです。

実装。 テンソルコアは、高度に最適化された行列乗算を提供します

従来の同等の数値動作を持たないビルディングブロック

したがって、命令の数値的な動作はわずかに異なります。

cudnnSetConvolutionMathType、cudnnSetRNNMatrixMathType、および

cudnnMathType_t

cudnnSetConvolutionMathTypeおよびcudnnSetRNNMatrixMathType

関数を使用すると、でTensorCore操作を使用するかどうかを選択できます

数学モードをいずれかに設定することにより、それぞれ畳み込み層とRNN層

CUDNN_TENSOR_OP_MATHまたはCUDNN_DEFAULT_MATH。

Tensor Core演算は、複数の並列浮動小数点累積を実行します

浮動小数点製品。

数学モードをCUDNN_TENSOR_OP_MATHに設定すると、ライブラリが使用することを示します

テンソルコア操作。

デフォルトはCUDNN_DEFAULT_MATHです。 このデフォルトは、TensorCoreが

操作はライブラリによって回避されます。 デフォルトのモードはシリアル化された操作です

一方、Tensor Coreは並列化された操作であるため、2つの結果が生じる可能性があります

操作の順序が異なるため、数値結果がわずかに異なります。

Tensor Coreの操作が行われると、ライブラリはデフォルトの数学モードにフォールバックします。

サポートされていないか、許可されていません。

cudnnSetConvolutionGroupCount

アプリケーションが畳み込みグループを実行できるようにする新しいインターフェイス

1回のAPI呼び出しで畳み込みレイヤー。

cudnnCTCLoss

cudnnCTCLossは、コネクショニスト時時のGPU実装を提供します

RNNの分類(CTC)損失関数。 CTC損失関数は次の目的で使用されます

音声および手書き認識における音素認識。

CUDNN_BATCHNORM_SPATIAL_PERSISTENT

CUDNN_BATCHNORM_SPATIAL_PERSISTENT関数は新しいバッチです

cudnnBatchNormalizationForwardTrainingの正規化モード

およびcudnnBatchNormalizationBackward。 このモードはに似ています

CUDNN_BATCHNORM_SPATIALただし、一部のタスクでは高速になる場合があります。

cudnnQueryRuntimeError

cudnnQueryRuntimeError関数は、GPUによって記述されたエラーコードを報告します

cudnnBatchNormalizationForwardTrainingを実行するときのカーネル

およびcudnnBatchNormalizationBackward

CUDNN_BATCHNORM_SPATIAL_PERSISTENTモード。

cudnnGetConvolutionForwardAlgorithm_v7

この新しいAPIは、期待されるパフォーマンスでソートされたすべてのアルゴリズムを返します

(内部ヒューリスティックを使用)。 これらのアルゴリズムは、次のように出力されます。

cudnnFindConvolutionForwardAlgorithm。

cudnnGetConvolutionBackwardDataAlgorithm_v7

この新しいAPIは、期待されるパフォーマンスでソートされたすべてのアルゴリズムを返します

(内部ヒューリスティックを使用)。 これらのアルゴリズムは、次のように出力されます。

cudnnFindConvolutionBackwardAlgorithm。

cudnnGetConvolutionBackwardFilterAlgorithm_v7

この新しいAPIは、期待されるパフォーマンスでソートされたすべてのアルゴリズムを返します

(内部ヒューリスティックを使用)。 これらのアルゴリズムは、次のように出力されます。

cudnnFindConvolutionBackwardFilterAlgorithm。

CUDNN_REDUCE_TENSOR_MUL_NO_ZEROS

MUL_NO_ZEROS関数は、乗算の削減であり、

データ。

CUDNN_OP_TENSOR_NOT

OP_TENSOR_NOT関数は、

(alpha * A)。

cudnnGetDropoutDescriptor

cudnnGetDropoutDescriptor関数を使用すると、アプリケーションでドロップアウトを取得できます

値。

さて、私はCUDA 9 RC + cuDNN7.0の「ブログ」のような新しい問題を始めることを考えています。 一緒にパッチが適用されている「手元に」TFビルドがありますが、CUDA9RCとcuDNN7.0であり、誰かがそれを試すことに興味があるかどうかを確認したいと思います。 また、共有できない奇妙な理由がないことを確認する必要があります。 TensorFlowが使用する一部のアップストリームライブラリに変更を加える必要がありますが、近い将来、NVIDIAからPRが提供されるようになります。 私とチームは、VoltaでCUDA 8 + cuDNN 6をテストし、次にFP32コードを使用してVolta(V100)でCUDA 9RC + cuDNN7をテストすることができました。 私はLinuxビルドとPython2.7のみを行っていますが、興味のある方は、cuDNN6.0よりもコミュニティに参加してみてください。 あまり面白くないかもしれませんが、私は情報を提供しているだけでなく、私たちが一緒にいるように感じさせたいと思っています。 また、現在取り組んでいる機能のリストを作成したいのですが、cuDNN 7(および6.0)には期待できません。 @ cancan101完全なリストをありがとう。

@tfboyd :CUDA 9.0RC + cuDNN7.0の実行について説明していただければ幸いです。 私は奇妙なシステム(TF1.3、CUDA 8.0、cuDNN 6.0gcc-4.8を搭載したubuntu17.10ベータ版)を使用していますが、cuda9とcudnn7へのアップグレードは実際にはコンパイラーとしては素晴らしいでしょう。

私はあなたがあなた自身を構築するために必要なものを手に入れるために私が何ができるかを見ていきます

バイナリ。 パフォーマンスチームのリーダーは、私がこれを実現しようと試みることができることを示しました

透明性を高め、コミュニティとしてもっと楽しくなることを願っています。

パッチの入手方法とその作成方法はそれほど難しくはありませんが、少しです

もっと強く。 管理する時間がないので、それはまた非常に非公式になります

ブランチとパッチは非常に速くビット腐敗する可能性があります(きれいに適用されません)。 NS

パッチは、関係者全員がの変更に問題がないことを確認するために使用されました

一般的に、私は個々のPRが入り始めることを期待しています。

5時22分AMで金、2017年8月11日には、Erlend Aune [email protected]

書きました:

@tfboyd https://github.com/tfboyd :説明をいただければ幸いです

CUDA 9.0RC + cuDNN7.0の実行について。 私は自分で奇妙なシステムを使用しています(ubuntu

17.10ベータ版(TF1.3、CUDA 8.0、cuDNN 6.0 gcc-4.8)、およびアップグレード

cuda9とcudnn7は、実際にはコンパイラーとしては素晴らしいでしょう。—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321798364 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesj4WRkFKNX-Nt2oKtvp0oyQVBtM5ks5sXEdqgaJpZM4OuRL7

。

@tfboyd :興味があります。どのように共有しますか? ブランチ?

@tfboyd私も間違いなくとても興味があります。 ありがとう!

今週それを理解しようとしています。 ロジスティクスは私より難しいことがよくあります

考える。

2017年8月12日午前10時18分、「TanmayBakshi」 [email protected]は次のように書いています。

@tfboydhttps ://github.com/tfboyd私は間違いなく非常に興味があります

良い。 ありがとう!—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321994065 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesjO42Rl1WCyW0KR22KgbydKh1O4Zks5sXd6AgaJpZM4OuRL7

。

Python 2.7が好きな場合は、手順とバイナリを試してみてください。 作成した問題を更新して作業を追跡するため、これを閉じます。 @ tanmayb123 @Froskekongen

コンパイル済みのtensorflow-gpu-1.3.0for Python3.6をWindowsx64にインストールしてみて、cuDNNライブラリバージョン7.0とCuda 8.0を提供しましたが、少なくとも私にとってはすべてが機能しているようです。 例外や問題は発生していません。

これは予想されることですか? cuDNN7.0はcuDNN6.0と下位互換性がありますか? これは問題につながる可能性がありますか?

@apacha私はそれがうまくいったことに少し驚いています。 以前のテストで、TensorFlowバイナリが名前でcuDNNを検索し、*。soファイルの名前に6.0 / 7.0が含まれているため、cuDNNが見つからないというエラーを確認しました。 リモートで可能ですが、cuDNN6がまだパスに残っています。 私はあなたのセットアップについて推測するのは好きではありませんが、私が賭けをしているなら、それはまだcuDNN6を使用していると言うでしょう。

特定のバージョンを探すためにコンパイルされている下位互換性のないTensorFlowに関して。 知らない。

最後に、それは大したことではありません。 cuDNN 7 PRはほぼ承認/マージされており、事前にコンパイルされたバイナリは1.5以降cuDNN7に移行する可能性があります。

CUDA9RCおよびcuDNN7への進捗状況に関する更新

- NVIDIAのPRはほぼ承認されています

- EIGENの変更が承認され、統合されました

- FP16テストがV100(Volta)で本格的に開始されました

@tfboyd完全を期すために:以前はcuDNN 5を使用していましたが、tensorflow 1.3に更新する必要があったため、cuDNNバージョン7に切り替えて試してみました。 cudnn64_5.dllを明示的に削除しましたが、CUDAインストールパスにcudnn64_6.dllがありません。 多分それはWindowsの魔法です。 :-NS

1つ注意してください:私はまだ9.0ではなくCUDA8.0を使用しています。

@apachaそれは窓の魔法かもしれません。 わからなかったので、判断力を発揮したくありませんでした。 cuDNN呼び出しは変更されるべきではなかったため、下位互換性がありそうなので、Windowsマジックは可能だと思います。 Linuxビルドの場合、TensorFlowは特定のファイル(またはエラーが発生したときの外観)を探しており、cudnnblahblah.6.soが見つからない場合は非常に不満です。 アップデートと詳細をありがとう。

チェックアウトして試してみることができるブランチ/タグはありますか?

まったく新しいインストール、Ubuntu17を開始しました...次に新しいgccがCUDA9を課します。適合するCuDNNは7であることがわかります...あなたは私が向かっているところを見ることができます。

私は確かに多くの場所でセットアップをハックすることができます(そしてUbuntu 16で最初からやり直すことができます)ちょうど私はとても近いです、修正は近いと言われています...私が作ることができればなぜ過去に大きなジャンプをするのですか?将来的には小さなジャンプです!

PRはほぼ承認されています。 彼らはレビュー中です。 もう少し疑う

せいぜい数週間ですが、これらのレビューには時間がかかる場合があります。 これらはすべてだと思います

彼ら。 EIGENの変更を取得するためのストラグラーまたは変更がある可能性があります

CUDA9。私はそれらを個人的に準備していません。 彼らは毎日近づいています。

https://github.com/tensorflow/tensorflow/pull/12504

https://github.com/tensorflow/tensorflow/pull/12503

https://github.com/tensorflow/tensorflow/pull/12502

2017年9月12日火曜日午後7時49分、レミモーリン[email protected]

書きました:

チェックアウトして試してみることができるブランチ/タグはありますか?

まったく新しいインストール、Ubuntu 17を開始しました...その後、新しいgccがCUDA9を課します

適合するCuDNNは7であることがわかります...あなたは私が向かっているところを見るでしょう。

私は確かに多くの場所で私のセットアップをハックすることができます(そしてそれを最初から始めることができます

再びUbuntuで16)ちょうど私はとても近いです、修正は近いと言われています...なぜ

将来小さなジャンプができれば、過去に大きなジャンプをしてください!—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-329041739 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesrpX6TSN6fVESEsql3QNtjgo-LM9ks5sh0KqgaJpZM4OuRL7

。

@tfboydこれはまだ問題ですか? cuda9.0が本日リリースされたことに気づきました。

cuda 9.0がリリースされましたが、cuda8.0インストールファイルが見つかりません...。

plsアップグレードテンソルフロー...

cuda 9.0がリリースされましたが、cuda8.0インストールファイルが見つかりません...。

@thomasjoありがとう!

それで、 @ tfboydが彼が言及したPRを承認した後、

@voxmenthe CUDA9.0と

編集:基本的に、私は方法がわかりません。 しかし、それ以上変更せずにマスターブランチ(最初はインストールしていませんでした)に移動すると、インストールすることができました。 ただし、テンソルフローをインポートしようとすると、プラットフォームモジュールが欠落していると表示されます。

関連するPRがどれだけ近づいているかを示すものはありますか? cuDNN 7をインストールしたところ、問題が発生していることに気付きました。v6にダウングレードできますが、解決に近づいたら待つかもしれないと考えました...

PRは承認されたようです。 私は数日で自分でビルドを実行していません。 1.3には、しばらく前のようにこれらの変更がないことに注意してください。 1.4に変更があります。 今週、最新バージョンをダウンロードして、新しいビルドを実行できることを願っています。 時間がある前に誰かがそれをうまくやるだろうと私は思う。

あなたの賢い人の誰かが、CUDA v9.0、Win 10x64用のcudnn7.0でtf1.3または1.4のチュートリアルを作成している可能性はありますか? (Anaconda)をインストールしようとしましたが、「_ pywrap_tensorflow_internal」エラーが発生し続け、msvcp140.dllがパスに追加されていることを確認しました。

@ devilsnare007 : //github.com/philferriere/dlwinをフォローするのが最善のチャンスだと思います。 リストされているバージョンを現在のバージョンに置き換えるだけです。 TF1.4はまだリリースされていないことに注意してください。 ただし、TF 1.3は、提供されている手順で正常に機能するはずです。 すべてがアップグレードされ、TF 1.4がリリースされたら、そのチュートリアルを更新します。

TF1.4がリリースされたときにcuDNN7.0はサポートされますか?

@soloice

頭の中で(数日前の時点で)、特別な変更を加えずにcuDNN7.0でCUDA9(リリースバージョン)をコンパイルし、GTX1080でいくつかのtf_cnn_benchmarks.pyテストを実行しました。すべて正常に見えます。 今週RCする必要があるTF1.4にはCUDA8とcuDNN6のバイナリがありますが、CUDA9とcuDNN7でも問題なくコンパイルされます。目標はTF1.5のバイナリにCUDA9とcuDNN7が含まれることです。 これにより、システムライブラリをアップグレードするための時間と、テストのためのより多くの時間が与えられます。 Voltasを実行している場合は、別のスレッドを自由に開始してください。FP16でリアルタイムに進行するように更新します。

@tfboyd TF1.4がcuDNN7でコンパイルされると聞いてうれしいです! ある時点でインストールガイドを作成することに気が付いたら、それはDLコミュニティにとって素晴らしい公共サービスになるでしょう。

問題ありません、それは十分に簡単なはずです、そして私はそれを埋めることを喜んで試みます

ギャップ。

9:42で月、2017年10月9日には、ジェフの[email protected]は書きました:

@tfboyd https://github.com/tfboyd TF1.4がコンパイルされると聞いて

cuDNN 7で! ある時点で、インストールガイドを作成することに気が付いた場合は

DLコミュニティにとって素晴らしい公共サービスになるでしょう。—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335212652 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesp7d2aT8gsGOWb6YjHH_CnpKXUIPks5sqkztgaJpZM4OuRL7

。

CUDA9およびcuDNN7.0で動作するwhlを持つ可能性はありますか?

ありがとう!

私は私のものを公開します(1.4ではない可能性がありますが、いくつかのほぼ一致します

テスト用にビルドするときに名前にハッシュを含めますが、

ubuntu 16.04(gccのバージョンを忘れています)、linux、python2.7を参考にしてください。

そして、私はそれらのビルドを共有することを本当に想定していません。

人々を混乱させると私はあなたが知っているすべてのために私がいくつかを含めたことを強調します

クレイジーバックドア。 秘密のコードを追加するのは大変な作業のように感じますが

私に。

毎晩のGPUビルドはほとんどピップでライブだと思います(私はそれらがかなり確信しています

いつも起こっているので、あなたはそれらを見つけなければなりませんでした)つまり、1.4以降は

ナイトリービルドは非常に迅速にCUDA9 + cuDNN7に移行します。

月曜、11:41 AMで2017年10月9日、alexiraeに[email protected]書きました:

CUDA9およびcuDNN7.0で動作するwhlを持つ可能性はありますか?

ありがとう!

—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335249979 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZeskJ5LXJwFcRpm-sKZ9QORoltrHOEks5sqmj1gaJpZM4OuRL7

。

@tfboydお返事ありがとうございます。 最後に、Ubuntu16.04でCUDA8 + cuDNN 7をサポートするソースから最新のTFを構築することができ、GTX 1080Tiではすべてが正常に機能します。

@tfboyd 14.rcTFはCuDNN7とCUDA9をサポートしていますか?

ソースからビルドする場合に含まれます。 デフォルトを変更したい

AWS上のK80でいくつかの回帰テストを実行する必要があるバイナリ

ビルドを作成するだけでなく、すべてが見栄えがよいことを確認してください。 私たち

NVIDIAドライバーがパフォーマンスの低下を必要としていたため、すぐに問題が発生しました

Google Cloudで実行されているココロで30%。 すべてがまっすぐなわけではありません

フォワードですが、CUDA9とcuDNN7は1.4ソースであり、期待どおりに

私にとってPascalでの非常に限られたテスト。

2:40の木、2017年10月12日には、コンスタンチン[email protected]

書きました:

@tfboyd https://github.com/tfboyd 14.rcTFはCuDNN7をサポートしていますか

CUDA 9?—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336075883 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesq03dvnXWd0GLXODBTNCWExlZGPnks5srd6pgaJpZM4OuRL7

。

CUDA 9、cuDNN 7.0、Python 3.5で動作するwhlを持つ可能性はありますか?

TF 1.4が完成した後、ナイトリービルドはCUDA 9+に移行します。

問題がないと仮定した場合のcuDNN7。 私が作成して楽しみのために共有したビルドは

これは私のテストシステムのデフォルトであるため、常にpython2.7です。

6:59で月、2017年10月16日には、ディエゴ・Stalder [email protected]

書きました:

CUDA 9、cuDNN 7.0、およびで動作するwhlを持つ可能性はありますか

Python 3.5?—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336894073 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesqgclWqET4OufQHV3FAD4XxgnZiKks5ss2E6gaJpZM4OuRL7

。

リリース予定日はありますか?

これらはすべて、ソースから#masterをビルドするだけです。 それほど難しくはありません(時間がかかるだけです)。最新のCUDA / cuDNNを取得し、pip / whlインストールで追加の最適化を行います(たとえば、このtutのCPU最適化を参照してください)。 さらに、次回CUDA / cuDNNをアップグレードするときに、待つことなく再構築できます。

ソースから構築されたTF1.4は、cuda 9.0、cuDNN v7.0.3、およびpython3.5で動作します。

win10プラットフォームのソースからビルドできますか?

TFをcuda9.0、cuDNN v7、python3で動作させたい。 6 、およびwin10

ソースから構築されたTF1.4は、cuda 9.0、cuDNN v7.0.3、およびpython2.7でも動作します。

@affromero偶然jsoncppに問題がありましたか?

CUDA 9 / cuDNN7を使用してTF1.4RC0ブランチからAWSビルドでtf_cnn_benchmarksのテストを行いましたが、結果はCUDA 8 + cuDNN6と同等かわずかに高速でした。

編集:私がエリペターのコメントに対処していなかったという言及を削除します。 :-)

@elipeters

ビルドとは、ホイールファイルをインストールせずにソースからビルドすることを意味します。 ホイールはすでにコンパイルされており、1.4バイナリはCUDA 8 + cuDNN 6をサポートしています。CUDA9を入手するには、ソースからビルドする必要があります。 私はWindowsのビルドを行ったことがありません。 1.4が出荷されると、チームはナイトリービルドをCUDA9に切り替えます。

プリコンパイルされたホイールとして1.4outの2番目のリリース候補(rc1)があります(https://pypi.python.org/pypi/tensorflow)。 誰かがCUDA9でそれをテストしましたか?

試してみましたが、動作中のcuda9.0では動作しませんでした。

もう一度やり直します。

1.4はCUDA8 + cuDNN6です。これはCUDA9では機能しません。ソースからコンパイルする必要があります。

1.4がリリースされたら、ナイトリービルドをCUDA 9に切り替え、1.5がCUDA9になる可能性が高くなります。

先週末AWSでベンチマークを行っていたので、ソース(ubuntu 16.04 / python 2)から1.4をビルドするときにCUDA9が正常に機能することを知っています。

ここにソースからのビルドに関する最近のレシピがあります(ビルドしたら、CUDA 9.0ホイールへのリンクもそこに投稿してください)

あなたは最高のヤロスラフです。

8:11の水、2017年10月25日には、ヤロスラフBulatov [email protected]

書きました:

ここにソースから構築するための最近のレシピがあります

https://github.com/yaroslavvb/tensorflow-community-wheels (投稿してください

CUDA 9.0ホイールへのリンクも、ビルドしたらそこにあります)—

あなたが言及されたのであなたはこれを受け取っています。

このメールに直接返信し、GitHubで表示してください

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-339361959 、

またはスレッドをミュートします

https://github.com/notifications/unsubscribe-auth/AWZesmRwb0UmLWxzANWCq5RrT6teYtr5ks5sv0-IgaJpZM4OuRL7

。

こんにちは、私はwin10envによってtensorflowgpuを構築しようとしました、それから私もこの問題のように会いました、誰かが私を助けることができます、最初に感謝します。

私の環境:

win10 + gtx 1080ti + cuda 9.0 + cuDNN 7+ビジュアルスタジオの職業2015+ cmake 3.6.3 + python 3.5.4

tensorflow r1.4に切り替えて、win10環境でcmakeでビルドすると、次のようになります。

`CUSTOMBUILD:内部エラー:アサーションが失敗しました:" C:/dvs/p4/build/sw/rel/gpu_drv/r384/r384_00/drivers/compiler/edg/EDG_4.12/src/lookup.c "、行2652 [ C:\ TF \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

「C:/Users/ADMINI~1/AppData/Local/Temp/tmpxft_00000c94_00000000-8_adjust_contrast_op_gpu.cu.cpp4.ii」のコンパイルで1つの壊滅的なエラーが検出されました。

コンパイルが中止されました。

Adjust_contrast_op_gpu.cu.cc

CUSTOMBUILD:nvccエラー: 'cudafe ++'がステータス0xC0000409で終了しました[C:\ TF \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.ReleaseでのCMakeエラー。 cmake:267 (メッセージ):

ファイルの生成中にエラーが発生しました

C:/TF/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir / __ / __ / core / kernels / Release / tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj`

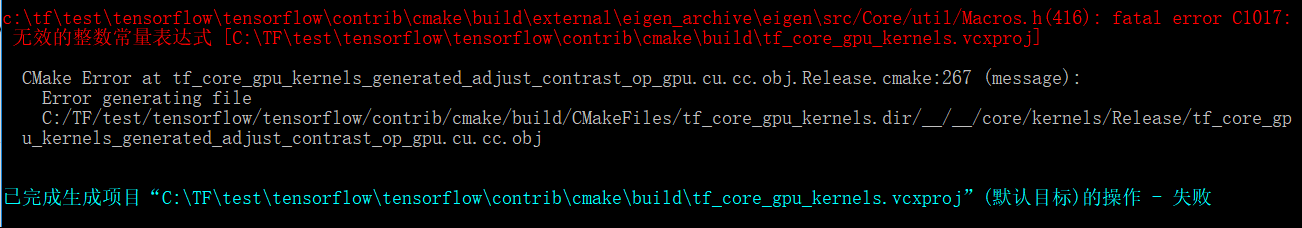

上記の問題は、cuda compolie自体の問題のように見えますが、tensorflowバージョンをr1.3に切り替えると、別の問題が発生します。

`c:\ tftest \ tensorflow \ tensorflow \ contrib \ cmake \ build \ external \ eigen_archive \ eigen \ src / Core / util / Macros.h(416):致命的なエラーC1017:

⾾式[C:\ TFtest \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.ReleaseでのCMakeエラー。 cmake:267 (メッセージ):

ファイルの生成中にエラーが発生しました

C:/TF/test/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir / __ / __ / core / kernels / Release / tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj`

ファイルadjust_contrast_op_gpu.cu.ccに問題があるようですが、エラーが見つかりません。

そのような上記の問題は私を数日悩ませます、誰かが私がこの試みと成功をするのを手伝ってくれることを望みます、そしてグーグルアップグレードテンソルフローサポートcuda9.0とcudnn7をwin10環境で強く期待します。

誰かがCUDA9とcuDNN7.0でTensorFlowのwhlをリリースしましたか?

@vellamikeあなたの質問は一般的だと思いますが、TFチームはバイナリにCUDA 9を持ち、1.5は第4四半期に着陸するはずです。 今のところ、ソースからビルドする必要があります。

Mac 10.13 HighSierraでCUDA9とcuDNN7を使用して1.4をビルドしようとしています。 このエラーが発生し続けます

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: output 'tensorflow/core/kernels/_objs/depthwise_conv_op_gpu/tensorflow/core/kernels/depthwise_conv_op_gpu.cu.pic.o' was not created.

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: not all outputs were created or valid.

Target //tensorflow/tools/pip_package:build_pip_package failed to build

これに対する解決策はありますか?

@smitshilu関連する可能性がありますhttps://github.com/tensorflow/tensorflow/issues/2143

1.4がまだバイナリにCUDA9を持っていないのはなぜですか? このバージョンはかなり前にリリースされており、ソースからのV100ビルドで使用するには、報告されている多くの問題に続いてそれほどスムーズで高速ではないことが必要です。

@ViktorMソースからコンパイルする

2017年9月26日はCUDA9のGAでした。第4四半期にCUDA9 + cuDNN 7バイナリをリリースした場合、これはcuDNNをアップグレードした中で最速になると思います。 私は8.5から9の間ここにいなかったので、私にはわかりません。 もう少し速くしたいのですが、これは、CUDA 8をセットアップしている人は、CUDA 9だけでなく、デバイスドライバーを384.xにアップグレードする必要があることも意味します。これは、実稼働環境の人々ではないと言えます。軽く取ってください。

理想的には、無限の(またはほんの少しだけですが、マトリックスは速く爆発します)ビルドがありますが、それは説明に時間がかかる別の問題であり、多くの人が気にかけているとは思えません。

@yaroslavvb非常に正直に言って、私たちはいくつかのFP16の問題に取り組んでいます。 FP16のtf_cnn_benchmarksにパスがあり、最初にResNet50に焦点が当てられており、FP16の自動スケーリングにも取り組んでいます。 興味のある方はぜひお試しくださいが、いくつかの問題に積極的に取り組んでいます。 人々はそれに乗っており、それはただ時間がかかっています。 ついにDGX-1が社内に導入されたので、同じコンテナーで遊んだり、その正確なプラットフォームでのパフォーマンスを追跡したりすることもできます。

さて、Ubuntu 17.10をインストールします。最新のものをすべて試して、楽しみたいと思いました。

私がする前に、誰かがソースから構築された以下のスタックを試し、運が良かったことを知りたかっただけですか?

-> Ubuntu 17.10、CUDA 9.0、cuDNN 7.0、TFマスター

-> Ubuntu 17.10、CUDA 8.0、cnDNN 6.1、TF 1.4

@ xsr-aiと同じ問題が発生しています。具体的には、Python 3.6.3、VS 2017、CUDA 9、cuDNN7を使用しています。

@ aluo-x Windows 10で試したということですか? あなたがVS2017と言ったからだと仮定します。

はい、その通りです。 特定のエラーは次のとおりです。

CustomBuild:

Building NVCC (Device) object CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

CMake Error at tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release.cmake:222 (message):

Error generating

C:/optimae/tensorflow-1.4.0/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

C:\Program Files (x86)\Microsoft Visual Studio\2017\BuildTools\Common7\IDE\VC\VCTargets\Microsoft.CppCommon.targets(171,5): error MSB6006: "cmd.exe" exited with code 1. [C:\optimae\tensorflow-1.4.0\

tensorflow\contrib\cmake\build\tf_core_gpu_kernels.vcxproj]

@ aluo-x最新のc-makeを使用しましたか? すなわち、リリース候補または安定版リリース?

cmake 3.9.5、swig 3.0.12、CUDA 9.0.176、cuDNN7.0.3を使用します。 VS 201719.11.25547。

@ aluo-xc-makeはあまり運がなかった。 しかし、Bazelでビルドしてみることができますか?

@smitshilu私が間違っていなければ、位置合わせに関してエラーが発生しますよね? ここでpytorchについて説明したものと同様です: https :

私は同じ解決策を適用しようとしました。つまり、問題のあるファイルからすべての___align __(sizeof(T))_を削除します。

_tensorflow / core / kernels / concat_lib_gpu_impl.cu.cc_

_tensorflow / core / kernels / depthwise_conv_op_gpu.cu.cc_

_tensorflow / core / kernels / split_lib_gpu.cu.cc_

これが問題を引き起こすかどうかはわかりませんが、これまでのところ正常に機能しているようです。 そして私が理解していることから、ランタイムは常に共有メモリに16の固定配置を使用します。

興味のある方のために、CUDA9ホイールをアップロードしています。 自分で構築する必要はありません! https://github.com/mind/wheels/releases/tag/tf1.4-gpu-cuda9

Ubuntu 17.10、CUDA 9、CuDNN 7、Python 3.6、bazel 0.7.0 +ソース(マスター)からのTF。

この回答の指示に従って、CUDAを稼働させます。

https://askubuntu.com/questions/967332/how-can-i-install-cuda-9-on-ubuntu-17-10

64ビットバージョンの代わりに、次のコマンドを使用することをお勧めします。

sudo ln -s /usr/bin/gcc-6 /usr/local/cuda-9.0/bin/gcc

sudo ln -s /usr/bin/g++-6 /usr/local/cuda-9.0/bin/g++

sudo ./cuda_9.0.176_384.81_linux-run --override

Tensorflowをインストールするには、次のものが必要です

- TFをコンパイルする前に:パス変数を正しく構成します(NVIDIAページからのパスは私には機能しませんでした):

export PATH=/usr/local/cuda-9.0/bin:${PATH}

export LD_LIBRARY_PATH=${LD_LIBRARY_PATH}:/usr/local/cuda-9.0/lib64

- コンパイルする前に:CUDAインストール時と同じgccバージョンを使用するようにbazelを構成します。

sudo update-alternatives --remove-all g++

sudo update-alternatives --remove-all gcc

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-6 10

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-6 10

- bazelビルドステップノートに到達したらTFの指示に従いますが、4より古いバージョンのgccでコンパイルするには追加のフラグが必要です。*:

bazel build --config=opt --config=cuda --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0" //tensorflow/tools/pip_package:build_pip_package

@alexbrad CUDA 9、cuDNN7を使用したMacGPUの同じ問題の構築に遭遇しました。このソリューションも機能し、これまでTFを使用して問題が発生したことはありません。

ソースの変更とホイール: https :

Ubuntu 16.04、CUDA9.0およびcuDNN7.0.3を搭載したTensorFlow1.4がすでにインストールされ、テストされています。

ソースからTensorflow1.4をインストールします

cd ~/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

- CUDAバージョン用に構成:9.0

- cuDNNバージョン用に構成:7.0.3

- https://developer.nvidia.com/cuda-gpusからコンピューティング機能を入手して

- 私はGeForceGTX 1070を持っているので、これを6.1に設定しました

- 必要に応じて他のオプションを構成します

./configure

Bazelのインストール

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

TensorFlowの構築

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

上記のテンソルフローホイールファイルの名前は異なる場合があります

確認するのはls /tmp/tensorflow_pkgだけです

Mac 10.13、CUDA 9、およびtensorflow1.4のインストール手順https://gist.github.com/smitshilu/53cf9ff0fd6cdb64cca69a7e2827ed0f

誰かが教えてもらえますか、Linux(Ubuntu 16.04)のWindows用ソースからbazelを使用してtensorflow whlパッケージをビルドするにはどうすればよいですか? 私が正しければ、バージョン1.2でも可能でした。 ありがとう。

@ValeryPiashchynski次の手順に従うことができますhttps://www.tensorflow.org/install/install_sources

@smitshiluお答えいただきありがとうございます。 この手順に従ってUbuntuでホイールパッケージをビルドできますが、Ubuntuではすべて正常に機能します。 しかし、そのwhlパッケージをWindows OSにインストールすることはできません(エラーがあります:サポートされていないホイールです)。 だから私の質問は、UbuntuでパッケージをビルドしてWindowsにインストールできるようにする方法です。

〜 @ ValeryPiashchynskiそれは不可能だと思います。〜

(以下のコメントがそうでないことを示唆しているようにそれを取り出す)

Ubuntu for Windowsでのクロスビルドは、いつかclangを介して可能になるはずです。 Windowsバイナリは現在MSVCで構築されているため、おそらく多くの修正が必要になります。 先週の月曜日に直接話したとき、私は基本的に同じ質問をしました。 CUDAとは直接関係がないので、これを独自のGH問題に分岐させる必要がありますか?

クロスコンパイルはbazelで可能ですが、tensorflowでそれを行う方法がわかりません。 参考のために

https://github.com/bazelbuild/bazel/wiki/Building-with-a-custom-toolchain

https://github.com/bazelbuild/bazel/issues/1353

ここに投稿されたtensorflow1.5ナイトリービルド(win10ビルド)がCUDA9 + CuDNN7をサポートしているかどうか誰かが知っていますか?

https://pypi.python.org/pypi/tf-nightly-gpu/1.5.0.dev20171115

ちなみに、「TF 1.5でリリースされる」と言ったからといって、このチケットと#14126を閉じるのは全く無責任です。 MXNET 0.12には、すでにCUDA9FP16が生産されています。 TensorflowとCNTKは急ぐ必要があります。 それはVoltaにとって有益なだけではありません。

まだ、CUDA9のビルドインフラストラクチャのアップグレードに取り組んでいます。

今週中にCUDA9でpipパッケージを作成することを目指しています。

私は2台のコンピューターを持っていますが、昨日1080tiをインストールし、すべて(cuda8とcudnn6)の新しいグラフィックドライバーであるVisual Studio2015をインストールします。

エポック1080tiと980tiの時間を比較します

1080tiは22分で各エポックを実行しますが、980tiは13分で実行されます!!!(1080の場合はバッチ= 60、980tiの場合はバッチ= 20)

1080tiが980tiよりも動作が遅い理由!!!! そして、どうすれば何が悪いのかを確認できますか?!

1080Tiに20バッチを使用する場合、実行時間はどのくらいですか?

@gunan 、これに新しいETAがあるかどうか疑問に思っていますか?

@smitshilu

1080tiで20バッチ= 26分

60バッチ= 19分

980gtxでバッチ20 = 14分!!!!

私はウィンドウズを使用し、cuda8とcudnn6で最新バージョンのドライバーをインストールします

980よりも実行が遅い理由をどのように見つけることができますか?

@naserghSLIにGTX1080tiと980tiがありますか?

@vickylance

番号

2つの異なるコンピューター!

どちらもcori7と1TBのハードディスクで、1TBのSATAHDDからデータイメージをロードします

しかし、980ではSSDハードディスクにWindowsがあります

私はCUDA8とcudnn6でasusのウェブサイトからダウンロードした388.13をチェックする最後のことで異なるバージョンのドライバーを試します

どれが理由なのかわからない

1-ウィンドウ! 多分それはLinuxでうまくいくでしょう

2-HDD速度

3-偽の1080TI

4-CUDAとcudnnは1080tiと互換性がありません

5-CPU(1080TIコンピューターのCPUは980よりも強力です)

何を指示してるんですか ?

@nasergh

1)RAMは同じですか? もしそうなら。 それほど影響があるかどうかはわかりませんが、RAMのMHzも両方のシステムで同じかどうかを確認してください。

2)980tiおよび1080tiで実行している場合のGPU使用率%を確認します。 GPUの使用率を確認する場合は、このツールを使用してください。 https://docs.microsoft.com/en-us/sysinternals/downloads/process-explorerそこにはもっと良いものがありますが、これが私の頭に浮かんだものです。

3)最高のパフォーマンスを求めたい場合は、Ubuntu16.04をデュアルブートとして1080tiシステムにインストールし、CUDA9.0とcuDNN7.0を使用することをお勧めします。

4)また、Windowsはそれ自体で多くのシステムリソースを消費するため、SSDで実行すると確実に優位に立つことができますが、テストシナリオで見られるほどの大きさではありません。

多分それは選択されたボードアーキテクチャです。

TFは、デフォルトで3.0、3.5、および5.2に構成されています。 https://en.wikipedia.org/wiki/CUDA#GPUs_supportedによると、1080TIは6.1(Pascal)、980は5.2(Maxwell)

おそらく、3.0または5.2へのダウングレードは1080TIでは効率的ではありませんが、980ではネイティブですか?

機能5.2と6.1の両方でコンピューティングを試してください(CMakeLists.txt l.232とl.246を参照)

De:nasergh [mailto:[email protected]]

エンボイエ:メルクレディ2017年11月22日17:17

À:テンソルフロー/テンサーフロー

Cc:sylvain-bougnoux; マニュアル

Objet:Re:[tensorflow / tensorflow] CuDNN7およびCUDA9へのアップグレード(#12052)

@vickylance

番号

2つの異なるコンピューター!

どちらもcori7と1TBのハードディスクで、1TBのSATAHDDからデータイメージをロードします

しかし、980ではSSDハードディスクにWindowsがあります

私はCUDA8とcudnn6でasusのウェブサイトからダウンロードした388.13をチェックする最後のことで異なるバージョンのドライバーを試します

どれが理由なのかわからない

1-ウィンドウ! 多分それはLinuxでうまくいくでしょう

2-HDD速度

3-偽の1080TI

4-CUDAとcudnnは1080tiと互換性がありません

何を指示してるんですか ?

—

このスレッドにサブスクライブしているため、これを受け取っています。

このメールに直接返信するか、GitHubで表示するか、スレッドをミュートしてください。

環境:cuda9.0 + cudnn7.0 + tf1.4、および「ptb」の例を実行するとエラーが発生します。TypeError:__ init __()が予期しないキーワード引数「input_size」を取得しました。「input_size」はのパラメータです。 CudnnLSTM

このスレッドを何ヶ月も見た後、Gentoolinuxで試してみるつもりです

私はasusstrix1080TIを持っています

1- ubuntoでは、nvidia Webサイトでドライバーを使用できます。または、asusからダウンロードする必要があります(asus WebサイトにLinux用のドライバーが表示されないため)

2-最後のバージョンは大丈夫ですか、またはほとんどのコメントで378.13を使用すると言われているので、378.13をインストールする必要がありますか?

ありがとう

Windowsを使用している場合は、CUDA 8.0.61.2、cuDNN 7.0.4、Python 3.6.3に対してビルドされたTF1.4.0を、AVXサポート付きでリポジトリにアップロードしました。 うまくいけば、CUDA9がWindowsで整理されるまではこれで十分です。

私はubuntu16.04とpython3.6にCUDA9とcudnn7をインストールしようとしています

しかし、私は失敗しています:(

私はすべてを試し、どこでも検索しますが、それでも同じエラーが発生します "importError:libcublas.so.8.0は共有オブジェクトファイルを開くことができません:そのようなファイルまたはディレクトリはありません

テンソルはCUDA8を実行したいと思います

どのように私は彼にcuda9を使うように言うことができますか?!!!! 回答がソースから実行された場合、どの程度正確ですか? ソースからのビルドについて非常に明確なウェブサイトを見ませんでした

ありがとう

source @naserghからtfをインストールする必要があります

@ withme6696

ソースからインストールするにはどうすればよいですか?

私はこれの1つをダウンロードできることを知っています

https://github.com/mind/wheels/releases

しかし、どれをダウンロードして、どのようにインストールするのかわかりません!?

@naserghのインストール方法については、 READMEを確認してください。 MKLのインストールを気にしない場合は、

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-37/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

MKLをインストールしたくない場合は、次のことができます。

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-nomkl/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

この問題をCUDA9サポートの追跡問題として使用します。

現在、2つのブロッカーがあります。

1- https://github.com/tensorflow/tensorflow/pull/14770

2-Windowsでは、NVCCにバグがあるようです。 CUDA9を使用したTFの構築は、コンパイラーのクラッシュで失敗しているようです。 NVIDIAはこれの調査を支援しており、アップデートがあれば続行します。

@danqing

ありがとう

1- MKLはどれだけ速度を向上させますか?

2-MKLのないバージョンでは、MKLをインストールする必要がありますか?!

1の場合は、これを参照してください。GPUで実行された計算では、明らかに速度が向上しないことに注意してください。

2の場合、あなたはしません。 正しいバージョンをインストールしてください。

ところで、これは多くのサブスクライバーを持つスレッドです。 ホイールに今後問題が発生した場合は、以下にコメントするのではなく、リポジトリで問題を開いてください。そうすれば、大量の人にスパムを送信することはありません。

@Tweakmind :私はこの部分を渡すことができません:

TensorFlowの構築

bazel build --config = opt --config = cuda // tensorflow / tools / pip_ package:build_pip_package --cxxopt = "-D_GLIBCXX_USE_CXX11_ABI = 0

bazel-bin / tensorflow / tools / pip_package / build_pip_package / tmp / tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

最初の行は不完全なようです(二重引用符がありません)? これらは3行ですか、それとも2行ですか。

@goodmangu正しいコードは次のとおりです。

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

コマンドに二重引用符がありません。

みんなありがとう。 これを高く評価しました。 代わりにナイトリービルドLinuxバイナリを使用して、同じ日に動作させました。 参照: https :

現在、Kerasで3つのGTX 1080Tiを実行しています。 いいね!

eGPUを搭載したMacBookProのソース(r1.4)からTensorflowをビルドするために過去2日間を費やしました。 Cuda 8.0、cuDNN 6.0、Mac OSX Sierra10.12で動作するドライバー。 終わりに非常に近いですが、20分後にいくつかのビルドエラーによってブロックされました。 これまでに運が良かった人はいますか? 共有できる正常にビルドされたパッケージはありますか? 前もって感謝します。

@goodmanguどの「ナイトリービルドLinuxバイナリ」を使用していますか。

確かに、これは:tf_nightly_gpu-1.head-cp27-none-linux_x86_64.whl

それでも、Cuda 9.0 + cuDNN7.0に対するWindows10のサポートはありませんか? 確認するだけです。

Tensorflow GPU 1.4.0

@goodmangu 1.4で試しましたが、OSX10.13とCUDA9 cuDNN7です。手順はここにあります。

@ eeilon79 Windowsにnvccのバグがあり、バイナリを構築できません。 これらの問題を修正するために、nvidiaから支援を受けています。

tf-nightly-gpu pipパッケージのTensorflowNightly Version(1.5-dev)にCUDA 9のアップデートはありますか? KerasのCuDNNLSTMにはこの1.5を使用する必要があります

OK、PRはマージされたばかりです。

約10〜12時間で、ウィンドウを除いて、新しいナイトリーをcuda9で作成する必要があります。

Windowsでは、NVCCのバグによってまだブロックされています。

Gentooシステム用の一般的なCUDA9およびCUDANN7パッケージを終了し、ダミーテストを試しましたが、Pythonでtfとしてダミーインポートテンソルフローで動作しているように見えますが、追加のテストを行う必要があります。

私はコミットを使用しています:c9568f1ee51a265db4c5f017baf722b9ea5ecfbb

Windowsでは、NVCCのバグによってまだブロックされています。

その問題へのリンクをここに投稿していただけませんか? 前もって感謝します!

@smitshiluあなたの記事は私を助けてくれました。

そして、いくつかの要素を追加して記事を書きました。

https://github.com/masasys/MacTF1.4GPU

@arbynacosta

走る

bazel build --config = opt --config = cuda // tensorflow / tools / pip_ package:build_pip_package --cxxopt = "-D_GLIBCXX_USE_CXX11_ABI = 0"

しかし、私はこのエラーが発生します

エラー:ビルドコマンドは、ワークスペース内からのみサポートされます。

私も毎晩テンソルを試しますが、エラーが発生します

attributeerror:モジュール 'tensorflow'には属性がありません...。

dir(tf)の出力

['__doc __'、 '__ loarder __'、 '__ name __'、__ package__ '' __path__ __spec__]

申し訳ありませんが@goodmangu 、私は@arbynacostaが指摘したように、最後の二重引用符を

@nasergh 、クローンされたtensorflowディレクトリ内からそのコマンドを実行していますか。 WORKSPACEがディレクトリに存在することを確認してください。

例えば:

~/Downloads/tensorflow$ ls

ACKNOWLEDGMENTS bazel-bin bazel-testlogs configure LICENSE tensorflow WORKSPACE

ADOPTERS.md bazel-genfiles BUILD configure.py models.BUILD third_party

arm_compiler.BUILD bazel-out CODE_OF_CONDUCT.md CONTRIBUTING.md README.md tools

AUTHORS bazel-tensorflow CODEOWNERS ISSUE_TEMPLATE.md RELEASE.md util

@Tweakmind

コマンドを実行します

sudo su

次に、tensorflowフォルダーに移動します(そこにワークスペースファイルがありました)

しかし、私はこのエラーが発生します

root<strong i="10">@pc</strong>:/home/pc2/tensorflow# bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

..........

WARNING: Config values are not defined in any .rc file: opt

ERROR: /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD:4:1: Traceback (most recent call last):

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD", line 4

error_gpu_disabled()

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/error_gpu_disabled.bzl", line 3, in error_gpu_disabled

fail("ERROR: Building with --config=c...")

ERROR: Building with --config=cuda but TensorFlow is not configured to build with GPU support. Please re-run ./configure and enter 'Y' at the prompt to build with GPU support.

ERROR: no such target '@local_config_cuda//crosstool:toolchain': target 'toolchain' not declared in package 'crosstool' defined by /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD

INFO: Elapsed time: 6.830s

FAILED: Build did NOT complete successfully (2 packages loaded)

currently loading: @bazel_tools//tools/jdk

@naserghここにあるすべての指示に必ず従ってください。

https://www.tensorflow.org/install/install_sources

GPUをサポートして構築している場合は、適切に構成していることを確認してください。

ソースからTensorflow1.4をインストールします。

- この記事の執筆時点では、これがCUDA9.0およびcuDNN7.0で動作する唯一の方法です。

- 手順: https :

- いくつかの指示は意味をなさないかもしれません、これが私がそれをした方法です:

cd $HOME/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

./configure

サンプルの出力とオプションは、手順のそれとは異なります

- CUDAバージョン9.0用に構成していることを確認してください

- cuDNNバージョン7.0.4用に構成していることを確認してください

- https://developer.nvidia.com/cuda-gpusからコンピューティング機能を知っていることを確認して

- 私はGeForceGTX 1070を持っているので、これを6.1に設定しました

Bazelのインストール

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

TensorFlowの構築

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

@Tweakmind :これについて私に戻ってきてくれてありがとう。 はい、Ubuntuで動作しましたが、eGPU(1080 Ti)を搭載したMac OSX(10.12.6)ではまだうまくいきません。 私がフォローしたすべてのソースについて、ビルドは約10〜15分後に失敗しました。 再現性のある成功があれば素晴らしいと思います。 前もって感謝します。

@Tweakmind

私は次のことを行い、ファイルも構成しますが、それは言います

pc2<strong i="7">@pc</strong>:~/Downloads/tensorflow$ bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: Skipping '//tensorflow/tools/pip_package:build_pip_package': error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

WARNING: Target pattern parsing failed.

ERROR: error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

INFO: Elapsed time: 0.082s

FAILED: Build did NOT complete successfully (0 packages loaded)

currently loading: tensorflow/tools/pip_package

私はcudaとcudnnを正しくインストールすると思います

`` `

/ usrを見つける| grep libcudnn

/ usr / share / doc / libcudnn7

/ usr / share / doc / libcudnn7 / copyright

/usr/share/doc/libcudnn7/NVIDIA_SLA_cuDNN_Support.txt

/usr/share/doc/libcudnn7/changelog.Debian.gz

/ usr / share / lintian / overrides / libcudnn7

/usr/lib/x86_64-linux-gnu/libcudnn.so.7.0.4

/usr/lib/x86_64-linux-gnu/libcudnn.so.7

`` `

@goodmangu 、私は週末にMacOSビルドに取り組みます。

@ nasergh 、

インストールをテストするためのソースとドキュメントを含むcuDNNのガイドは次のとおりです。

cuDNN7.0.4ファイルをダウンロードする

ブラウザでNvidia開発者アカウントにログインする必要があります

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/cudnn-9.0-linux-x64-v7

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64

各ハッシュを確認してください

cd $HOME/Downloads

md5sum cudnn-9.0-linux-x64-v7.tgz && \

md5sum libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

出力は次のようになります。

fc8a03ac9380d582e949444c7a18fb8d cudnn-9.0-linux-x64-v7.tgz

e986f9a85fd199ab8934b8e4835496e2 libcudnn7_7.0.4.31-1 + cuda9.0_amd64.deb

4bd528115e3dc578ce8fca0d32ab82b8 libcudnn7-dev_7.0.4.31-1 + cuda9.0_amd64.deb

04ad839c937362a551eb2170afb88320 libcudnn7-doc_7.0.4.31-1 + cuda9.0_amd64.deb

cuDNN7.0.4とライブラリをインストールします

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

cuDNNの検証

Ubuntu 17.10には、GNUコンパイラのバージョン7以降が含まれています

CUDAはバージョン6以降と互換性がありません

返されるエラーは次のとおりです。

エラー-サポートされていないGNUバージョン! 6以降のgccバージョンはサポートされていません!

修正-バージョン6をインストールし、CUDAbinディレクトリにシンボリックリンクを作成します。

sudo apt-get install gcc-6 g++-6

sudo ln -sf /usr/bin/gcc-6 /usr/local/cuda/bin/gcc

sudo ln -sf /usr/bin/g++-6 /usr/local/cuda/bin/g++

次に、mnistCUDNNをビルドしてcuDNNをテストします

cp -r /usr/src/cudnn_samples_v7/ $HOME

cd $HOME/cudnn_samples_v7/mnistCUDNN

make clean && make

./mnistCUDNN

cuDNNが正しくインストールされている場合は、次のように表示されます。

テストに合格しました!

親愛なる@Tweakmind

あなたの方法はあなたの助けに感謝します(私は3週間以上テンソルをインストールしようとしていました!!!)

問題は、python3.6にインストールしたところ、PILパッケージに問題が発生したことです。

Traceback (most recent call last):

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 551, in get

inputs = self.queue.get(block=True).get()

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 644, in get

raise self._value

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 119, in worker

result = (True, func(*args, **kwds))

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 391, in get_index

return _SHARED_SEQUENCES[uid][i]

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 761, in __getitem__

return self._get_batches_of_transformed_samples(index_array)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 1106, in _get_batches_of_transformed_samples

interpolation=self.interpolation)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 345, in load_img

raise ImportError('Could not import PIL.Image. '

ImportError: Could not import PIL.Image. The use of `array_to_img` requires PIL.

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File "<stdin>", line 7, in <module>

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/models.py", line 1227, in fit_generator

initial_epoch=initial_epoch)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/engine/training.py", line 2115, in fit_generator

generator_output = next(output_generator)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 557, in get

six.raise_from(StopIteration(e), e)

File "<string>", line 3, in raise_from

StopIteration: Could not import PIL.Image. The use of `array_to_img` requires PIL.

枕を取り付けようとしましたが、役に立ちません

私もPILをインストールしようとしますが

UnsatisfiableError: The following specifications were found to be in conflict:

- pil -> python 2.6*

- python 3.6*

@naserghあなたは何を手に入れますか:

pip install pillow

私のは次のようになります:

~$ pip install pillow

Requirement already satisfied: pillow in ./anaconda3/lib/python3.6/site-packages

@nasergh 、クラッシュする必要がありますが、起きたらチェックインします。

@ goodmangu 、2012 Mac Proにアクセスできないため、週末にMacビルドを実行できなくなります。 うまくいけば、あなたは今のところUbuntuに慣れています。 私はそれが私にとってうまくいくことを知っています。 私は来週末にそれを取り戻す必要があります。

@ Tweakmind-ありがとう! 、CUDA9とcuDNN7でパフォーマンスが向上するのを見たことがありますか?

また、以下の@Tweakmindで言及されているいくつかの手順は冗長であると思います。どちらかが必要です:

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

また

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

@gunan

CUDA 9.1.85は、少し前にCuDNN 7.0.5でリリースされ、nvccコンパイラのバグが修正されました。 win10ユーザーがTensorflow1.4.1をコンパイルできるかどうか疑問に思いますか? そろそろ時間です。

NVIDIAとのやり取りから、9.1でこの問題が修正されたとは思いません。

ただし、回避策があります。 まず、このPRをeigenにマージする必要があります。

https://bitbucket.org/eigen/eigen/pull-requests/351/win-nvcc/diff

次に、固有の依存関係を更新します。これにより、CUDA9のすべてのビルドが修正されます。

prは拒否されますが、手動でマージする必要があります。 固有のリリースを待つ必要がありますか、それともソースによって構築されていますか?

かっこいい、それならナイトリーピップになりますか?

@Tweakmind

Python2.7を使用してテンソルを再構築しようとしています

しかし、bazelビルドでは、このエラーが発生します

numpyもインストールしますが、変更はありません。

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: /home/gh2/Downloads/tensorflow/util/python/BUILD:5:1: no such package '@local_config_python//': Traceback (most recent call last):

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 310

_create_local_python_repository(repository_ctx)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 274, in _create_local_python_repository

_get_numpy_include(repository_ctx, python_bin)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 257, in _get_numpy_include

_execute(repository_ctx, [python_bin, "-c",..."], <2 more arguments>)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 76, in _execute

_python_configure_fail("\n".join([error_msg.strip() if ... ""]))

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 37, in _python_configure_fail

fail(("%sPython Configuration Error:%...)))

Python Configuration Error: Problem getting numpy include path.

Traceback (most recent call last):

File "<string>", line 1, in <module>

**ImportError: No module named numpy**

Is numpy installed?

and referenced by '//util/python:python_headers'

ERROR: Analysis of target '//tensorflow/tools/pip_package:build_pip_package' failed; build aborted: Loading failed

INFO: Elapsed time: 10.826s

FAILED: Build did NOT complete successfully (26 packages loaded)

currently loading: tensorflow/core ... (3 packages)

Fetching http://mirror.bazel.build/.../~ooura/fft.tgz; 20,338b 5s

Fetching http://mirror.bazel.build/zlib.net/zlib-1.2.8.tar.gz; 19,924b 5s

Fetching http://mirror.bazel.build/.../giflib-5.1.4.tar.gz; 18,883b 5s

OSXはcuDNNのバージョン7.0.5で除外されているようです。 誰かが詳細なことを知っていますか?

それでも、Windows 10(CUDA9.0.176およびcudnn7.0)でtensorflow-gpuを動作させることができません。

tensorflowとtensorflow-gpuの両方をアンインストールし、再インストールしました(--no-cache-dirを使用して、固有の回避策を使用して最新バージョンを確実にダウンロードします)。 両方をインストールすると、GPUが認識されません。

InvalidArgumentError(トレースバックについては上記を参照):操作にデバイスを割り当てることができません 'random_uniform_1 / sub':操作は/ device:GPU :0に明示的に割り当てられましたが、使用可能なデバイスは[/ job:localhost / reply :0 / task:0 / deviceです: CPU:0 ]。 デバイス仕様が有効なデバイスを参照していることを確認してください。

tensorflow-gpuだけをインストールすると、dllが見つからないと文句を言います。

ImportError:「cudart64_80.dll」が見つかりませんでした。 TensorFlowでは、このDLLが%PATH%環境変数で指定されたディレクトリにインストールされている必要があります。 次のURLからCUDA8.0をダウンロードしてインストールします: https :

私のCUDAバージョンは8.0ではなく9.0であり、認識されている(deviceQueryテストに合格している)ので、これは奇妙です。

私のPythonバージョンは3.6.3です。 tensorflow-gpuをテストするために、このコードをSpyder(3.2.4)で実行しようとしています。

私は何を取りこぼしたか?

私は勝利7でbazelによってソースから構築しようとしています、エラーが発生します

CPU用のツールキャヒンはありません 'x64_windows'

誰でもwhlを構築できますか?

@ hadaev8 、私は助けるためにもっとたくさんの情報が必要です。 whlで作業することはできますが、依存関係が大きく、Win7ではありません。MacOSを解決したら、Win10を解決します。 いずれにせよ、あなたの詳細を投稿してください。

@ eeilon79 、

@ nasergh 、Python 2.7の要件はありますか?

CUDA8.0とcuDNN6.0では、これがWin10でCudaGPUとAVX2をサポートするためにソースからTensorFlowをインストールした方法です::

要件:

* Windows 10 64-Bit

* Visual Studio 15 C++ Tools

* NVIDIA CUDA® Toolkit 8.0

* NVIDIA cuDNN 6.0 for CUDA 8.0

* Cmake

* Swig

Visual Studio Community Edition Update 3 w / Windows Kit10.0.10240.0をインストールします

https://github.com/philferriere/dlwin (ありがとうPhil)の指示に従ってください

仮想ドライブNを作成する:わかりやすくするため

次の手順に基づいて、C:または選択したドライブからディレクトリを作成してN:を作成することをお勧めします(2GB以上)。

https://technet.microsoft.com/en-us/library/gg318052(v = ws.10).aspx

Cuda 8.064ビットをインストールします

https://developer.nvidia.com/cuda-downloads (レガシーまでスクロールダウン)

Cuda8.0用のcuDNN6.0をインストールします

https://developer.nvidia.com/rdp/cudnn-download

zipからcudaフォルダーをN:\に置き、cuDNN-6の名前を変更します

CMakeをインストールする

https://cmake.org/files/v3.10/cmake-3.10.0-rc5-win64-x64.msi

Swigをインストールします(swigwin-3.0.12)

https://sourceforge.net/projects/swig/files/swigwin/swigwin-3.0.12/swigwin-3.0.12.zip

cntk-py36

`` `conda create --name cntk-py36 python = 3.6 numpy scipy h5py jupyter

cntk-py36をアクティブ化する

pipインストールhttps://cntk.ai/PythonWheel/GPU/cntk-2.2-cp36-cp36m-win_amd64.whl

python -c "import cntk; print(cntk .__ version__)"

conda install pygpu

pip install keras

#### Remove old tensorflow in Tools if it exists

```cd C:\Users\%USERNAME%\Tools\

move tensorflow tensorflow.not

git clone --recursive https://github.com/tensorflow/tensorflow.git

cd C:\Users\%USERNAME%\Tools\tensorflow\tensorflow\contrib\cmake

Edit CMakeLists.txt

これらをコメントアウトします。

# if (tensorflow_OPTIMIZE_FOR_NATIVE_ARCH)

# include(CheckCXXCompilerFlag)

# CHECK_CXX_COMPILER_FLAG("-march=native" COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

# if (COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

# set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -march=native")

# endif()

# endif()

これらを追加します:

if (tensorflow_OPTIMIZE_FOR_NATIVE_ARCH)

include(CheckCXXCompilerFlag)

CHECK_CXX_COMPILER_FLAG("-march=native" COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

if (COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -march=native")

else()

CHECK_CXX_COMPILER_FLAG("/arch:AVX2" COMPILER_OPT_ARCH_AVX_SUPPORTED)

if(COMPILER_OPT_ARCH_AVX_SUPPORTED)

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} /arch:AVX2")

endif()

endif()

endif()

mkdirビルドとcdビルド

"C:\Program Files (x86)\Microsoft Visual Studio 14.0\VC\bin\amd64\vcvars64.bat"

cmake .. -A x64 -DCMAKE_BUILD_TYPE=Release ^

-DSWIG_EXECUTABLE=N:/swigwin-3.0.12/swig.exe ^

-DPYTHON_EXECUTABLE=N:/Anaconda3/python.exe ^

-DPYTHON_LIBRARIES=N:/Anaconda3/libs/python36.lib ^

-Dtensorflow_ENABLE_GPU=ON ^

-DCUDNN_HOME="n:\cuDNN-6" ^

-Dtensorflow_WIN_CPU_SIMD_OPTIONS=/arch:AVX2

-構築対象:Visual Studio 14 2015

--WindowsSDKバージョン10.0.14393.0を選択してWindows10.0.16299をターゲットにします。

--CコンパイラのIDはMSVC19.0.24225.1です。

--CXXコンパイラIDはMSVC19.0.24225.1です。

-動作しているCコンパイラを確認します:C:/ Program Files(x86)/ Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe

-動作しているCコンパイラを確認します:C:/ Program Files(x86)/ Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 /cl.exe--動作します

--CコンパイラのABI情報を検出しています

--CコンパイラのABI情報を検出しています-完了

-動作しているCXXコンパイラを確認します:C:/ Program Files(x86)/ Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe

-動作しているCXXコンパイラを確認します:C:/ Program Files(x86)/ Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 /cl.exe--動作します

--CXXコンパイラのABI情報を検出しています

--CXXコンパイラのABI情報を検出しています-完了

--CXXコンパイル機能の検出

--CXXコンパイル機能の検出-完了

-テストの実行COMPILER_OPT_ARCH_NATIVE_SUPPORTED

-テストCOMPILER_OPT_ARCH_NATIVE_SUPPORTEDの実行-失敗しました

-テストの実行COMPILER_OPT_ARCH_AVX_SUPPORTED

-テストの実行COMPILER_OPT_ARCH_AVX_SUPPORTED-成功

-テストの実行COMPILER_OPT_WIN_CPU_SIMD_SUPPORTED

-テストの実行COMPILER_OPT_WIN_CPU_SIMD_SUPPORTED-成功

--CUDAが見つかりました:C:/ Program Files / NVIDIA GPU Computing Toolkit / CUDA / v8.0(適切なバージョン「8.0」が見つかりました。最低限必要なのは「8.0」です)

--PythonInterpが見つかりました:C:/Users/%USERNAME%/Anaconda3/python.exe(バージョン "3.6.3"が見つかりました)

-見つかったPythonLibs:C:/Users/%USERNAME%/Anaconda3/libs/python36.lib(見つかったバージョン "3.6.3")

--SWIGが見つかりました:C:/Users/%USERNAME%/Tools/swigwin-3.0.12/swig.exe(バージョン "3.0.12"が見つかりました)

-構成が完了しました

-生成が完了しました

-ビルドファイルは次の場所に書き込まれています:C:/ Users /%USERNAME%/ Tools / tensorflow / tensorflow / contrib / cmake / build

MSBuild /p:Configuration=Release tf_python_build_pip_package.vcxproj

@Tweakmind

python 3.6、テンソルフローはマスターから最後、cuda 9.0、cudnn 7.0.5 for cuda 9.0、バーゼル、スウィッグが本日ロードされました。

@Tweakmindマスターでビルドしますか?

@Tweakmind

cuda 9 cudnn 7を使用してWindows上に構築し、.whlを共有できますか?

@Tweakmind

cuda 9 cudnn 7でwin10を構築してみませんか?

あなたの専門知識をありがとう!

@ hadaev8 @ alc5978

pip install -U tf-nightly-gpuは、20171221日付のwin10ビルドを提供するようになりました。これは、CUDA9.0およびCuDNN7.0.5を備えたTF1.5ベータに基づいています。 私は昨夜それを実行しました、それは大丈夫です。 次に、CUDAカーネルの起動速度を12倍にするためにCUDA9.1に移行する必要があります。 Tensorflow Windowsのサポートはかなり遅く、貧血です。 安定した公式ビルドはできるだけ早く提供する必要があります。 実際、Tensorflow1.5の安定版がCUDA9.1でリリースされる予定ですが、1月末までにリリースしてください。

2018年、ほぼ1月末で、Windows 10へのCUDA9.1とCuDNN7を使用したTFのインストールはまだ完了していませんか?

最終的には9.0ではなくCUDA9.1になることを願っています。

最終的には9.0ではなくCUDA9.1になることを願っています。

最終的には9.0ではなくCUDA9.1になると思いますね。 :)

@ViktorM @ Magicfeng007 @ alc5978

9.1スレッドは、基本的に閉じていますが、フォローしたい場合

GPUを使用していないTensorFlowバックエンドのKerasのような問題にまだ直面している人がいる場合は、このページの手順に従ってください。 更新され、100%正しく機能します。

https://research.wmz.ninja/articles/2017/01/configuring-gpu-accelerated-keras-in-windows-10.html

こんにちは、みんな

私は今日、CUDA9.0を使用してwin10にtensorflow-gpu1.6.0rc1をインストールし、 http: //www.python36.com/install-tensorflow-using-official-pip-pacakage/を使用してcuDNN7.0.5ライブラリをインストールし

すべて問題ないようです

最新のTensorFlow(v1.5 +)用のNVIDIA GPU前提条件(CUDA-9.0およびcuDNN-7.0)用に1つのスクリプトを作成しました。ここに、リンクがあります。

最も参考になるコメント

追加する方法について言えば、cudnn7からのグループ畳み込みはビジョンコミュニティにとって重要な機能です。