Tensorflow: Обновление до CuDNN 7 и CUDA 9

Системная информация

- Написал ли я собственный код (в отличие от стандартного сценария, представленного в TensorFlow) : Нет

- Платформа ОС и распространение (например, Linux Ubuntu 16.04) : Windows Server 2012

- TensorFlow установлен из (исходный или двоичный) : двоичный

- Версия TensorFlow (используйте команду ниже) : 1.3.0-rc1

- Версия Python : 3.5.2

- Версия Bazel (при компиляции из исходников) : N / A

- Версия CUDA / cuDNN : CUDA V8.0.44, CuDNN 6.0

- Модель графического процессора и память : Nvidia GeForce GTX 1080 Ti, 11 ГБ

- Точная команда для воспроизведения : N / A

Опишите проблему

Обновите TensorFlow для поддержки CUDA 9 и CuDNN 7. Nvidia утверждает, что это обеспечит двукратный прирост производительности на графических процессорах Pascal.

Все 170 Комментарий

@tfboyd у вас есть комментарии по этому поводу?

cuDNN 7 все еще находится в режиме предварительного просмотра и над ним ведутся работы. Мы только что перешли на cuDNN 6.0 с 1.3, которая должна выйти через пару недель. Вы можете скачать cuDNN 1.3.0rc2, если вам это интересно. Я еще не скомпилировал с cuDNN 7 или CUDA 9. Я слышал, что CUDA 9 нелегко установить на всех платформах, и доступны только избранные установочные пакеты. Когда библиотеки будут окончательными, мы начнем окончательную оценку. NVIDIA также только что начала рассылать исправления для основных платформ машинного обучения для поддержки аспектов этих новых библиотек, и я подозреваю, что потребуется дополнительная работа.

Изменить: я хотел сказать, что CUDA 9 нелегко установить на всех платформах, и вместо этого сказал cuDNN. Я также поменял уверенность, что будет работа, на подозреваю, что будет дополнительная работа. Остальную часть своего глупого заявления я оставил, например, я не осознавал, что cuDNN 7 был запущен вчера.

Не говоря уже о том, как читать сайт. Но двукратное ускорение на паскале, похоже, является частью выпуска CUDA 8. Полагаю, это зависит от того, как вы читаете сайт. NVIDIA не упомянула нам, что CUDA 9 ускорит Pascal в 2 раза (во всем), и хотя все возможно, я не ожидал, что это произойдет.

https://developer.nvidia.com/cuda-toolkit/whatsnew

Сайт немного сбивает с толку, но я думаю, что цитируемый вами раздел вложен в CUDA 8. Я упоминаю об этом только для того, чтобы у вас не было нереалистичных ожиданий по поводу их выпуска. Что касается Volta, это должно принести большую пользу из того, что я понимаю, и я думаю (сейчас я не уверен), что люди просто получают инженерные образцы Volta, чтобы начать высокоуровневую работу, чтобы подготовиться к полной версии.

@tfboyd cuDNN 7 со

Ах, я пропустил это. Спасибо @sclarkson и извиняюсь за неверную информацию.

Я обязательно попробую, потому что, наконец, gcc 6 поддерживается CUDA 9, а Ubuntu 17.04 идет с ним.

Если повезет, дайте знать. Я лично только начинаю

полностью протестировать cuDNN 6 (внутри он много тестировался, но я не

использую лично). Я часто медленно обновляюсь до последней версии. Мой

думаю, вы не увидите никаких реальных изменений с cuDNN 7, пока все не будет

исправлены для использования новейших API. Я хочу еще раз подчеркнуть, что я ошибаюсь

времени. То, что я видел как посторонний, - это добавление новых версий cuDNN

новые методы / API. Некоторые интересны, а некоторые не сразу

полезный. Затем эти API становятся доступными через TensorFlow API или просто используются.

за кулисами, чтобы ускорить существующие методы. Мой очень высокий уровень

понимание, что cuDNN 7 + CUDA 9 улучшит поддержку FP16 с акцентом на

Вольта. Я думаю, что одним из основных направлений является получение моделей (многих, а не только

несколько), чтобы сойтись с FP16 без необходимости бесконечно угадывать правильный

config / hyperparameters для использования. Хочу подчеркнуть, что именно так я

Разговор понял и могу ошибаться или наполовину прав.

СТРЕСС: Если есть методы, которые, по вашему мнению, необходимо добавить (или использовать для

performance) в TensorFlow из cuDNN нас всегда интересует список.

Внутри это произошло с cuDNN 6, и мы сосредоточились на реализации

команды разработчиков функций сказали, что они хотели, чтобы это помогло их проектам.

В субботу, 5 августа 2017 г., в 8:46, Courtial Florian [email protected]

написал:

Я обязательно попробую, потому что, наконец, gcc 6 поддерживается CUDA 9 и

Ubuntu 17.04 идет вместе с ним.-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320450756 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZessKqj_nPY1br9SD9L9SX-8Kf5Dbtks5sVI5TgaJpZM4OuRL7

.

Говоря о методах, которые будут добавлены, свертка групп из cudnn7 была бы важной функцией для сообщества специалистов по визуальному развитию.

Круто, я добавлю его в список, который я начинаю. Я могу забыть, но не стесняйтесь

напомнить мне опубликовать какой-то список, в котором я могу дать некоторые рекомендации

над тем, над чем, вероятно, работают. Это не может быть обещанием, но мы хотим

обратная связь, чтобы мы могли расставить приоритеты в том, чего хотят и в чем нуждаются люди. Спасибо, Юсинь.

В субботу, 5 августа 2017 г., в 12:26 Юсинь Ву [email protected] написал:

Говоря о методах, которые будут добавлены, групповая свертка из cudnn7 будет

важная особенность для сообщества видений.-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

.

Я просто попытался скомпилировать cuDNN 7 с CUDA 8, и это не удалось, что мне нравится

ожидаемого. От NVIDIA поступает патч, который должен помочь

вещи вверх. Предупреждаем, если кто-то пытается.

В субботу, 5 августа 2017 г., в 13:47 Тоби Бойд [email protected] написал:

Круто, я добавлю его в список, который я начинаю. Я могу забыть, но не стесняйтесь

напомнить мне опубликовать какой-то список, в котором я могу дать некоторые рекомендации

над тем, над чем, вероятно, работают. Это не может быть обещанием, но мы хотим

обратная связь, чтобы мы могли расставить приоритеты в том, чего хотят и в чем нуждаются люди. Спасибо, Юсинь.В сб, 5 августа 2017 г., в 12:26, Юсинь Ву [email protected]

написал:Говоря о методах, которые будут добавлены, групповая свертка из cudnn7 будет

важная особенность для сообщества видений.-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320465264 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesv9udRRxy9WvsK2eUEZCj7LAGM8bks5sVMHVgaJpZM4OuRL7

.

Я пытаюсь получить cuDNN 7 с запущенным CUDA 8/9. CUDA 8 не поддерживается GTX 1080 Ti - по крайней мере, так говорит установщик ^^

У меня большие проблемы со временем, чтобы все работало вместе. Я хочу отметить эту замечательную статью, в которой резюмируется то, что я уже пробовал: https://nitishmutha.github.io/tensorflow/2017/01/22/TensorFlow-with-gpu-for-windows.html

Примеры CUDA работают через Visual-Studio в обеих комбинациях настройки.

Вот вывод deviceQuery.exe, который был скомпилирован с помощью Visual-Studio:

PS C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release> deviceQuery.exe

C:\ProgramData\NVIDIA Corporation\CUDA Samples\v9.0\bin\win64\Release\deviceQuery.exe Starting...

CUDA Device Query (Runtime API) version (CUDART static linking)

Detected 1 CUDA Capable device(s)

Device 0: "GeForce GTX 1080 Ti"

CUDA Driver Version / Runtime Version 9.0 / 9.0

CUDA Capability Major/Minor version number: 6.1

Total amount of global memory: 11264 MBytes (11811160064 bytes)

(28) Multiprocessors, (128) CUDA Cores/MP: 3584 CUDA Cores

GPU Max Clock rate: 1683 MHz (1.68 GHz)

Memory Clock rate: 5505 Mhz

Memory Bus Width: 352-bit

L2 Cache Size: 2883584 bytes

Maximum Texture Dimension Size (x,y,z) 1D=(131072), 2D=(131072, 65536), 3D=(16384, 16384, 16384)

Maximum Layered 1D Texture Size, (num) layers 1D=(32768), 2048 layers

Maximum Layered 2D Texture Size, (num) layers 2D=(32768, 32768), 2048 layers

Total amount of constant memory: 65536 bytes

Total amount of shared memory per block: 49152 bytes

Total number of registers available per block: 65536

Warp size: 32

Maximum number of threads per multiprocessor: 2048

Maximum number of threads per block: 1024

Max dimension size of a thread block (x,y,z): (1024, 1024, 64)

Max dimension size of a grid size (x,y,z): (2147483647, 65535, 65535)

Maximum memory pitch: 2147483647 bytes

Texture alignment: 512 bytes

Concurrent copy and kernel execution: Yes with 2 copy engine(s)

Run time limit on kernels: Yes

Integrated GPU sharing Host Memory: No

Support host page-locked memory mapping: Yes

Alignment requirement for Surfaces: Yes

Device has ECC support: Disabled

CUDA Device Driver Mode (TCC or WDDM): WDDM (Windows Display Driver Model)

Device supports Unified Addressing (UVA): Yes

Supports Cooperative Kernel Launch: No

Supports MultiDevice Co-op Kernel Launch: No

Device PCI Domain ID / Bus ID / location ID: 0 / 1 / 0

Compute Mode:

< Default (multiple host threads can use ::cudaSetDevice() with device simultaneously) >

deviceQuery, CUDA Driver = CUDART, CUDA Driver Version = 9.0, CUDA Runtime Version = 9.0, NumDevs = 1, Device0 = GeForce GTX 1080 Ti

Result = PASS

@tfboyd есть ли у вас ссылка, подтверждающая обновление cuDNN от Nvidea?

@ 4F2E4A2E 1080 Ti определенно поддерживает CUDA 8.0. Это то, что я использую с TensorFlow последние несколько месяцев.

Привет всем, итак у меня gtx 1080 ti с cuda 8.0. Я пытаюсь установить tensorflow-gpu, выбрать cuDNN 5.1, 6.0 или 7.0?

Я предлагаю пока придерживаться 5.1. Я работаю глубже

тесты на 6 и получение неоднозначных результатов, для выяснения которых требуется дополнительное тестирование.

6 августа 2017 г. в 21:30 "colmantse" [email protected] написал:

Привет всем, итак у меня gtx 1080 ti с cuda 8.0. Я пытаюсь установить

tenorflow-gpu, выбрать cuDNN 5.1, 6.0 или 7.0?-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-320566071 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZeshvEFsdeWz-1uyzl_L6HE15E0BzSks5sVpLlgaJpZM4OuRL7

.

спасибо, я пробовал с cudnn 6.0, но не работает, я думаю, из-за моей фиктивной установки tf-gpu. cudnn 5.1 у меня работает с python 3.6

@tpankaj Спасибо! У меня он работает с CUDA 8 и cuDNN 5.1

Вот полный набор функций cuDNN 7:

Ключевые особенности и улучшения

Этот выпуск cuDNN включает следующие ключевые функции и улучшения.

Тензорные ядра

Версия 7.0.1 cuDNN является первой, которая поддерживает операции Tensor Core в своем

реализация. Тензорные ядра обеспечивают оптимизированное умножение матриц

строительные блоки, которые не имеют эквивалентного числового поведения в традиционных

инструкции, поэтому его числовое поведение немного отличается.

cudnnSetConvolutionMathType, cudnnSetRNNMatrixMathType и

cudnnMathType_t

CudnnSetConvolutionMathType и cudnnSetRNNMatrixMathType

функции позволяют вам выбрать, использовать ли операции Tensor Core в

слои свертки и RNN соответственно, установив математический режим на любой

CUDNN_TENSOR_OP_MATH или CUDNN_DEFAULT_MATH.

Операции тензорного ядра выполняют параллельное накопление нескольких чисел с плавающей запятой.

продукты с плавающей запятой.

Установка математического режима на CUDNN_TENSOR_OP_MATH указывает, что библиотека будет использовать

Операции с тензорным ядром.

По умолчанию - CUDNN_DEFAULT_MATH. Это значение по умолчанию означает, что тензорное ядро

библиотека будет избегать операций. Режим по умолчанию - это сериализованная операция.

тогда как тензорное ядро - это параллельная операция, поэтому оба могут

немного разные численные результаты из-за разной последовательности операций.

Библиотека возвращается в математический режим по умолчанию, когда выполняются операции Tensor Core.

не поддерживается или не разрешено.

cudnnSetConvolutionGroupCount

Новый интерфейс, который позволяет приложениям выполнять сверточные группы в

слои свертки за один вызов API.

cudnnCTCLoss

cudnnCTCLoss обеспечивает реализацию графического процессора Connectionist Temporal

Функция потерь классификации (CTC) для RNN. Функция потерь CTC используется для

распознавание фонем в речи и распознавание почерка.

CUDNN_BATCHNORM_SPATIAL_PERSISTENT

Функция CUDNN_BATCHNORM_SPATIAL_PERSISTENT - это новый пакет

режим нормализации для cudnnBatchNormalizationForwardTraining

и cudnnBatchNormalizationBackward. Этот режим похож на

CUDNN_BATCHNORM_SPATIAL, однако для некоторых задач он может быть быстрее.

cudnnQueryRuntimeError

Функция cudnnQueryRuntimeError сообщает коды ошибок, написанные графическим процессором.

ядра при выполнении cudnnBatchNormalizationForwardTraining

и cudnnBatchNormalizationBackward с

Режим CUDNN_BATCHNORM_SPATIAL_PERSISTENT.

cudnnGetConvolutionForwardAlgorithm_v7

Этот новый API возвращает все алгоритмы, отсортированные по ожидаемой производительности.

(с использованием внутренней эвристики). Эти алгоритмы выводятся аналогично

cudnnFindConvolutionForwardAlgorithm.

cudnnGetConvolutionBackwardDataAlgorithm_v7

Этот новый API возвращает все алгоритмы, отсортированные по ожидаемой производительности.

(с использованием внутренней эвристики). Эти алгоритмы выводятся аналогично

cudnnFindConvolutionBackwardAlgorithm.

cudnnGetConvolutionBackwardFilterAlgorithm_v7

Этот новый API возвращает все алгоритмы, отсортированные по ожидаемой производительности.

(с использованием внутренней эвристики). Эти алгоритмы выводятся аналогично

cudnnFindConvolutionBackwardFilterAlgorithm.

CUDNN_REDUCE_TENSOR_MUL_NO_ZEROS

Функция MUL_NO_ZEROS - это уменьшение умножения, которое игнорирует нули в

данные.

CUDNN_OP_TENSOR_NOT

Функция OP_TENSOR_NOT - это унарная операция, которая принимает отрицательное значение

(альфа * A).

cudnnGetDropoutDescriptor

Функция cudnnGetDropoutDescriptor позволяет приложениям отключаться

ценности.

Хорошо, я подумываю о создании нового выпуска, который будет больше похож на «блог» CUDA 9 RC + cuDNN 7.0. У меня «в руке» есть сборка TF, которая пропатчена вместе, но это CUDA 9RC и cuDNN 7.0, и я хочу посмотреть, интересно ли кому-нибудь попробовать ее. Мне также нужно убедиться, что нет какой-то странной причины, по которой я не могу этим поделиться. В некоторые апстрим-библиотеки, которые использует TensorFlow, необходимо внести изменения, но в ближайшем будущем вы начнете получать PR от NVIDIA. Я и моя команда смогли протестировать CUDA 8 + cuDNN 6 на Volta, а затем CUDA 9RC + cuDNN 7 на Volta (V100) с кодом FP32. Я делаю только сборки Linux и Python 2.7, но если все / кто-либо из вас заинтересован, я хотел бы попытаться привлечь сообщество больше, чем мы сделали с cuDNN 6.0. Это может быть не очень весело, но я хочу предложить, а также попытаться сделать так, чтобы это было больше похоже на то, что мы находимся в этом вместе, а не я ищу информацию. Я также все еще хочу составить списки функций, над которыми мы работаем, но не перспективны для cuDNN 7 (и 6.0). @ cancan101 спасибо за полный список.

@tfboyd : Буду признателен за описания выполнения CUDA 9.0RC + cuDNN 7.0. Я сам использую странную систему (ubuntu 17.10 beta с TF1.3, CUDA 8.0 и cuDNN 6.0 gcc-4.8), и обновление до cuda 9 и cudnn 7 было бы неплохо с точки зрения компиляции.

Я посмотрю, что я могу сделать, чтобы получить то, что вам нужно, чтобы построить себя, и

двоичный. Руководитель группы по производительности сказал, что я могу попытаться сделать это

так что мы можем быть более прозрачными и, надеюсь, получать больше удовольствия от сообщества.

Получить патч и как его собрать не очень сложно, но немного

Сильнее. Это также будет очень неформально, так как у меня нет времени управлять

ветка, и пластырь может очень быстро сгнить (не наносить аккуратно). В

патч был использован, чтобы убедиться, что все участники согласны с изменениями в

в целом, и я ожидаю, что начнут поступать индивидуальные PR.

Пт, 11 августа 2017 г., в 5:22, Erlend Aune [email protected]

написал:

@tfboyd https://github.com/tfboyd : Буду признателен за описания

при выполнении CUDA 9.0RC + cuDNN 7.0. Я сам использую странную систему (ubuntu

17.10 beta с TF1.3, CUDA 8.0 и cuDNN 6.0 gcc-4.8) и обновление до

cuda 9 и cudnn 7 действительно были бы хороши с точки зрения компиляции.-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321798364 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesj4WRkFKNX-Nt2oKtvp0oyQVBtM5ks5sXEdqgaJpZM4OuRL7

.

@tfboyd : Мне интересно, как вы этим поделитесь? Филиал?

@tfboyd Мне тоже было бы очень интересно. Спасибо!

Пытаюсь разобраться на этой неделе. Логистика зачастую сложнее, чем я

считать.

12 августа 2017 г., 10:18, «Танмай Бакши» [email protected] написал:

@tfboyd https://github.com/tfboyd Мне определенно было бы очень интересно, как

хорошо. Спасибо!-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-321994065 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesjO42Rl1WCyW0KR22KgbydKh1O4Zks5sXd6AgaJpZM4OuRL7

.

Инструкции и двоичный файл для игры, если вам нравится Python 2.7. Я собираюсь закрыть это, так как я обновлю проблему, которую создаю, чтобы отслеживать усилия. @ tanmayb123 @Froskekongen

Я просто попытался установить предварительно скомпилированный tensorflow-gpu-1.3.0 для Python 3.6 в Windows x64 и предоставил библиотеку cuDNN версии 7.0 с Cuda 8.0, и, по крайней мере, для меня все, похоже, работает. Я не вижу никаких исключений или проблем.

Этого следовало ожидать? Является ли cuDNN 7.0 обратно совместимой с cuDNN 6.0? Может ли это привести к каким-либо проблемам?

@apacha Я немного удивлен, что это сработало. Я уже видел ошибку в своем тестировании, когда двоичный файл TensorFlow не может найти cuDNN, потому что он ищет его по имени, а файлы * .so включают в себя 6.0 / 7.0. Удаленно возможно, что у вас еще есть cuDNN 6. Я не люблю гадать о вашей настройке, но если бы я делал ставку, я бы сказал, что она все еще использует cuDNN 6.

Что касается обратной совместимости, минус TensorFlow, который компилируется для поиска конкретной версии. Я не знаю.

Наконец, это не имеет большого значения. PR cuDNN 7 почти одобрены / объединены, и предварительно скомпилированный двоичный файл, вероятно, переместится в cuDNN 7 начиная с версии 1.5.

ОБНОВЛЕНИЕ о прогрессе в CUDA 9RC и cuDNN 7

- PR от NVIDIA почти одобрены

- Изменение EIGEN было одобрено и объединено

- Тестирование FP16 началось всерьез на V100 (Volta)

@tfboyd просто для полноты: раньше я использовал cuDNN 5, и, поскольку мне пришлось обновиться для tensorflow 1.3, я просто перешел на cuDNN версии 7, чтобы попробовать. Я явно удалил cudnn64_5.dll и в моем пути установки CUDA нет cudnn64_6.dll . Может, это волшебство Windows. :-П

Однако обратите внимание на одну вещь: я все еще использую CUDA 8.0, а не 9.0.

@apacha Это может быть волшебство Windows. Я не хотел осуждать, потому что понятия не имел. Я думаю, что магия Windows возможна, поскольку вызовы cuDNN не должны были меняться, и, следовательно, обратная совместимость кажется вероятной. Для сборок linux TensorFlow ищет определенные файлы (или именно так это выглядит, когда я получаю ошибки) и очень недоволен, если не находит cudnnblahblah.6.so. Спасибо за новости и подробности.

Есть ли ветка / тег, что мы можем проверить и попробовать?

Начал новую установку, Ubuntu 17 ... затем новый gcc наложил CUDA 9, я вижу, что CuDNN, который соответствует 7 ... вы видите, куда я направляюсь.

Я могу наверняка взломать свою установку во многих местах (и снова начать ее с нуля с Ubuntu 16), просто я так близок, исправление, как говорят, близко ... зачем делать большой скачок в прошлом, если я могу сделать небольшой прыжок в будущее!

PR почти утверждены. Они находятся на рассмотрении. Я подозреваю еще пару

максимум недель, но на эти проверки может уйти время. Я думаю это все из

их. Там может быть отставший или изменение, чтобы получить сдачу EIGEN для

CUDA 9. Я их лично не готовил. Они приближаются с каждым днем.

https://github.com/tensorflow/tensorflow/pull/12504

https://github.com/tensorflow/tensorflow/pull/12503

https://github.com/tensorflow/tensorflow/pull/12502

Во вторник, 12 сентября 2017 г., в 19:49, Реми Морин [email protected]

написал:

Есть ли ветка / тег, что мы можем проверить и попробовать?

Начал новую установку, Ubuntu 17 ... затем новый gcc наложил CUDA 9,

Я вижу, что CuDNN, которому подходит 7 ... вы видите, куда я направляюсь.

Я точно могу взломать свою установку во многих местах (и начать ее с нуля).

снова с Ubuntu 16) просто я так близок, исправление, как говорят, близко ... почему

совершить большой прыжок в прошлое, если я смогу сделать небольшой прыжок в будущем!-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-329041739 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesrpX6TSN6fVESEsql3QNtjgo-LM9ks5sh0KqgaJpZM4OuRL7

.

@tfboyd Это все еще проблема? Я понял, что cuda 9.0 вышла только сегодня.

Была выпущена cuda 9.0, я не могу найти установочный файл cuda 8.0 ....

пожалуйста, обновите tenorflow ...

Была выпущена cuda 9.0, я не могу найти установочный файл cuda 8.0 ....

@thomasjo спасибо!

Итак, после того, как @tfboyd утвердит упомянутые им PR, будет ли теперь tenorflow 1.3 совместим с CUDA 9 и cuDNN 7? Кто-нибудь где-нибудь действительно успешно установил это?

@voxmenthe Я только что попытался установить tf1.3 с CUDA 9.0 и cuDNN7. Я получил ошибку, связанную с этой проблемой # 12489

РЕДАКТИРОВАТЬ: В принципе, я не знаю, как это сделать. Но перейдя в основную ветку (которая вначале не устанавливалась для меня) без каких-либо дальнейших изменений, я смог ее установить. Хотя теперь, когда я пытаюсь импортировать тензорный поток, он говорит, что отсутствует модуль платформы.

Есть ли признаки того, насколько близки к работе связанные PR? Я установил cuDNN 7, затем понял, что это вызывает проблемы - я могу перейти на версию 6, но решил, что могу подождать, если проблема будет близка к разрешению ...

Похоже, что PR одобрены. Я сам не запускал сборку несколько дней. Имейте в виду, что в 1.3 не будет этих изменений, как это было некоторое время назад. 1.4 будут изменения. Надеюсь, на этой неделе я смогу загрузить последние версии и сделать новую сборку. Я подозреваю, что кто-то сделает это хорошо, прежде чем у меня будет время.

Есть ли шанс, что кто-нибудь из вас, умных людей, может сделать учебник для tf 1.3 или 1.4 с CUDA v9.0, cudnn 7.0 для Win 10 x64? Я пробовал установить (Anaconda), но продолжаю получать ошибку _pywrap_tensorflow_internal, и я уже проверил, что msvcp140.dll добавлен в мой путь ..

@ devilsnare007 : Думаю, больше всего шансов, если вы https://github.com/philferriere/dlwin. Просто замените перечисленные версии текущими версиями. Отметим, что TF 1.4 даже не выпущен. Но TF 1.3 должен нормально работать с предоставленными инструкциями. Как только все будет обновлено и будет выпущен TF 1.4, мы обновим это руководство.

Будет ли поддерживаться cuDNN 7.0 после выхода TF 1.4?

@soloice

На начальном этапе (пару дней назад) я смог скомпилировать CUDA 9 (релизную версию) с cuDNN 7.0 без особых изменений и провел несколько тестов tf_cnn_benchmarks.py на GTX 1080. Все выглядит нормально. TF 1.4, который должен RC на этой неделе, будет иметь двоичные файлы CUDA 8 и cuDNN 6, но также будет хорошо компилироваться с CUDA 9 и cuDNN 7. Целью TF 1.5 является наличие CUDA 9 и cuDNN 7 в двоичном файле. Это дает людям время для обновления своих системных библиотек и больше времени для тестирования. Если вы используете Voltas, не стесняйтесь начинать другой поток, и я буду обновлять его, он будет прогрессировать на FP16 в реальном времени.

@tfboyd Приятно слышать, что TF 1.4 компилируется с cuDNN 7! Если в какой-то момент вы захотите создать руководство по установке, это станет отличной общественной услугой для сообщества DL.

Нет проблем, это должно быть достаточно просто, и я рад попробовать заполнить это

зазор.

В понедельник, 9 октября 2017 г., в 9:42 Джефф [email protected] написал:

@tfboyd https://github.com/tfboyd Приятно слышать, что TF 1.4 компилируется

с cuDNN 7! Если в какой-то момент вы захотите создать руководство по установке,

будет отличной общественной услугой для сообщества DL.-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335212652 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesp7d2aT8gsGOWb6YjHH_CnpKXUIPks5sqkztgaJpZM4OuRL7

.

Есть ли возможность иметь WHL, который работает с CUDA 9 и cuDNN 7.0?

Спасибо!

Я опубликую свой (который, скорее всего, будет не 1.4, а какой-то близкий к нему

и я добавляю хэш в имя), когда создаю его для тестирования, но он будет

быть ubuntu 16.04 (я забыл, какая версия gcc), linux, python 2.7 просто FYI.

И я не собираюсь делиться этими сборками, потому что это может быть

сбивает с толку людей, и я подчеркну, что вы знаете, что я включил некоторые

сумасшедший черный ход. Хотя добавление секретного кода кажется слишком большим трудом

мне.

Я думаю, что сборки nightly-gpu практически доступны в pip (я почти уверен, что они

всегда случалось, вам просто нужно было их найти), что означает, что после 1.4

ночные сборки очень быстро перейдут на CUDA 9 + cuDNN 7.

В понедельник, 9 октября 2017 г., в 11:41, alexirae [email protected] написала:

Есть ли возможность иметь WHL, который работает с CUDA 9 и cuDNN 7.0?

Спасибо!

-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-335249979 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZeskJ5LXJwFcRpm-sKZ9QORoltrHOEks5sqmj1gaJpZM4OuRL7

.

@tfboyd Спасибо за ответ. Наконец, мне удалось собрать последнюю версию TF из исходников с поддержкой CUDA 8 + cuDNN 7 на Ubuntu 16.04, и все отлично работает на GTX 1080 Ti.

@tfboyd Поддерживает ли 14.rc TF CuDNN 7 и CUDA 9?

Он включен, если вы строите из исходников. Я хочу изменить значение по умолчанию

двоичные файлы, что требует от меня выполнения некоторых регрессионных тестов на K80s на AWS, чтобы

убедитесь, что все выглядит хорошо, а также создавайте сборки. Мы

сразу возникла проблема, так как драйверу NVIDIA требовалось снижение производительности

на Kokoro, работающем в Google Cloud, на 30%. Нет ничего прямо

вперед, но CUDA 9 и cuDNN 7 находятся в исходном коде 1.4 и, как и ожидалось, в

очень ограниченные тесты на Паскале для меня.

12 октября 2017 г., в 2:40, Константин [email protected]

написал:

@tfboyd https://github.com/tfboyd Поддерживает ли 14.rc TF CuDNN 7 и

CUDA 9?-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336075883 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesq03dvnXWd0GLXODBTNCWExlZGPnks5srd6pgaJpZM4OuRL7

.

Есть ли возможность иметь WHL, который работает с CUDA 9, cuDNN 7.0 и python 3.5?

После завершения TF 1.4 ночные сборки перейдут на CUDA 9+.

cuDNN 7 при условии, что проблем нет. Сборки, которые я сделал и которыми делюсь ради развлечения,

всегда python 2.7, потому что это значение по умолчанию в моих тестовых системах.

В понедельник, 16 октября 2017 г., в 6:59, Диего Сталдер [email protected]

написал:

Есть ли возможность иметь WHL, который работает с CUDA 9, cuDNN 7.0 и

питон 3.5?-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-336894073 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesqgclWqET4OufQHV3FAD4XxgnZiKks5ss2E6gaJpZM4OuRL7

.

Ожидаемая дата выхода?

Все, кто грызет бит, просто создайте #master из исходников. Это не слишком сложно (просто отнимает много времени), вы получаете последнюю версию CUDA / cuDNN, _и_ дополнительную оптимизацию при установке pip / whl (например, см. Оптимизацию ЦП в этом руководстве ). Кроме того, при следующем обновлении CUDA / cuDNN вы сможете построить заново без ожидания.

построение из исходников, TF1.4 работает с cuda 9.0, cuDNN v7.0.3 и python3.5

Могу ли я собрать из исходников на платформе win10?

Хотелось бы, чтобы TF работал на cuda 9.0, cuDNN v7, python3. 6 и win10

Создавая из исходных кодов, TF1.4 также работает с cuda 9.0, cuDNN v7.0.3 и python2.7.

@affromero Были ли у вас случайно проблемы с jsoncpp?

Я провел тест tf_cnn_benchmarks при сборке AWS из ветки TF 1.4RC0 с CUDA 9 / cuDNN 7, и результаты были равны или немного быстрее, чем CUDA 8 + cuDNN 6.

Изменить: удалить упоминание, я не обращался к комментарию elipeters. :-)

@elipeters

Когда мы говорим о строительстве, мы имеем в виду сборку из исходного кода, а не установку файла wheel. Колесо уже скомпилировано, а двоичные файлы 1.4 поддерживают CUDA 8 + cuDNN 6. Чтобы получить CUDA 9, вам нужно будет выполнить сборку из исходников. Я никогда не занимался сборкой окон. После выхода 1.4 команда переключит ночные сборки на CUDA 9.

Существует второй кандидат на выпуск (rc1) для 1.4 в виде предварительно скомпилированного колеса (https://pypi.python.org/pypi/tensorflow). Кто-нибудь еще тестировал это с CUDA 9?

Пробовал, но не с рабочим cuda 9.0.

Я попробую снова.

1.4 - это CUDA 8 + cuDNN 6, это не будет работать с CUDA 9, вам придется скомпилировать из исходников

после выпуска 1.4 мы будем работать над переключением ночных сборок на CUDA 9, и тогда 1.5, скорее всего, будет CUDA 9.

Я знаю, что CUDA 9 отлично работает при сборке 1.4 из исходников (ubuntu 16.04 / python 2), потому что в прошлые выходные я проводил тесты на AWS.

У меня есть недавний рецепт сборки из исходников здесь (пожалуйста, опубликуйте ссылку на свое колесо CUDA 9.0, когда вы его построите)

Ты лучший Ярослав.

В среду, 25 октября 2017 г., в 8:11, Ярослав Булатов [email protected]

написал:

У меня есть недавний рецепт сборки из исходников здесь

https://github.com/yaroslavvb/tensorflow-community-wheels (опубликуйте

ссылка на ваше колесо CUDA 9.0 там же, когда вы его построите)-

Вы получаете это, потому что вас упомянули.

Ответьте на это письмо напрямую, просмотрите его на GitHub

https://github.com/tensorflow/tensorflow/issues/12052#issuecomment-339361959 ,

или отключить поток

https://github.com/notifications/unsubscribe-auth/AWZesmRwb0UmLWxzANWCq5RrT6teYtr5ks5sv0-IgaJpZM4OuRL7

.

привет я пытаюсь создать тензорный графический процессор с помощью win10 env , тогда я также встретил такую проблему , может кто-нибудь мне помочь , сначала спасибо.

мое окружение :

win10 + gtx 1080ti + cuda 9.0 + cuDNN 7 + визуальная студия профессии 2015 + cmake 3.6.3 + python 3.5.4

когда я переключаюсь на тензорный поток r1.4 , и строю с помощью cmake в среде win10 проблема в том, что :

`CUSTOMBUILD: Внутренняя ошибка: утверждение не удалось на:" C: /dvs/p4/build/sw/rel/gpu_drv/r384/r384_00/drivers/compiler/edg/EDG_4.12/src/lookup.c ", строка 2652 [ C: \ TF \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

При компиляции "C: /Users/ADMINI~1/AppData/Local/Temp/tmpxft_00000c94_00000000-8_adjust_contrast_op_gpu.cu.cpp4.ii" обнаружена 1 катастрофическая ошибка.

Компиляция прервана.

Adjust_contrast_op_gpu.cu.cc

CUSTOMBUILD: ошибка nvcc: 'cudafe ++' умер со статусом 0xC0000409 [C: \ TF \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

Ошибка CMake в tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release. cmake: 267 (сообщение):

Ошибка при создании файла

C: /TF/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir / __ / __ / core / kernels / Release / tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj`

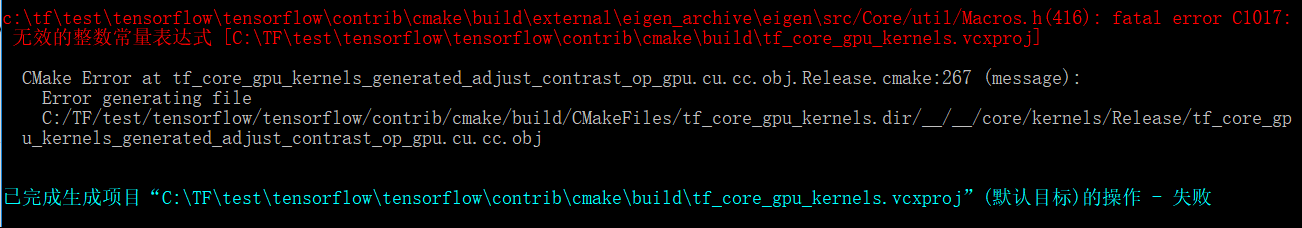

Вышеупомянутая проблема выглядит как проблема cuda compolie но когда я переключаю версию tenorflow на r1.3 , другая проблема accur :

`c: \ tftest \ tensorflow \ tensorflow \ contrib \ cmake \ build \ external \ eigen_archive \ eigen \ src / Core / util / Macros.h (416): фатальная ошибка C1017:

无效 的 整数 常量 表达式 [C: \ TFtest \ tensorflow \ tensorflow \ contrib \ cmake \ build \ tf_core_gpu_kernels.vcxproj]

Ошибка CMake в tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release. cmake: 267 (сообщение):

Ошибка создания файла

C: /TF/test/tensorflow/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir / __ / __ / core / kernels / Release / tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.ob

похоже, что у файла adjust_contrast_op_gpu.cu.cc есть проблема , но я не могу найти в нем никаких ошибок.

такие вышеупомянутые проблемы беспокоят меня несколько дней , желаю кому-то помочь мне в этой попытке и успеха , и сильно ожидаю, что обновление tenorflow от Google поддерживает cuda 9.0 и cudnn 7 в среде win10.

Кто-нибудь выпустил whl для TensorFlow с CUDA 9 и cuDNN 7.0?

@vellamike Я знаю, что ваш вопрос общий, но команда TF будет иметь CUDA 9 в двоичных файлах с версией 1.5, которая должна появиться в четвертом квартале. На данный момент вам нужно строить из исходников.

Я пытаюсь построить 1.4 с CUDA 9 и cuDNN 7 в mac 10.13 high sierra. Я продолжаю получать эту ошибку

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: output 'tensorflow/core/kernels/_objs/depthwise_conv_op_gpu/tensorflow/core/kernels/depthwise_conv_op_gpu.cu.pic.o' was not created.

ERROR: /Users/smitshilu/tensorflow/tensorflow/core/kernels/BUILD:2948:1: not all outputs were created or valid.

Target //tensorflow/tools/pip_package:build_pip_package failed to build

Любое решение для этого?

@smithilu, возможно, связанный https://github.com/tensorflow/tensorflow/issues/2143

Почему в 1.4 до сих пор нет CUDA 9 в двоичных файлах? Эта версия была выпущена давно, и для использования с V100 требуется сборка из исходников, что не так гладко и быстро, что связано с рядом обнаруженных проблем.

@ViktorM Какие проблемы у вас были при компиляции из исходников? Это было немного сложно, но не так сложно.

26 сентября 2017 года была GA для CUDA 9. Если мы выпустим двоичные файлы CUDA 9 + cuDNN 7 в четвертом квартале, я думаю, это будет самое быстрое обновление cuDNN. Я не был здесь с 8,5 до 9, поэтому понятия не имею. Я хотел бы, чтобы мы пошли немного быстрее, но это также означает, что любой, у кого есть установка CUDA 8, должен обновиться не только до CUDA 9, но им также необходимо обновить драйвер своего устройства до 384.x, что, я могу сказать, не является чем-то, что производят люди воспринимать легкомысленно.

В идеале у нас было бы бесконечное количество (или еще несколько, но матрица быстро взрывается) сборок, но это еще одна проблема, на объяснение которой уйдет много времени, и я сомневаюсь, что многим это небезразлично.

@yaroslavvb Если честно, мы работаем над некоторыми проблемами FP16. В tf_cnn_benchmarks для FP16 есть путь, и в первую очередь основное внимание уделяется ResNet50, и мы также работаем над автоматическим масштабированием для FP16. Вы можете попробовать, если вам интересно, но мы активно работаем над некоторыми проблемами. Люди участвуют в этом, и это просто требует времени. Наконец-то у нас есть DGX-1, поэтому мы можем играть с теми же контейнерами и пытаться отслеживать производительность на этой конкретной платформе в дальнейшем.

Хорошо, я собираюсь установить Ubuntu 17.10, и я просто хотел попробовать все новейшие возможности для развлечения.

Прежде чем я это сделаю, я просто хотел знать, пробовал ли кто-нибудь из приведенных ниже стеков строить из исходников и получил ли удачу?

-> Ubuntu 17.10, CUDA 9.0, cuDNN 7.0, мастер TF

-> Ubuntu 17.10, CUDA 8.0, cnDNN 6.1, TF 1.4

Я столкнулся с той же проблемой, что и @ xsr-ai, в частности, используя Python 3.6.3, VS 2017, CUDA 9, cuDNN 7.

@ aluo-x Вы имеете в виду, что пробовали на Windows 10? Предполагая, потому что вы сказали VS 2017.

Да, это правильно. Вот конкретная ошибка:

CustomBuild:

Building NVCC (Device) object CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

CMake Error at tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj.Release.cmake:222 (message):

Error generating

C:/optimae/tensorflow-1.4.0/tensorflow/contrib/cmake/build/CMakeFiles/tf_core_gpu_kernels.dir/__/__/core/kernels/Release/tf_core_gpu_kernels_generated_adjust_contrast_op_gpu.cu.cc.obj

C:\Program Files (x86)\Microsoft Visual Studio\2017\BuildTools\Common7\IDE\VC\VCTargets\Microsoft.CppCommon.targets(171,5): error MSB6006: "cmd.exe" exited with code 1. [C:\optimae\tensorflow-1.4.0\

tensorflow\contrib\cmake\build\tf_core_gpu_kernels.vcxproj]

@ aluo-x Вы использовали последнюю версию c-make? т.е. релиз-кандидат или стабильный релиз?

Использование cmake 3.9.5, swig 3.0.12, CUDA 9.0.176, cuDNN 7.0.3. VS 2017 19.11.25547.

@ aluo-x Даже мне не повезло с c-make. Но можно ли попробовать построить с Базел?

@smitshilu Если я не ошибаюсь, у вас ошибка выравнивания, верно? Подобно описанному здесь для pytorch: https://github.com/pytorch/pytorch/issues/2692

Я попытался применить то же решение, которое удаляет все ___ align __ (sizeof (T)) _ из проблемных файлов:

_tensorflow / core / kernels / concat_lib_gpu_impl.cu.cc_

_tensorflow / core / kernels / depthwise_conv_op_gpu.cu.cc_

_tensorflow / core / kernels / split_lib_gpu.cu.cc_

Я не уверен, вызывает ли это какие-либо проблемы, но, похоже, пока он работает нормально. И насколько я понимаю, среда выполнения всегда будет использовать фиксированное выравнивание 16 для разделяемой памяти.

Для заинтересованных у нас загружены колеса CUDA 9. Не нужно строить себя! https://github.com/mind/wheels/releases/tag/tf1.4-gpu-cuda9

Ubuntu 17.10, CUDA 9, CuDNN 7, Python 3.6, bazel 0.7.0 + TF из исходного кода (мастер).

Следуйте инструкциям, приведенным в этом ответе, чтобы запустить CUDA:

https://askubuntu.com/questions/967332/how-can-i-install-cuda-9-on-ubuntu-17-10

Обратите внимание, что вы можете использовать эти команды вместо 64-битной версии:

sudo ln -s /usr/bin/gcc-6 /usr/local/cuda-9.0/bin/gcc

sudo ln -s /usr/bin/g++-6 /usr/local/cuda-9.0/bin/g++

sudo ./cuda_9.0.176_384.81_linux-run --override

Для установки Tensorflow вам понадобится

- Перед компиляцией TF: правильно настройте переменные пути (пути со страницы NVIDIA у меня не работали):

export PATH=/usr/local/cuda-9.0/bin:${PATH}

export LD_LIBRARY_PATH=${LD_LIBRARY_PATH}:/usr/local/cuda-9.0/lib64

- Перед компиляцией: настройте bazel для использования той же версии gcc, что и во время установки CUDA:

sudo update-alternatives --remove-all g++

sudo update-alternatives --remove-all gcc

sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-6 10

sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-6 10

- Следуя инструкциям TF, как только вы перейдете к этапу сборки bazel, обратите внимание, что вам понадобится дополнительный флаг для компиляции с версией gcc выше 4. *:

bazel build --config=opt --config=cuda --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0" //tensorflow/tools/pip_package:build_pip_package

@alexbrad Я столкнулся с той же проблемой, что и для графического процессора Mac с CUDA 9, cuDNN 7. Это решение также сработало для меня, и я пока не сталкивался с какими-либо проблемами при использовании TF.

Изменения источника и колесо: https://github.com/nathanielatom/tensorflow/releases/tag/v1.4.0-mac

Ubuntu 16.04, TensorFlow 1.4 с уже установленными и протестированными CUDA 9.0 и cuDNN 7.0.3:

Установите Tensorflow 1.4 из исходного кода

cd ~/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

- Настроить для версии CUDA: 9.0

- Настроить для версии cuDNN: 7.0.3

- Получите свои вычислительные возможности на https://developer.nvidia.com/cuda-gpus

- Я установил это на 6.1, так как у меня GeForce GTX 1070.

- При необходимости настройте другие параметры

./configure

Установка Базела

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

Построение TensorFlow

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Имя файла с колесом тензорного потока выше может быть другим.

Просто ls /tmp/tensorflow_pkg чтобы проверить

Шаги установки для Mac 10.13, CUDA 9 и tensorflow 1.4 https://gist.github.com/smitshilu/53cf9ff0fd6cdb64cca69a7e2827ed0f

Может ли кто-нибудь сказать мне, как я могу создать пакет tenorflow whl из источников для Windows в Linux (Ubuntu 16.04) с помощью bazel? Если я прав, это было возможно для версии 1.2. Спасибо.

@ValeryPiashchynski, вы можете выполнить следующие действия https://www.tensorflow.org/install/install_sources

@smitshilu Спасибо за ответ. Я могу собрать пакет wheel в Ubuntu, выполнив следующие действия, и все будет хорошо работать в Ubuntu. Но я не могу установить этот пакет whl в ОС Windows (есть ошибка: не поддерживается колесо). Итак, мой вопрос: как я могу создать пакет в Ubuntu, который затем можно установить в Windows?

~ @ValeryPiashchynski Я не думаю, что это возможно. ~

(вынимая его, как указано в комментариях ниже)

Когда-нибудь через clang появится возможность кросс-компоновки Ubuntu для Windows. Вероятно, это потребует множества исправлений, поскольку двоичные файлы Windows в настоящее время создаются с помощью MSVC. Я задал практически тот же вопрос, когда лично разговаривал с @gunan в прошлый понедельник. Следует ли выделить отдельную проблему GH, поскольку она не имеет прямого отношения к CUDA?

Кросс-компиляция возможна с помощью bazel, но не уверен, как это сделать с тензорным потоком. Для справки

https://github.com/bazelbuild/bazel/wiki/Building-with-a-custom-toolchain

https://github.com/bazelbuild/bazel/issues/1353

Кто-нибудь знает, есть ли у ночных сборок tenorflow 1.5, размещенных здесь (сборки win10), поддержку CUDA9 + CuDNN7?

https://pypi.python.org/pypi/tf-nightly-gpu/1.5.0.dev20171115

Кстати, совершенно безответственно закрывать этот тикет, а также номер 14126 только потому, что вы сказали: «Он будет выпущен с TF 1.5». В MXNET 0.12 уже работает CUDA9 FP16. Tensorflow и CNTK нужно поторопиться. Это выгодно не только Вольте.

Пока нет, мы работаем над обновлением инфраструктуры сборки для CUDA 9.

Мы планируем выпустить пакеты с CUDA 9 до конца этой недели.

У меня два компьютера, и вчера я установил 1080ti и установил все (cuda8 и cudnn6), новый графический драйвер, Visual Studio 2015

сравниваю время эпохи 1080ti против 980ti

и я вижу, что 1080ti запускает каждую эпоху за 22 минуты, но 980ti запускается за 13 минут !!! (партия = 60 для 1080 против партии = 20 для 980ti)

почему 1080ти работает медленнее 980ти !!!! и как я могу проверить что не так ?!

Какое время работы, если использовать 20 пакетов для 1080Ti?

@gunan , просто интересно, есть ли новое

@smithilu

в 1080ти с 20 партиями = 26 мин

и с 60 пакетами = 19 мин

в 980gtx при партии 20 = 14 мин !!!!

Я использую Windows, устанавливаю последнюю версию драйвера с cuda 8 и cudnn 6

как я могу узнать, почему он работает медленнее, чем 980?

@nasergh У вас GTX 1080ti и 980ti в SLI?

@vickylance

Нет

два разных компа!

Оба являются жестким диском Cori7 и 1 ТБ, и я загружаю образ данных с жесткого диска sata 1 ТБ

но в 980 году у меня есть окна на жестком диске SSD

Я пробую другую версию драйвера в последнюю очередь проверяю 388.13, загруженную с веб-сайта asus, с CUDA 8 и cudnn 6

я не знаю, что из этого является причиной

1- окна! может он лучше работает на linux

2- Скорость жесткого диска

3- подделка 1080TI

4- CUDA и cudnn несовместимы с 1080ti

5- ЦП (ЦП на компьютере 1080TI мощнее 980)

что ты посоветуешь ?

@nasergh

1) Оперативная память такая же? если так. Я не уверен, повлияет ли это так сильно, но проверьте, одинаковы ли МГц ОЗУ в обеих системах.

2) Проверьте использование графического процессора в% при работе на 980ti и 1080ti. Используйте этот инструмент, если хотите проверить использование графического процессора. https://docs.microsoft.com/en-us/sysinternals/downloads/process-explorer Есть лучшие, но это то, что пришло мне в голову.

3) Если вы хотите добиться максимальной производительности, я бы предложил установить Ubuntu16.04 в качестве двойной загрузки в вашей системе 1080ti и использовать CUDA 9.0 и cuDNN 7.0.

4) Окна также занимают много системных ресурсов сами по себе, поэтому запуск его на SSD определенно дает ему преимущество, но не такого масштаба, как показано в вашем тестовом сценарии.

Может дело в выбранной архитектуре платы.

TF по умолчанию настроен на 3.0, 3.5 и 5.2; в то время как 1080TI составляет 6,1 (Паскаль), а 980 - 5,2 (Максвелл) согласно https://en.wikipedia.org/wiki/CUDA#GPUs_supported.

Может быть, понижение до 3.0 или 5.2 неэффективно на 1080TI, в то время как для 980 оно родное?

Попробуйте выполнить вычисления с возможностями 5.2 и 6.1 (см. CMakeLists.txt 1.232 и 1.246)

De: nasergh [mailto: [email protected]]

Посланник: mercredi 22 ноября 2017 г., 17:17

А: тензорный поток / тензорный поток

Копия: сильвен-бугну; Руководство по эксплуатации

Цель: Re: [tenorflow / tensorflow] Обновление до CuDNN 7 и CUDA 9 (# 12052)

@vickylance

Нет

два разных компа!

Оба являются жестким диском Cori7 и 1 ТБ, и я загружаю образ данных с жесткого диска sata 1 ТБ

но в 980 году у меня есть окна на жестком диске SSD

Я пробую другую версию драйвера в последнюю очередь проверяю 388.13, загруженную с веб-сайта asus, с CUDA 8 и cudnn 6

я не знаю, что из этого является причиной

1- окна! может он лучше работает на linux

2- Скорость жесткого диска

3- подделка 1080TI

4- CUDA и cudnn несовместимы с 1080ti

что ты посоветуешь ?

-

Вы получаете это, потому что подписаны на эту ветку.

Ответьте на это письмо напрямую, просмотрите его на GitHub или отключите чат.

environment: cuda9.0 + cudnn7.0 + tf1.4 ,, и я обнаружил ошибку при запуске примера "ptb", TypeError: __init __ () получил неожиданный аргумент ключевого слова 'input_size', 'input_size' является параметром CudnnLSTM

после нескольких месяцев просмотра этой темы я собираюсь попробовать ее на Gentoo linux

у меня asus strix 1080TI

1- в ubunto я могу использовать драйвер на веб-сайте nvidia или я должен загрузить его с asus (потому что я не вижу драйвер для linux на веб-сайте asus)

2- последняя версия в порядке, или я должен указать 378,13, потому что в большинстве комментариев я вижу, что используется 378,13?

Благодарность

Для тех, кто работает с Windows, я только что загрузил TF 1.4.0, созданный на основе CUDA 8.0.61.2, cuDNN 7.0.4, Python 3.6.3, с поддержкой AVX в свое репо . Надеюсь, этого будет достаточно, пока CUDA 9 не будет разобрана в Windows.

Я пытаюсь установить CUDA9 и cudnn 7 на ubuntu 16.04 и python 3.6

но я потерпел неудачу :(

Я пробую все, ищу везде, но все равно выдает ту же ошибку "importError: libcublas.so.8.0 не может открыть файл общих объектов: нет такого файла или каталога

я думаю, что тензор хочет запустить CUDA8

как я могу сказать ему использовать cuda9? !!!! если ответ запускается из источника, как именно? я не видел очень четкого веб-сайта о сборке из исходников

Благодарность

Вы должны установить tf из источника @ nasergh

@ withme6696

как я могу установить его из исходников?

я знаю, что могу скачать одно из этого

https://github.com/mind/wheels/releases

но я не знаю какой скачать и как установить !?

@nasergh, ознакомьтесь с нашим README, чтобы узнать, как установить. Если вы не против установки MKL, вы можете сделать

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-37/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Если вы не хотите устанавливать MKL, вы можете сделать

pip --no-cache-dir install https://github.com/mind/wheels/releases/download/tf1.4-gpu-cuda9-nomkl/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Я буду использовать эту проблему как проблему отслеживания для поддержки CUDA 9.

На данный момент существует два блокиратора:

1 - https://github.com/tensorflow/tensorflow/pull/14770

2 - В Windows похоже, что у нас есть ошибка с NVCC. Построение TF с помощью CUDA9, похоже, не работает из-за сбоя компилятора. NVIDIA помогает разобраться в этом, и как только у нас будет обновление, мы продолжим.

@danqing

Спасибо

1- MKL насколько улучшить скорость?

2- в версии без MKL мне нужно установить MKL ?!

для 1 см. это - обратите внимание, что вычисления, выполняемые на GPU, явно не будут ускоряться.

для 2 вы этого не сделаете. убедитесь, что вы установили правильную версию.

кстати, это ветка с большим количеством подписчиков. если у вас в будущем возникнут проблемы с нашими колесами, пожалуйста, откройте проблему в нашем репо, а не комментируйте ниже, чтобы мы не спамили множество людей.

@Tweakmind : Я не могу пройти эту часть:

Построение TensorFlow

bazel build --config = opt --config = cuda // tensorflow / tools / pip_ package: build_pip_package --cxxopt = "- D_GLIBCXX_USE_CXX11_ABI = 0

bazel-bin / tensorflow / инструменты / pip_package / build_pip_package / tmp / tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

Первая строка кажется неполной (отсутствуют двойные кавычки)? Это три строки или две строки?

@goodmangu , я думаю, правильный код:

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

В команде отсутствуют двойные кавычки.

Я прохожу эту часть, используя скрипт здесь , но блокируюсь некоторыми ошибками компилятора cuda в https://github.com/tensorflow/tensorflow/issues/15108

Спасибо ребята. Оценил это. Я заставил его работать в тот же день, используя вместо этого бинарный файл Linux для ночной сборки. См .: https://github.com/tensorflow/tensorflow

Сейчас работает 3 GTX 1080 Tis с Keras. Прохладный!

Последние два дня потратил на попытки собрать Tensorflow из исходного кода (r1.4) для моего MacBook Pro с eGPU. Драйвер рабочий, с Cuda 8.0, cuDNN 6.0, Mac OSX Sierra 10.12. Очень близко к завершению, но через 20 минут блокируется некоторыми ошибками сборки. Кому-нибудь пока что повезло? Любой успешно собранный пакет, которым вы можете поделиться? Заранее спасибо.

@goodmangu Не могли бы вы указать, какой «двоичный файл Linux для ночной сборки» вы используете?

Конечно, это: tf_nightly_gpu-1.head-cp27-none-linux_x86_64.whl

По-прежнему нет поддержки Windows 10 для Cuda 9.0 + cuDNN 7.0? Просто проверяю.

Графический процессор Tensorflow 1.4.0

@goodmangu Я пробовал с 1.4, но OSX 10.13 и CUDA 9 cuDNN 7. Вы можете найти шаги здесь

@ eeilon79 есть ошибка nvcc в Windows, которая не позволяет нам создавать двоичные файлы. Мы получаем помощь от nvidia в решении этих проблем.

Есть ли какие-либо обновления для CUDA 9 в ночной версии Tensorflow (1.5-dev) в пакете tf-nightly-gpu pip? Необходимо использовать это 1.5 для CuDNNLSTM в Керасе

Ладно, пиар просто слился.

Примерно через 10-12 часов наши новые ночные клубы должны быть построены с помощью cuda9, за исключением окон.

В Windows мы все еще блокируемся ошибкой NVCC.

Я закончил общий пакет CUDA 9 и CUDANN 7 для системы Gentoo и попробовал фиктивный тест и, похоже, работал с фиктивным тензорным потоком импорта как tf в python, но мне нужно провести дополнительные тесты:

Я использую фиксацию: c9568f1ee51a265db4c5f017baf722b9ea5ecfbb

В Windows мы все еще блокируемся ошибкой NVCC.

Не могли бы вы разместить здесь ссылку на этот вопрос? Заранее спасибо!

@smitshilu Ваша статья мне помогла.

И я написал статью с добавлением некоторых элементов.

https://github.com/masasys/MacTF1.4GPU

@arbynacosta

я бегу

bazel build --config = opt --config = cuda // tensorflow / tools / pip_ package: build_pip_package --cxxopt = "- D_GLIBCXX_USE_CXX11_ABI = 0"

но я получаю эту ошибку

Ошибка: команда сборки поддерживается только из рабочей области.

Я также пробую тензор каждую ночь, но он дает ошибку

attributeerror: модуль tenorflow не имеет атрибута ....

вывод dir (tf)

['__doc__', '__loarder__', '__name__', __package__ '' __path__ __spec__]

Прости, @goodmangu , меня не было. Получилось ли у вас работать? Я пропустил закрывающие двойные кавычки, как указал @arbynacosta . Теперь у меня это работает под Ubuntu 17.10 с CUDA 9.0 и cuDNN 7.0.4. При необходимости я могу поработать над сборкой MacOS. Я отказался от Win10 и MacOS, но могу поработать над ними в эти выходные, если людям это нужно.

@nasergh , вы запускаете эту команду из клонированного каталога тензорного потока. Убедитесь, что в каталоге существует РАБОЧЕЕ МЕСТО.

Например:

~/Downloads/tensorflow$ ls

ACKNOWLEDGMENTS bazel-bin bazel-testlogs configure LICENSE tensorflow WORKSPACE

ADOPTERS.md bazel-genfiles BUILD configure.py models.BUILD third_party

arm_compiler.BUILD bazel-out CODE_OF_CONDUCT.md CONTRIBUTING.md README.md tools

AUTHORS bazel-tensorflow CODEOWNERS ISSUE_TEMPLATE.md RELEASE.md util

@Tweakmind

я запускаю команду

sudo su

а затем перейти в папку тензорного потока (там был файл рабочей области)

но я получаю эту ошибку

root<strong i="10">@pc</strong>:/home/pc2/tensorflow# bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

..........

WARNING: Config values are not defined in any .rc file: opt

ERROR: /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD:4:1: Traceback (most recent call last):

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD", line 4

error_gpu_disabled()

File "/root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/error_gpu_disabled.bzl", line 3, in error_gpu_disabled

fail("ERROR: Building with --config=c...")

ERROR: Building with --config=cuda but TensorFlow is not configured to build with GPU support. Please re-run ./configure and enter 'Y' at the prompt to build with GPU support.

ERROR: no such target '@local_config_cuda//crosstool:toolchain': target 'toolchain' not declared in package 'crosstool' defined by /root/.cache/bazel/_bazel_root/cccfa03cbaf937d443248403ec70306e/external/local_config_cuda/crosstool/BUILD

INFO: Elapsed time: 6.830s

FAILED: Build did NOT complete successfully (2 packages loaded)

currently loading: @bazel_tools//tools/jdk

@nasergh Пожалуйста, убедитесь, что вы следуете всем приведенным здесь инструкциям:

https://www.tensorflow.org/install/install_sources

Если вы строите с поддержкой графического процессора, убедитесь, что вы правильно настраиваете.

Установите Tensorflow 1.4 из исходного кода.

- На момент написания этой статьи это единственный способ работы с CUDA 9.0 и cuDNN 7.0.

- Инструкции: https://www.tensorflow.org/install/install_sources

- Некоторые инструкции могут не иметь смысла, вот как я это сделал:

cd $HOME/Downloads

git clone https://github.com/tensorflow/tensorflow

cd tensorflow

git checkout r1.4

./configure

Пример вывода и параметры будут отличаться от приведенных в инструкциях.

- Убедитесь, что вы настроили для версии CUDA: 9.0

- Убедитесь, что вы настроили версию cuDNN: 7.0.4

- Убедитесь, что вы знаете свои вычислительные возможности по адресу https://developer.nvidia.com/cuda-gpus.

- Я установил это на 6.1, так как у меня GeForce GTX 1070.

Установка Базела

sudo add-apt-repository ppa:webupd8team/java

sudo apt-get update && sudo apt-get install oracle-java8-installer

echo "deb [arch=amd64] http://storage.googleapis.com/bazel-apt stable jdk1.8" | sudo tee /etc/apt/sources.list.d/bazel.list

curl https://bazel.build/bazel-release.pub.gpg | sudo apt-key add -

sudo apt-get update && sudo apt-get install bazel

sudo /sbin/ldconfig -v

Построение TensorFlow

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

bazel-bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

pip install /tmp/tensorflow_pkg/tensorflow-1.4.0-cp36-cp36m-linux_x86_64.whl

@Tweakmind : спасибо, что вернулся ко мне по этому

@Tweakmind

Я делаю следующее, а также настраиваю файл, но он говорит

pc2<strong i="7">@pc</strong>:~/Downloads/tensorflow$ bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: Skipping '//tensorflow/tools/pip_package:build_pip_package': error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

WARNING: Target pattern parsing failed.

ERROR: error loading package 'tensorflow/tools/pip_package': Encountered error while reading extension file 'cuda/build_defs.bzl': no such package '@local_config_cuda//cuda': Traceback (most recent call last):

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 1042

_create_local_cuda_repository(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 905, in _create_local_cuda_repository

_get_cuda_config(repository_ctx)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 662, in _get_cuda_config

_cudnn_version(repository_ctx, cudnn_install_base..., ...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 360, in _cudnn_version

_find_cudnn_header_dir(repository_ctx, cudnn_install_base...)

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 612, in _find_cudnn_header_dir

auto_configure_fail(("Cannot find cudnn.h under %s" ...))

File "/home/pc2/Downloads/tensorflow/third_party/gpus/cuda_configure.bzl", line 129, in auto_configure_fail

fail(("\n%sCuda Configuration Error:%...)))

Cuda Configuration Error: Cannot find cudnn.h under /usr/lib/x86_64-linux-gnu

INFO: Elapsed time: 0.082s

FAILED: Build did NOT complete successfully (0 packages loaded)

currently loading: tensorflow/tools/pip_package

Я думаю, что правильно установил cuda и cudnn

`` ''

найти / usr | grep libcudnn

/ usr / share / doc / libcudnn7

/ usr / share / doc / libcudnn7 / авторское право

/usr/share/doc/libcudnn7/NVIDIA_SLA_cuDNN_Support.txt

/usr/share/doc/libcudnn7/changelog.Debian.gz

/ usr / share / lintian / overrides / libcudnn7

/usr/lib/x86_64-linux-gnu/libcudnn.so.7.0.4

/usr/lib/x86_64-linux-gnu/libcudnn.so.7

`` ''

@goodmangu , я буду работать над сборкой MacOS на выходных.

@nasergh , CuDNN ставили?

Вот мое руководство по cuDNN, включая исходный код и документацию для тестирования установки:

Скачать файлы cuDNN 7.0.4

Вы должны войти в свою учетную запись разработчика Nvidia в своем браузере.

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/cudnn-9.0-linux-x64-v7

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64

- https://developer.nvidia.com/compute/machine-learning/cudnn/secure/v7.0.4/prod/9.0_20171031/Ubuntu16_04-x64/libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64

Проверить каждый хеш

cd $HOME/Downloads

md5sum cudnn-9.0-linux-x64-v7.tgz && \

md5sum libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb && \

md5sum libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

Результат должен быть:

fc8a03ac9380d582e949444c7a18fb8d cudnn-9.0-linux-x64-v7.tgz

e986f9a85fd199ab8934b8e4835496e2 libcudnn7_7.0.4.31-1 + cuda9.0_amd64.deb

4bd528115e3dc578ce8fca0d32ab82b8 libcudnn7-dev_7.0.4.31-1 + cuda9.0_amd64.deb

04ad839c937362a551eb2170afb88320 libcudnn7-doc_7.0.4.31-1 + cuda9.0_amd64.deb

Установите cuDNN 7.0.4 и библиотеки

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

Проверка cuDNN

Ubuntu 17.10 включает компиляторы GNU версии 7+.

CUDA не совместим с версией выше 6

Возвращенная ошибка:

ошибка - неподдерживаемая версия GNU! Версии gcc старше 6 не поддерживаются!

Исправление - Установите версию 6 и создайте символические ссылки в каталоге bin CUDA:

sudo apt-get install gcc-6 g++-6

sudo ln -sf /usr/bin/gcc-6 /usr/local/cuda/bin/gcc

sudo ln -sf /usr/bin/g++-6 /usr/local/cuda/bin/g++

Теперь создайте mnistCUDNN для тестирования cuDNN.

cp -r /usr/src/cudnn_samples_v7/ $HOME

cd $HOME/cudnn_samples_v7/mnistCUDNN

make clean && make

./mnistCUDNN

Если cuDNN установлен правильно, вы увидите:

Тест пройден!

Уважаемый @Tweakmind

по-твоему работает спасибо за помощь (больше 3-х недель пытался установить тензор !!!)

Проблема в том, что я устанавливаю его на python3.6, и теперь у меня проблема с пакетом PIL

Traceback (most recent call last):

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 551, in get

inputs = self.queue.get(block=True).get()

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 644, in get

raise self._value

File "/home/pc2/anaconda3/lib/python3.6/multiprocessing/pool.py", line 119, in worker

result = (True, func(*args, **kwds))

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 391, in get_index

return _SHARED_SEQUENCES[uid][i]

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 761, in __getitem__

return self._get_batches_of_transformed_samples(index_array)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 1106, in _get_batches_of_transformed_samples

interpolation=self.interpolation)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/preprocessing/image.py", line 345, in load_img

raise ImportError('Could not import PIL.Image. '

ImportError: Could not import PIL.Image. The use of `array_to_img` requires PIL.

The above exception was the direct cause of the following exception:

Traceback (most recent call last):

File "<stdin>", line 7, in <module>

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/models.py", line 1227, in fit_generator

initial_epoch=initial_epoch)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/legacy/interfaces.py", line 87, in wrapper

return func(*args, **kwargs)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/engine/training.py", line 2115, in fit_generator

generator_output = next(output_generator)

File "/home/pc2/venv/lib/python3.6/site-packages/keras/utils/data_utils.py", line 557, in get

six.raise_from(StopIteration(e), e)

File "<string>", line 3, in raise_from

StopIteration: Could not import PIL.Image. The use of `array_to_img` requires PIL.

я пытаюсь установить подушку но это не помогает

Я также пытаюсь установить PIL, но

UnsatisfiableError: The following specifications were found to be in conflict:

- pil -> python 2.6*

- python 3.6*

@nasergh Что

pip install pillow

Мой выглядит так:

~$ pip install pillow

Requirement already satisfied: pillow in ./anaconda3/lib/python3.6/site-packages

@nasergh , мне нужно

@goodmangu , я не смогу сделать сборку Mac за выходные, так как у меня нет доступа к моему Mac Pro 2012 года. Надеюсь, у вас все хорошо в Ubuntu. Я знаю, что у меня это хорошо работает. Я должен вернуть его на следующих выходных.

@Tweakmind - Спасибо! , видели ли вы повышение производительности с помощью CUDA 9 и cuDNN 7?

Также я думаю, что некоторые шаги, упомянутые ниже @Tweakmind, являются избыточными, вам либо нужно:

tar -xzvf cudnn-9.0-linux-x64-v7.tgz

sudo cp cuda/include/cudnn.h /usr/local/cuda/include

sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

или

sudo dpkg -i libcudnn7_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-dev_7.0.4.31-1+cuda9.0_amd64.deb

sudo dpkg -i libcudnn7-doc_7.0.4.31-1+cuda9.0_amd64.deb

@gunan

CUDA 9.1.85 только что был выпущен с CuDNN 7.0.5 с исправлениями ошибок компилятора nvcc. Интересно, позволяет ли он пользователям Win10 компилировать Tensorflow 1.4.1? Пришло время.

Судя по переписке с NVIDIA, я не думаю, что 9.1 решила эту проблему.

Однако у нас есть обходные пути. Во-первых, нам нужно, чтобы этот PR был объединен с собственным:

https://bitbucket.org/eigen/eigen/pull-requests/351/win-nvcc/diff

Затем мы обновим нашу собственную зависимость, которая должна исправить все наши сборки для CUDA9.

Цена отклонена, но ее необходимо объединить вручную. Придется ли нам ждать собственного релиза или его собирают исходники?

Круто, тогда будет на Nightly pip?

@Tweakmind

я пытаюсь восстановить тензор с помощью python 2.7

но в сборке bazel я получаю эту ошибку

Я также устанавливаю numpy, но без изменений.

bazel build --config=opt --config=cuda //tensorflow/tools/pip_package:build_pip_package --cxxopt="-D_GLIBCXX_USE_CXX11_ABI=0"

ERROR: /home/gh2/Downloads/tensorflow/util/python/BUILD:5:1: no such package '@local_config_python//': Traceback (most recent call last):

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 310

_create_local_python_repository(repository_ctx)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 274, in _create_local_python_repository

_get_numpy_include(repository_ctx, python_bin)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 257, in _get_numpy_include

_execute(repository_ctx, [python_bin, "-c",..."], <2 more arguments>)

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 76, in _execute

_python_configure_fail("\n".join([error_msg.strip() if ... ""]))

File "/home/gh2/Downloads/tensorflow/third_party/py/python_configure.bzl", line 37, in _python_configure_fail

fail(("%sPython Configuration Error:%...)))

Python Configuration Error: Problem getting numpy include path.

Traceback (most recent call last):

File "<string>", line 1, in <module>

**ImportError: No module named numpy**

Is numpy installed?

and referenced by '//util/python:python_headers'

ERROR: Analysis of target '//tensorflow/tools/pip_package:build_pip_package' failed; build aborted: Loading failed

INFO: Elapsed time: 10.826s

FAILED: Build did NOT complete successfully (26 packages loaded)

currently loading: tensorflow/core ... (3 packages)

Fetching http://mirror.bazel.build/.../~ooura/fft.tgz; 20,338b 5s

Fetching http://mirror.bazel.build/zlib.net/zlib-1.2.8.tar.gz; 19,924b 5s

Fetching http://mirror.bazel.build/.../giflib-5.1.4.tar.gz; 18,883b 5s

Похоже, OSX исключен из cuDNN версии 7.0.5. Кто-нибудь знает подробности?

Я все еще не могу заставить tenorflow-gpu работать в Windows 10 (с CUDA 9.0.176 и cudnn 7.0).

Я удалил и tensorflow, и tensorflow-gpu и переустановил их (с параметром --no-cache-dir, чтобы обеспечить загрузку самой последней версии с собственным обходным путем). Когда я устанавливаю оба, мой графический процессор не распознается:

InvalidArgumentError (см. Выше для трассировки): невозможно назначить устройство для операции 'random_uniform_1 / sub': операция была явно назначена / device: GPU : 0, но доступные устройства: [/ job: localhost / replica : 0 / task: 0 / device : CPU: 0 ]. Убедитесь, что в спецификации устройства указано действительное устройство.

Когда я устанавливаю только tensorflow-gpu, он жалуется на отсутствующую dll:

ImportError: не удалось найти cudart64_80.dll. TensorFlow требует, чтобы эта DLL была установлена в каталоге, который указан в вашей переменной среды% PATH%. Загрузите и установите CUDA 8.0 по этому URL-адресу: https://developer.nvidia.com/cuda-toolkit

Это странно, потому что моя версия CUDA - 9.0, а не 8.0, и распознается (тест deviceQuery пройден).

Моя версия python - 3.6.3. Я пытаюсь запустить этот код в Spyder (3.2.4), чтобы протестировать tensorflow-gpu.

Что я пропустил?

Я пытаюсь собрать из исходников bazel на win 7, получаю ошибку

Нет инструментария для процессора 'x64_windows'

Кто-нибудь может построить WHL?

@ hadaev8 , мне нужно больше информации, чтобы помочь. Я могу работать на whl, но у него будут тяжелые зависимости, а не Win7, как только я решу MacOS, я решу Win10. В любом случае выложите свои данные.

@ eeilon79 , мне нужно воссоздать это под Win10. В настоящее время я сосредоточен на MacOS, теперь, когда решена проблема Ubuntu. Вернусь к Win 10.

@nasergh , есть ли требование для python 2.7?

Используя CUDA 8.0 и cuDNN 6.0, я установил TensorFlow из исходных кодов для поддержки Cuda GPU и AVX2 в Win10:

Требования:

* Windows 10 64-Bit

* Visual Studio 15 C++ Tools

* NVIDIA CUDA® Toolkit 8.0

* NVIDIA cuDNN 6.0 for CUDA 8.0

* Cmake

* Swig

Установите обновление 3 Visual Studio Community Edition с Windows Kit 10.0.10240.0

Следуйте инструкциям по адресу: https://github.com/philferriere/dlwin (спасибо, Фил)

Создайте виртуальный диск N: для ясности

Я предлагаю создать каталог на C: или на выбранном вами диске и создать N: на основе этих инструкций (минимум 2 ГБ):

https://technet.microsoft.com/en-us/library/gg318052 (v = ws.10) .aspx

Установите 64-разрядную версию Cuda 8.0.

https://developer.nvidia.com/cuda-downloads (прокрутите вниз до Legacy)

Установите cuDNN 6.0 для Cuda 8.0

https://developer.nvidia.com/rdp/cudnn-download

Поместите папку cuda из zip на N: \ и переименуйте cuDNN-6

Установить CMake

https://cmake.org/files/v3.10/cmake-3.10.0-rc5-win64-x64.msi

Установите Swig (swigwin-3.0.12)

https://sourceforge.net/projects/swig/files/swigwin/swigwin-3.0.12/swigwin-3.0.12.zip

cntk-py36

`` conda create --name cntk-py36 python = 3.6 numpy scipy h5py jupyter

активировать cntk-py36

pip установить https://cntk.ai/PythonWheel/GPU/cntk-2.2-cp36-cp36m-win_amd64.whl

python -c "import cntk; print (cntk .__ version__)"

conda установить pygpu

pip install keras

#### Remove old tensorflow in Tools if it exists

```cd C:\Users\%USERNAME%\Tools\

move tensorflow tensorflow.not

git clone --recursive https://github.com/tensorflow/tensorflow.git

cd C:\Users\%USERNAME%\Tools\tensorflow\tensorflow\contrib\cmake

Edit CMakeLists.txt

Прокомментируйте это:

# if (tensorflow_OPTIMIZE_FOR_NATIVE_ARCH)

# include(CheckCXXCompilerFlag)

# CHECK_CXX_COMPILER_FLAG("-march=native" COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

# if (COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

# set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -march=native")

# endif()

# endif()

Добавьте эти:

if (tensorflow_OPTIMIZE_FOR_NATIVE_ARCH)

include(CheckCXXCompilerFlag)

CHECK_CXX_COMPILER_FLAG("-march=native" COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

if (COMPILER_OPT_ARCH_NATIVE_SUPPORTED)

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -march=native")

else()

CHECK_CXX_COMPILER_FLAG("/arch:AVX2" COMPILER_OPT_ARCH_AVX_SUPPORTED)

if(COMPILER_OPT_ARCH_AVX_SUPPORTED)

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} /arch:AVX2")

endif()

endif()

endif()

сборка mkdir и сборка компакт-диска

"C:\Program Files (x86)\Microsoft Visual Studio 14.0\VC\bin\amd64\vcvars64.bat"

cmake .. -A x64 -DCMAKE_BUILD_TYPE=Release ^

-DSWIG_EXECUTABLE=N:/swigwin-3.0.12/swig.exe ^

-DPYTHON_EXECUTABLE=N:/Anaconda3/python.exe ^

-DPYTHON_LIBRARIES=N:/Anaconda3/libs/python36.lib ^

-Dtensorflow_ENABLE_GPU=ON ^

-DCUDNN_HOME="n:\cuDNN-6" ^

-Dtensorflow_WIN_CPU_SIMD_OPTIONS=/arch:AVX2

- Сборка для: Visual Studio 14 2015

- Выбор Windows SDK версии 10.0.14393.0 для Windows 10.0.16299.

- Идентификатор компилятора C - MSVC 19.0.24225.1.

- Идентификатор компилятора CXX - MSVC 19.0.24225.1.

- Проверка работоспособности компилятора C: C: / Program Files (x86) / Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe

- Проверить работоспособность компилятора C: C: / Program Files (x86) / Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe - работает

- Обнаружение информации ABI компилятора C

- Обнаружение информации ABI компилятора C - выполнено

- Проверка работоспособности компилятора CXX: C: / Program Files (x86) / Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe

- Проверить работоспособность компилятора CXX: C: / Program Files (x86) / Microsoft Visual Studio 14.0 / VC / bin / x86_amd64 / cl.exe - работает

- Обнаружение информации ABI компилятора CXX

- Обнаружение информации ABI компилятора CXX - выполнено

- Обнаружение функций компиляции CXX

- Обнаружение функций компиляции CXX - выполнено

- Выполнение теста COMPILER_OPT_ARCH_NATIVE_SUPPORTED

- Выполнение теста COMPILER_OPT_ARCH_NATIVE_SUPPORTED - Ошибка

- Выполнение теста COMPILER_OPT_ARCH_AVX_SUPPORTED

- Выполнение теста COMPILER_OPT_ARCH_AVX_SUPPORTED - Успех