Tensorflow: Kann ich ein von der GPU trainiertes Modell zur Bereitstellung/Auswertung auf eine reine CPU-Maschine exportieren?

Ich habe ein Modell auf einer GPU-Maschine trainiert.

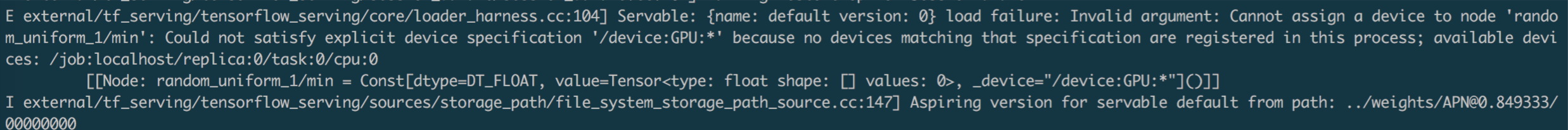

Wenn ich ein solches Modell auf eine reine CPU-Maschine lade, erhalte ich die folgende Fehlermeldung.

Vielen Dank für alle Vorschläge!

awaiting tensorflower

Alle 3 Kommentare

@vrv Könntest du dir das bitte anschauen? Haben wir jetzt eine solche Unterstützung? Danke.

Ja, Sie können tf.ConfigProto(allow_soft_placement=True) an die tf.Session übergeben, wenn Sie die Anweisungen zur Geräteplatzierung im Diagramm wirklich ignorieren möchten. Ich bin kein großer Fan dieser Option (ich möchte lieber, dass das Diagramm neu geschrieben wird, um die Gerätefelder explizit zu entfernen), aber das sollte funktionieren.

Auch in Zukunft ist StackOverflow der richtige Ort, um diese Fragen zu stellen.

War diese Seite hilfreich?

0 / 5 - 0 Bewertungen

Hilfreichster Kommentar

Auch in Zukunft ist StackOverflow der richtige Ort, um diese Fragen zu stellen.