Tensorflow: Puis-je exporter un modèle formé par GPU vers une machine à CPU uniquement pour la diffusion/l'évaluation ?

J'ai formé un modèle sur une machine GPU.

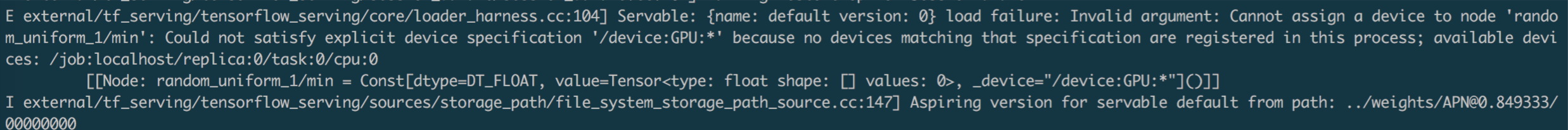

Lorsque je charge un tel modèle sur une machine à processeur uniquement, j'obtiens l'erreur ci-dessous.

Merci pour toute suggestion !

awaiting tensorflower

Tous les 3 commentaires

@vrv Pourriez-vous jeter un œil à cela s'il vous plaît? Avons-nous un tel soutien maintenant? Merci.

Oui, vous pouvez passer tf.ConfigProto(allow_soft_placement=True) à tf.Session si vous voulez vraiment ignorer les directives de placement de périphérique dans le graphique. Je ne suis pas un grand fan de l'utilisation de cette option (je préférerais que le graphique soit réécrit pour supprimer explicitement les champs de périphérique), mais cela devrait fonctionner.

De plus, à l'avenir, StackOverflow sera le bon endroit pour poser ces questions.

Cette page vous a été utile?

0 / 5 - 0 notes

Commentaire le plus utile

De plus, à l'avenir, StackOverflow sera le bon endroit pour poser ces questions.