Mve: système de coordonnées de scène

Bonjour

existe-t-il un moyen simple de créer dans MVE pour transformer le nuage de points de scene2pset en système de coordonnées de scène.

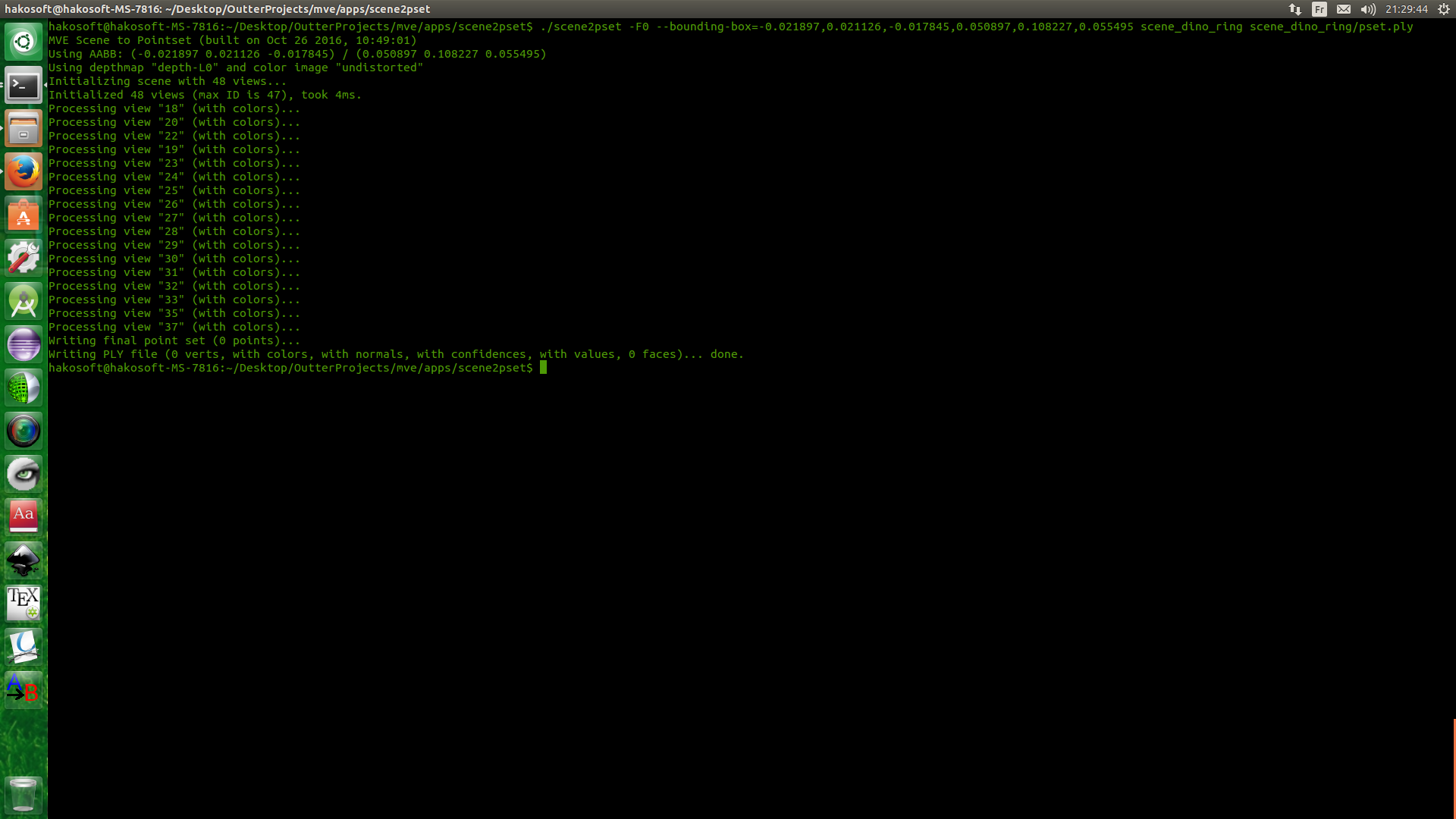

Je développe un algorithme de reconstruction de carte de profondeur et transmets ces cartes à MVE pour créer un nuage de points, j'ai utilisé un ensemble de données Dino pour tester la reconstruction, mais ce n'est pas en coordonnées de scène. Si j'utilise un arg de boîte englobante avec scene2pset, j'obtiens un fichier de plis vide. sinon, j'obtiens mes points, ce qui signifie que mon nuage n'est pas dans les coordonnées de la scène, comment puis-je résoudre ce problème

note: même si j'ai utilisé dmrecon, la même chose se produit

Merci

Tous les 12 commentaires

L'application scene2pset exporte le nuage de points dans le système de coordonnées de la scène. Aucune transformation n'est appliquée. Vous pouvez vérifier en chargeant le nuage de points et la scène dans UMVE dans l'onglet "Scene Inspect".

Non je ne pense pas. Je n'ai pas UMVE intégré pour le moment, je vérifierai plus tard. mais c'est la sortie de scene2pset.

cela signifie que tous les points ne sont pas en BB donc ils ne sont pas en coordonnées de scène

Votre boîte englobante, ou la façon dont vous spécifiez la boîte englobante, doit être erronée. scene2pset sort dans le système de coordonnées de la scène, c'est un fait. L'UMVE dispose également d'un créateur de boîte englobante qui peut vous aider à trouver les bons paramètres.

La boîte englobante n'est pas la mienne. c'est en fait de vision.Middelburry, et la raison pour laquelle j'en parle est que j'ai envoyé mon résultat pour évaluation à Middlebury et ils ont dit que mes points n'étaient pas dans la bonne coordonnée et ils m'ont demandé d'exécuter une vérification de la santé mentale en utilisant leur boîte englobante et le l'image ci-dessus est le résultat.

Toujours selon votre réponse pour le numéro 358 : " Tous les résultats sont dans le système de coordonnées dicté par SfM. Si vous voulez un système de coordonnées de scène spécifique, vous devez le transformer vous-même". les points ne sont pas dans le système de coordonnées de la scène

Exécutez-vous SfM sur les ensembles de données Middleburry ? Cela créera essentiellement un système de coordonnées de scène arbitraire qui n'a rien à voir avec celui auquel Middleburry s'attend. Si vous voulez le faire correctement, voici ce que vous devez faire :

1) Utilisez les éléments intrinsèques et extrinsèques de la caméra comme spécifié dans le jeu de données Middleburry, et utilisez-les pour les vues, c'est-à-dire insérez les paramètres dans les fichiers meta.ini .

2) Créer des fonctionnalités SfM sans réellement exécuter SfM. C'est la partie délicate, car vous voulez détecter, faire correspondre, trianguler les caractéristiques, puis exécuter une optimisation qui ne modifie pas les paramètres de la caméra. Je ne pense pas que nous ayons de code pour ce scénario exact en ce moment.

3) Exécutez votre code sur la scène résultante, qui se trouve dans le système coordonné de Middleburry.

oh ok, c'est bizarre et je ne vois pas la logique derrière ce XD. Je vais faire ce que vous avez dit, mais l'étape 2 va être difficile -__-

dernière question et je vais dormir x') : si je lance sfmrecon avec ce 2 arg = true

- args.add_option('0', "fixed-intrinsics", false, "Ne pas optimiser les intrinsèques de la caméra");

- args.add_option('0', "shared-intrinsics", false, "Partager les intrinsèques entre toutes les caméras");

est-ce que ça marchera?

Non. Parce que vous devrez également corriger les extrinsèques. Et la fixation des éléments extrinsèques n'est pas prise en charge par la nature de l'approche GDF incrémentielle.

Qu'y a-t-il de bizarre dans ces étapes ? L'étape 1 devrait être assez explicite, vous devez utiliser les paramètres fournis par Middleburry car ces paramètres de caméra "vérité terrain" sont meilleurs que ce que n'importe quel SfM peut produire. L'étape 2 est requise car notre MVS nécessite des points SfM pour fonctionner. Si vous avez un algorithme MVS qui ne nécessite pas de points SfM, vous pouvez probablement omettre cette étape.

Merci pour toutes les réponses que vous avez fournies. c'est vraiment utile.

Ce ne sont pas les étapes qui sont bizarres. mais pourquoi les paramètres sfm sont loin de la vérité terrain. et non, je ne peux pas omettre la 2ème étape puisque mon travail est basé sur votre travail spécialement _dmrecon_ , j'utilise également des caractéristiques comme graine pour estimer la profondeur et les normales. C'est pourquoi je poste beaucoup de problèmes et pose tant de questions ^__^

La reconstruction SfM a une ambiguïté en 7 dimensions, c'est-à-dire la position, l'orientation et l'échelle par rapport à l'objet original du monde réel. Cette ambiguïté est résolue dans les premières étapes de SfM en prenant des décisions arbitraires.

La reconstruction n'est donc pas "lointain", juste différente par rapport à cette ambiguïté.

J'ai ajouté un outil simple qui fait ce que vous voulez. Veuillez lire cette page.

https://github.com/simonfuhrmann/mve/wiki/Middlebury-Datasets

Merci beaucoup ,

Commentaire le plus utile

La reconstruction SfM a une ambiguïté en 7 dimensions, c'est-à-dire la position, l'orientation et l'échelle par rapport à l'objet original du monde réel. Cette ambiguïté est résolue dans les premières étapes de SfM en prenant des décisions arbitraires.

La reconstruction n'est donc pas "lointain", juste différente par rapport à cette ambiguïté.